LLaMA模型慘遭洩漏,Meta版ChatGPT被迫「開源」! GitHub斬獲8k星,評測大量出爐

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB轉載

- 2023-04-12 17:49:031540瀏覽

ChatGPT角逐之戰愈演愈烈。

前幾週,Meta發布了自家的大型語言模型LLaMA,參數量從70億到650億不等。

論文中,僅用1/10參數的LLaMA(130億)在大多數基準測試下超越了GPT-3。

對於650億參數的LLaMA,則與DeepMind的Chinchilla(700億參數)和Google的PaLM(5400億參數)旗鼓相當。

雖然Meta聲稱LLaMA是開源的,但還需要研究人員申請並進行審核。

然而萬萬沒想到的是,剛發布沒幾天,LLaMA的模型檔案就提前洩漏了。

那麼,問題來了,這究竟是故意的還是不小心的

LLaMA慘遭「開源」 ?

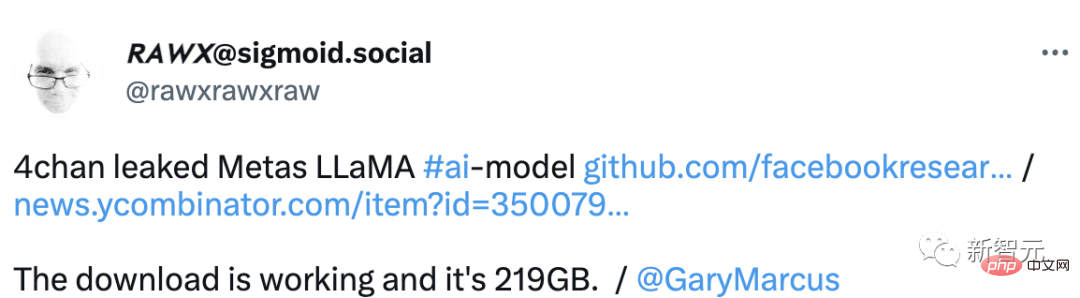

近日,國外論壇4chan上洩漏了LLaMA的成品庫。

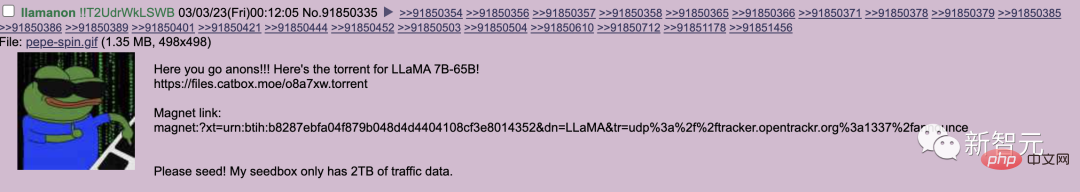

#上週四,用戶llamanon在4chan的技術板上發帖,透過種子文件(torrent)發布7B和65B的LLaMA模型。

這個種子連結目前被合併到了LLaMA的GitHub頁面。

他也向專案提交了第二個拉請求,該請求提供了一個種子鏈接,連結到模型的另一組權重。

目前專案在GitHub已收穫8k顆星。

然而,洩密者最大的錯誤之一就是在洩密的模型中包含了他們唯一的識別碼。

這個程式碼是專門用來追蹤洩密者的,使用戶llamanon的個人資訊處於危險之中。

正所謂,LLaMA開源的不太體面,網友幫它體面了。

此外,4chan上的使用者也為那些希望在自己的工作站上部署模型的人創建了一個方便的資源。

並提供了一個分佈教程的指南,說明如何獲得模型,並將修改後的權重添加到其中,以便進行更有效的推理。

更重要的是,這個資源甚至提供了一種將LLaMA整合到 線上寫作平台KoboldAI的方法。

#對於這件事究竟是Meta有意為之,還是無意洩漏。網友們紛紛發表了自己的看法。

一位網友分析地頭頭是道,「也許這是Meta故意洩漏的,以對抗 OpenAI。」

一些客戶認為這是一個更好的模型,它恰好擊中了他們以每年25萬美元的價格出售訪問權的商業計劃的核心。訪問他們的服務一個月可以購買一台能夠運行這種洩漏模型的機器。 Meta削弱了一個潛在的新貴競爭對手,以保持當前的大型科技卡特爾穩定。也許這有點陰謀論,但我們生活在大科技和大陰謀的時代。

週一,Meta稱,儘管LLaMA已經洩露給未經授權的用戶,仍將繼續向認可的研究人員發布其人工智慧工具。

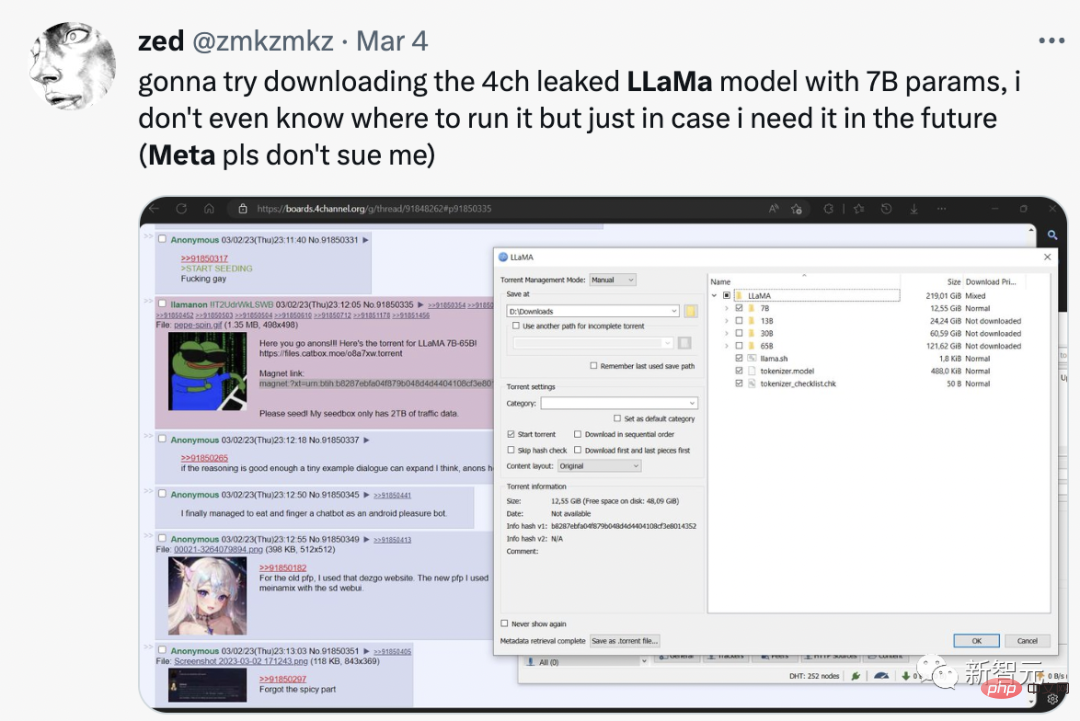

有網友直接稱,自己下載了70億參數的LLaMA,儘管不知道如何運行,萬一以後用上就能拿來了。

#LLaMA的洩漏和開源是一個大事件:

Stable Diffusion開源了。 8個月後,我們現在就可以讀懂別人的思想,解碼他們所看到的一切。

隨著LLMs的開放,我們將得到一些真正的瘋狂的東西。

模型初步評測

LLaMA發布不久後,網友發現這個最小參數的模型也需要近30GB的GPU才能運作。

然而,透過位元和位元組庫進行浮點最佳化,他們能夠讓模型在單一NVIDIA RTX 3060上運行。

此外,GitHub 上的一名研究人員甚至能夠在Ryzen 7900X CPU上運行LLM的7B 版本,每秒能推斷出幾個單字。

那麼LLaMA模型究竟怎麼樣?國外小哥便對它進行了評測。

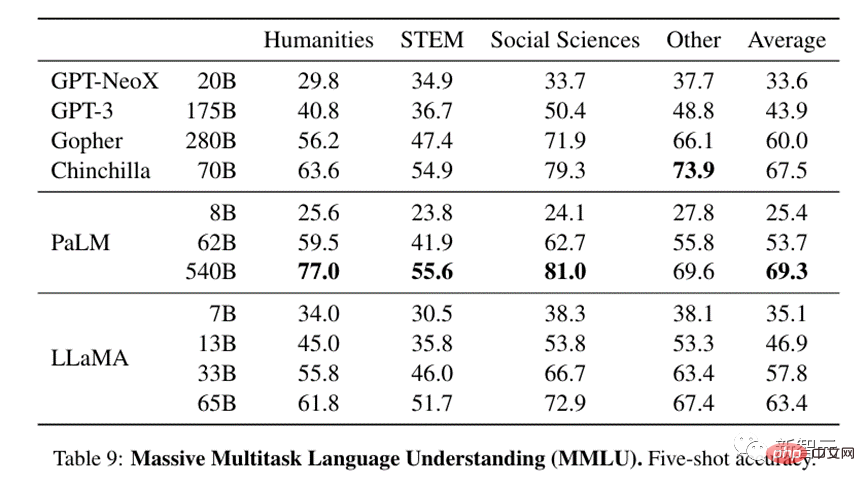

#LLaMA在許多測試中表現出色。

在大規模多任務語言理解方面,即使相對較小的13B模型也與GPT-3水準相當,而GPT-3的規模是其13倍。

33B版本遠優於GPT-3, 65B則可與現有最強大的LLM模型--Google的540B參數的PaLM競爭。

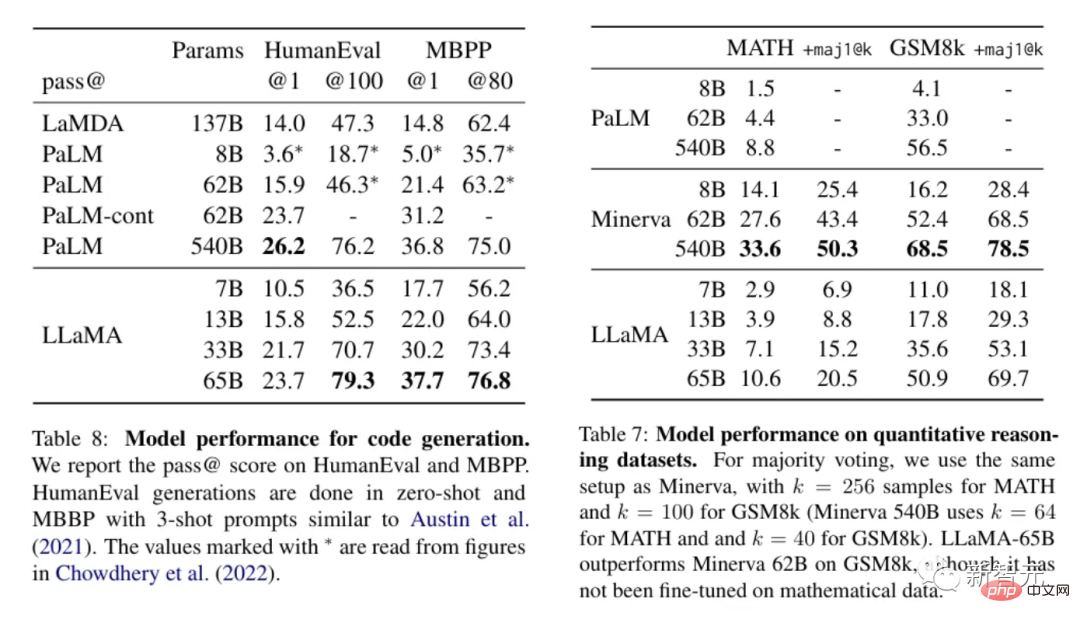

對於需要應用邏輯或計算進行處理的文本方面,LLaMA表現優秀,在定量推理方面可與PaLM相較,甚至比後者的程式碼產生能力更好。

#鑑於這些結果,LLaMA似乎是目前最先進的模型之一,而且,它足夠小,不需要多少資源就能運作。這使得LLaMA對人們來說充滿誘惑,想讓人和它玩玩,見見它的本領。

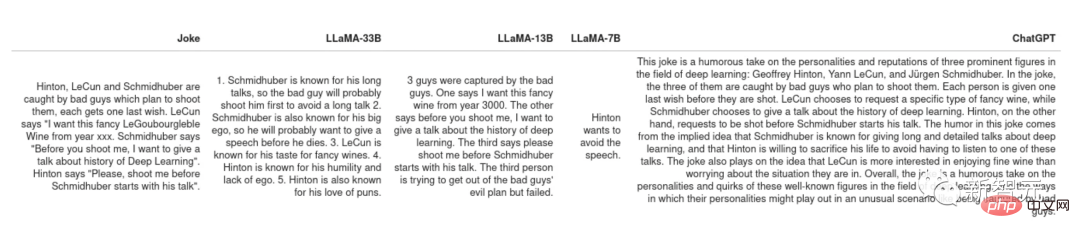

#解釋笑話

PaLM原始論文中展示了一個非常酷的用例:給定一個笑話,讓模型解釋它為什麼好笑。這個任務需要把嘗試和邏輯結合起來,PaLM之前的所有模型都無法做到這一點。

將其中一些笑話交給LLaMA和ChatGPT來解釋,有些笑話語言模型能get到,例如Schimidhuber冗長無聊的發言。

#但整體上LLaMA和ChatGPT都沒什麼幽默感。

不過兩者應對聽不懂的笑話的策略不同,ChatGPT會產生「一堵文本牆」,希望其中至少有一些語句是正確答案,這種行為就像是不知道答案的學生,希望老師能從他們的一通亂說裡找出答案。

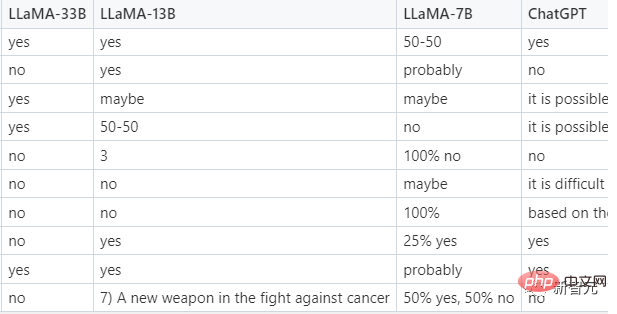

零樣本歸類

#這是一種很實用的功能,使得人們可以用LLM取代評分員來產生訓練集,然後在這些訓練集上訓練較小的可服務的模型。

一個更有挑戰性的任務是點擊廣告分類,由於連人類都不能就什麼是點擊廣告達成一致,在提示中會向模型提供一些例子,所以事實上這是一個少樣本而非零樣本歸類。下面是LLaMA的提示。

測試中只有LLaMA-33B會設法遵循所要求格式給出答案,而且其預測是合理的,ChatGPT表現次之,能給出比較合理的答案,但時常不依照規定的格式回答,較小的7B、13B模型則不太適合完成這項任務。

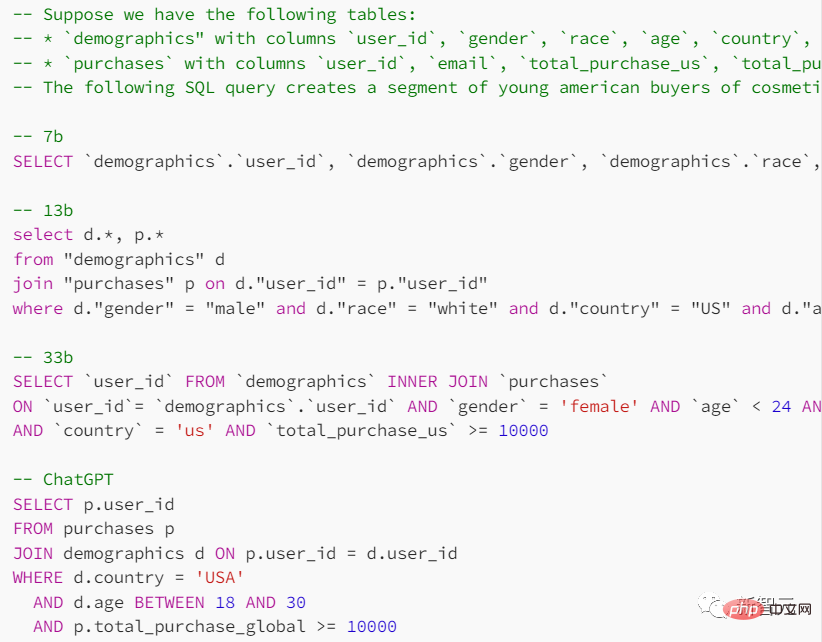

程式碼產生

雖然法LLM在人文方面表現出色,但不擅長STEM科目,那麼LLaMA在這方面的表現如何呢?

在提示中,給出搜尋表的形式和希望達到的目的,要求模型給予提供SQL查詢語句。

ChatGPT在這項任務中表現較好一點,但語言模型給出的結果整體都不太可靠。

#在與ChatGPT對比進行的各項測試中,LLaMA並沒有如想像中一樣大獲全勝。當然如果其間差距只是由RLHF(具有人類回饋的強化學習)造成的,那麼小型模型的未來可能會更光明。

#以上是LLaMA模型慘遭洩漏,Meta版ChatGPT被迫「開源」! GitHub斬獲8k星,評測大量出爐的詳細內容。更多資訊請關注PHP中文網其他相關文章!