通常來說,並道無論對於自動駕駛還是有人駕駛都是挑戰性的任務,尤其是在密集的交通流場景中,因為並道的車輛通常需要與他車交互,以識別或創造出空間,實現安全併入。本文研究了強制並道場景下自動駕駛車輛的控制問題。我們提出了一種新的基於博弈的控制器,稱為領導者-跟隨者博弈控制器(LFGC)。

其中,使用了部分可觀的領導者-跟隨者博弈模型建模自動駕駛車輛與其他具有先驗不確定駕駛意圖的車輛之間的交互行為。 LFGC根據觀察到的軌跡在線估計他車的意圖,預測它們未來的軌跡,並使用模型預測控制(MPC)規劃自車輛軌跡,以在實現併入目標的同時保證安全機率。為了驗證LFGC的性能,我們使用模擬及NGSIM數據對其進行了測試,其中LFGC展示了高達97.5%的併入成功率。

01 引言

高度自動駕駛汽車的實現仍然面臨許多挑戰[4],在公路上完成強制並道對於有人駕駛和自動駕駛來說都是具有挑戰性的場景。強制並道通常指當前車道結束、需要強制並道的場景,例如高速公路入口匝道併入。交通密集時,並道車輛與目標車道行駛的車輛互動和/或合作。

此時,目標車道上的車輛可以選擇忽略並道車輛(即繼續行駛),此時併入車輛只能在其後併道;或者,目標車道中的車輛可以選擇屈服於並道(即讓併入車輛並道至其前方)。為了成功地併入密集交通流,自動駕駛車輛控制器需要對目標車道車輛的繼續或屈服的意圖合理預測,以做出適當地回應。

同時,他車的意圖不僅取決於交通狀況(如兩輛車之間的相對位置和速度),還取決於駕駛員的普遍具有的駕駛風格、個性、情緒等。例如激進的司機可能傾向於繼續行駛,而謹慎、保守的司機可能傾向於屈服。這對自動駕駛汽車的規劃和控制提出了重大挑戰。

#圖1 藍色自車強制並道場景圖

目前許多學者使用部分可觀察馬可夫決策過程(POMDP)框架處理互動的不確定性(例如,由於他車的不同合作意圖),然而,該方法對計算的要求高[ 11],難以用於多車輛互動。

強化學習(RL)方法是另一種針對變換車道或併道場景設定控制策略[12][13]的流行方法。基於RL的方法具備處理複雜的交通下多車互動場景的能力,但RL缺乏可解釋性和明確的安全保證。

為了實現更可解釋的控制,有研究人員提出在控制演算法中顯示加入車輛互動的預測模型。如[22]使用 「社會生成對抗網路(GAN)」來預測他車的未來軌跡,以回應自車的行為。然而,SocialGAN未考慮到駕駛者的風格和意圖的變化,需要用巨大的交通資料[23]進行訓練;有的研究中使用博弈論方法建模變換車道或併道場景[9]、[25]、 [26]、[27]、[28]、[29]下的車輛交互,可以解釋不同的駕駛風格和/或意圖,如透過博弈建模和在線估計駕駛員的認知水平[26]或[ 30],[31]。

在本文提出了一種新的高階控制演算法,稱為領導者-跟隨者博弈控制器(LFGC),用於強制並道場景下的自動駕駛車輛的規劃和控制。在LFGC中,使用明確博弈論建模駕駛員的互動意圖(繼續或屈服)以及由此產生的車輛行為。

因為模型有多個並行領導者-跟隨者對,故稱為領導者-跟隨者博弈[32]。考慮互動的不確定性,將兩車輛間先驗不確定的領導者-跟隨者關係建模為潛在變數。 LFGC根據觀察到的軌跡在線估計領導者-跟隨者關係,並使用基於模型預測控制(MPC)的策略為自主自車做出最佳決策。

因此,所提出的LFGC適應於評估預測領導-跟隨者關係,以在實現並道的同時保證機率安全。

比較已有方法,LFGC的貢獻與創新點如下:

1)使用LFGC賽局模型進行車輛軌跡預測,同時考慮他車互動與合作意圖,接上MPC控制後產生可解釋的控制方案。

2)LFGC透過將不確定性建模為潛在變量,基於歷史觀察軌跡集合貝葉斯推理在線估計,以處理由於他車的不同合作意圖造成的交互不確定性。

3)LFGC建立車輛安全要求(如避免碰撞)的限制條件,在滿足明確的機率安全特性(即使用者指定的安全機率邊界內)的情況下進行最佳化。

4)LFGC是在連續狀態空間設定下設計,降低離散空間的運算成本,能夠處理更複雜的多車互動場景。

5) LFGC的可行性通過了基於模擬的全面的案例驗證,包括他車由各種類型的駕駛員模型控制的案例,以及在NGSIM美國高速公路101資料集[34]中的實際案例。並在實際案例模擬中顯示了高達97.5%的成功率。

02 模型和控制策略描述

#本節中基於表示車輛和交通動力學的模型,建立了基於MPC的自車軌跡規劃策略。

車輛動力學模型

#在我們使用運動學自行車模型[35]中,自行車模型的連續時間方程式如下,

#假設只有前輪轉向 ,沒有後輪轉向(即

,沒有後輪轉向(即 );x、y是車輛的縱向、橫向位置;v是車輛的速度;ψ和β是車輛的偏航角和滑移角;

);x、y是車輛的縱向、橫向位置;v是車輛的速度;ψ和β是車輛的偏航角和滑移角;  和

和 表示車輛從CG到前輪和後輪軸的距離;a是沿著速度v方向的加速度。控制輸入是加速和前輪轉向,

表示車輛從CG到前輪和後輪軸的距離;a是沿著速度v方向的加速度。控制輸入是加速和前輪轉向, 。

。

動態交通設定

#場景包括用1個自車和n個他車,交通狀態及其動力學的特徵是所有n 1車輛的狀態和動力學的聚集。具體使用以下離散時間模型來描述交通動態:

其中,

表示離散時刻的n 1量車的交通狀態, 表示時間t時所有n 1輛車輛的控制輸入的集合。每輛車的狀態

表示時間t時所有n 1輛車輛的控制輸入的集合。每輛車的狀態 包括它的xy座標、速度和偏航角;控制輸入

包括它的xy座標、速度和偏航角;控制輸入

獎勵函數

獎勵函數 是駕駛駕駛目標的數學表示,交通狀態是由這兩輛車的狀態組成的,而自車獲得的獎勵取決於兩交互車的狀態和控制輸入。我們考慮

是駕駛駕駛目標的數學表示,交通狀態是由這兩輛車的狀態組成的,而自車獲得的獎勵取決於兩交互車的狀態和控制輸入。我們考慮 ##其中,

##其中,

#,

#, 是一個權重向量。獎勵項

是一個權重向量。獎勵項 代表駕駛過程中的以下常見考慮:1)安全性

代表駕駛過程中的以下常見考慮:1)安全性 #,即不與他車相撞、不離開道路;2)並道意願

#,即不與他車相撞、不離開道路;2)並道意願 ,即與目的車道的距離;3)舒適性

,即與目的車道的距離;3)舒適性 #,即與他車保持合理的間距。

#,即與他車保持合理的間距。

#圖2 五自由度的變換車道曲線####### ##

選擇軌跡作為車輛動作

#我們考慮 上的車輛運動軌跡樣本作為每個車輛的動作空間。具體來說,每個軌跡都是從車輛當前狀態

上的車輛運動軌跡樣本作為每個車輛的動作空間。具體來說,每個軌跡都是從車輛當前狀態

開始的車輛狀態 的時間歷史。 根據車輛動力學模型(1),可以將每個軌跡對應的控制輸入時間歷史

的時間歷史。 根據車輛動力學模型(1),可以將每個軌跡對應的控制輸入時間歷史

計算。

計算。

對於在目標車道上行駛的互動車輛,我們只考慮它們的縱向運動。

假設 和

和 #,這些車輛的運動學模型(1)簡化為:

#,這些車輛的運動學模型(1)簡化為:

此時從給定的初始條件開始的軌跡只依賴[0,T]的加速度a。在每個樣本時間都會考慮81個加速度曲線,也就是81個滿足表達式(4)的軌跡,由此形成在目標車道上駕駛的他車的軌跡可行域。

這81個軌跡符合速度約束 。

。

將每一個軌跡表示為 ,m = 1,2,…81,軌跡的集合記為

,m = 1,2,…81,軌跡的集合記為

併入車輛的軌跡策略包括車道維持與變換車道,車道維持的軌跡產生與(4) 類似,變換車道軌跡使用五階多項式來表示[37]。即變換車道軌跡需求解可以建模為以下邊值問題:

找出係數 和

和 ,讓5階多項式

,讓5階多項式

滿足相應的初值條件和終值條件。 (5)中的變數ζ表示連續時間,目前樣本的ζ=0。

同時假設1)車輛可以在規劃範圍內任何樣本時間開始變換車道,2) 完整變換車道需要時間 為常數[37]。允許車輛在變換車道過程隨時終止變換車道行為,這代表當先前計劃的變換車道變得不可行/安全時,司機「改變主意」。中止變換車道後的軌跡透過類似變換車道軌跡的方式產生。

最後將車道維持、車道變更和放棄變換車道的軌跡拼接組合成162個軌跡,作為策略的可行域。

提煉出軌跡特徵為:1)是否/何時開始變換車道;2)是否/何時中止一個不適當的變換車道。

圖3為車輛沒有開始變換車道時和當車輛在變換車道過程中時的軌跡取樣集。將每個軌跡表示為,m = 1,2,…,162;軌跡集合為。

圖3 併入車輛的軌跡樣本

綜上定義了作為決策輸出的可行軌跡。同時,對應這些軌跡的控制輸入量的時間歷史可以根據車輛動力學模型(1)計算。所規劃的軌跡可以實際傳遞到下層的車輛運動控制器上。

模型預測控制策略

#考慮基於MPC的自主自車軌跡規劃策略,考慮訊號互動車輛的存在:在每個樣本時刻t,自車計算一個最優軌跡, ,根據在規劃範圍內最大化其累積獎勵:

,根據在規劃範圍內最大化其累積獎勵:

在其中, 表示離散時刻t τ的預測交通狀態,而

表示離散時刻t τ的預測交通狀態,而 和

和

分別表示預測的自車和互動車輛在t τ的控制輸入。參數λ∈(0,1)是未來獎勵的損益係數,即優先考慮當下的獎勵。在(6)中,

代表自車在t τ時的獎勵,如第II-C節所述, 代表一組交通狀態的安全值,用於執行嚴格的安全規範(如防碰撞、道路邊界約束等)。在獲得最佳軌跡

代表一組交通狀態的安全值,用於執行嚴格的安全規範(如防碰撞、道路邊界約束等)。在獲得最佳軌跡 後,自車用與該軌跡對應的控制輸入

後,自車用與該軌跡對應的控制輸入

,在一個取樣週期內更新其狀態,然後在下一個採樣時間瞬間t 1重複上述步驟。

,在一個取樣週期內更新其狀態,然後在下一個採樣時間瞬間t 1重複上述步驟。

03 車輛合作行為的賽局理論模型和使用模仿學習的明確表示

這部分介紹了本文所使用的領導者-跟隨者博弈模型。為了簡化博弈論模型的線上計算,使用模仿學習獲得基於神經網路的顯式模型,以在基於MPC的整體軌跡規劃策略中在線預測交互車輛響應併入自車行為的軌跡。

領導者-跟隨者賽局理論模型

#在本文中,我們考慮了基於成對的領導者-跟隨者互動的參數理論模型來表示駕駛者的合作意圖及其由此產生的車輛行為,稱為領導者-跟隨者博弈模型。在該模型中,決定在另一輛車之前繼續前進的車輛(或司機)是這對車中的領導者,而決定向另一輛車讓步的車輛是這對車中的跟隨者。領導者和跟隨者使用不同的決策策略。這種領導者-跟隨者博弈論模型最初是在[32]中提出的,此處簡要回顧下該博弈論模型,以介紹它在高速公路強制並道場景中的應用。

表示領導者和跟隨者的軌跡分別為和,其中和為領導者、跟隨者的可行軌跡集。假設博弈雙方都做出了最大化其累積獎勵的決定,分別記為和,定義如下:

其中代表博弈中的角色,是領導者/跟隨者的獎勵函數,和表示對應二者軌跡和的控制輸入量。

具體來說,我們對領導者和跟隨者的互動式決策過程進行建模如下:

##其中 (區別於

(區別於 )是領導者(區別於跟隨者)的最優軌跡,取決於當前交通狀態,

)是領導者(區別於跟隨者)的最優軌跡,取決於當前交通狀態,  與

與 定義如下:

定義如下:

#其中

#。

#。

決策模型(8)-(11)在強制並道中可以解釋為:一個跟隨者代表一個打算讓步的駕駛者。由於對其他駕駛者的行動的不確定性,跟隨者決定採取一個行動,透過(9)和(11)來最大化其的最壞情況下的獎勵,他們假定其他駕駛員可以自由地採取行動。一個領導者則代表一個打算繼續前進的司機,他們假設另一個司機會屈服。因此,領導者使用跟隨者模型來預測另一個駕駛者的行動,並透過(8)和(10),在預測的跟隨者的行動下最大化領導者自己的獎勵。這種領導者-跟隨者博弈模型部分源自斯塔克爾伯格博弈模型[38],但放寬了一些不適用於駕駛者互動的假設。可以參考[32]來更詳細的了解領導跟隨者博弈模型以及它在多車輛場景中建模駕駛員互動的有效性。

請注意,該模型並不意味著一個領導者車輛總是迫使併入車輛在其後併道或跟隨者車輛總讓併入車輛在其前併道,在以下舉例的兩個情況中,並道車輛可能在領導者車輛前並道:1)併道車輛在領導者車輛前面,有足夠大的距離,允許安全並道。 2)正在併入的車輛即將到達其車道的盡頭。因為離開道路產生一個大的懲罰(見第二節-c),因此只要自車的併入不導致碰撞(碰撞的懲罰大於離開道路),自車即可以選擇並道在來車之前以避免大的懲罰,。

以上表明,在我們的決策模型(8)-(11)中,領導者跟隨者的角色並不是由車輛的空間位置來分配的(領導者不一定是前面的車輛)。此外,模型允許自車迫使目標車道交通流讓它並道:自車接近目標車道時,將越來越傾向於並道以避免離開道路受到懲罰,此時自車會在目標車道的所有交互車輛都是領導者或目前的併入間隙不夠大、併入不夠舒適時仍然採取併入動作。模型(8)-(11)顯示領導者身分的互動車輛能夠預測併入車輛接下來的併入動機。隨後,併入車輛為了自身的安全和舒適,也會放慢速度擴大車距,從而保證並道。

透過模仿學習明確表示賽局策略的領導者

(8)-(11)能夠基於駕駛員的意圖和當前交通狀態資訊預測他車的決策和軌跡,即領導者的最優行動策略、跟隨者的最優行動策略都可透過(8)-(11)獲得。但 (8)-(11)的重複線上計算會很耗時。因此,我們將使用模仿學習顯式地表示和。

參考[39],我們利用監督學習(具體為使用模仿學習)表示。

模仿學習屬於監督學習問題,代理人將透過觀察專家的行為來學習一個策略。專家可以是人工或人工智慧代理,在我們的工作中,由(8)-(11)獲得的即專家策略。

我們利用「資料集聚合」演算法[40]獲得了一個模擬的策略。

其中,資料集聚合演算法的整體學習目標可以描述為:

表示使用θ (神經網路權重)參數化的策略,表示損失函數,關於模仿學習和「資料集聚合」演算法詳見[39]和[40]。

學習(8)-(11)的模仿學習策略可以在了解駕駛員合作意圖的情況下預測他車的決策和未來的發展軌跡。然而,在給定的交通場景中,我們可能事先不知道其他駕駛者的合作意圖,因為駕駛者的意圖不僅取決於交通情況(例如,兩輛車之間的相對位置和速度),還取決於駕駛者的風格/類型。我們將他車合作意圖的不確定性建模為潛在變量,在自動駕駛汽車規劃和控制問題中將利用估計他車的合作意圖以及使用預測控制方法獲得最優軌跡。

04 合作意圖不確定性條件下的決策

#下面我們描述了在合作意圖不確定下的高速公路強制並道決策演算法,即領導者-跟隨博弈控制器(LFGC)。在強制並道過程中,我們產生一個如本節所述的其他駕駛員的合作意圖估計,基於該估計將(6)建模為成對交互的多車控制策略。

估計交互車輛的合作意圖

#使用引導跟隨者博弈,根據對他車駕駛員的合作意圖進行行為建模。屈服的車輛建模為博弈中的跟隨者,繼續(不屈服)的車輛建模為領導者。即,可以透過估計交互車輛在領導者-跟隨者博弈中的角色來估計交互車輛的合作意圖。

為了實現這一點,我們考慮了交通動力學模型(2)以及領導者或跟隨者的最佳行動(8)和(9)。從自車的角度來看,交互車輛是在進行領導者-跟隨者博弈,動態交通模型可以寫成

其中 是自車的控制,

是自車的控制, 是交互車輛的控制,由領導者跟隨者博弈得到,

是交互車輛的控制,由領導者跟隨者博弈得到, {領導者,跟隨者}代表跟隨者或領導者,並且

{領導者,跟隨者}代表跟隨者或領導者,並且 第一個控制輸入,對應(8)(9)中

第一個控制輸入,對應(8)(9)中

##的最優軌跡。現在(14)的唯一輸入是對自車的控制

。

############考慮到現實中,他車的決策並不一定遵循從(8)和(9)中計算出的最優策略,因此加入高斯噪聲,假設系統依照(14)工作:###########################其中為平均值和協方差為0的加性高斯雜訊。 ############假設自車對σ有一個先驗信念,表示為,其中{領導者,跟隨者}。然後根據所有先前的交通狀態和自車所採取的所有行動######自車需要計算或維持對互動車輛的領導者或跟隨者角色的後驗信念, ##。

##。

利用[41]中提出的混合估計演算法,可以計算互動車輛的領導者或跟隨者角色的條件後驗信念。

具體來說,識別互動車輛的領導者或跟隨者角色可以表示為:

其中 為條件機率;

為條件機率; #為作用車角色從##到

#為作用車角色從##到 的轉移機率;

的轉移機率; 為作用車角色

為作用車角色 #的似然函數,定義為:

#的似然函數,定義為:

##式中,

為常態分佈的機率密度函數,平均值為0,協方差W在 評估;

評估;

假設互動車輛的角色在並道期間保持不變,即當

#,當

#,當

其中 是互動車輛的領導者或跟隨者的角色的先驗信念。

是互動車輛的領導者或跟隨者的角色的先驗信念。

多車交互作用的控制策略

#當交通繁忙時,高速公路上可能存在多輛車輛幹擾自車的並道,如圖1所示。一個低複雜度的解決方案是,自車只考慮與第一輛車的交互,第一輛車遠離後開始與第二輛車的交互。然而,這可能會導致對後車輛意圖的估計推遲,從而致使自車失去並道的機會。

另一個解決方案是同時與多輛車輛互動。這時需要建構模型來預測互動車輛的行為。雖然第三節中描述的2人領導-跟隨博弈可以透過考慮多層次決策層次來擴展到多人領導者-跟隨者博弈,但隨著玩家數量的增加模型複雜度將呈指數級增長。超過3個玩家時,即很難獲得斯塔克爾伯格平衡[42]。因此,我們提出了一種計算上易於處理的方法,透過考慮成對交互,將框架擴展到多車輛交互。

當有m個相互作用的車輛時,我們考慮自車和每個相互作用的車輛的成對交互,然後構造m個包含自車和第k個他車狀態的交通狀態,表示為,,每個的動態模型由下式給出:

類似地,我們可以用 {領導者,跟隨者}表示第k個互動車輛的成對領導者或跟隨者角色,用

{領導者,跟隨者}表示第k個互動車輛的成對領導者或跟隨者角色,用 表示自車所有先前的成對交通狀態和行動的集合,即,

表示自車所有先前的成對交通狀態和行動的集合,即,

然後我們可以利用(19)來更新每個互動車輛的領導者或跟隨者角色的信念, #,

#,

##{領導者,跟隨者}。 (6)中基於MPC的控制策略可以重新表述為:

其中, 是(12)中訓練策略

是(12)中訓練策略 的軌跡對應的第一個控制輸入,ε∈[0,1]表示(使用者指定的)所需的約束滿足機率水平。

的軌跡對應的第一個控制輸入,ε∈[0,1]表示(使用者指定的)所需的約束滿足機率水平。

在目標函數中的期望可以根據(23)求解;

#其中, #為給定互動車輛的角色為

#為給定互動車輛的角色為 #的預測交通狀態,而(22)中的最後一個限制可以通過,

#的預測交通狀態,而(22)中的最後一個限制可以通過,

其中, 為集合B中b的指示器函數。請注意,(22)中的最後一個約束強制執行了以下條件,

為集合B中b的指示器函數。請注意,(22)中的最後一個約束強制執行了以下條件,

#這意味著任何成對的交互作用進入不安全狀態(例如,碰撞和離開道路邊界)的機率都小於ε。

為了推導(26),我們先表示事件

然後

然後

然後套用(22)中的最後一個約束,就可以得到

(6)和(22)之間的主要差異是:

1) (6)中的為未知,而在(22 )中,它們是基於模仿學習的訓練策略獲得的;

2)將(6)中累積獎勵的最大化改為(22)中期望累積獎勵的最大化,以解釋互動車輛的領導者/跟隨者角色的機率信念;

3)期望累積獎勵改變為所有成對互動的期望獎勵之和,以解釋多輛車輛的不確定行為(便於計算);

4)硬約束變成機率的機會約束,以ε∈[0,1]為參數。

決策演算法進行如下:在取樣時間t時,自車測量每組互動對的當前狀態,並將它們與先前的控制輸入量一起添加到觀測向量 #中。對每輛車的領導者或跟隨者角色的信念根據(19)進行更新。然後,利用基於MPC的控制策略(22),透過搜尋第2-D節中引入的所有軌跡,得到最佳軌跡

#中。對每輛車的領導者或跟隨者角色的信念根據(19)進行更新。然後,利用基於MPC的控制策略(22),透過搜尋第2-D節中引入的所有軌跡,得到最佳軌跡 ,自車在一個採樣週期內應用第一個控制輸入來更新其狀態。整個過程將在下一次採樣時重複進行。

,自車在一個採樣週期內應用第一個控制輸入來更新其狀態。整個過程將在下一次採樣時重複進行。

需要注意的是,控制策略(22)是「互動感知」的,原因如下:

1)它基於領導者-跟隨者博弈論模型(8)-(11)預測不同互動意圖下他車的軌跡。

2)這些預測都是閉環式的。具體來說,對應自車的不同軌跡規劃 ,他車特定意圖下的軌跡預測也是不同的。這種情況是因為預測的他車的行為依賴交通狀態,而預測的交通狀態依賴自車的規劃軌跡。

,他車特定意圖下的軌跡預測也是不同的。這種情況是因為預測的他車的行為依賴交通狀態,而預測的交通狀態依賴自車的規劃軌跡。

3)(22)中的目標函數是一個條件期望,表示安全的限制是一個條件機率,兩者都基於他車意圖(即領導者或跟隨者)的最新估計, 。同時,根據他車前的互動行為來估計他車意圖。

。同時,根據他車前的互動行為來估計他車意圖。

05 模擬與驗證結果

#在本節中,我們將展示領導者跟隨博弈控制器(LFGC )應用於自動駕駛車輛強制並道問題的驗證結果。我們具體考慮了三個模擬驗證,在這些模擬中,LFGC假設交互車輛與自車進行領導者-跟隨者博弈,並估計他們在博弈中的領導者/跟隨者角色。我們也假設,一旦進入強制變換車道情況,自車用轉向信號對準車道,宣布其並道意圖,並開始強制並道過程。因此,交互他車會意識到自車的並道意圖,並做出相應的反應。

我們首先在領導者-跟隨者賽局中,使用由領導者或跟隨者控制的互動車輛來驗證LFGC。然後,我們測試了LFGC與其他類型的駕駛者或實際交通資料控制的互動車輛。此外,我們測試了透過智慧駕駛員模型對互動車輛(IDM)進行控制的情況,以及互動車輛遵循下一代模擬網站[34]中實際的美國101高速公路交通數據。我們的模擬是在Intel Xeon E3-1246 v3 @ 3.50 GHz CPU和16 GB記憶體的PC上的MATLAB R2019a平台上執行的。

領導者-跟隨者模型互動車輛

#首先我們使用領導者/跟隨者模擬和控制互動車輛,測試LFGC。我們所考慮的場景如圖4所示,加速車道上的自動自車(藍色)在加速車道結束前需要並道到高速公路上,而其他多輛車輛(紅色、粉紅色、綠色)目前正在高速公路上行駛。如圖4所示,自車透過偏向車道標記和閃爍的轉向訊號來開始強制並道過程。在這種情況下,自動駕駛車輛需要與他車進行交互,以實現安全並道。

圖4 高速公路強制並道場景下領導者/跟隨者控制互動車輛的LFGC驗證場景圖

經過試驗,自車能=正確辨識互動車輛的意圖(即能正確劃分交互他車為領導者/跟隨者)

圖5 使用LFGC與不同領導者和跟隨者組合的他車的交互結果

(a)他車為三個領導者;

(b) 他車為1領導者(車輛1)和2跟隨者(車輛2和3);

(c ) 他車為兩個領導者(車輛1和2)和一個跟隨者(車輛3);

(d) 他車為三個跟隨者。

左欄(a-1)到(d-1)顯示了自車對他車在博弈中的領導者的信念。右列(a-2)到(d-2)顯示了在這個強制並道過程中自車和他車行為的時間歷史結果。具體來說,在右欄中,每個塊的邊界線顏色區分不同的車輛,塊中的數字表示時間以秒為單位,每個塊的顏色描述該時刻的車輛速度,藍色虛線表示自車的軌跡。請注意,車輛1-3有相同的縱向位置,圖中添加了一些縱向偏移量以更好地區分。

對於LFGC,規劃範圍為N = 4,機會約束參數為ε = 0.1。請注意,較大的N可能會導致更好的長期性能,但也會導致更長的計算時間,而較小的N可能會強調直接的好處,因此在許多情況下無法合併。對於本文中考慮的高速公路強制合併,一般需要選擇N,使其超過車道變更的持續時間(即 )。

)。

圖5(a)顯示了自車與三位領導者互動時的結果。自車能夠捕捉到互動車輛的意圖,即所有車輛都更有可能成為博弈中的領導者,如圖5(a-1)所示。在獲得這些資訊後,自車決定在t = 1 [s]後減速,並在所有互動的車輛經過後等待合併。

當自車與一個領導者(車輛1)和兩個跟隨者(車輛2和3)互動時,自車正確辨識互動車輛的意圖,如圖5( b-1)所示。然後在t = 1 [s]後,自車開始減速,並在車輛1和車輛2之間成功合併,如圖5(b-2)所示。如圖5所示,(c)是自車與兩個領導者(車輛1和2)和一個跟隨者(車輛3)互動的結果。

在這種情況下,自車觀察到車輛1和2加速而不屈服,所以自車決定減速,並在車輛2和3之間合併。當自車與三個跟隨者互動時,我們也進行了測試,結果如圖5(d)所示,自車觀察所有產生意圖的車輛,在所有互動的車輛前面加速和合併。在每個時間步長中,求解(22)的平均計算時間為0.182 [s]。

對於圖5所示的所有案例,初始化的信念是相同的,這意味著自車不事先知道互動的載體是領導者還是跟隨者。因此,自車依賴它的觀察值來估計互動載體的領導者/跟隨者的角色。在領導者-跟隨者博弈中,當所有互動車輛都被領導者/跟隨者控制時,LFGC可以捕捉互動車輛的意圖並做出相應的決策。

他車採用IDM模型的互動

第5-A節所示的驗證結果假設他車根據領導者-跟隨者的賽局做出決策。 LFGC估計其他駕駛者在博弈中的角色,並做出相應的決定。這意味著第5-A節的環境的行為與LFGC所期望的一樣。然而,其他駕駛者的實際行為可能不同於領導者-跟隨者博弈的政策。因此,我們進一步研究該框架如何在他車使用智慧駕駛員模型(IDM)時做出回應。

在本節使用IDM控制他車,並與自車互動。自車仍由LFGC控制,並試圖透過估計其相應的領導者或跟隨者角色來估計互動車輛的意圖。 IDM是一個連續時間的汽車追蹤模型,由(27)到(29)[43]來定義。

其中 ##為縱向位置;

##為縱向位置;  為縱向速度;

為縱向速度; 為車輛的期望速度;

為車輛的期望速度;

為跟車距離, 為目標車輛的位置,

為目標車輛的位置, 為目標車輛的長度;

為目標車輛的長度; 是車輛與目標車輛的速度差;

是車輛與目標車輛的速度差;

根據:

#其中,

#其中, #為IDM模型的參數。這些參數的物理解釋是最大加速度

#為IDM模型的參數。這些參數的物理解釋是最大加速度 、跟隨距離

、跟隨距離

#的最小車輛、期望的時間T和舒適減速度b。 #######

我們考慮了圖6所示的場景作為驗證測試。在圖6中,所有車輛前方有另一輛車(黑色車輛4)以恆速行駛。自車仍然與V-A節相同,並由LFGC控制,這意味著從自車的角度來看,它正在與所有互動的車輛玩領導者-跟隨者博弈。對於這三個相互作用的車輛(車輛1至3),它們由IDM控制,跟隨前面車輛(車輛4)或具有一定時間前進t的自車。 IDM模型參數列於表1。注意,自車將車輛4作為環境車輛,並假定其以恆速行駛。

#圖6 當他車子遵循IDM時,自車採用LFGC完成強制並道的場景示意圖

#1 智慧駕駛模式參數

圖7顯示了自車與具有不同目標車輛和不同期望時間的IDM控制的他車進行互動時的結果。

圖7顯示了自車與具有不同目標車輛和不同期望時間的IDM控制的他車進行互動時的結果。

#圖7 :LFGC對IDM控制的不同目標和期望時間的他車的互動結果

(a)車輛1產生(跟隨自車)時間進展T = 1 [s],車輛2和車輛3跟隨T = 0.5 [s];

(b)車輛2產生(跟隨自車)T=0.5[s],車輛1和3跟隨前車輛T = 0.5 [s];

(c)所有車輛跟隨前車輛與T = 0.5 [s];(d)所有車輛跟隨前車輛與T = 1.5 [s]。

左欄(a-1)到(d-1)顯示了自車對他車在博弈中的領導者的信念。右列(a-2)到(d-2)顯示了在這個強制合併過程中自我和他車行為的時間歷史結果。具體來說,在右欄中,每個塊的邊界線顏色區分不同的車輛,塊中的數字表示時間以秒為單位,每個塊的顏色描述該時刻的車輛速度,藍色虛線表示自車的軌跡。

在圖7(a)中,第一輛交互車輛(車輛1)打算向自車讓步,因此它選擇跟隨1秒時間前進的自車,而最後兩輛交互車輛跟隨0.5秒時間前進的前方車輛。從圖7(a-1)可以看出,自車認為車輛1有很高的機率成為博弈中的跟隨者,並選擇在車輛1的前面合併,如圖7(a-2)所示。

圖7(b)顯示了另一種情況,即第一輛交互車輛(車輛1)前進0.5,第二輛交互車輛打算向自車讓步,前進0.5跟隨自車。那麼在這種情況下,從自車的角度來看,車輛1在博弈中成為領導者的機率更高,而車輛2在博弈中成為跟隨者的機率更高,因此在這種情況下,自車在車輛2的前面成功合併。

另外兩個非產量情況如圖7(c)和(d)。所示圖7(c)顯示了跟隨前面車輛的所有交互車輛的結果。從自車的角度來看,所有互動的車輛都更有可能成為博弈中的領導者,所以自車在所有車輛通過後都能成功地融合。

在圖7(d)中,所有相互作用的車輛都以1.5秒的速度前進。在這種情況下,自車發現車輛2的行為是保守的,並認為車輛2在博弈中成為跟隨者的可能性更高。因此,自車成功地在車輛1和車輛2之間融合。在每個時間步長中,求解(22)的平均計算時間為0.198 [s]。

######遵循真實交通數據的他車車輛##########我們已經在領導者-跟隨者博弈中由領導者/跟隨者驅動的他車和IDM模型上測試了LFGC。我們想用真實的流量數據來進一步測試控制器的效能。具體來說,我們使用了來自Next Generation Simulation(NGSIM)網站[34]的美國高速公路101交通數據集,該網站由美國聯邦高速公路管理局收集,被認為是最大的公開的自然駕駛數據來源之一。美國高速公路101資料集已經在文獻[44],[45],[46]中得到了廣泛的研究。

更具體地說,我們考慮了美國101交通資料集的一部分,其中包含了美國101高速公路上30分鐘的車輛軌跡。時段從早上7:50到8:20,這代表了上午尖峰時間前後的擁擠。此資料集包含約6000輛車輛的位置和速度軌跡以及車輛尺寸,每0.1 [s]記錄一次資訊。用於收集資料的美國101高速公路部分的俯視圖如圖8所示。研究路段包括公路的五個主要車道,一條到公路的入口匝道,一條離開公路的出口匝道,以及一條用於併入公路和退出公路的輔助車道。

如同在[47]中所討論的,US101資料集由於視訊分析和數值區分而包含了一個顯著的雜訊量。為了克服這個缺點,我們利用薩維茨基-戈雷濾波器[48]來平滑車輛的位置,並更新其對應的速度。 Savitzky-Golay濾波器在時間視窗長度為21 [45]的US101資料集方面表現良好。一個原始車輛軌跡和對應的平滑車輛軌跡如圖9所示。

#圖8 用來收集美國101交通資料[34]的高速公路俯視圖

路段包括高速公路的五個主要車道,通往高速公路的入口匝道,一條退出高速公路的出口匝道,還有一條用於併入高速公路和退出高速公路的輔助車道。

#圖9 使用薩維茨基-戈雷濾波器從美國101交通資料集平滑的車輛軌跡

對於LFGC的驗證測試,我們專注於入口匝道和輔助車道,以識別所有合併車輛。在識別了合併車輛和相應的場景後,我們根據圖10識別了相互作用的車輛。具體來說,我們將目標車道上第一輛在2秒時間內的第一輛視為第一輛交互車輛,並將連續的車輛視為第二和第三輛車輛。對於場景中出現的所有他車,自車將把它們視為環境車輛,並假設它們以恆速行駛。一個已確定的合併場景如圖11所示。

#圖10 互動式車輛的選擇:自車(藍色車輛)選擇框(紅色框)內的車輛為互動車輛

選擇框的前端在自車前2個時間進展。以選擇框內目標車道上的第一車輛為第一交互車輛,以以下車輛為第二和第三交互車輛。對於高速公路上的所有他車,它們被視為環境車輛,並假定保持恆定的速度。

#圖11 從美國101流量資料集中所確定的合併情境

#在此場景中,車輛0(藍色車輛)是合併車輛,我們讓LFGC控制車輛0。根據我們選擇交互車輛的標準,選擇車輛1(紅色車輛)和車輛2(粉紅色車輛)作為交互車輛,並將所有他車(黑色車輛)視為環境車輛,假設其以定速行駛。

對於每個合併場景,我們不是讓自車追蹤交通數據,而是使用LFGC來控制自車的行為和結果軌跡。對於所有他車,包括相互作用的車輛和環境車輛,它們遵循它們在美國101交通資料集中出現的相應軌跡。然後,LFGC需要估計互動車輛的意圖,並控制自車進行適當的合併。請注意,在資料收集過程中,互動式車輛和環境車輛可能會在實際交通過程中與合併車輛進行互動。由於1)LFGC可能會採取不同於人類操作的行為,因此互動車輛或環境車輛的行為對自車的行為沒有反應。相反,它們的行為是由流量資料集預先決定的,因此需要採取保守的措施來避免碰撞;2)交通密集,使自車沒有安全的邊際合併而不與他車的碰撞箱相交。

#表2:使用US101流量資料集驗證LFGC的統計資料

」成功「意味著自車成功地合併到目標車道上,而沒有任何碰撞。 ”失敗合併”意味著自車不能在輔助車道的末端合併。 「碰撞」是指自車與他車發生碰撞。最後,作者取一個併入過程的截圖進行了分析。

在圖12中,我們展示了一個成功合併的螢幕截圖。在這些圖中,藍色的車輛由LFGC控制,灰色的盒子表示自車在資料集中的實際位置。所有他車(包括紅色的交互車輛和黑色的環境車輛)都在資料集中遵循它們相應的軌跡。由LFGC控制的自車與人類駕駛員(灰色盒子)做出類似的決定:LFGC和人類駕駛員首先都試圖加速並在卡車前面合併(車輛1)。然而,在認識到卡車更有可能繼續不屈服後,自車決定減速,並在卡車後合併。

#圖12 在對美國高速公路101資料集驗證LFGC時成功並道的說明

其中藍色車輛是由LFGC控制的自車,灰色框是資料中出現的自車的位置。

06 結論

在本文中,我們提出了一種用於合併場景中自動車輛規劃和控制的領跟隨博弈控制器(LFGC)。 LFGC將不同駕駛意圖導致的互動不確定性作為潛在變量,估計其他駕駛意圖,並選擇促進自車合併的行動。特別是,LFGC能夠執行一個明確的機率安全特性,即受到車輛安全約束。

透過考慮自車和互動車輛的兩兩交互,LFGC能夠以一種可計算處理的方式處理與多輛車輛的交互。最後,進行了多個基於模擬的驗證,以證明LFGC的有效性,包括他車在博弈中關注領導者或跟隨者的場景,智慧駕駛員模型(IDM),以及實際的美國高速公路101數據。

本文譯自

《Interaction-Aware Trajectory Prediction and Planning for Autonomous Vehicles in Forced Merge Scenarios》

#以上是自動駕駛強制並道下軌跡預測與規劃的詳細內容。更多資訊請關注PHP中文網其他相關文章!

生成AI應用的代理框架 - 分析VidhyaApr 13, 2025 am 11:13 AM

生成AI應用的代理框架 - 分析VidhyaApr 13, 2025 am 11:13 AM想像一下,擁有一個由AI驅動的助手,不僅可以響應您的查詢,還可以自主收集信息,執行任務甚至處理多種類型的數據(TEXT,圖像和代碼)。聽起來有未來派?在這個a

您需要查看的3台Openai' s的動手實驗 - 分析VidhyaApr 13, 2025 am 11:06 AM

您需要查看的3台Openai' s的動手實驗 - 分析VidhyaApr 13, 2025 am 11:06 AM介紹 您在講話之前真正思考和理性多久?當前最新的LLM GPT-4O已經在不花很多時間做出回應的情況下提供了令人印象深刻的回應。但是想像一下它是否開始服用

如何訪問OpenAi O1? - 分析VidhyaApr 13, 2025 am 11:05 AM

如何訪問OpenAi O1? - 分析VidhyaApr 13, 2025 am 11:05 AM介紹 草莓在市場上! ! !我希望這將像其他OpenAI最新車型帶來的人工智能的最新進步一樣富有成果。 我們一直在等待GPT-5這麼長時間

使用llamaindex構建多文件代理抹布Apr 13, 2025 am 11:03 AM

使用llamaindex構建多文件代理抹布Apr 13, 2025 am 11:03 AM介紹 在人工智能快速發展的領域中,處理和理解大量信息的能力變得越來越重要。輸入多文件代理抹布 - 一個功能強大的應用

免費學習SQL的YouTube頻道 - 分析VidhyaApr 13, 2025 am 10:46 AM

免費學習SQL的YouTube頻道 - 分析VidhyaApr 13, 2025 am 10:46 AM介紹 掌握SQL(結構化查詢語言)對於追求數據管理,數據分析和數據庫管理的個人至關重要。如果您是從新手開始的,或者是經驗豐富的專業人士,請尋求改進,

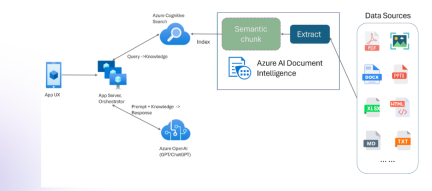

具有多模式和Azure文檔智能的抹布Apr 13, 2025 am 10:38 AM

具有多模式和Azure文檔智能的抹布Apr 13, 2025 am 10:38 AM介紹 在基於數據運行的當前世界中,關係AI圖(RAG)通過關聯數據並繪製關係來對行業產生很大影響。但是,如果一個人可以再進一步多怎麼辦

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

AI Hentai Generator

免費產生 AI 無盡。

熱門文章

熱工具

MinGW - Minimalist GNU for Windows

這個專案正在遷移到osdn.net/projects/mingw的過程中,你可以繼續在那裡關注我們。 MinGW:GNU編譯器集合(GCC)的本機Windows移植版本,可自由分發的導入函式庫和用於建置本機Windows應用程式的頭檔;包括對MSVC執行時間的擴展,以支援C99功能。 MinGW的所有軟體都可以在64位元Windows平台上運作。

MantisBT

Mantis是一個易於部署的基於Web的缺陷追蹤工具,用於幫助產品缺陷追蹤。它需要PHP、MySQL和一個Web伺服器。請查看我們的演示和託管服務。

Safe Exam Browser

Safe Exam Browser是一個安全的瀏覽器環境,安全地進行線上考試。該軟體將任何電腦變成一個安全的工作站。它控制對任何實用工具的訪問,並防止學生使用未經授權的資源。

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

Dreamweaver Mac版

視覺化網頁開發工具