揭秘ChatGPT背後天價超算!上萬顆英偉達A100,燒光微軟數億美元

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB轉載

- 2023-04-12 12:40:021111瀏覽

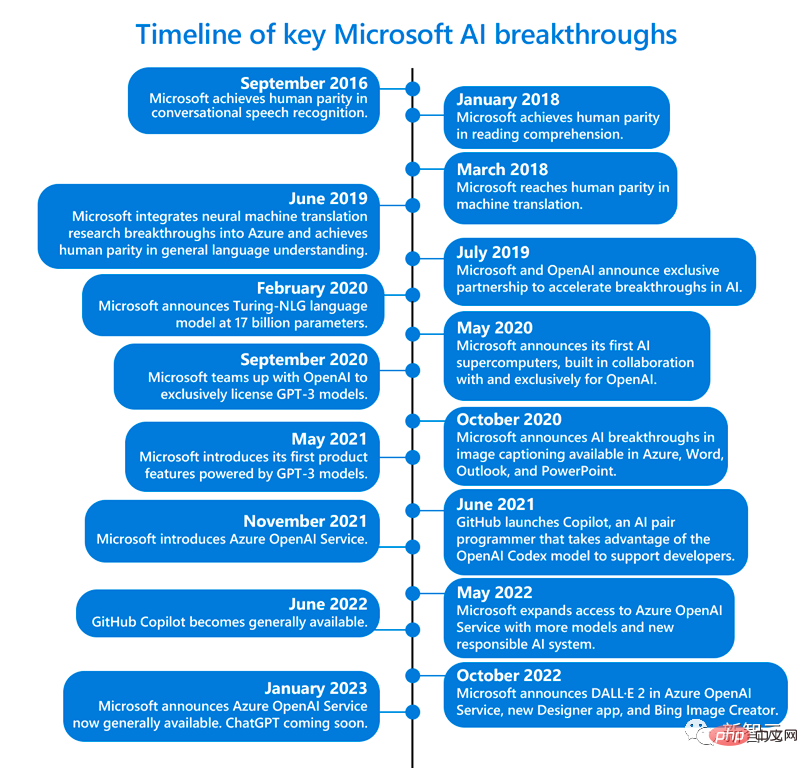

ChatGPT能成為如今火遍全球的頂流模型,少不了背後超強的算力。

數據顯示,ChatGPT的總算力消耗約為3640PF-days(即假如每秒計算一千萬億次,需要計算3640天)。

那麼,身為依託的那台微軟專為OpenAI打造的超級計算機,又是如何誕生的呢?

週一,微軟在官博上連發兩文,親自解密這台超級昂貴的超級計算機,以及Azure的重磅升級——加入成千上萬張英偉達最強的H100顯示卡以及更快的InfiniBand網路互連技術。

基於此,微軟也宣布了最新的ND H100 v5虛擬機,具體規格如下:

- 8個NVIDIA H100 Tensor Core GPU透過下一代NVSwitch和NVLink 4.0互聯

- 每個GPU有400 Gb/s的NVIDIA Quantum-2 CX7 InfiniBand,每個虛擬機器有3.2Tb/s的無阻塞胖樹型網路

- NVSwitch和NVLink 4.0在每個虛擬機器的8個本地GPU之間具有3.6TB/s的雙向頻寬

- #第四代英特爾至強可擴充處理器

- PCIE Gen5到GPU互連,每個GPU有64GB/s頻寬

- 16頻道4800MHz DDR5 DIMM

數億美元撐起來的算力

大約五年前,OpenAI向微軟提出了一個大膽的想法-建立一個可以永遠改變人機互動方式的人工智慧系統。

當時,沒人能想到,這將意味著AI可以用純語言創造出人類所描述的任何圖片,人類可以用聊天機器人來寫詩、寫歌詞、寫論文、寫郵件、寫選單……

為了建立這個系統,OpenAI需要很多算力──可以真正支撐起超大規模運算的那種。

但問題是,微軟能做到嗎?

畢竟,當時既沒有能滿足OpenAI需要的硬件,也無法確定在Azure雲端服務中建構這樣龐大的超級電腦會不會直接把系統搞崩。

隨後,微軟開啟了一段艱難的摸索。

微軟Azure高效能運算和人工智慧產品負責人Nidhi Chappell(左)和微軟策略夥伴關係高級總監Phil Waymouth (右)

為了構建支援OpenAI專案的超級計算機,它斥資數億美元,在Azure雲端運算平台上將幾萬個Nvidia A100晶片連接在一起,並改造了伺服器機架。

此外,為了給OpenAI量身打造這個超算平台,微軟十分盡心,一直在密切關注著OpenAI的需求,隨時了解他們在訓練AI時最關鍵的需要。

這麼一個大工程,成本究竟是多少呢?微軟負責雲端運算和人工智慧的執行副總裁Scott Guthrie不願透露具體數目,但他表示,「可能不只」幾億美元。

OpenAI出的難題

微軟負責策略夥伴關係的高階主管Phil Waymouth指出,OpenAI訓練模式所需的雲端運算基礎設施規模,是業界前所未有的。

指數級成長的網路GPU叢集規模,超過了業界任何人試圖建構的程度。

微軟之所以下定決心與OpenAI 合作,是因為堅信,這種前所未有的基礎設施規模將改變歷史,造出全新的AI,和全新的程式設計平台,為客戶提供切實符合他們利益的產品和服務。

現在看來,這幾億美元顯然沒白花——寶押對了。

在這台超算上,OpenAI能夠訓練的模型越來越強大,並且解鎖了AI工具令人驚嘆的功能,幾乎開啟人類第四次工業革命的ChatGPT,由此誕生。

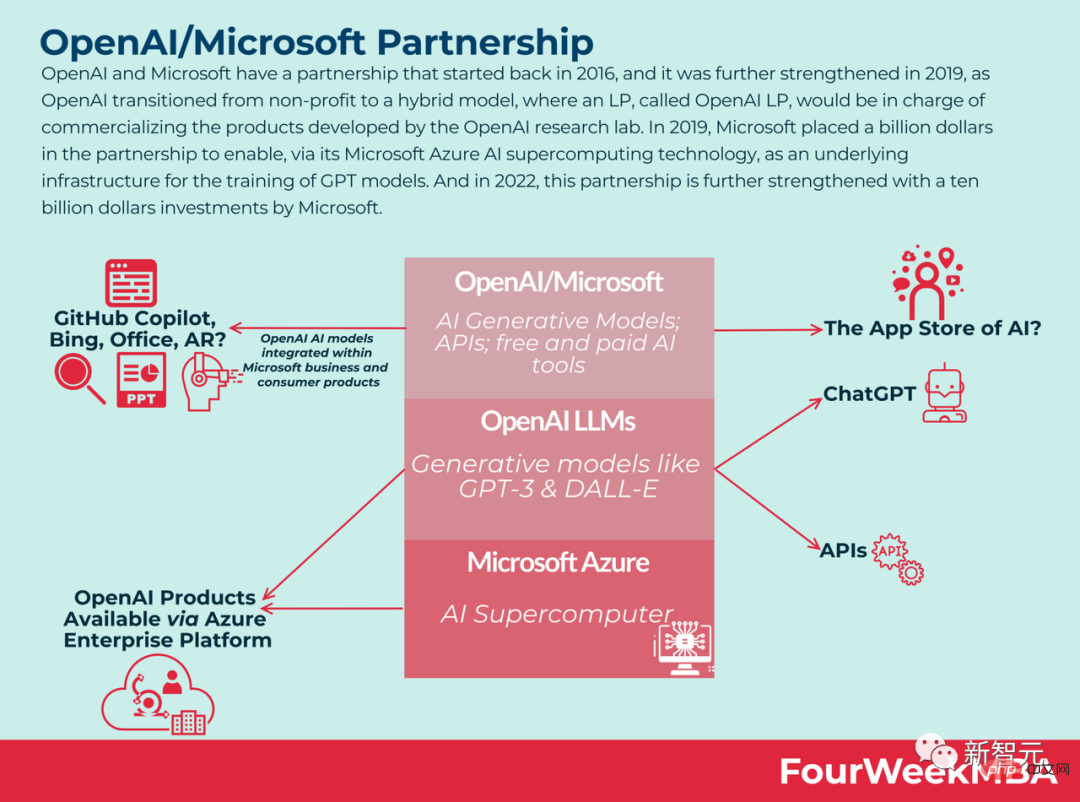

非常滿意的微軟,在1月初又向OpenAI狂砸100億美元。

可以說,微軟突破AI超算界限的雄心,已經得到了回報。而這背後體現的,是從實驗室研究,到AI產業化的轉變。

目前,微軟的辦公室軟體帝國已經初具規模。

ChatGPT版必應,可以幫我們搜尋假期安排;Viva Sales中的聊天機器人可以幫行銷人員寫郵件;GitHub Copilot可以幫開發者續寫程式碼;Azure OpenAI 服務可以讓我們存取OpenAI的大語言模型,還能存取Azure的企業級功能。

和英偉達聯手

#其實,在去年11月,微軟就曾官宣,要與Nvidia聯手建構「世界上最強大的AI超級電腦之一」,來處理訓練和擴展AI所需的巨大計算負載。

這台超級電腦基於微軟的Azure雲端基礎設施,使用了數以萬計個Nvidia H100和A100Tensor Core GPU,及其Quantum-2 InfiniBand網路平台。

Nvidia在聲明中表示,這台超級電腦可用於研究和加速DALL-E和Stable Diffusion等生成式AI模型。

隨著AI研究人員開始使用更強大的GPU來處理更複雜的AI工作負載,他們看到了AI模型更大的潛力,這些模型可以很好地理解細微差別,從而能夠同時處理許多不同的語言任務。

簡單來說,模型越大,你擁有的資料越多,你能訓練的時間越長,模型的準確性就越好。

但是這些較大的模型很快就會到達現有運算資源的邊界。而微軟明白,OpenAI需要的超級電腦是什麼樣子,需要多大的規模。

這顯然不是說,單純地購買一大堆GPU並將它們連接在一起之後,就可以開始協同工作的東西。

微軟Azure高效能運算和人工智慧產品負責人Nidhi Chappell表示:「我們需要讓更大的模型訓練更長的時間,這意味著你不僅需要擁有最大的基礎設施,你還必須讓它長期可靠地運行。」

Azure全球基礎設施總監Alistair Speirs表示,微軟必須確保它能夠冷卻所有這些機器和晶片。例如,在較涼爽的氣候下使用外部空氣,在炎熱的氣候下使用高科技蒸發冷卻器等。

此外,由於所有的機器都是同時啟動的,所以微軟還必須考慮它們和電源的擺放位置。就像你在廚房同時打開微波爐、烤麵包機和吸塵器時可能會發生的情況,只不過是資料中心的版本。

大規模AI訓練

完成這些突破,關鍵在哪裡?

難題就是,如何建構、操作和維護數萬個在高吞吐量、低延遲InfiniBand網路上互連的共置GPU。

這個規模,已經遠遠超出了GPU和網路設備供應商測試的範圍,完全是一片未知的領域。沒有任何人知道,在這種規模下,硬體會不會崩。

微軟Azure高效能運算和人工智慧產品負責人Nidhi Chappell解釋道,在LLM的訓練過程中,涉及的大規模運算通常會被劃分到一個叢集中的數千個GPU上。

在被稱為allreduce的階段,GPU之間會互相交換它們所做工作的資訊。此時就需要透過InfiniBand網路進行加速,讓GPU在下一塊運算開始前完成。

Nidhi Chappell表示,由於這些工作跨越了數千個GPU,因此除了要確保基礎設施的可靠外,還需要大量許多系統級優化才能實現最佳的效能,而這是經過許多世代的經驗總結出來的。

所謂系統級最佳化,其中就包含能夠有效利用GPU和網路設備的軟體。

在過去的幾年裡,微軟已經開發了這種技術,在使訓練具有數十萬億個參數的模型的能力得到增長的同時,降低了訓練和在生產中提供這些模型的資源需求和時間。

Waymouth指出,微軟和合作夥伴也一直在逐步增加GPU叢集的容量,發展InfiniBand網絡,看看他們能在多大程度上推動維持GPU叢集運作所需的數據中心基礎設施,包括冷卻系統、不間斷電源系統和備用發電機。

微軟AI平台公司副總裁Eric Boyd表示,這種為大型語言模型訓練和下一波AI創新而優化的超算能力,已經可以在Azure雲端服務中直接獲得。

並且微軟透過與OpenAI的合作,累積了大量經驗,當其他合作方找來、想要同樣的基礎設施時,微軟也可以提供。

現在,微軟的Azure資料中心已經涵蓋了全球60多個地區。

全新虛擬機器:ND H100 v5

在上面這個基礎架構上,微軟一直在持續改進。

今天,微軟就宣布了全新的可大規模擴展虛擬機,這些虛擬機整合了最新的NVIDIA H100 Tensor Core GPU 和 NVIDIA Quantum-2 InfiniBand 網路。

透過虛擬機,微軟可以提供客戶基礎設施,根據任何AI任務的規模進行擴展。據微軟稱,Azure的新ND H100 v5 虛擬機器為開發者提供卓越的效能,同時呼叫數千個GPU。

參考資料:##https://www.php.cn/link/a7bf3f5462cc82062e41b3a2262e1a21

#以上是揭秘ChatGPT背後天價超算!上萬顆英偉達A100,燒光微軟數億美元的詳細內容。更多資訊請關注PHP中文網其他相關文章!