OpenAI提出的新摩爾定律如何理解?中國隱藏算力巨頭有話說

- 王林轉載

- 2023-04-12 11:34:071364瀏覽

本文經AI新媒體量子位元(公眾號ID:QbitAI)授權轉載,轉載請聯絡來源。

ChatGPT火遍全世界,與之相關的一切都在風口浪尖。

OpenAI執行長Sam Altman看似隨意分享的一句話,就成為熱議的焦點:

新版摩爾定律很快就要來了,宇宙中的智能每18個月翻一倍。

有些人猜測可能指神經網路的參數量,但和過去幾年的資料並未正確的。

有些人理解是包括人和AI在內所有智能體的能力,但這個指標如何衡量又成了問題。

也有很多學者、網友不認同這個判斷,IBM科學家Grady Booch表示這是胡說,就被頂成了熱評第一。

對於這些討論,Altman只是簡單的回覆了「現在還沒開始」。

但不管怎麼說,AI快速發展的背後,算力是一個明確可衡量的指標,也是不可或缺的條件。

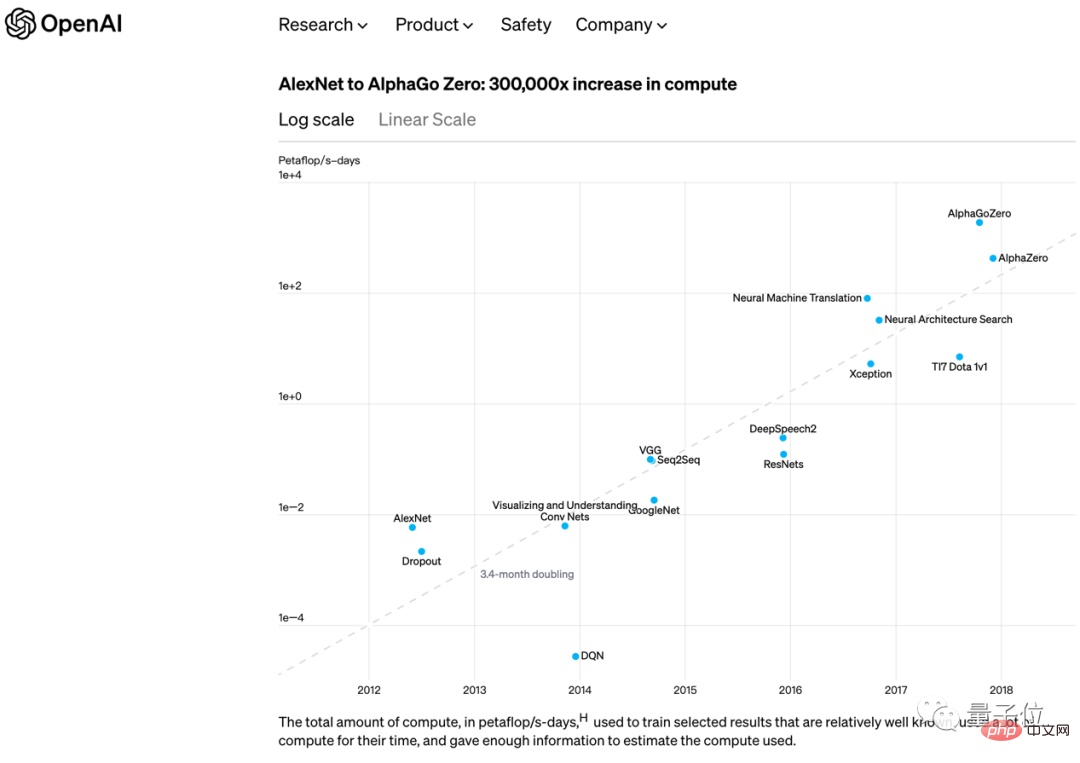

早在2018年,OpenAI也發表過另一個與摩爾定律形式相近的觀點:

從2012年的AlexNet到2017年底的AlphaGo Zero,訓練最大AI模型所需算力每3.4個月翻倍。

#不久後,他們自己發布的GPT-3又把這個數字縮短到2個月翻一番。

到了ChatGPT時代,需要考慮的就不只是AI訓練算力,全球1億月活用戶、接入微軟必應搜尋等產品,AI推理算力也是重要支撐。

最直接為ChatGPT提供算力的是微軟Azure雲,從2019年第一次投資OpenAI10億美元開始就是OpenAI的獨家雲端供應商。

最新追加100億美元投資時,雙方在聲明中再次強調了這一點。

獨家供應,表示OpenAI的開發基礎架構全部建置在Azure雲端上,使用Azure雲端提供的工具鏈。

也意味著即將到來的AI創業大軍,要想基於ChatGPT也只能選擇Azure雲。

對應的,GoogleAI背後有自家的Google雲,雲端運算產業第一的亞馬遜也緊急找來HuggingFace合作部署開源大模型Bloom。

……

而雲端運算並不是算力的源頭,就在ChatGPT的火爆火熱中,算力供應側出現一批表現亮眼的公司。

有些玩家你或許馬上就能想到,但也有一些參與者,由於之前其他業務太出名,可能在意料之外。

這其中,就有一位來自中國的選手。

新摩爾定律,離不開算力

上一波以圖像辨識、推薦演算法為代表的AI應用落地,推動數位經濟發展的時候,算力從一個技術名詞上升成經濟學名詞,被產業、學界一再強調。

這一波生成式AI引爆全球熱情的時候,算力再一次升級成了與普通人工作生活相關的,被大眾所感知到。

ChatGPT消耗多少成本?

半導體產業資訊機構SemiAnalysis做過一個估算:以GPU衡量,需要約3617台英偉達HGX A100伺服器,也就是28936塊A100;以資金衡量,用戶每一次提問的成本是0.36美分, 一天就要花費69萬美元。

得出的結論是:如果讓ChatGPT承擔谷歌搜尋的全部訪問量,總共需要410萬張英偉達A100 GPU。

所以自然而然,英偉達就是那個ChatGPT火爆中最知名的獲利者。目前英偉達在AI晶片市場約佔75%-80%份額,ChatGPT每一次熱搜,都是老黃帳戶金幣到帳的聲音,在這波熱潮加持下,截至最新財報公佈之時,英偉達的股價在2023年足足上漲了45%。

CEO黃仁勳也在電話會議上有個最新表態:

「生成式AI,讓全球企業都有了開發和部署人工智慧的戰略緊迫感。」

##「生成式AI,讓全球企業都有了開發和部署人工智慧的戰略緊迫感。」而且這只是開始,根據花旗銀行則預測,未來12個月內英偉達GPU銷售額可達30億至110億美元。英偉達之外,從GPU往上游追溯ChatGPT紅利贏家,是位於晶片製造層的台積電。

近期就有報導稱,近期英偉達、AMD包括蘋果都對台積電下緊急訂單,希望搶佔未來產能。 之前,台積電多年來的收入支柱一直是智慧型手機業務,但在2022年,智慧型手機銷量慘淡,人工智慧爆發的雙重影響下,高效能運算業務連續三個季度反超——或許也是時代轉關的先聲。 更重要的是,台積電實際上也已經明確了這種變化。在最近的對外發聲中,台積電對於接下來的一年給出了樂觀預期,表達也非常耐人尋味:儘管全球半導體產業面臨衰退,但全年業績仍有望小幅增長。 當然,如果更簡單粗暴推導,其實英偉達漲的時候,台積電業績也不會差,畢竟產業鏈角色和供需關係就放在那裡。 那依照這個供需,是不是ChatGPT帶來的算力層紅利,也會到雲端運算、雲端服務廠商了? 是,也不全是。 就在ChatGPT的火熱中,許多分析指向了雲端運算,但也有分析快速把目光集中到了中間環節──GPU到雲端運算服務的中間環節──伺服器。 晶片要真正發揮作用,繞不過伺服器:晶片之間如何高速互聯,整個機櫃如何控制能耗和散熱,系統設計如何適應不同工作負載,都影響著最終性能和效率。 Gartner就有預測稱,到2025年,全球伺服器市場規模會達到1,350億美元,其中AI伺服器和AI雲端服務更是會呈現爆發態勢。 而也就是在這一環節,在AI伺服器方向,藏著文章開頭提到的來自中國的算力參與者。聯想集團,Lenovo。

或許之前,你對聯想集團認知更多的是PC,但PC的本質也是個人算力。 聯想走過這樣一條從PC到高效能運算,再到更廣泛的算力基礎設施之路。 這有最直觀的財報資料為證。根據聯想集團公佈的第三季財報(2022年10-12月),其ISG(Infrastructure Solutions Group)基礎建設方案業務,營收成長48%,營運利潤更是激增156%。 與DigiTimes統計的同期全球伺服器出貨量年減7.1%,季減4.3%形成鮮明對比。 聯想集團ISG,提供的正是算力為核心的基礎設施輸出和方案,伺服器是其中最重要的業務之一。 並且更直接地細分到伺服器業務,該季度營收年增了35%,已經成為了全球第三大伺服器供應商-來自GhatGPT的算力紅利功不可沒。 但ChatGPT的突然爆火,實際上也只是把聯想集團作為算力贏家的隱密角色推到了台前。 聯想靠什麼成為算力「隱形」冠軍?聯想集團董事長兼CEO楊元慶稱,ChatGPT背後所需的普慧算力基礎設施恰好是聯想已經佈局多年的強項。

對算力設備的需求聯想早已預見,並提出「端-邊-雲端-網-智」的新IT架構。去年,聯想進一步提出普慧算力。也就是隨著數據爆炸式增長,我們進入了一個全新的數位化、智慧化的時代,對於計算的需求如雨後春筍,「單兵作戰」的設備以及本地化的數據中心已經遠遠不能滿足隨時隨地的計算需求,需要「端-邊-雲端-網-智」的新IT架構

為使用者提供無所不在的普慧算力。 由此可見,聯想成為的並不是生產算力的“水源”,而是“送水人”——將晶片整合成可高效釋放算力的伺服器,更不容易被外界感知。 在這個角色和定位中,聯想集團很「強」——這種強核心是兩個面向。一是伺服器產品效能;二是數量規模。

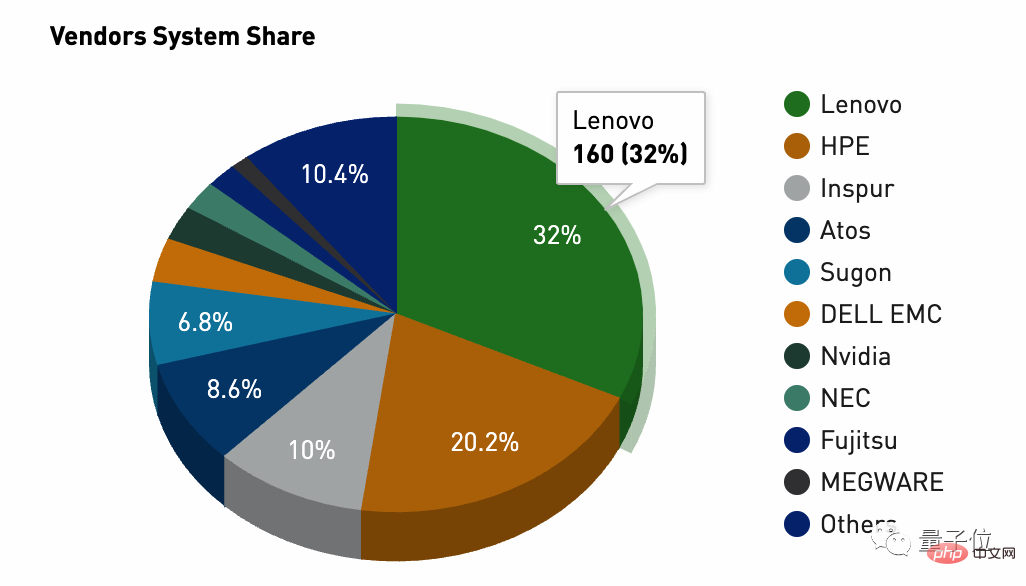

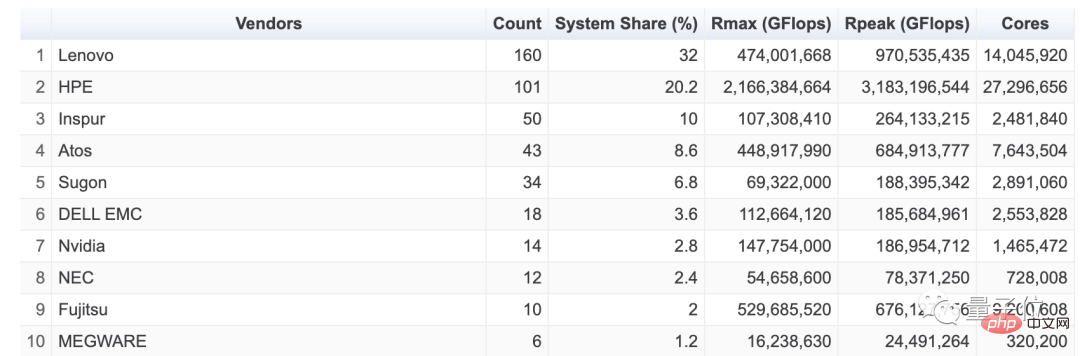

####在這個領域,全球高效能運算榜單TOP500是觀察伺服器算力的最佳參考,而如果開啟最新一期全球高效能運算榜單TOP500(2022年11月),就可以感知到上述所說的聯想集團之強。

市佔率比32%,以160台的供給佔全球第一,甚至領先第二名惠普集團近12個百分點。

#且聯想集團這個算力供應,還具有客戶構成上的普遍性和多元性。

在回答日本經濟新聞社的提問時,聯想集團執行副總裁Kirk Skaugen就曾凡爾賽式透露:全球排名前10的公有雲提供商中,有8個是聯想集團的客戶。

換句話說,聯想伺服器得到了全球客戶的認可,這對國產伺服器製造商來說很不容易。

這些客戶中,外界猜測就包括了雲端領域第二名的微軟Azure雲端——ChatGPT背後的加速引擎、以及「金主爸爸」。

當初微軟大手筆投資支持OpenAI時,就有評論說,精明的微軟CEO納德拉哪裡會用真金白銀的投資支持,核心提供的還是等價雲服務,既獲得了OpenAI股權,實現了頂級AI研究機構的戰略佈局,又為自家Azure雲帶來了客戶和增漲,簡直一石二鳥,這生意虧不了。

只是沒想到,瘋狂的OpenAI還真用大模型搞出了名堂,真用一個偶然創新出的ChatGPT點燃了全球科技互聯網,讓所有玩家陷入大模型、生成式AI的沸騰中。

微軟不僅率先獲益,還把老對手谷歌逼到牆角,動搖了谷歌搜尋的現金乳牛,納德拉估計最近夢都是甜的。

而與微軟合作關係密切、還在2022年拿下微軟設備合作夥伴獎的聯想集團,甜頭已經直接展現在財報業績上了。

另外,也是這層關係,也就能理解2021年聯想集團創新科技大會上,為什麼會出現微軟CEO納德拉了,只不過當年的公告還太“行業黑話”,需要結合今日ChatGPT紅利才能真正看明白,當時公告是這樣寫的:未來雙方在PC、雲端運算與邊緣運算、服務三個領域展開更深入合作。

不過即使聯想集團成為了ChatGPT這波熱潮的算力提供者,就意味著這種前景可持續嗎?畢竟微軟和ChatGPT的案例有其特殊性,幕後的聯想集團嚐到甜頭有幸運的因素。

但從ChatGPT確立的大模型發展方向來看,趨勢會持續下去,算力供給側還會隨之發生方向性改變。

據《財經十一人》最近基於多位基礎設施人士觀點得出的結論稱,AI算力會對雲端運算的財務模型帶來重大影響,背後都是摩爾定律式的指數成長邏輯:

其一,AI算力消耗量、成長速度,將遠大於一般算力消耗量。信通院2022年數據顯示,2021年中國通用算力規模95 EFlops,成長速度為24%,佔47%。智慧算力規模是104EFlops,成長速度為85%,佔比超50%。這意味著,智慧算力會成為雲端運算的新一輪增長點。

其二,智能算力的價格高於通用算力。通用算力的價格不斷降低,由於AI算力相對稀缺,價格目前正被推高。理論上,實現規模化營運的AI算力比通用算力的毛利率高10%以上。

其三,AI算力 大模型在垂直產業的使用可以讓新的應用模式產生。例如金融、自動駕駛、醫療研發、智慧製造場景下,企業通常需要採購企業的AI大模型開源平台,調教適合自己業務的小模型。這種PaaS化的AI服務可以帶來60%以上的毛利。這是目前加深AI算力/AI模型使用的最佳路徑。

這種AI算力方向性的變革,具體到中國市場,還可以推演出更具體影響:

目前不可否認的是,中國雲廠商的AI算力、大模型和微軟之間存在著較大的差距。原因是,算力規模、資料規模、模型精度都存在差距。以算力規模為例,支撐ChatGPT的智慧算力群集至少需要使用上萬張英偉達GPU A100顯示卡。一次完整的模型訓練成本超過1200萬美元。

ChatGPT背後的智慧算力集群,光是GPU顯示卡採購成本就超過10億元。國內目前能夠支撐起類似基礎設施的企業不超過3家。中國雲端廠商的資料中心通常只配備了數千張GPU顯示卡。原因是採購一片英偉達頂級GPU的成本高達8萬元。一台伺服器通常需要4張-8張GPU,一台GPU伺服器的成本通常超過40萬元。國內服務器均價4萬-5萬元。這意味著GPU伺服器的成本是普通伺服器的10倍以上。

所以這波大模型驅動的技術變革浪潮,對中國算力供應玩家的挑戰和機遇,也基本上能推導出來了。

首先,必須具備完整、成熟、穩定的智慧算力叢集基礎設施。

其次,相關產品在綜合性能之外,還需要具備能源效率優勢-環保且省成本。

於是明確了這兩點結論,大概也就能知曉聯想集團作為ChatGPT紅利背後隱藏贏家,算力前景方向上還會可持續下去的原因了。

如果算力迎來新摩爾定律,不可忽視的就會是能耗問題,國家發展改革委高技術司主要負責人21年曾表示,我國資料中心年用電量約佔全社會用電的2%。

換個更直觀的說法是“每年耗電超過2.5個三峽大壩發電量”,摩爾定律是一種指數增長,而三峽大壩發電量是不可能指數增長的。

聯想集團為此研發了領先的「海神」溫水水冷技術,使用50°C溫水透過流動循環帶走熱量,省去了冷水機組和熱交換器,還可以利用餘熱為建築供暖,每年電費節省和排放降低超過42%

在最新的全球HPC Green500榜單上,聯想集團交付的Henri系統以每瓦特電力消耗可執行65.091億次浮點運算的認證性能,不僅同時符合國內和國際要求,甚至成為全球最節能的高效能運算系統。

實際上,聯想已經不是你刻板印象裡的那個只有電腦的公司了。整體來看,在算力基礎建設業務迎來爆發的同時,聯想集團整體也逐漸完成了轉型:個人電腦以外的業務總營收佔比,已經超過了40%。

ChatGPT也好、大模型也好,甚至AI也好,技術創新周期中率先洶湧開來的算力紅利,正在刷新聯想集團,或者更準確地說,把算力供給側的幕後隱形冠軍推到台前。

以上是OpenAI提出的新摩爾定律如何理解?中國隱藏算力巨頭有話說的詳細內容。更多資訊請關注PHP中文網其他相關文章!