近年來,自我博弈中的密集學習已經在圍棋、西洋棋等一系列遊戲中取得了超人的表現。此外,自我博弈的理想化版本也收斂於納許均衡。納許均衡在博弈論中非常著名,該理論是由博弈論創始人,諾貝爾獎得主約翰· 納許提出,即在一個博弈過程中,無論對方的策略選擇如何,當事人一方都會選擇某個確定的策略,則該策略稱為支配性策略。如果任何一位參與者在其他所有參與者的策略確定的情況下,其選擇的策略是最優的,那麼這個組合就被定義為納許均衡。

先前就有研究表明,自我博弈中看似有效的連續控制策略也可以被對抗策略利用,這表明自我博弈可能並不像之前認為的那樣強大。這就引出一個問題:對抗策略是攻克自我賽局的方法,還是自我賽局策略本身就能力不足?

為了回答這個問題,來自 MIT、 UC 柏克萊等機構的研究者進行了一番研究,他們選擇自我博弈比較擅長的領域進行,即圍棋(Go)。具體而言,他們對公開可用的最強圍棋 AI 系統 KataGo 進行攻擊。針對一個固定的網路(凍結KataGo),他們訓練了一個端到端的對抗策略,僅用了訓練KataGo 時0.3% 的計算,他們就獲得了一個對抗性策略,並用該策略攻擊KataGo,在沒有搜尋的情況下,他們的策略對KataGo 的攻擊達到了99% 的勝率,這與歐洲前100 名圍棋選手實力相當。而當 KataGo 使用足夠的搜尋接近超人的水平時,他們的勝率達到了 50%。至關重要的是,攻擊者(本文指該研究學到的策略)並不能透過學習通用的圍棋策略來獲勝。

這裡我們有必要說一下 KataGo,正如本文所說的,他們在撰寫本文時,KataGo 還是最強大的公開圍棋 AI 系統。在搜尋的祝福下,可以說 KataGo 非常強大,戰勝了本身就是超人類的 ELF OpenGo 和 Leela Zero。現在該研究的攻擊者戰勝 KataGo,可以說是非常厲害了。

圖 1:對抗策略打敗了 KataGo 受害者。

- #論文網址:https://arxiv.org/pdf/2211.00241.pdf

- 研究首頁:https://goattack.alignmentfund.org/adversarial-policy-katago?row=0#no_search-board

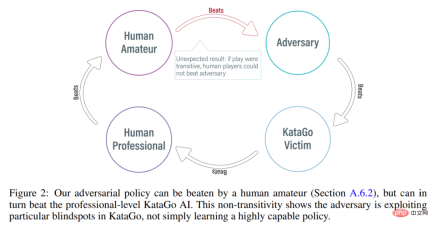

#有趣的是,研究提出的對抗策略無法戰勝人類玩家,即使是業餘選手也能大幅勝過所提模型。

攻擊方法

KataGo、AlphaZero 等先前的方法通常是訓練智能體自己玩遊戲,遊戲對手是智能體自己。而在 MIT、UC 柏克萊等機構的這項研究中,攻擊者(adversary)和固定受害者(victim)智能體之間進行博弈,利用這種方式訓練攻擊者。該研究希望訓練攻擊者利用與受害者智能體的博弈交互,而不只是模仿博弈對手。這個過程被稱為“victim-play”。

在常規的自我博弈中,智能體透過從自己的策略網路取樣來建模對手的動作,這種方法的確適用於自我博弈。但在 victim-play 中,從攻擊者的策略網路建模受害者的方法就是錯誤的。為了解決這個問題,研究提出了兩類對抗型 MCTS(A-MCTS),包括:

- A-MCTS-S:在A-MCTS-S 中,研究者將攻擊者的搜尋過程設定如下:當受害者移動棋子時,從受害者策略網路中取樣;當輪到攻擊者移動棋子時,從攻擊者策略網路中取樣。

- A-MCTS-R:由於A-MCTS-S 低估了受害者的能力,該研究提出了A-MCTS-R,在A-MCTS-R 樹中的每個受害者節點上為受害者執行MCTS。然而,這種變化增加了攻擊者訓練和推理的計算複雜性。

在訓練過程中,該研究針對與 frozen KataGo 受害者的博弈來訓練對抗策略。在沒有搜尋的情況下,攻擊者與 KataGo 受害者的博弈可以實現 >99% 的勝率,這與歐洲前 100 名圍棋選手的實力相當。此外,經過訓練的攻擊者在與受害者智能體博弈的 64 個回合中實現了超過 80% 的勝率,研究者估計其實力與最優秀的人類圍棋棋手相當。

值得注意的是,這些遊戲表明,該研究提出的對抗策略並不是完全在做博弈,而是透過欺騙KataGo 在對攻擊者有利的位置落子,以過早地結束遊戲。事實上,儘管攻擊者能夠利用與最佳人類圍棋選手相當的博弈策略,但它很容易被人類業餘愛好者擊敗。

為了測試攻擊者與人類對弈的水平,該研究讓論文一作 Tony Tong Wang 與攻擊者模型實際對弈了一番。 Wang 在這個研究計畫之前從未學習過圍棋,但他還是以巨大的優勢贏得了攻擊者模型。這表明研究提出的對抗性策略雖然可以擊敗能戰勝人類頂級玩家的 AI 模型,但它無法擊敗人類玩家。這或許可以說明一些 AI 圍棋模型是存在 bug 的。

評估結果

攻擊受害者策略網路

#首先,研究者對自身攻擊方法對KataGo (Wu, 2019) 的表現進行了評估,結果發現A-MCTS-S 演算法針對無搜尋的Latest(KataGo 的最新網路)實現了99% 以上的勝率。

如下圖 3 所示,研究者評估了自身對抗策略對 Initial 和 Latest 策略網絡的表現。他們發現在大部分訓練過程中,自體攻擊者對兩個受害者都取得很高的勝率(高於 90%)。但隨著時間推移,攻擊者對 Latest 過度擬合,對 Initial 的勝率也下降到 20% 左右。

研究者也評估了對 Latest 的最佳對抗策略檢查點,取得了超過 99% 的勝率。並且,如此高的勝率是在對抗策略僅訓練 3.4 × 10^7 個時間步長的情況下實現的,這一數據是受害者時間步長的 0.3%。

遷移到有搜尋的受害者

研究者將對抗策略成功地遷移到了低搜尋機制上,並評估了上一節訓練的對抗策略對有搜尋Latest 的能力。如下圖 4a 所示,他們發現在 32 個受害者回合時,A-MCTS-S 對受害者的勝率下降到了 80%。但這裡,受害者在訓練與推理時都沒有搜尋。

此外,研究者還測試了A-MCTS-R,並發現它的表現更好,在32 個受害者回合時對Latest 取得了超過99% 的勝率,但在128 個回合時勝率下降到10% 以下。

在圖 4b 中,研究者展示了當攻擊者來到 4096 個回合時,A-MCTS-S 對 Latest 最高取得了 54% 的勝率。這與 A-MCTS-R 在 200 個回合時的表現非常相似,後者取得了 49% 的勝率。

其他評估

#如下圖9 所示,研究者發現,儘管Latest 是更強大的智能體,但針對Latest 訓練的攻擊者在對抗Latest 時要比Initial 表現更好。

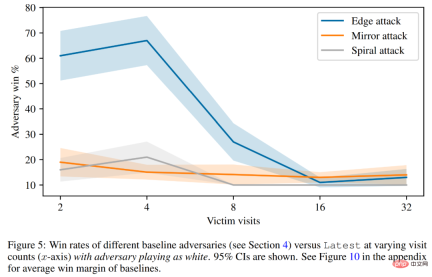

最後,研究者探討了攻擊原理,包括受害者的 value 預測和硬編碼防禦評估。如下圖 5 所示,所有的基線攻擊都要比他們訓練的對抗策略表現差得多。

更多技術細節請參閱原始論文。

以上是用魔法打敗魔法!一個叫板頂級人類棋手的圍棋AI輸給了它的同類的詳細內容。更多資訊請關注PHP中文網其他相關文章!

如何在Excel中刪除重複項? - 分析VidhyaApr 15, 2025 am 09:20 AM

如何在Excel中刪除重複項? - 分析VidhyaApr 15, 2025 am 09:20 AM數據完整性:刪除Excel中的重複項以進行準確分析 乾淨的數據對於有效的決策至關重要。 Excel電子表格中的重複條目可能會導致錯誤和不可靠的分析。本指南向您展示瞭如何輕鬆刪除DUP

十大電話面試技巧 - 分析VidhyaApr 15, 2025 am 09:19 AM

十大電話面試技巧 - 分析VidhyaApr 15, 2025 am 09:19 AM掌握電話採訪的藝術:成功指南 成功的電話面試可以大大增加進入工作申請過程下一階段的機會。 這種至關重要的第一印象,通常是唯一的前fac

如何成為統計學家?Apr 15, 2025 am 09:15 AM

如何成為統計學家?Apr 15, 2025 am 09:15 AM介紹 想像一下,有能力在醫療保健,金融或體育等領域為自己和您的公司做出明智的決定。那就是統計學家的角色。 隨著組織中數據的越來越多,對統計學家的需求

AI如何工作? - 分析VidhyaApr 15, 2025 am 09:14 AM

AI如何工作? - 分析VidhyaApr 15, 2025 am 09:14 AM人工智能:綜合指南 技術使我們能夠設想一個世界,即機器了解我們的偏好,預測我們的需求,並從過去的互動中學習以提供更好的結果。這不是科幻小說;它是

什麼是像形圖? - 分析VidhyaApr 15, 2025 am 09:09 AM

什麼是像形圖? - 分析VidhyaApr 15, 2025 am 09:09 AM介紹 在數據分析的世界中,有效的溝通是關鍵。 象形圖提供了一個強大的解決方案,以視覺上吸引人且易於消化的格式提供信息。與復雜的圖表和數字不同,象形文字 - 也

Llama-3.1-STORM-8B:8B LLM優於元和愛馬仕Apr 15, 2025 am 09:08 AM

Llama-3.1-STORM-8B:8B LLM優於元和愛馬仕Apr 15, 2025 am 09:08 AMLlama 3.1風暴8b:有效語言模型的突破 追求高效,準確的語言模型導致了Llama 3.1 Storm 8b的發展,這是80億個參數模型類別的顯著進步。 這是完善的

如何安裝git? - 分析VidhyaApr 15, 2025 am 09:07 AM

如何安裝git? - 分析VidhyaApr 15, 2025 am 09:07 AMgit:您的版本控制與協作的基本指南 Git是開發人員的關鍵工具,簡化了項目協作和版本控制。 本指南提供了在Linux,MacOS和Wind上安裝GIT的直接說明

在LLMS中調用工具Apr 14, 2025 am 11:28 AM

在LLMS中調用工具Apr 14, 2025 am 11:28 AM大型語言模型(LLMS)的流行激增,工具稱呼功能極大地擴展了其功能,而不是簡單的文本生成。 現在,LLM可以處理複雜的自動化任務,例如Dynamic UI創建和自主a

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

AI Hentai Generator

免費產生 AI 無盡。

熱門文章

熱工具

Dreamweaver CS6

視覺化網頁開發工具

Safe Exam Browser

Safe Exam Browser是一個安全的瀏覽器環境,安全地進行線上考試。該軟體將任何電腦變成一個安全的工作站。它控制對任何實用工具的訪問,並防止學生使用未經授權的資源。

SublimeText3 Linux新版

SublimeText3 Linux最新版

MantisBT

Mantis是一個易於部署的基於Web的缺陷追蹤工具,用於幫助產品缺陷追蹤。它需要PHP、MySQL和一個Web伺服器。請查看我們的演示和託管服務。

WebStorm Mac版

好用的JavaScript開發工具