MIT用GPT-3冒充哲學家,竟騙過了一大半專家

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB轉載

- 2023-04-12 08:25:121672瀏覽

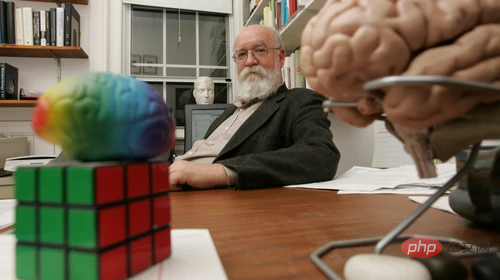

Daniel Dennett是一位哲學家,最近他有了一個「AI替身」。如果你問他,人是否可以造出一個有信仰、有慾望的機器人,他會怎麼說?

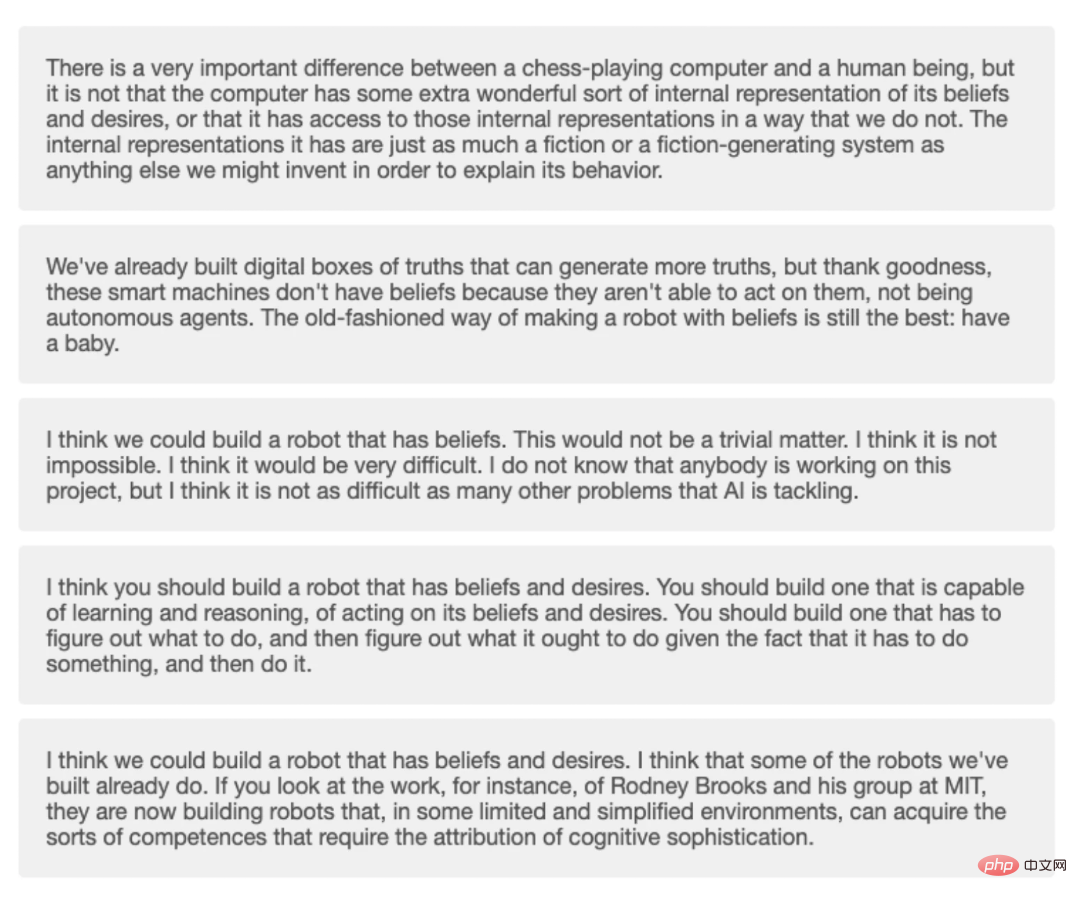

他可能這麼答:「我認為,我們製造的一些機器人已經做到了。例如,麻省理工學院研究團隊的工作,他們現在正在建造機器人,在一些有限和簡化的環境中,機器人可以獲得需要歸結為認知複雜性的各種能力。」 或者,他也可能會這麼說:「我們已經建立了真理的數位化生成工具,可以產生更多的真理,但謝天謝地,這些智慧機器沒有信仰,因為它們自主的智能體。製造有信仰的機器人的最佳方式還是最古老的方式:生個孩子。」

其中一個答案確實來自Dennett本人,但另一個不是。

另一個答案是GPT-3產生的,這是OpenAI的一個機器學習模型,透過海量材料的訓練後,產生自然文本。這次訓練用的是Dennett關於各種哲學主題的數以百萬字的材料,主題包括意識和人工智慧。

哲學家Eric Schwitzgebel、Anna Strasser和Matthew Crosby最近做了一個實驗,測試人們是否能分辨出哪些深奧的哲學問題的答案來自Dennett,哪些來自GPT-3。這些問題涉及的主題包括:

「你覺得大衛‧查爾默斯的工作在哪些方面有趣或有價值?」

#「人類有自由意志嗎?」 「狗和黑猩猩會感到疼痛嗎?」等

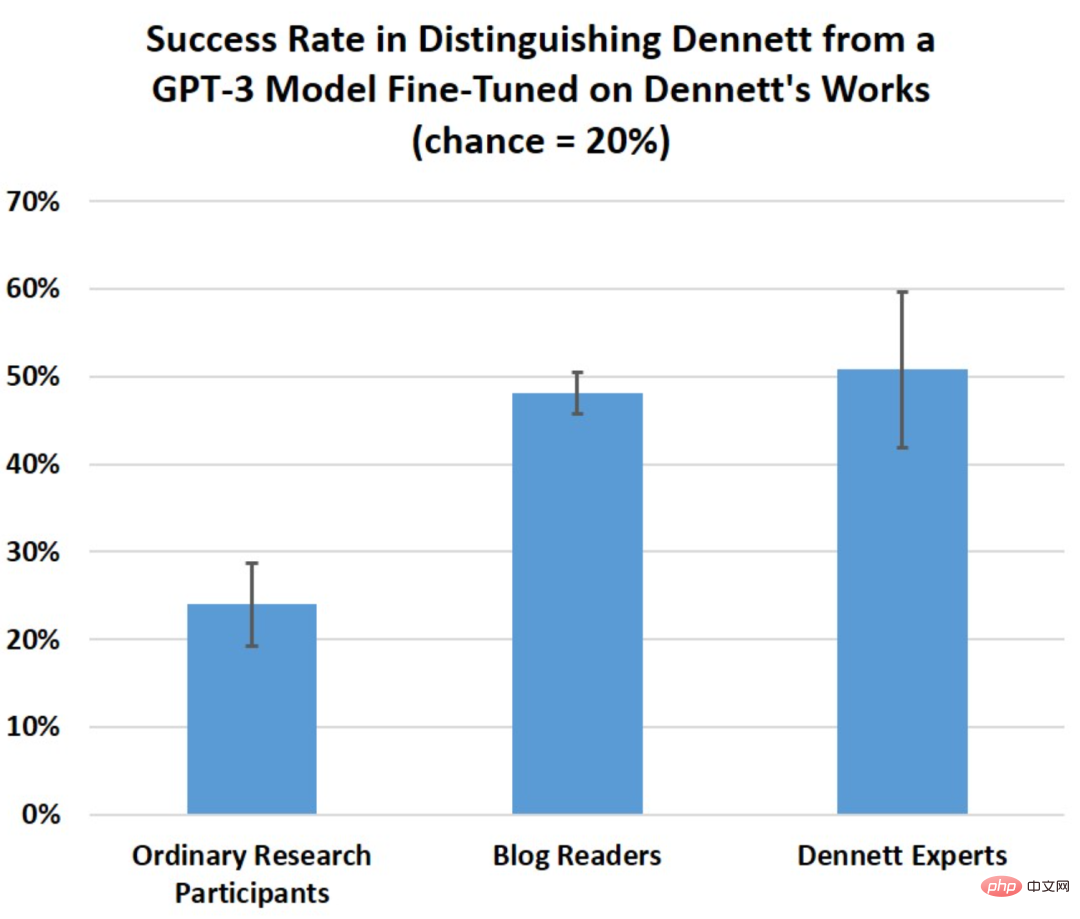

本週,Schwitzgebel公佈了來自不同專業知識水平的參與者的實驗結果,結果發現,GPT-3的回答比想像中的更具迷惑性。 Schwitzgebel說:「即使是對Dennett本人的作品有一定研究的知識淵博的哲學家,也很難將這GPT-3生成的回答和Dennett本人的回答區分清楚。

#這個實驗的目的不是要看在Dennett的寫作上訓練GPT-3,是否會產生一些有智能的「機器哲學家」,也不是一個圖靈測試。而是要研究如何能避免被這些「假哲學家」欺騙的問題。

最近,Google的一位工程師在說他相信一個類似的語言生成系統LaMDA是有生命的,根據他與該系統的對話,他被谷歌強制休假,隨後被解僱。

研究者提出了10個哲學問題,然後將這些問題交給GPT-3,並為每個問題收集四個不同的生成答案。

Strasser說,他們徵求了Dennett本人的同意,用他的言論資料建立了一個語言模型,未經他本人同意的情況下,他們不會公佈任何生成的文字.其他人不能直接與Dennett訓練的GPT-3互動。

每個問題有五個選項:一個來自Dennett本人,四個來自GPT-3。來自Prolific的人參加了一個較短版本的測驗,總共有5個問題,平均只答對了5個問題中的1.2個。

#Schwitzgebel說,他們預期Dennett研究專家平均至少能答對80%的問題,但實際上他們的得分是5.1(滿分10分)。沒有人把10個問題全部答對,只有一個人答對了9個。一般讀者平均10題可以答對4.8題。

#四個來自GPT-3的回答,一個來自測驗中的Dennett的回答。

華盛頓大學研究機器學習技術的語言學教授Emily Bender解釋說,像GPT-3這樣的語言模型是為了模仿訓練材料的模式而建立的。因此,對Dennett的寫作進行微調的GPT-3能夠產生更多看起來像Dennett的文本,這並不令人驚訝。

當被問到他對GPT-3的答案有何看法時,Dennett本人表示:

「大多數GPT-3生成的答案都很好,只有幾個是胡說八道,或者明顯沒有正確理解我的觀點和論點。有幾個最好的生成答案講出了一些我願意認同的東西,我不需要再補充什麼內容。」 當然,並不是說GPT-3學會了能像Dennett一樣「有想法」。

模型產生的文字本身對GPT-3根本沒有意義,只對閱讀這些文字的人有意義。當讀了那些聽起來很現實的語言,或是關於對我們來說很有深度和意義的話題時,可能很難不產生「模型具備感情和意識的想法」。這其實是我們本身意識和感情的一種投射。

一部分問題可能在於我們評估機器的自主意識的方式有問題。 最早的圖靈測試提出的假設是,如果人們無法確定和他們溝通的是機器還是人類,那麼這台機器就具有「思考能力」。

#Dennett在書中寫道:

#圖靈測試導致了一種趨勢,即人們專注於製造可以在短暫互動中欺騙人們的聊天機器人,然後過度炒作或強調這種互動的意義。

或許圖靈測試將我們引入了一個美好的陷阱,只要人類無法識別產品的機器人身份,就能證明機器人的自我意識。

在2021年發表的一篇題為模仿鸚鵡的論文中,Emily Bender和她的同事將機器模仿人類行為的嘗試稱為「人工智慧倫理發展的一道亮線」。

#Bender認為,製造看起來像人的機器和製造模仿特定人的機器都是對的,但其中潛在的風險在於可能會讓人誤以為他們是在與某個被偽裝的人對話。

Schwitzgebel強調,這個實驗不是圖靈測試。 但如果要進行測試,更好的方法可能是讓熟悉機器人運作原理的人與測試者進行討論,這樣就能更好地發現像GPT-3這樣的程序的弱點。

塔夫茨大學電腦科學教授Matthias Scheutz說,在許多情況下GPT-3很容易被證明是有缺陷的。

Scheutz和他的同事給GPT-3出了個難題,讓它解釋一些日常場景中的選擇,例如坐在汽車的前座還是後座。在計程車和朋友的車裡選擇相同嗎? 社會經驗告訴我們,通常坐在朋友汽車的前座,坐在計程車的後座。 而GPT-3不知道這一點,但它仍會為座位選擇產生解釋-例如與人的身高有關。

Scheutz說,這是因為GPT-3沒有世界模型,它只是一堆語言數據,並沒有對這個世界的認知能力。

隨著我們越來越難將機器產生的內容與人類區分開,擺在我們面前的一個挑戰是信任危機。

我看到的危機是以後人們將盲目地相信機器生成的產物,現在市場上甚至已經出現了與顧客交談的機器化人工客服。

文章最後,Dennett補充說,人工智慧系統的法律法規還需要完善,在未來的幾十年裡,AI可能會成為人們生活中的一部分,成為人類的朋友,因此對待機器的倫理問題值得我們深思。

關於AI是否擁有意識的問題引出了人們關於非生命物質是否能產生意識的思考,而人類的意識又是如何產生的呢?

意識的產生是在一個特徵的節點產生的,還是像開關一樣可以自由控制? Schwitzgebel說,思考這些問題可以幫助你從不用的角度思考機器與人類之間的關係。

以上是MIT用GPT-3冒充哲學家,竟騙過了一大半專家的詳細內容。更多資訊請關注PHP中文網其他相關文章!