由於可以做一些沒訓練過的事情,大型語言模型似乎具有某種魔力,也因此成為了媒體和研究員炒作和關注的焦點。

當擴展大型語言模型時,偶爾會出現一些較小模型沒有的新能力,這種類似「創造力」的屬性被稱為「突現」能力,代表我們向通用人工智慧邁進了一大步。

如今,來自Google、史丹佛、Deepmind和北卡羅來納大學的研究人員,正在探索大型語言模型中的「突現」能力。

#解碼器提示的DALL-E

神奇的「突現」能力

自然語言處理(NLP)已經被基於大量文字資料訓練的語言模型徹底改變。擴大語言模型的規模通常會提高一系列下游NLP任務的表現和樣本效率。

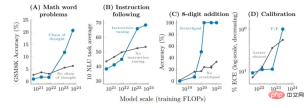

在許多情況下,我們可以透過推斷較小模型的效能趨勢來預測大型語言模型的表現。例如,規模對語言模型困惑的影響已被驗證跨越超過七個數量級。

然而,某些其他任務的表現卻並沒有以可預測的方式提高。

例如,GPT-3的論文表明,語言模型執行多位數加法的能力對於從100M到13B參數的模型具有平坦的縮放曲線,近似隨機,但會在一個節點造成效能的飛升。

鑑於語言模型在NLP研究中的應用越來越多,因此更能理解這些可能意外出現的能力非常重要。

在近期發表在機器學習研究(TMLR)上的論文「大型語言模型的突現能力」中,研究人員展示了數十個擴展語言模型所產生的「湧現”能力的例子。

這種「突現」能力的存在提出了一個問題,即額外的縮放是否能進一步擴大語言模型的能力範圍。

某些提示和微調方法只會在更大的模型中產生改進

「突現」提示任務

首先,我們討論在提示任務中可能出現的「突現」能力。

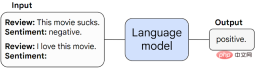

在這類任務中,預先訓練的語言模型會被提示執行下一個單字預測的任務,並透過完成反應來執行任務。

如果沒有任何進一步的微調,語言模型通常可以執行訓練期間沒有看到的任務。

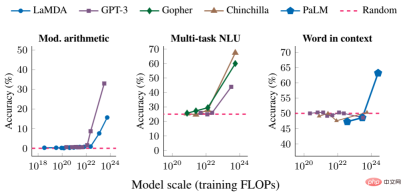

當任務在特定規模門檻下不可預測地從隨機表現飆升至高於隨機表現時,我們稱之為「突現」任務。

下面我們展示了三個具有「突現」表現的提示任務範例:多步驟算術、參加大學程度的考試和辨識單字的預期意義。

在每種情況下,語言模型的表現都很差,對模型大小的依賴性很小,直到達到某個閾值——它們的表現驟升。

對於足夠規模的模型,這些任務的表現只會變得非隨機-例如,算術和多工NLU任務的訓練每秒浮點運算次數( FLOP)超過10的22次方,情境任務中單字的訓練FLOP超過10的24次方。

「突現」提示策略

第二類「突現」能力包含增強語言模型能力的提示策略。

提示策略是用於提示的廣泛範式,可應用於一系列不同的任務。當它們對小型模型失敗並且只能由足夠大的模型使用時,它們被認為是可「突現」的。

思維鏈提示是「突現」提示策略的典型範例,提示模型在給出最終答案之前產生一系列中間步驟。

思考鏈提示使語言模型能夠執行需要複雜推理的任務,例如多步驟數學單字問題。

值得一提的是,模型無需經過明確訓練即可獲得思維鏈推理的能力,下圖則顯示了一個思維鏈提示的範例。

思維鏈提示的實證結果如下。

對於較小的模型,應用思維鏈提示並不會優於標準提示,例如當應用於GSM8K時,這是一個具有挑戰性的數學文字問題基準。

然而對於大型模型,思維鏈提示在GSM8K上達到了57%的解決率,在我們的測試中表現顯著提升。

研究「突現」能力的意義

那麼研究「突現」能力,又究竟有什麼意義呢?

識別大型語言模型中的「突現」能力,是理解此類現象及其對未來模型能力的潛在影響的第一步。

例如,由於「突現」小樣本提示能力和策略沒有在預訓練中明確編碼,研究人員可能不知道目前語言模型的小樣本提示能力的全部範圍。

此外,進一步擴展是否會潛在地賦予更大的模型「突現」能力,這個問題同樣十分重要。

- 為什麼會出現「突現」能力?

- 當某些能力出現時,語言模型的新現實世界應用會被解鎖嗎?

- 由於運算資源昂貴,能否在不增加擴展性的情況下透過其他方法解鎖突現」能力(例如更好的模型架構或訓練技術)?

研究人員表示,這些問題尚且不得而知。

不過隨著NLP領域的不斷發展,分析和理解語言模型的行為,包括由縮放產生的「突現」能力,是十分重要的。

以上是參數少量提升,性能指數爆發!谷歌:大語言模型暗藏「神秘技能」的詳細內容。更多資訊請關注PHP中文網其他相關文章!

谷歌三件套指的是哪三个软件Sep 30, 2022 pm 01:54 PM

谷歌三件套指的是哪三个软件Sep 30, 2022 pm 01:54 PM谷歌三件套指的是:1、google play商店,即下载各种应用程序的平台,类似于移动助手,安卓用户可以在商店下载免费或付费的游戏和软件;2、Google Play服务,用于更新Google本家的应用和Google Play提供的其他第三方应用;3、谷歌服务框架(GMS),是系统软件里面可以删除的一个APK程序,通过谷歌平台上架的应用和游戏都需要框架的支持。

为什么中国不卖google手机Mar 30, 2023 pm 05:31 PM

为什么中国不卖google手机Mar 30, 2023 pm 05:31 PM中国不卖google手机的原因:谷歌已经全面退出中国市场了,所以不能在中国销售,在国内是没有合法途径销售。在中国消费市场中,消费者大都倾向于物美价廉以及功能实用的产品,所以竞争实力本就因政治因素大打折扣的谷歌手机主体市场一直不在中国大陆。

谷歌超强AI超算碾压英伟达A100!TPU v4性能提升10倍,细节首次公开Apr 07, 2023 pm 02:54 PM

谷歌超强AI超算碾压英伟达A100!TPU v4性能提升10倍,细节首次公开Apr 07, 2023 pm 02:54 PM虽然谷歌早在2020年,就在自家的数据中心上部署了当时最强的AI芯片——TPU v4。但直到今年的4月4日,谷歌才首次公布了这台AI超算的技术细节。论文地址:https://arxiv.org/abs/2304.01433相比于TPU v3,TPU v4的性能要高出2.1倍,而在整合4096个芯片之后,超算的性能更是提升了10倍。另外,谷歌还声称,自家芯片要比英伟达A100更快、更节能。与A100对打,速度快1.7倍论文中,谷歌表示,对于规模相当的系统,TPU v4可以提供比英伟达A100强1.

谷歌并未放弃TensorFlow,将于2023年发布新版,明确四大支柱Apr 12, 2023 am 11:52 AM

谷歌并未放弃TensorFlow,将于2023年发布新版,明确四大支柱Apr 12, 2023 am 11:52 AM2015 年,谷歌大脑开放了一个名为「TensorFlow」的研究项目,这款产品迅速流行起来,成为人工智能业界的主流深度学习框架,塑造了现代机器学习的生态系统。从那时起,成千上万的开源贡献者以及众多的开发人员、社区组织者、研究人员和教育工作者等都投入到这一开源软件库上。然而七年后的今天,故事的走向已经完全不同:谷歌的 TensorFlow 失去了开发者的拥护。因为 TensorFlow 用户已经开始转向 Meta 推出的另一款框架 PyTorch。众多开发者都认为 TensorFlow 已经输掉

LLM之战,谷歌输了!越来越多顶尖研究员跳槽OpenAIApr 07, 2023 pm 05:48 PM

LLM之战,谷歌输了!越来越多顶尖研究员跳槽OpenAIApr 07, 2023 pm 05:48 PM前几天,谷歌差点遭遇一场公关危机,Bert一作、已跳槽OpenAI的前员工Jacob Devlin曝出,Bard竟是用ChatGPT的数据训练的。随后,谷歌火速否认。而这场争议,也牵出了一场大讨论:为什么越来越多Google顶尖研究员跳槽OpenAI?这场LLM战役它还能打赢吗?知友回复莱斯大学博士、知友「一堆废纸」表示,其实谷歌和OpenAI的差距,是数据的差距。「OpenAI对LLM有强大的执念,这是Google这类公司完全比不上的。当然人的差距只是一个方面,数据的差距以及对待数据的态度才

参数少量提升,性能指数爆发!谷歌:大语言模型暗藏「神秘技能」Apr 11, 2023 pm 11:16 PM

参数少量提升,性能指数爆发!谷歌:大语言模型暗藏「神秘技能」Apr 11, 2023 pm 11:16 PM由于可以做一些没训练过的事情,大型语言模型似乎具有某种魔力,也因此成为了媒体和研究员炒作和关注的焦点。当扩展大型语言模型时,偶尔会出现一些较小模型没有的新能力,这种类似于「创造力」的属性被称作「突现」能力,代表我们向通用人工智能迈进了一大步。如今,来自谷歌、斯坦福、Deepmind和北卡罗来纳大学的研究人员,正在探索大型语言模型中的「突现」能力。解码器提示的 DALL-E神奇的「突现」能力自然语言处理(NLP)已经被基于大量文本数据训练的语言模型彻底改变。扩大语言模型的规模通常会提高一系列下游N

四分钟对打300多次,谷歌教会机器人打乒乓球Apr 10, 2023 am 09:11 AM

四分钟对打300多次,谷歌教会机器人打乒乓球Apr 10, 2023 am 09:11 AM让一位乒乓球爱好者和机器人对打,按照机器人的发展趋势来看,谁输谁赢还真说不准。机器人拥有灵巧的可操作性、腿部运动灵活、抓握能力出色…… 已被广泛应用于各种挑战任务。但在与人类互动紧密的任务中,机器人的表现又如何呢?就拿乒乓球来说,这需要双方高度配合,并且球的运动非常快速,这对算法提出了重大挑战。在乒乓球比赛中,首要的就是速度和精度,这对学习算法提出了很高的要求。同时,这项运动具有高度结构化(具有固定的、可预测的环境)和多智能体协作(机器人可以与人类或其他机器人一起对打)两大特点,使其成为研究人

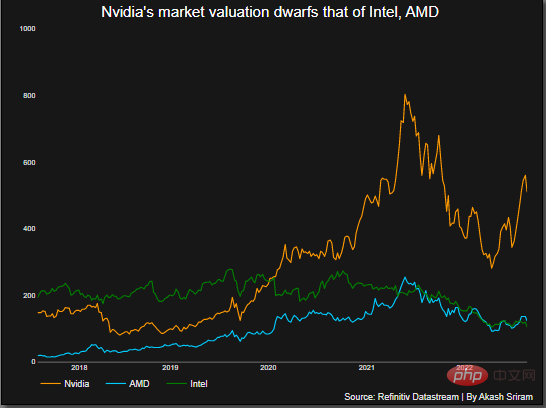

超5800亿美元!微软谷歌神仙打架,让英伟达市值飙升,约为5个英特尔Apr 11, 2023 pm 04:31 PM

超5800亿美元!微软谷歌神仙打架,让英伟达市值飙升,约为5个英特尔Apr 11, 2023 pm 04:31 PMChatGPT在手,有问必答。你可知,与它每次对话的计算成本简直让人泪目。此前,分析师称ChatGPT回复一次,需要2美分。要知道,人工智能聊天机器人所需的算力背后烧的可是GPU。这恰恰让像英伟达这样的芯片公司豪赚了一把。2月23日,英伟达股价飙升,使其市值增加了700多亿美元,总市值超5800亿美元,大约是英特尔的5倍。在英伟达之外,AMD可以称得上是图形处理器行业的第二大厂商,市场份额约为20%。而英特尔持有不到1%的市场份额。ChatGPT在跑,英伟达在赚随着ChatGPT解锁潜在的应用案

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

AI Hentai Generator

免費產生 AI 無盡。

熱門文章

熱工具

SublimeText3漢化版

中文版,非常好用

DVWA

Damn Vulnerable Web App (DVWA) 是一個PHP/MySQL的Web應用程序,非常容易受到攻擊。它的主要目標是成為安全專業人員在合法環境中測試自己的技能和工具的輔助工具,幫助Web開發人員更好地理解保護網路應用程式的過程,並幫助教師/學生在課堂環境中教授/學習Web應用程式安全性。 DVWA的目標是透過簡單直接的介面練習一些最常見的Web漏洞,難度各不相同。請注意,該軟體中

VSCode Windows 64位元 下載

微軟推出的免費、功能強大的一款IDE編輯器

SublimeText3 英文版

推薦:為Win版本,支援程式碼提示!

SAP NetWeaver Server Adapter for Eclipse

將Eclipse與SAP NetWeaver應用伺服器整合。