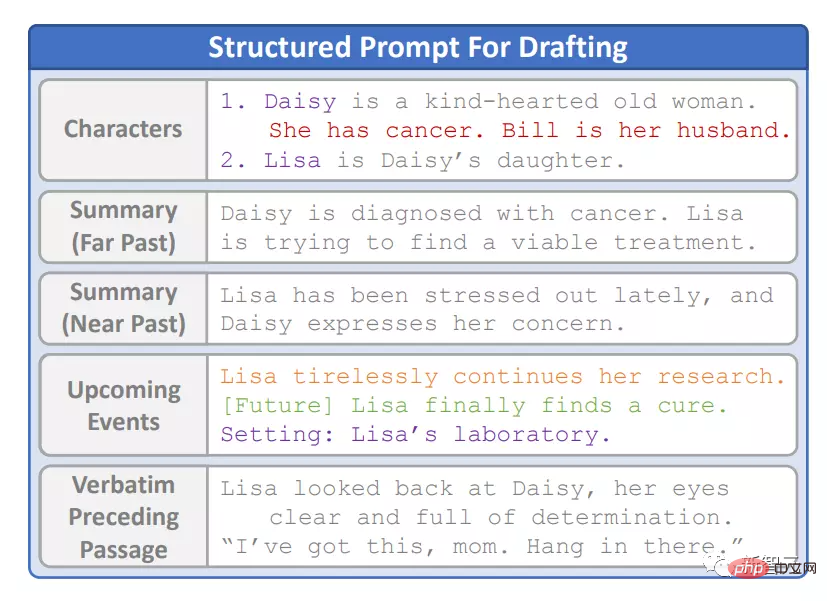

田淵棟團隊發表「長故事產生器」第二版DOC:連貫性大幅提升,趣味性提升20.7%!

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB轉載

- 2023-04-11 21:22:071581瀏覽

前段時間田淵棟博士團隊在EMNLP2022上發布了一個基於大規模語言模型的故事生成器Re3(Recursive Reprompting and Revision)框架,透過設計prompt讓模型生成一致性強的故事,完全不需要微調大模型,最長可以產生7500字的故事。

最近Re3的作者團隊又發布了第二版長故事生成框架DOC(Detailed Outline Control),使用層次化的大綱(outline)對故事進行更細節的描繪,並使用微調後的OPT-350m模型對生成的內容進行更連貫的續寫,相較之下,人類評估後認為DOC比上一代Re3的寫作能力更強。

論文連結:https://arxiv.org/abs/2212.10077

論文連結:https://github.com/yangkevin2/doc-story-generation

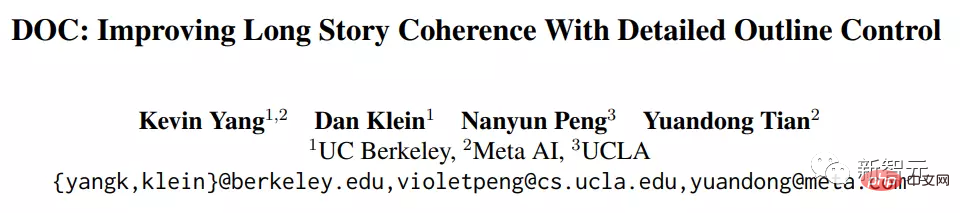

DOC由兩個互補的組件組成:

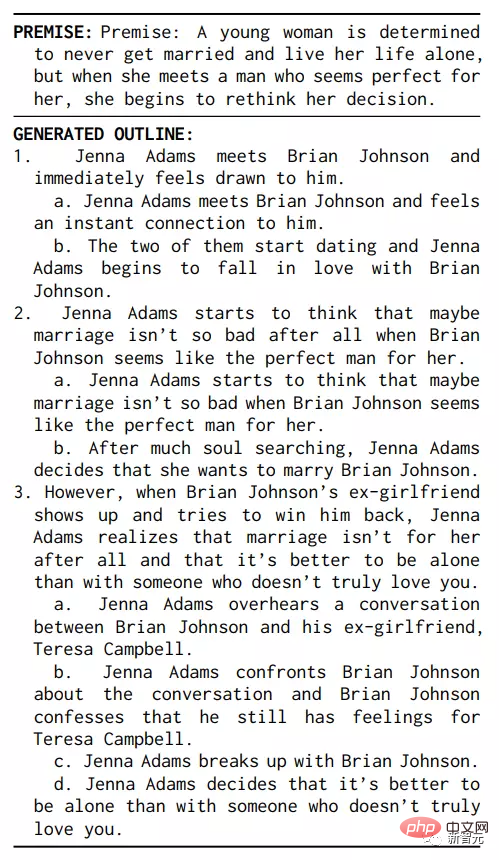

1. 詳細大綱產生器(detailed outliner)可以創建一個更詳細的、分層結構的大綱,將創造性的工作從主起草(drafting)過程轉移到規(planning)劃階段;

2. 詳細的控制器(detailed controller)透過控制故事段落與大綱細節保持一致,確保更詳細的大綱在生成過程中仍能發揮作用。

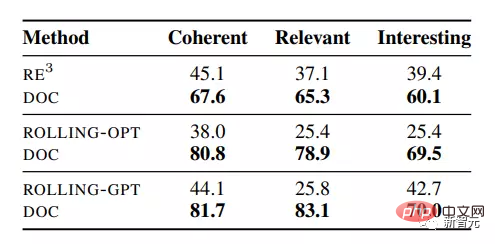

在自動生成故事的人類評估中,DOC 在情節一致性上取得22.5%的絕對增益,大綱相關性提升28.2%,趣味性提升20.7%,大大優於先前的Re3基線模型,人類評估者也認為DOC在互動式生成環境中更容易控制。

文章的第一作者Kevin Yang是加州大學柏克萊分校的四年級博士生,主要研究興趣為結構化設定下的可控自然語言文本生成,如利用可控產生的結構化方法來改善長篇文本的一致性。

第二作者田淵棟博士是Meta人工智慧研究院研究員、高級經理,其研究方向為深度增強學習及其在遊戲中的應用,以及深度學習模型的理論分析。先後於2005年及2008年取得上海交通大學本碩學位,2013年獲得美國卡內基美隆大學機器人研究所博士學位。

DOC框架

隨著自然語言技術的不斷發展,大規模語言模型對於短文本的理解逐漸接近瓶頸,人們對產生更長的文本逐漸產生興趣,例如一次產生數千個單字。

與短文本生成任務相比,長文本包含的內容和限制也更多,模型需要保持總體一致性,長期事實一致性,還要保持與用戶輸出的前提或計劃保持相關性。

與人類相比,像Re3這樣的故事生成系統在許多方面仍然存在不足,例如無法保證長距離下的劇情連貫性,全局不一致,故事內容偏離設定的計劃等。

為了彌補這一差距,詳細大綱控制(DOC)框架在重複使用Re3的高層規劃起草修訂(panning-drafting-revision)結構的同時,透過兩種互補的方法提高了長期一致性。

詳細大綱

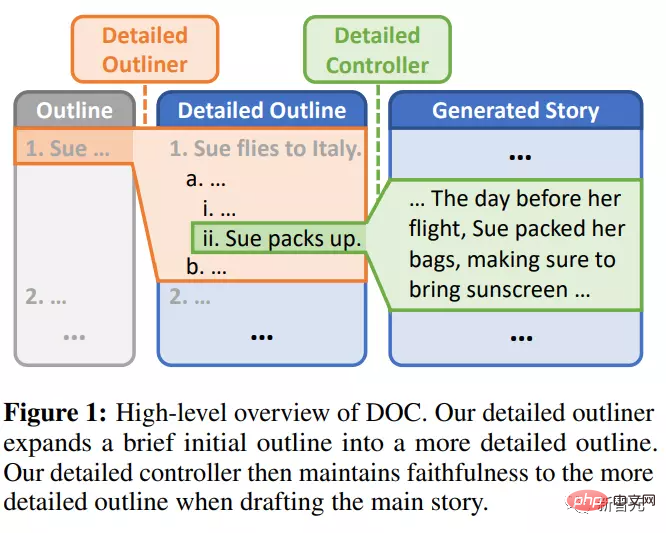

#首先,detailed outliner將一個簡短的初始大綱細化為一個更詳細、層次化的大綱,這樣設計的原因是人類作者可能在起草一份長文檔之前迭代地細化和擴展一個簡短的初始大綱。

與即興創作新的情節點相比,作者可能會在高層次大綱階段規劃一個連貫的總體情節,使用擴展的大綱在起草過程中提供更詳細的指導。

在起草階段,研究人員重用了Re3重寫階段的大綱相關性和文字連貫性重新排序,以偵測目前大綱專案何時完成了一段文章,並基於分數閾值實現提前停止。

大綱中有完整的設定和相關的角色,每個大綱項目都經過仔細篩選,以確保上下文中的相關性和連貫性。

在結構化prompt中,模型會反白顯示目前設定、設定中的更改,也會根據大綱中偵測到的角色檢索角色描述。

相比之下,Re3在起草過程中為每一段動態選擇相關角色,並且不追蹤設定訊息,這可能會導致故事設定發生意外變更

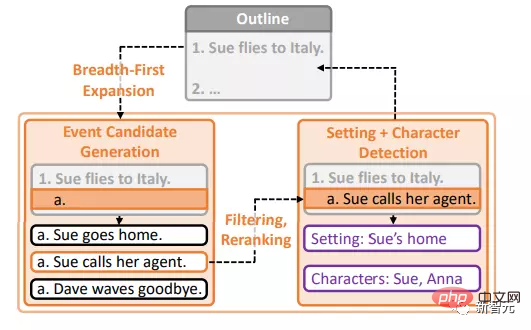

詳細控制器

第二個元件詳細控制器(detailed controller)透過基於對應的大綱項目控制段落生成來保持對詳細大綱的忠實性。

因為詳細大綱強加了許多重疊的軟約束,所以詳細控制器必須施加足夠的控制強度,同時詳細控制器還必須適應靈活的自然語言輸入,並在使用最先進的大型語言模型生成時具有計算效率。

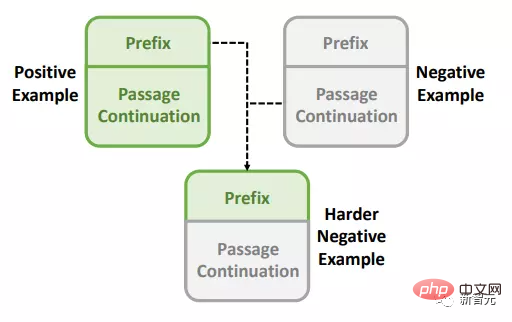

所以研究人員將詳細控制器實作為基於OPT350m的控制器,設計了一個對比訓練程序,將摘要與段落前綴對齊。

最關鍵的是,研究者也建構了許多流暢的硬負例(fluent hard negatives),以促進產生的段落不僅在開始時與主題相關,而且貫穿始終。

實驗部分

在實驗中,模型的輸入只是一個簡短的英語前提(premise),通常30-60個單詞,輸出是一個完整的故事。

研究人員沒有施加更多規則上的約束,因為「故事」的定義還不明確,更不用說定義「好故事」了,品質好壞主要依賴人工評估指標。

在評估上主要使用三個指標,更適用於比較段落而非完整的故事:

1. #連貫性,人類標註員判斷情節連貫的段落百分比;

2. 相關性,被判斷為符合對應大綱條目的段落百分比;

3. 趣味性,被認為有趣的段落百分比。

對比的基準模型包括Re3, ROLLING-OPT和ROLLING-GPT。

在實驗結果可以看到,與Re3相比,標註人員認為DOC產生的情節更為連貫,與大綱更相關,相比ROLLING基線提升更高。

並且結果證實了模型設計的正確性,即劇情連貫性和大綱相關性得益於將創意工作從規劃轉向起草,以及改進的控制機制。

而且令人意外的是,標註人員也認為DOC的段落明顯更有趣,研究人員認為這是更詳細(更具事件性)大綱帶來的進步,進一步的消融實驗也支持了這一假設。

不過定性分析也揭示了模型仍有進一步改進的巨大空間。

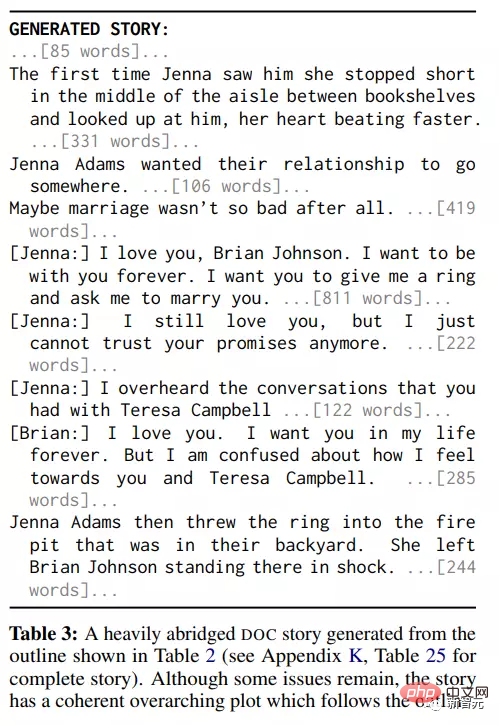

與RE3不同的是,DOC通常不會嚴重偏離頂層大綱,而RE3有時幾乎完全偏離主題,但DOC通常無法遵循詳細大綱的較低層次部分。

DOC和RE3中的內部一致性仍然存在問題,詳細大綱中偶爾出現的錯誤可能會造成特別大的負面影響,從而在起草過程中導致更大的級聯錯誤。

此外,DOC中的大綱往往在細節層次上不一致,有些過於模糊,而另一些似乎過於展開(over-expanded)。

此外,模型偵測到的設定和角色有時也會不正確或不完整,下面的例子顯示了DOC根據上述大綱所寫的一篇刪節嚴重的故事。

以上是田淵棟團隊發表「長故事產生器」第二版DOC:連貫性大幅提升,趣味性提升20.7%!的詳細內容。更多資訊請關注PHP中文網其他相關文章!