谷歌AI歌手震撼來襲! AudioLM簡單聽幾秒,便能譜曲寫歌

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB轉載

- 2023-04-11 21:10:061061瀏覽

圖像生成模型捲起來了!影片生成模型捲起來了!

下一個,便是音訊生成模型。

近日,Google研究團隊推出了語音產生的AI模型-AudioLM。

只需幾秒鐘音訊提示,它不僅可以產生高品質,連貫的語音,還可以產生鋼琴音樂。

論文網址:https://www.php.cn/link/b6b3598b407b7f328e3129c74ca8ca94

#AudioLM是一個具有長期一致性的高品質音訊產生框架,將輸入的音訊對應為一串離散的標記,並將音訊產生任務轉換為語言建模任務。

現有的音訊標記器在音訊產生品質和穩定的長期結構之間必須做出權衡,無法兼顧。

為了解決這個矛盾,Google採用「混合標記化」方案,利用預訓練好的掩膜語言模型的離散化激活,並利用神經音頻編解碼器產生的離散代碼來實現高質量的合成。

AudioLM模型可以基於簡短的提示,學習生成自然和連貫的連續詞,當對語音進行訓練時,在沒有任何記錄或註釋的情況下,生成了語法上通順、語意上合理的連續語音,同時保持說話者的身分和語調。

除了語音之外,AudioLM還能產生連貫的鋼琴音樂,甚至不需要在任何音樂符號來進行訓練。

從文本到鋼琴曲:兩大問題

近年來,在海量的文本語料庫中訓練出來的語言模型已經顯示出其卓越的生成能力,實現了開放式對話、機器翻譯,甚至常識推理,還能對文字以外的其他訊號進行建模,例如自然圖像。

AudioLM的想法是,利用語言建模方面的這些進展來產生音頻,而無需在註釋資料上進行訓練。

不過這需要面對兩個問題。

首先,音訊的資料率要高得多,單元序列也更長。例如一個句子包含幾十個字元表示,但轉換成音訊波形後,一般要包含數十萬個值。

另外,文字與音訊之間存在著一對多的關係。同一個句子可以由不同的說話者以不同的風格、情感內容和環境來呈現。

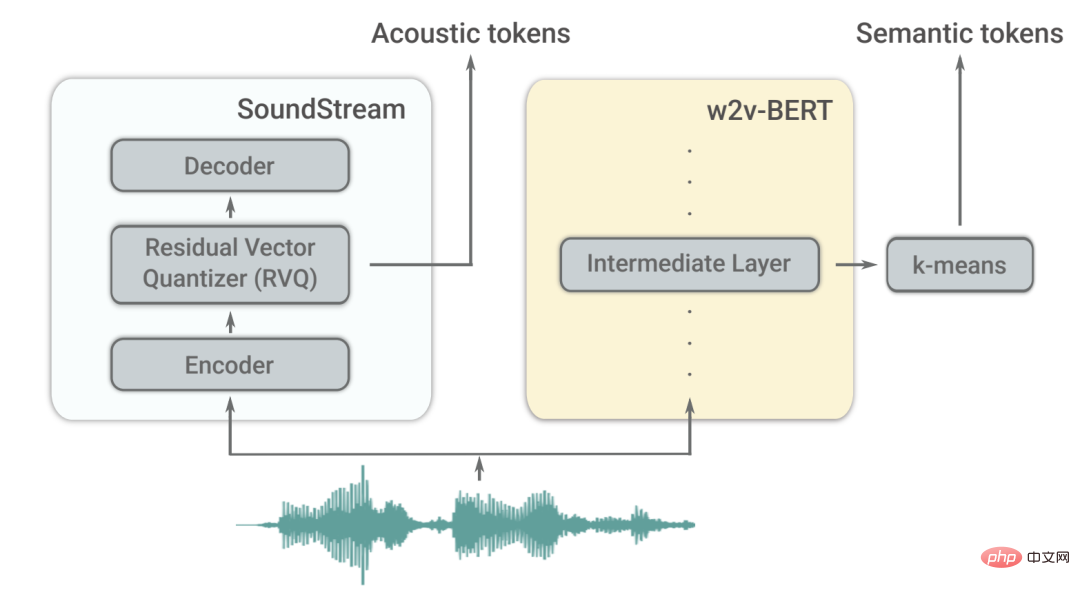

為了克服這兩個挑戰,AudioLM利用了兩種音訊標記。

首先,語意標記是從w2v-BERT這個自監督的音訊模型中提取的。

這些標記既能捕捉局部的依賴關係(如語音中的語音,鋼琴音樂中的局部旋律),又能捕捉到全局的長期結構(如語音中的語言句法和語義內容,鋼琴音樂中的和聲和節奏),同時對音頻訊號進行大量的降採樣,以便對長序列進行建模。

不過,從這些token中重建的音訊的保真度不高。

為了提高音質,除了語意標記外,AudioLM還利用了SoundStream神經編解碼器產生的聲學標記,捕捉音訊波形的細節(如揚聲器特徵或錄音條件),進行高品質的合成。

如何訓練?

AudioLM是一個純音訊模型,在沒有任何文字或音樂的符號表示下進行訓練。

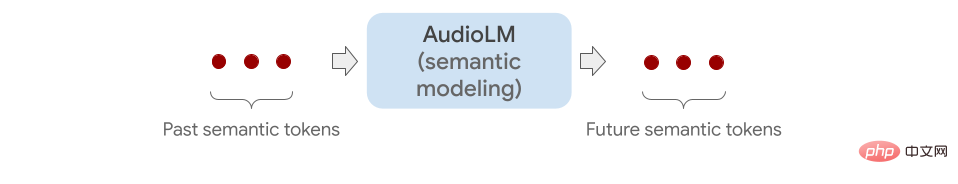

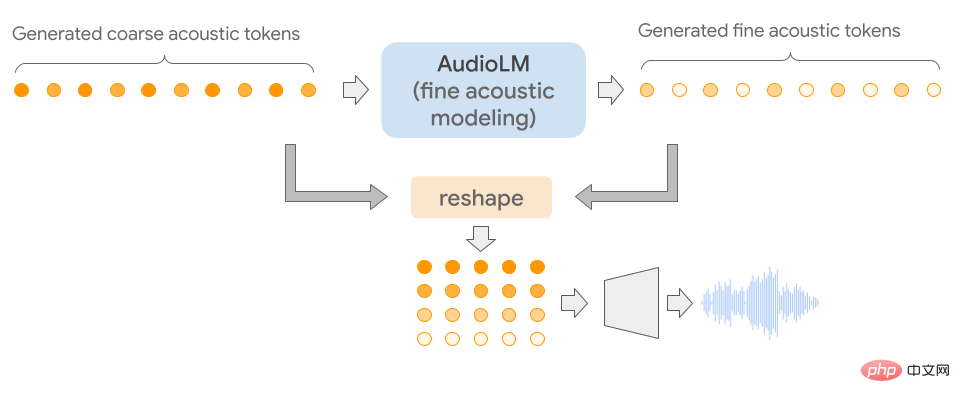

它透過連結多個Transformer模型(每個階段一個)從語義標記到精細的聲學標記對音訊序列進行分層建模。

每個階段都會根據上次的標記為下一個標記預測進行訓練,就像訓練一個語言模型一樣。

第一階段在語義標記上執行此任務,以對音訊序列的高階結構進行建模。

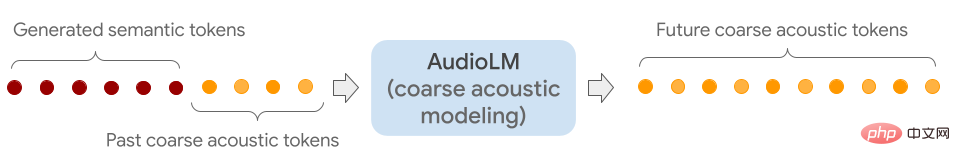

到了第二階段,透過將整個語義標記序列與過去的粗聲標記連接起來,並將兩者作為條件反饋給粗聲模型,然後預測未來的標記。

這個步驟模擬了聲學特性,例如說話者特性或音樂中的音色。

在第三階段,使用精細的聲學模型來處理粗糙的聲學訊號,從而為最終的音訊增加了更多的細節。

最後,將聲學標記輸入SoundStream解碼器以重建波形。

訓練完成後,可以在幾秒鐘音訊上調整AudioLM,這能夠讓其產生連續性的音訊。

為了展示AudioLM的普遍適用性,研究人員透過在不同音訊領域的2個任務來檢驗。

一是Speech continuation,模型保留提示的說話人特徵、韻律,同時還能輸出語法正確且語意一致的新內容。

二是Piano continuation,該模型會產生在旋律、和聲和節奏方面與提示一致的鋼琴音樂。

如下所示,你聽到的所有灰色垂直線之後的聲音都是由AudioLM產生的。

為了驗證效果如何,研究人員讓人類評分者去聽簡短的音訊片段,去判斷是人類語音的原始錄音還是由 AudioLM產生的錄音。

根據收集到的評分,可以看到AudioLM有51.2%的成功率,這意味著這個AI模型產生的語音對於一般聽眾來說很難與真正的語音區分開來。

在東北大學研究資訊與語言科學的Rupal Patel表示,先前使用人工智慧產生音訊的工作,只有在訓練資料中明確註釋這些細微差別,才能捕捉到這些差別。

相較之下,AudioLM從輸入資料中自動學習這些特徵,同樣達到了高保真度效果。

隨著GPT3 和Bloom(文字生成)、 DALLE和Stable Diffusion(圖像生成)、RunwayML和Make-A-Video(視頻生成)等多模態ML 模型的出現,關於內容創建和創意工作正在改變。

未來的世界,便是人工智慧生成的世界。

參考資料:

#https://www.php.cn/link/c11cb55c3d8dcc03a7ab7ab722703e0a

#https ://www.php.cn/link/b6b3598b407b7f328e3129c74ca8ca94

#https://www.php.cn/link/c5f7756d9f92a8951https://www.php.cn/link/c5f7756d9f92a8954884ec415f ##https://www.php.cn/link/9b644ca9f37e3699ddf2055800130aa9

以上是谷歌AI歌手震撼來襲! AudioLM簡單聽幾秒,便能譜曲寫歌的詳細內容。更多資訊請關注PHP中文網其他相關文章!