隨著語言模型和語料庫規模的逐漸擴大,大型語言模型(LLM)展現出更多的潛力。近來一些研究表明,LLM 可以使用 in-context learning(ICL)執行一系列複雜任務,例如解決數學推理問題。

來自北京大學、上海AI Lab 和加州大學聖塔芭芭拉分校的十位研究者近期發布了一篇關於in-context learning 的綜述論文,詳細梳理了ICL 研究的當前進展。

論文網址:https://arxiv.org/pdf/2301.00234v1.pdf

#in-context learning 的核心思路是類比學習,下圖描述了語言模型如何使用ICL 進行決策。

首先,ICL 需要一些範例來形成示範語境,這些範例通常用自然語言範本編寫。然後,ICL 將查詢問題和演示語境相聯繫,形成 prompt,並將其輸入語言模型進行預測。與監督學習需要使用反向梯度更新模型參數的訓練階段不同,ICL 不需要參數更新即可使預訓練語言模型直接執行預測任務,並且模型有望學習演示樣例中隱藏的模式,並據此做出正確的預測。

作為新的範式,ICL 有許多吸引人的優勢。首先,示範範例用自然語言格式編寫,這為與大語言模型關聯提供了一個可解釋的介面。透過改變示範範例和模板(Liu et al., 2022; Lu et al., 2022; Wu et al., 2022; Wei et al., 2022c),這種範式使將人類知識納入語言模型變得更加容易。第二,in-context learning 類似於人類透過類比學習的決策過程。第三,與監督式訓練相比,ICL 是一個無需訓練的學習架構。這不僅可以大大降低模型適應新任務的計算成本,還可以使語言模型即服務(LMaaS,Sun et al., 2022)成為可能,並輕鬆應用於大規模的現實任務。

儘管 ICL 有著大好的前景,但仍有許多值得探究的問題,包括它的效能。例如原始的 GPT-3 模型就具備一定的 ICL 能力,但一些研究發現,透過預訓練期間的適應,這種能力還可以獲得顯著的提升。此外,ICL 的表現對特定的設定很敏銳,包括 prompt 模板、語境樣例的選擇和樣例順序等。此外,ICL 的工作機制雖然看似合理,但仍不夠清晰明了,能夠初步解釋其工作機制的研究也不多。

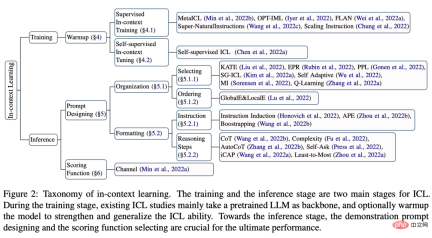

本篇綜述論文總結道,ICL 的強大表現依賴於兩個階段:

- 培養大型語言模型ICL 能力的訓練階段;

- 大型語言模型根據特定任務演示進行預測的推理階段。

在訓練階段,語言模型直接按照語言建模目標進行訓練,例如從左到右的生成。儘管這些模型並沒有專門針對 in-context learning 進行最佳化,但 ICL 的能力依舊令人驚訝。現有的 ICL 研究基本上以訓練良好的語言模型為主幹。

在推理階段,由於輸入和輸出的 label 都是用可解釋的自然語言模板表徵的,因此 ICL 性能可以從多個角度優化。這篇綜述論文進行了詳細的描述和比較,並選擇合適的例子進行演示,針對不同的任務設計具體的評分方法。

這篇綜述論文的大致內容與架構如下圖所示,包括:ICL 的正式定義(§3)、warmup 方法(§4)、prompt 設計策略(§5 ) 和評分函數(§6)。

此外,§7 深入闡述了目前為揭開 ICL 背後運作所做的探索。 §8 進一步為 ICL 提供了有用的評估與資源,§9 介紹了能顯示 ICL 有效性的潛在應用情境。最後,§10 總結了 ICL 領域存在的挑戰和潛在的方向,為該領域的進一步發展提供參考。

有興趣的讀者可以閱讀論文原文,了解更多研究細節。

以上是被GPT帶飛的In-Context Learning發展現況如何?這篇綜述梳理明白了的詳細內容。更多資訊請關注PHP中文網其他相關文章!

![無法使用chatgpt!解釋可以立即測試的原因和解決方案[最新2025]](https://img.php.cn/upload/article/001/242/473/174717025174979.jpg?x-oss-process=image/resize,p_40) 無法使用chatgpt!解釋可以立即測試的原因和解決方案[最新2025]May 14, 2025 am 05:04 AM

無法使用chatgpt!解釋可以立即測試的原因和解決方案[最新2025]May 14, 2025 am 05:04 AMChatGPT無法訪問?本文提供多種實用解決方案!許多用戶在日常使用ChatGPT時,可能會遇到無法訪問或響應緩慢等問題。本文將根據不同情況,逐步指導您解決這些問題。 ChatGPT無法訪問的原因及初步排查 首先,我們需要確定問題是出在OpenAI服務器端,還是用戶自身網絡或設備問題。 請按照以下步驟進行排查: 步驟1:檢查OpenAI官方狀態 訪問OpenAI Status頁面 (status.openai.com),查看ChatGPT服務是否正常運行。如果顯示紅色或黃色警報,則表示Open

計算ASI的風險始於人類的思想May 14, 2025 am 05:02 AM

計算ASI的風險始於人類的思想May 14, 2025 am 05:02 AM2025年5月10日,麻省理工學院物理學家Max Tegmark告訴《衛報》,AI實驗室應在釋放人工超級智能之前模仿Oppenheimer的三位一體測試演算。 “我的評估是'康普頓常數',這是一場比賽的可能性

易於理解的解釋如何編寫和撰寫歌詞和推薦工具May 14, 2025 am 05:01 AM

易於理解的解釋如何編寫和撰寫歌詞和推薦工具May 14, 2025 am 05:01 AMAI音樂創作技術日新月異,本文將以ChatGPT等AI模型為例,詳細講解如何利用AI輔助音樂創作,並輔以實際案例進行說明。我們將分別介紹如何通過SunoAI、Hugging Face上的AI jukebox以及Python的Music21庫進行音樂創作。 通過這些技術,每個人都能輕鬆創作原創音樂。但需注意,AI生成內容的版權問題不容忽視,使用時務必謹慎。 讓我們一起探索AI在音樂領域的無限可能! OpenAI最新AI代理“OpenAI Deep Research”介紹: [ChatGPT]Ope

什麼是chatgpt-4?對您可以做什麼,定價以及與GPT-3.5的差異的詳盡解釋!May 14, 2025 am 05:00 AM

什麼是chatgpt-4?對您可以做什麼,定價以及與GPT-3.5的差異的詳盡解釋!May 14, 2025 am 05:00 AMChatGPT-4的出现,极大地拓展了AI应用的可能性。相较于GPT-3.5,ChatGPT-4有了显著提升,它具备强大的语境理解能力,还能识别和生成图像,堪称万能的AI助手。在提高商业效率、辅助创作等诸多领域,它都展现出巨大的潜力。然而,与此同时,我们也必须注意其使用上的注意事项。 本文将详细解读ChatGPT-4的特性,并介绍针对不同场景的有效使用方法。文中包含充分利用最新AI技术的技巧,敬请参考。 OpenAI发布的最新AI代理,“OpenAI Deep Research”详情请点击下方链

解釋如何使用chatgpt應用程序!日本支持和語音對話功能May 14, 2025 am 04:59 AM

解釋如何使用chatgpt應用程序!日本支持和語音對話功能May 14, 2025 am 04:59 AMCHATGPT應用程序:與AI助手釋放您的創造力!初學者指南 ChatGpt應用程序是一位創新的AI助手,可處理各種任務,包括寫作,翻譯和答案。它是一種具有無限可能性的工具,可用於創意活動和信息收集。 在本文中,我們將以一種易於理解的方式解釋初學者,從如何安裝chatgpt智能手機應用程序到語音輸入功能和插件等應用程序所獨有的功能,以及在使用該應用時要牢記的要點。我們還將仔細研究插件限制和設備對設備配置同步

如何使用中文版Chatgpt?註冊程序和費用的說明May 14, 2025 am 04:56 AM

如何使用中文版Chatgpt?註冊程序和費用的說明May 14, 2025 am 04:56 AMChatGPT中文版:解鎖中文AI對話新體驗 ChatGPT風靡全球,您知道它也提供中文版本嗎?這款強大的AI工具不僅支持日常對話,還能處理專業內容,並兼容簡體中文和繁體中文。無論是中國地區的使用者,還是正在學習中文的朋友,都能從中受益。 本文將詳細介紹ChatGPT中文版的使用方法,包括賬戶設置、中文提示詞輸入、過濾器的使用、以及不同套餐的選擇,並分析潛在風險及應對策略。此外,我們還將對比ChatGPT中文版和其他中文AI工具,幫助您更好地了解其優勢和應用場景。 OpenAI最新發布的AI智能

5 AI代理神話,您需要停止相信May 14, 2025 am 04:54 AM

5 AI代理神話,您需要停止相信May 14, 2025 am 04:54 AM這些可以將其視為生成AI領域的下一個飛躍,這為我們提供了Chatgpt和其他大型語言模型聊天機器人。他們可以代表我們採取行動,而不是簡單地回答問題或產生信息

易於理解使用Chatgpt創建和管理多個帳戶的非法性的解釋May 14, 2025 am 04:50 AM

易於理解使用Chatgpt創建和管理多個帳戶的非法性的解釋May 14, 2025 am 04:50 AM使用chatgpt有效的多個帳戶管理技術|關於如何使用商業和私人生活的詳盡解釋! Chatgpt在各種情況下都使用,但是有些人可能擔心管理多個帳戶。本文將詳細解釋如何為ChatGpt創建多個帳戶,使用時該怎麼做以及如何安全有效地操作它。我們還介紹了重要的一點,例如業務和私人使用差異,並遵守OpenAI的使用條款,並提供指南,以幫助您安全地利用多個帳戶。 Openai

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SecLists

SecLists是最終安全測試人員的伙伴。它是一個包含各種類型清單的集合,這些清單在安全評估過程中經常使用,而且都在一個地方。 SecLists透過方便地提供安全測試人員可能需要的所有列表,幫助提高安全測試的效率和生產力。清單類型包括使用者名稱、密碼、URL、模糊測試有效載荷、敏感資料模式、Web shell等等。測試人員只需將此儲存庫拉到新的測試機上,他就可以存取所需的每種類型的清單。

MantisBT

Mantis是一個易於部署的基於Web的缺陷追蹤工具,用於幫助產品缺陷追蹤。它需要PHP、MySQL和一個Web伺服器。請查看我們的演示和託管服務。

ZendStudio 13.5.1 Mac

強大的PHP整合開發環境

SublimeText3漢化版

中文版,非常好用