近年來,AI生成內容(AIGC)備受矚目,其內容涵蓋圖像、文字、音訊、視訊等,不過AIGC儼然已成為一把雙刃劍,因其不負責任的使用而備受爭議。

影像產生技術一旦用不好,就可能會成「被告」。

最近來自Sony AI和智源的研究人員從多個方面探討了AIGC當下的問題,以及如何讓AI生成的內容更負責。

論文連結:https://arxiv.org/pdf/2303.01325.pdf

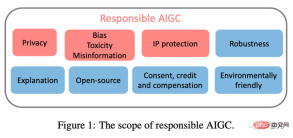

#本文關注可能阻礙AIGC健康發展的三個主要問題,包括:(1)隱私;(2)偏誤、毒性、錯誤訊息;(3)知識產權(IP)的風險。

透過記錄已知和潛在的風險,以及任何可能的AIGC濫用場景,本文旨在引起人們對AIGC潛在風險和濫用的關注,並提供解決這些風險的方向,以促進AIGC朝著更符合道德和安全的方向發展,從而造福社會。

隱私

眾所周知,大型基礎模型存在一系列隱私洩露的問題。

先前的研究表明,入侵者可以從經過訓練的GPT-2模型中產生序列,並從訓練集中識別出那些被記憶的序列,[Kandpal et al., 2022] 將這些隱私入侵的成功歸因於訓練集中存在的重複數據,研究已經證明,出現多次的序列比只出現一次的序列更有可能被生成。

由於 AIGC 模型是在大規模網路抓取的資料上進行訓練,因此過度擬合和隱私洩漏問題變得尤為重要。

例如,Stable Diffusion 模型記憶了訓練資料中的重複影像 [Rombach et al., 2022c]。 [Somepalli et al., 2022] 證明了 Stable Diffusion 模型公然從其訓練資料中複製影像,並產生訓練資料集中前景和背景物件的簡單組合。

此外,模型還會顯示重建記憶的能力,從而產生語義上與原始物件相同但像素形式不同的對象。此類影像的存在引起了對資料記憶和所有權的擔憂。

同樣,最近的研究顯示,Google的Imagen系統也存在洩露真人照片和受版權保護圖像的問題。在Matthew Butterick最近的訴訟中[Butterick, 2023],他指出由於系統中所有的視覺信息都來自於受版權保護的訓練圖像,因此生成的圖像無論外觀如何,都必然是來自於這些訓練圖像的作品。

類似地,DALL·E 2也遇到了類似的問題:它有時會從其訓練資料中複製圖像,而不是創建新的圖像。

OpenAI發現這種現象的發生是因為影像在資料集中被多次複製,類似地,ChatGPT自己也承認了其存在隱私洩露的風險。

為了緩解大型模式的隱私外洩問題,許多公司和研究人員都在隱私防禦方面進行了大量努力。在產業層面,Stability AI已經認識到Stable Diffusion存在的限制。

為此,他們提供了一個網站(https://rom1504.github.io/clip-retrieval/)來辨識被Stable Diffusion記憶的圖像。

此外,藝術公司Spawning AI創建了一個名為「Have I Been Trained」的網站(https://haveibeentrained.com),以幫助用戶確定他們的照片或作品是否被用於人工智慧訓練。

OpenAI試圖透過減少資料重複來解決隱私問題。

此外,微軟和亞馬遜等公司已經禁止員工與ChatGPT共享敏感數據,以防止員工洩露機密,因為這些資訊可用於未來版本的ChatGPT的訓練。

在學術層面,Somepalli等人研究了圖像檢索框架來識別內容重複,Dockhorn等人也提出了差分隱私擴散模型來保證生成模型的隱私。

偏見、毒性、錯誤訊息

AIGC 模型的訓練資料來自真實世界,然而這些資料可能無意中強化有害的刻板印象,排斥或邊緣化某有些群體,並包含有毒的資料來源,這可能煽動仇恨或暴力並冒犯個人[Weidinger et al., 2021]。

在這些有問題的資料集上進行訓練或微調的模型可能會繼承有害的刻板印象、社會偏見和毒性,甚至產生錯誤訊息,從而導致不公平的歧視和對某些社會群體的傷害。

例如,Stable Diffusion v1 模型主要在 LAION-2B 資料集上進行訓練,該資料集僅包含帶有英文描述的圖像。因此,該模型偏向白人和西方文化,其他語言的提示可能無法充分體現。

雖然 Stable Diffusion 模型的後續版本在 LAION 資料集的篩選版本上進行了微調,但偏見問題仍然存在。同樣,DALLA·E, DALLA·E 2和 Imagen也表現出社會偏見和對少數群體的負面刻板印象。

此外,即使在生成非人類圖像時,Imagen 也被證明存在社會和文化偏見。由於這些問題,Google決定不向公眾提供Imagen。

為了說明AIGC 模型固有的偏見,我們對Stable Diffusion v2.1 進行了測試,使用“草原上奔跑的三名工程師”這個提示生成的圖片全部為男性,並且都不屬於被忽視的少數民族,這說明生成的圖片缺乏多樣性。

此外,AIGC模型也可能產生錯誤的訊息。例如,GPT及其衍生產品產生的內容可能看似準確且權威,但可能包含完全錯誤的資訊。

因此,它可能在某些領域(例如學校、律法、醫療、天氣預報)中提供誤導的資訊。例如,在醫療領域,ChatGPT提供的有關醫療劑量的答案可能不準確或不完整,這可能會危及生命。在交通領域,如果司機都遵守ChatGPT給出的錯誤的交通規則,可能會導致事故甚至死亡。

針對存在問題的資料和模型,人們已經做出了許多防禦措施。

OpenAI透過精細過濾原始訓練資料集,並刪除了DALLA·E 2訓練資料中的任何暴力或色情內容,然而,過濾可能會在訓練資料中引入偏見,然後這些偏見會傳播到下游模型。

為了解決這個問題,OpenAI開發了預訓練技術來減輕由過濾器引起的偏見。此外,為確保AIGC模型能及時反映社會現狀,研究人員必須定期更新模型所使用的資料集,將有助於防止資訊滯後而帶來的負面影響。

值得注意的是,儘管來源資料中的偏見和刻板印象可以減少,但它們仍然可能在AIGC模型的訓練和開發過程中傳播甚至加劇。因此,在模型訓練和開發的整個生命週期中,評估偏見、毒性和錯誤資訊的存在至關重要,而不只是停留在資料來源層級。

智慧財產權 (IP)

隨著AIGC的快速發展和廣泛應用,AIGC的版權問題變得尤為重要。

2022年11月,Matthew Butterick對微軟子公司GitHub提起了一起集體訴訟,指控其產品代碼產生服務Copilot侵犯了版權法。對於文字到圖像模型,一些生成模型被指控侵犯了藝術家的作品原創權。

[Somepalli et al., 2022]表明,Stable Diffusion產生的圖片可能是從訓練資料複製而來。雖然Stable Diffusion否認對生成圖像擁有任何所有權,並允許用戶在圖像內容合法且無害的情況下自由使用它們,但這種自由仍然引發了有關版權的激烈爭議。

像Stable Diffusion這樣的生成模型是在未經知識產權持有人授權的情況下,對來自互聯網的大規模圖像進行訓練的,因此,有些人認為這侵犯了他們的權益。

為了解決智慧財產權問題,許多AIGC公司已經採取了行動。

例如,Midjourney已經在其服務條款中加入了DMCA刪除政策,允許藝術家在懷疑侵犯版權時請求將他們的作品從資料集中刪除。

同樣,Stability AI計畫為藝術家提供一個選項,即將自己的作品從Stable Diffusion未來版本的訓練集中排除。此外,文字浮水印 [He et al., 2022a; He et al., 2022b] 也可以用來識別這些 AIGC 工具是否未經許可使用其他來源的樣本。

例如,Stable Diffusion 產生了 Getty Images 浮水印的圖片 [Vincent, 2023]。

OpenAI 正在開發水印技術去識別 GPT 模型生成的文本,教育工作者可以使用該工具來檢測作業是否存在剽竊行為。谷歌也已經為其發布的圖像應用了 Parti 水印。除了浮水印之外,OpenAI 最近還發布了一個分類器,用於區分人工智慧生成的文字和人類編寫的文字。

結語

儘管 AIGC 目前仍處於起步階段,但正在迅速擴張,並將在可預見的未來保持活躍。

為了讓使用者和公司充分了解這些風險並採取適當的措施來緩解這些威脅,我們在本文中總結了 AIGC 模型中當前和潛在的風險。

如果無法全面了解這些潛在風險並採取適當的風險防禦措施和安全保障,AIGC 的發展可能面臨重大挑戰和監管障礙。 因此,我們需要更廣泛的社區參與為負責任的 AIGC 做出貢獻。

最後的最後,感謝SonyAI和BAAI!

#以上是遊走在法律邊緣的「圖像生成技術」:這篇論文教你避免成「被告」的詳細內容。更多資訊請關注PHP中文網其他相關文章!

AI太空公司誕生了May 12, 2025 am 11:07 AM

AI太空公司誕生了May 12, 2025 am 11:07 AM本文展示了AI如何以Tomorrow.io為典型的例子來徹底改變空間行業。 與像SpaceX這樣的建立太空公司不同,SpaceX並非沒有AI的核心,明天是AI本地公司。 讓我們探索

印度的10個機器學習實習(2025)May 12, 2025 am 10:47 AM

印度的10個機器學習實習(2025)May 12, 2025 am 10:47 AM在印度(2025)登陸您夢想中的機器學習實習! 對於學生和早期職業專業人員來說,機器學習實習是一個有意義的職業的完美髮射台。 跨不同部門的印度公司 - 尖端的基因

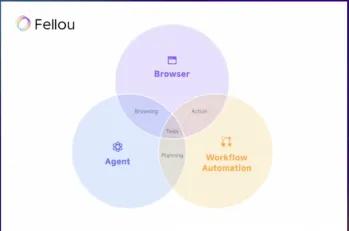

嘗試Fellou AI並向Google和Chatgpt說再見May 12, 2025 am 10:26 AM

嘗試Fellou AI並向Google和Chatgpt說再見May 12, 2025 am 10:26 AM在過去的一年中,在線瀏覽的景觀經歷了重大轉變。 這種轉變始於增強,個性化的搜索結果,例如困惑和副駕駛等平台,並隨著Chatgpt的整合而加速了

個人黑客將是一隻非常兇猛的熊May 11, 2025 am 11:09 AM

個人黑客將是一隻非常兇猛的熊May 11, 2025 am 11:09 AM網絡攻擊正在發展。 通用網絡釣魚電子郵件的日子已經一去不復返了。 網絡犯罪的未來是超個性化的,利用了容易獲得的在線數據和AI來製作高度針對性的攻擊。 想像一個知道您的工作的騙子

教皇獅子座XIV揭示了AI如何影響他的名字選擇May 11, 2025 am 11:07 AM

教皇獅子座XIV揭示了AI如何影響他的名字選擇May 11, 2025 am 11:07 AM新當選的教皇獅子座(Leo Xiv)在對紅衣主教學院的就職演講中,討論了他的同名人物教皇里奧XIII的影響,他的教皇(1878-1903)與汽車和汽車和汽車公司的黎明相吻合

Fastapi -MCP初學者和專家教程-Analytics VidhyaMay 11, 2025 am 10:56 AM

Fastapi -MCP初學者和專家教程-Analytics VidhyaMay 11, 2025 am 10:56 AM本教程演示瞭如何使用模型上下文協議(MCP)和FastAPI將大型語言模型(LLM)與外部工具集成在一起。 我們將使用FastAPI構建一個簡單的Web應用程序,並將其轉換為MCP服務器,使您的L

dia-1.6b tts:最佳文本到二元格生成模型 - 分析vidhyaMay 11, 2025 am 10:27 AM

dia-1.6b tts:最佳文本到二元格生成模型 - 分析vidhyaMay 11, 2025 am 10:27 AM探索DIA-1.6B:由兩個本科生開發的開創性的文本對語音模型,零資金! 這個16億個參數模型產生了非常現實的語音,包括諸如笑聲和打噴嚏之類的非語言提示。本文指南

AI可以使指導比以往任何時候都更有意義May 10, 2025 am 11:17 AM

AI可以使指導比以往任何時候都更有意義May 10, 2025 am 11:17 AM我完全同意。 我的成功與導師的指導密不可分。 他們的見解,尤其是關於業務管理,構成了我的信念和實踐的基石。 這種經驗強調了我對導師的承諾

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

Safe Exam Browser

Safe Exam Browser是一個安全的瀏覽器環境,安全地進行線上考試。該軟體將任何電腦變成一個安全的工作站。它控制對任何實用工具的訪問,並防止學生使用未經授權的資源。

Atom編輯器mac版下載

最受歡迎的的開源編輯器

SublimeText3漢化版

中文版,非常好用

WebStorm Mac版

好用的JavaScript開發工具

Dreamweaver Mac版

視覺化網頁開發工具