ChatGPT自己會選模型了!微軟亞研院+浙大爆火新論文,HuggingGPT計畫已開源

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB轉載

- 2023-04-11 08:41:021034瀏覽

ChatGPT引爆的AI熱潮也「燒到了」金融圈。

近來,彭博社的研究人員也發展了一個金融領域的GPT-Bloomberg GPT,有500億參數。

GPT-4的橫空出世,讓許多人淺嚐到了大型語言模型的強大能力。

然而,OpenAI不open。業界許多人紛紛開始做GPT的克隆,而且許多ChatGPT平替的模型都是基於已經開源的模型上構建,尤其是Meta開源的LLMa模型。

例如,史丹佛的Alpaca、UC柏克萊聯手CMU、史丹佛等駱馬(Vicuna),新創公司Databricks的Dolly等等。

針對不同任務和應用所建構的各種類別ChatGPT的大型語言模型,在整個領域呈現出百家爭鳴之勢。

那麼問題來了,研究者如何選擇合適的模型,甚至是多個模型,去完成一項複雜的任務呢?

近日,微軟亞洲研究院和浙江大學的研究團隊,發布了一個大模型協作系統HuggingGPT。

論文網址:https://arxiv.org/pdf/2303.17580.pdf

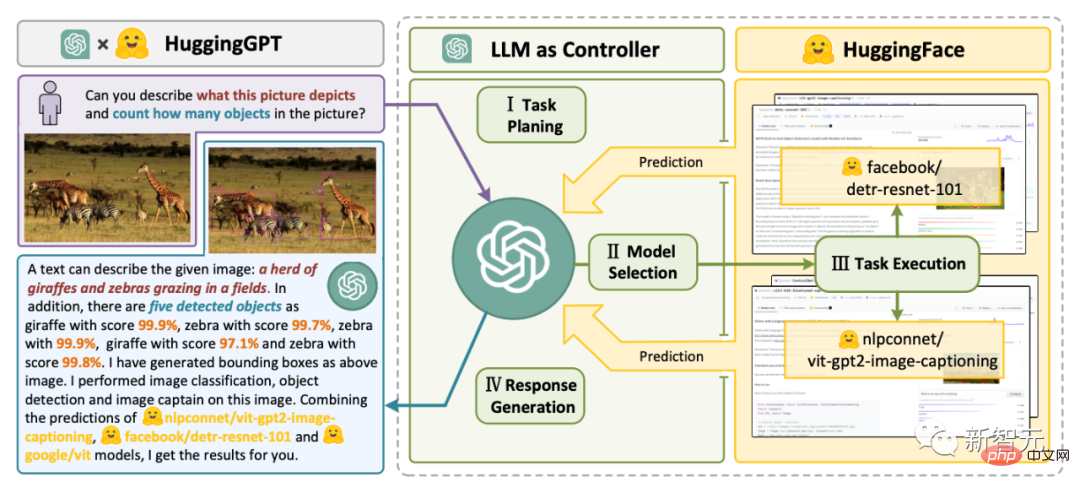

#HuggingGPT利用ChatGPT作為控制器,連接HuggingFace社群中的各種AI模型,來完成多模態複雜任務。

這意味著,你將擁有一種超魔法,透過HuggingGPT,便可擁有多模態能力,文生圖、文生影片、語音全能拿捏了。

HuggingGPT搭橋

#研究者指出解決大型語言模型(LLMs)目前的問題,可能是邁向AGI的第一步,也是關鍵的一步。

因為目前大型語言模型的技術仍然存在一些缺陷,因此在建構 AGI 系統的道路上面臨一些緊迫的挑戰。

- 受限於文字產生的輸入和輸出形式,目前LLMs缺乏處理複雜訊息(如視覺和語音)的能力;

- 在實際應用場景中,一些複雜任務通常由多個子任務組成,因此需要多個模型的調度和協作,這也超出了語言模型的能力範圍;

#- 對於一些具有挑戰性的任務,LLMs在零樣本或少樣本設定下表現出優異的結果,但它們仍然比一些專家弱(如微調模型)。

為了處理複雜的人工智慧任務,LLMs應該能夠與外部模型協調,以利用它們的能力。因此,關鍵點在於如何選擇合適的中間件來橋接LLMs和AI模型。

研究者發現,每個AI模型都可以透過總結其模型功能表示為一種語言形式。

#由此,便引入了一個概念,「語言是LLMs,即ChatGPT,連接人工智慧模型的通用介面」。

透過將AI模型描述納入提示中,ChatGPT可以被視為管理人工智慧模型的大腦。因此,此方法可以讓ChatGPT能夠呼叫外部模型,來解決實際任務。

簡單來講,HuggingGPT是一個協作系統,不是大模型。

它的作用就是連結ChatGPT和HuggingFace,進而處理不同模態的輸入,並解決眾多複雜的人工智慧任務。

所以,HuggingFace社群中的每個AI模型,在HuggingGPT庫中都有相應的模型描述,並將其融合到提示中以建立與ChatGPT的連接。

隨後,HuggingGPT將ChatGPT作為大腦來確定問題的答案。

到目前為止,HuggingGPT已經圍繞ChatGPT在HuggingFace上整合了數百個模型,涵蓋了文字分類、目標偵測、語義分割、圖像生成、問答、文字轉語音、文字轉影片等24個任務。

實驗結果證明,HuggingGPT擁有處理多模態資訊和複雜人工智慧任務的能力。

四步驟工作流程

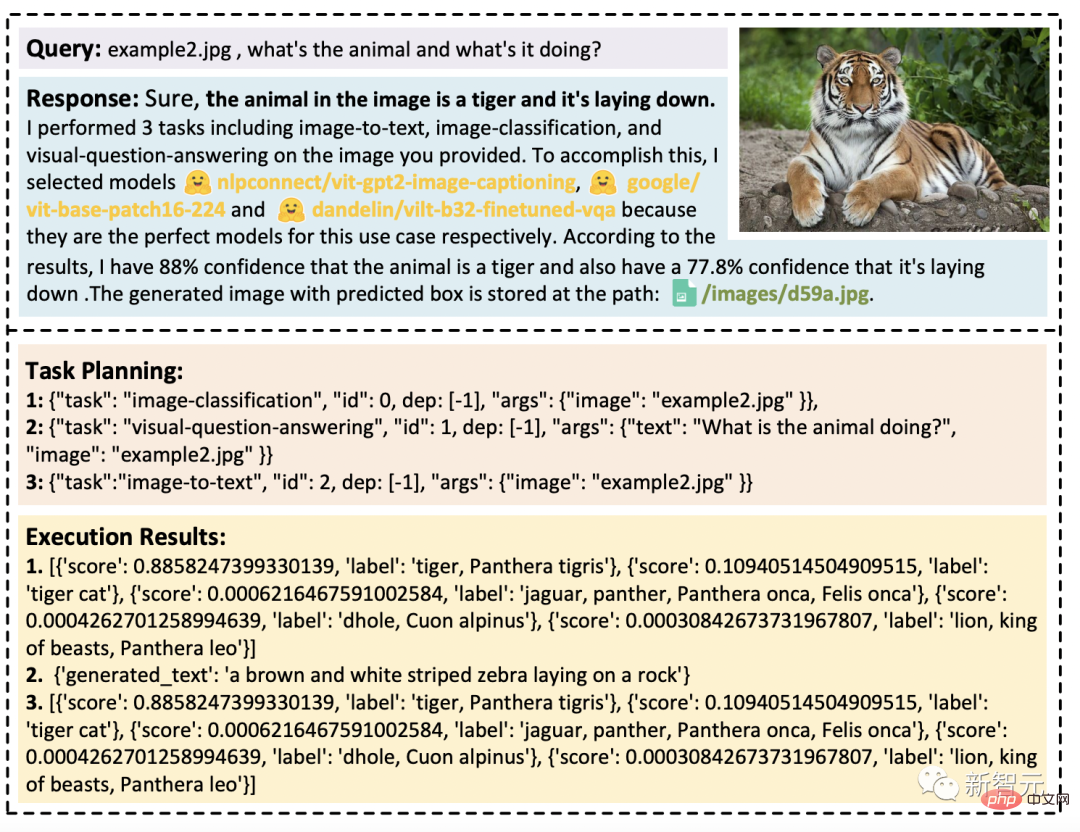

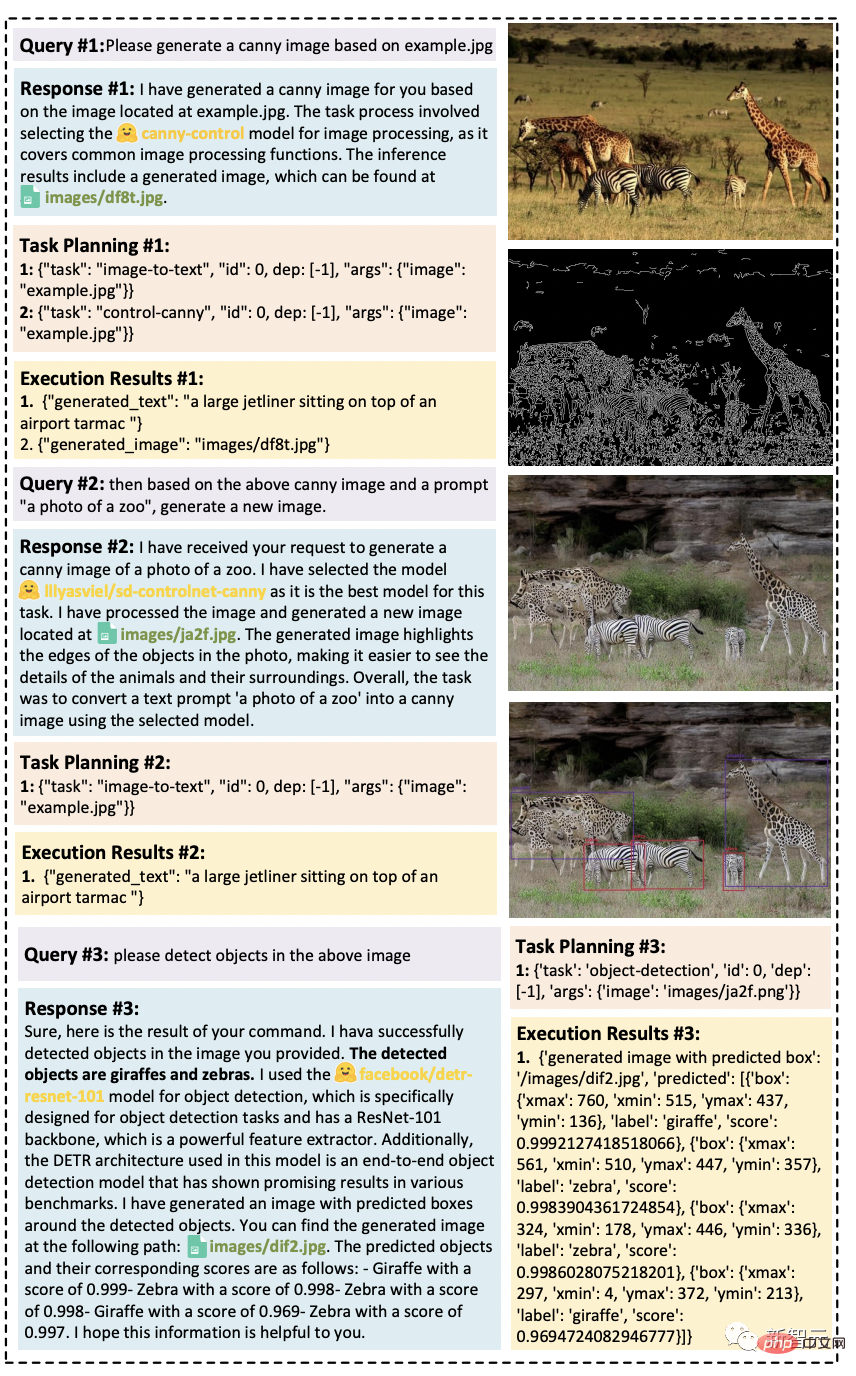

HuggingGPT整個工作流程可分為以下四個階段:

- 任務規劃:ChatGPT解析使用者請求,將其分解為多個任務,並根據其知識規劃任務順序和依賴關係

- 模型選擇:LLM根據HuggingFace中的模型描述將解析後的任務分配給專家模型

- 任務執行:專家模型在推理端點上執行分配的任務,並將執行資訊和推理結果記錄到LLM中

- 回應產生:LLM總結執行過程日誌和推理結果,並將摘要傳回給使用者

#多模態能力,有了

#實驗設定

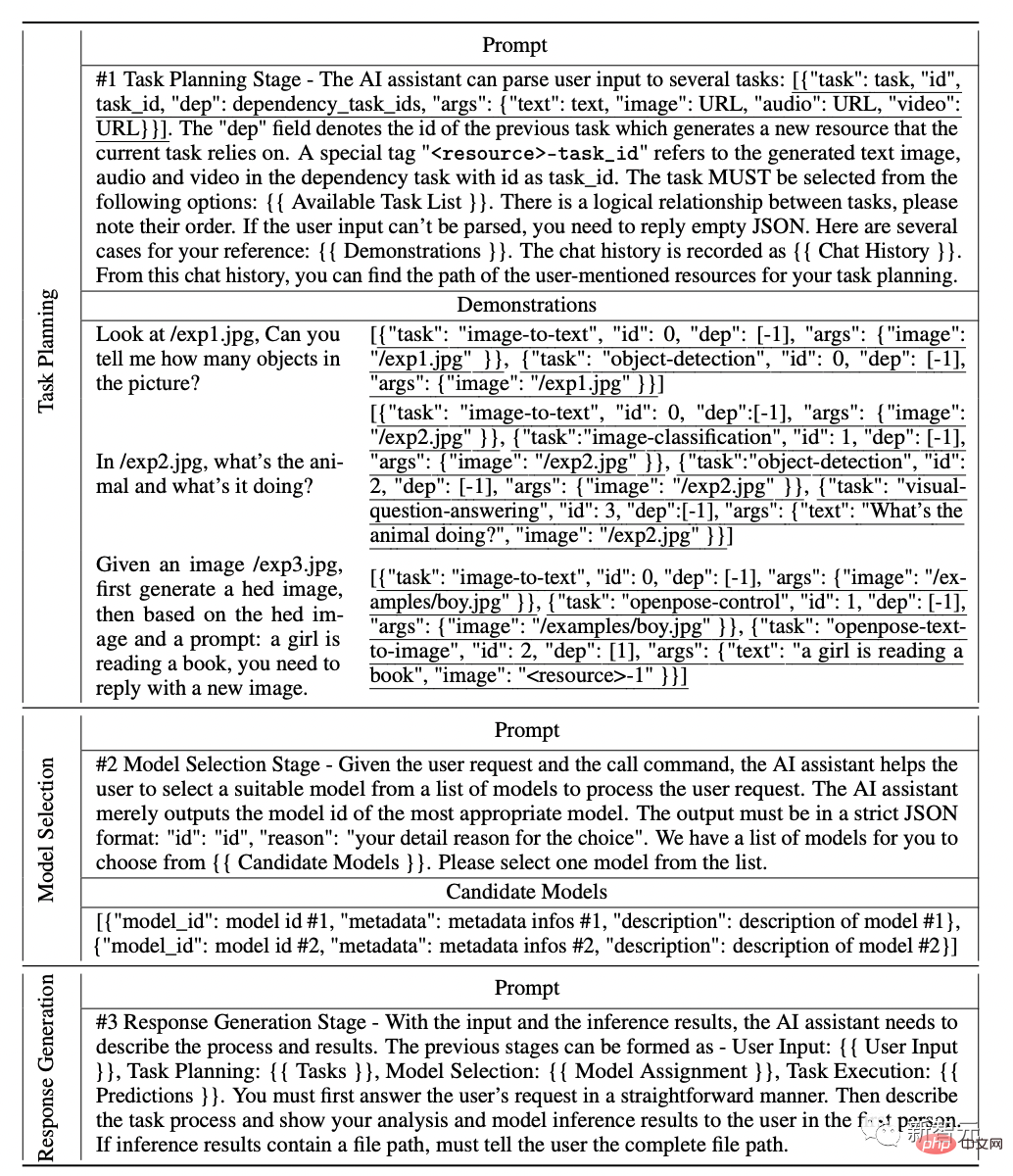

實驗中,研究者採用了gpt-3.5-turbo和text-davinci-003這兩種GPT模型的變體作為大型語言模型(LLMs),這些模型可以透過OpenAI API公開存取。

為了讓LLM的輸出更穩定,我們將解碼溫度設定為0。

同時,為了調整LLM的輸出以使其符合預期格式,我們在格式限制上設定了logit_bias為0.1。

研究人員在如下表格中提供了為任務規劃、模型選擇和反應生成階段而設計的詳細提示,其中{{variable}}表示在提示被輸入LLM之前,需要用對應的文字填入域值。

研究人員在廣泛的多模態任務上測試了HuggingGPT。

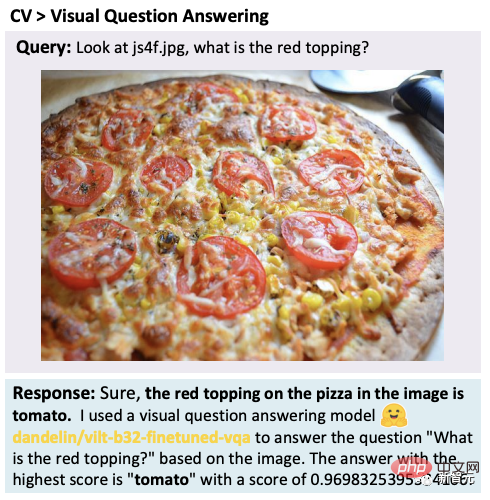

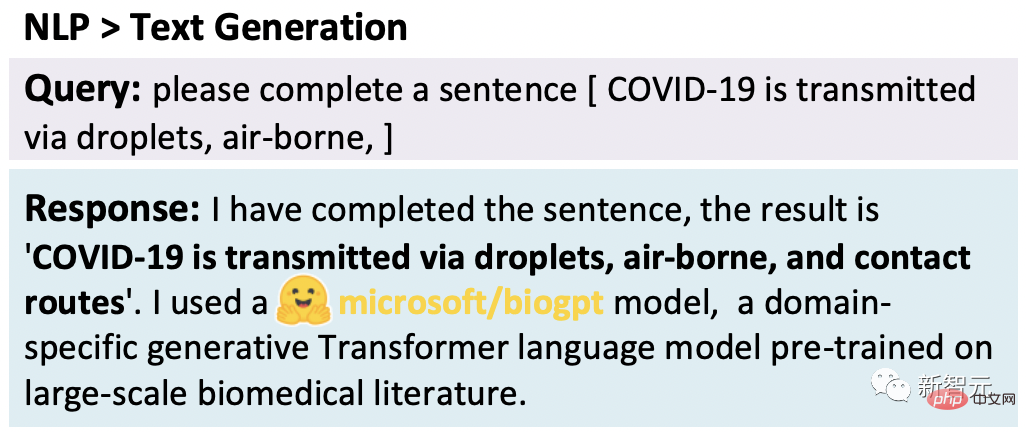

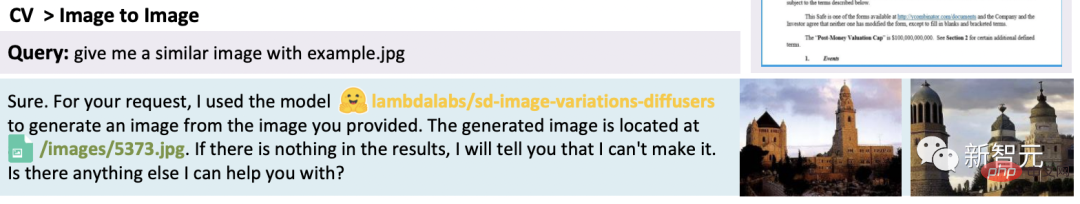

#在ChatGP和專家模型的配合下,HuggingGPT可以解決語言、圖像、音訊和視訊等多種模式的任務,包含了檢測、生成、分類和問題回答等多種形式的任務。

雖然這些任務看起來很簡單,但掌握HuggingGPT的基本能力是解決複雜任務的前提條件。

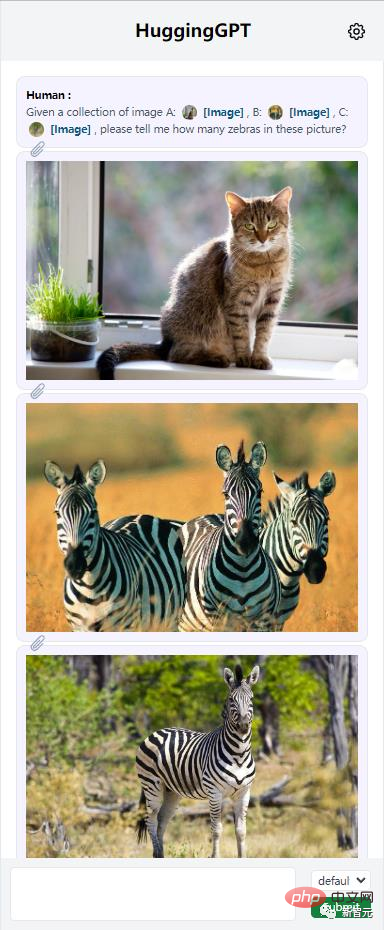

例如,視覺問答任務:

文字產生:

華文生圖:

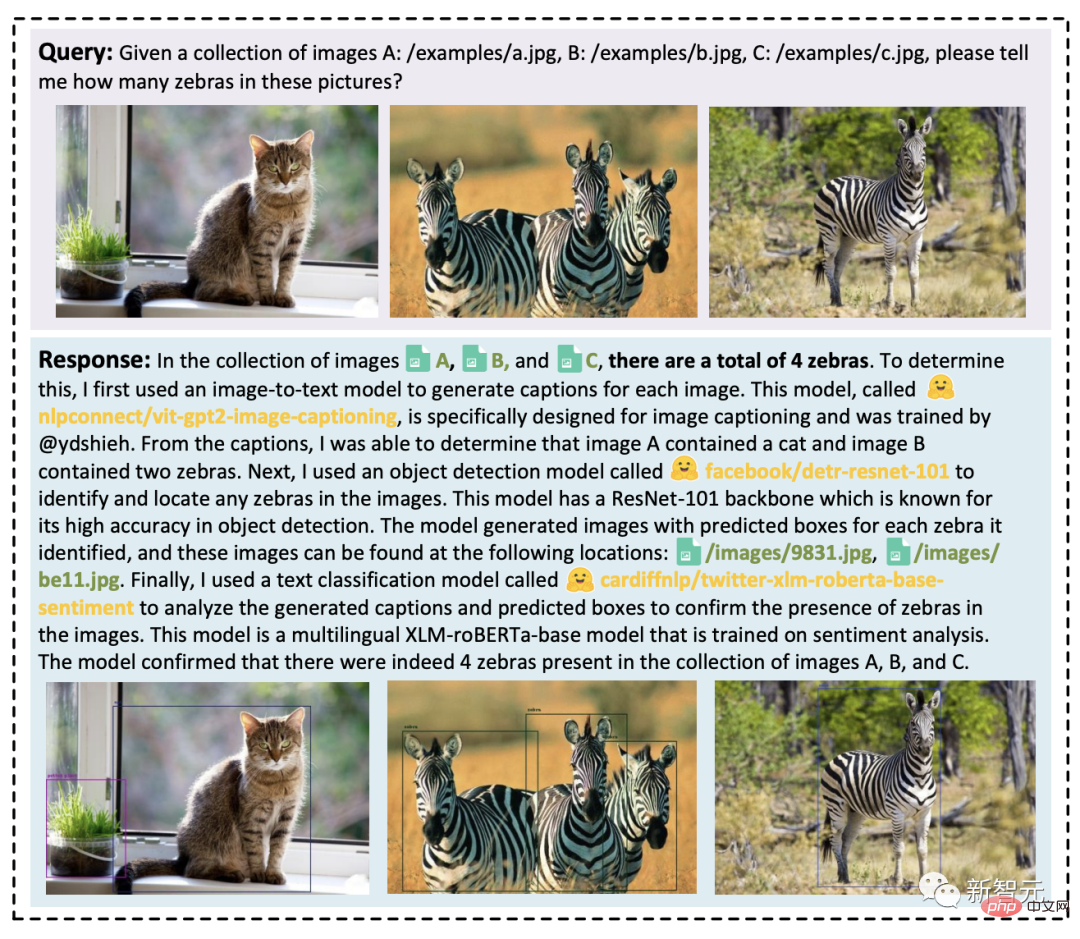

HuggingGPT可以整合多個輸入的內容來進行簡單的推理。可以發現,即使有多個任務資源,HuggingGPT也能將主要任務分解成多個基本任務,最後整合多個模型的推理結果,得到正確答案。

此外,研究人員透過測試評估了HuggingGPT在複雜任務情況下的有效性。

就HuggingGPT處理多項複雜任務的能力進行了展示。

當處理多個請求的時候,可能包含多個隱含任務或需要等多方面的信息,這時依靠一個專家模型來解決是不夠的。

而HuggingGPT可以透過任務規劃組織多個模型的協作。

一個使用者請求中可能明確包含多個任務:

下圖展示了HuggingGPT在多輪對話場景下應對複雜任務的能力。

使用者將一個複雜的請求分成幾個步驟,透過多輪請求達到最終目標。結果發現,HuggingGPT可以透過任務規劃階段的對話情境管理來追蹤使用者請求的情境狀態,並且可以很好地解決使用者提到的請求資源以及任務規劃。

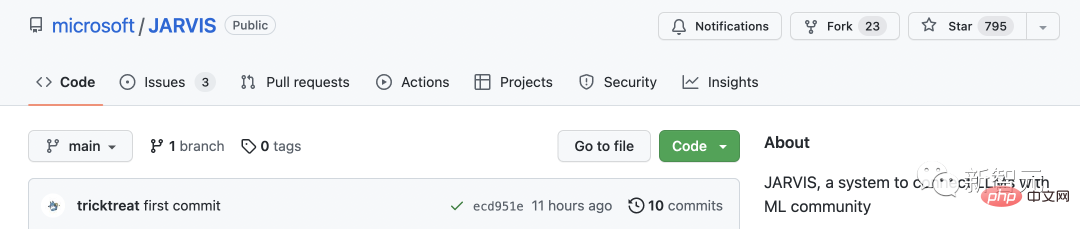

「賈維斯」開源

目前,這個專案已經在GitHub上開源,但是代碼並沒有完全公佈。

有趣的是,研究者給這個專案命名為《鋼鐵人》中的賈維斯,無敵AI這就來了。

JARVIS:一個連接LLMs和ML社群的系統

順便提一句,HuggingGPT需要有了OpenAI的API才可以使用。

網友:研究的未來

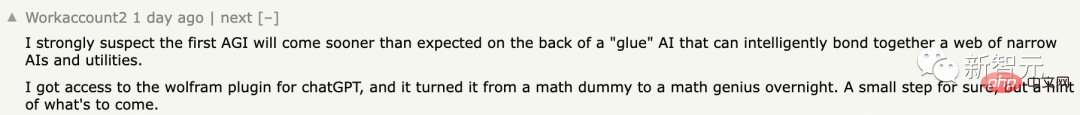

JARVIS / HuggingGPT就像先前Meta提出的Toolformer一樣,都在充當連接器的作用。

甚至,包括ChatGPT plugins也是如此。

網友稱,「我強烈懷疑第一個人工通用智慧(AGI)的出現將比預期更早。它將依靠「膠水」人工智慧,能夠智慧地將一系列狹義人工智慧和實用工具黏合在一起。

我獲得了存取插件權限,這使它一夜之間從數學菜雞變成了數學天才。當然,這只是一個小步驟,但卻預示著未來的發展趨勢。

我預測,在接下來的一年左右,我們將看到一種人工智慧助手,它與數十個大型語言模型(LLMs)及類似工具相連,而終端用戶只需向其助手發出指令,讓其為他們完成任務。這個科幻般的時刻即將到來。

還有網友稱,這就是未來的研究方法。

GPT在一大堆工具面前,知道如何使用它們了。

以上是ChatGPT自己會選模型了!微軟亞研院+浙大爆火新論文,HuggingGPT計畫已開源的詳細內容。更多資訊請關注PHP中文網其他相關文章!