馬庫斯發文砲轟LeCun:只靠深度學習無法實現類人智能

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB轉載

- 2023-04-09 23:01:141110瀏覽

今年3月,Gary Marcus(蓋瑞‧馬庫斯飾)提出「深度學習撞牆」這個觀點後,在人工智慧學界激起千層浪。

當時,就連深度學習三巨頭都坐不住了,先是Geoffrey Hinton在一期播客中駁斥了這個觀點。

緊接著6月,Yann LeCun撰寫了一篇文章對此作出了回應,並指出別把一時困難當撞牆。

現在,馬庫斯在美國NOEMA雜誌發表了一篇題為「Deep Learning Alone Isn't Getting Us To Human-Like AI」的文章。

同樣,他依舊沒有改變自己的觀點-僅靠深度學習並不能實現類人智慧。

並提出,目前人工智慧主要集中在深度學習的研究,是時候該重新考慮了。

近70年來,人工智慧領域中最根本的爭論就是:人工智慧系統是否應該建立在「符號操作」上,還是應該建立在類腦的「神經網路」系統之上。

其實,這裡還有第三種可能性:混合模型 ——將神經網路的深度學習與符號操作的強大抽象能力結合。

LeCun近期在NOEMA雜誌發表的文章「What AI Can Tell Us About Intelligence」同樣探討了這個問題,但馬庫斯指出他的文章看似清晰,但又有明顯缺陷,即前後邏輯矛盾。

這篇文章開頭,他們拒絕混合模型,但文章最後又承認混合模型的存在,並提到它是一種可能的前進方式。

神經網路和符號操作的混合模型

#馬庫斯指出,LeCun和Browning的觀點主要是「如果一個模型學會了符號操作,它就不是混合的」。

但機器學習的問題是一個發展的問題(系統是如何產生的?)

#而係統一旦發展起來如何運作是一個計算問題(例如,它使用一種機制還是兩種機制?),即“任何利用了符號和神經網路兩者的系統都是混合模型”。

也許他們真正想說的是,人工智慧很可能是一種學習的混合體,而不是天生的混合體。但學習的混合體仍然是混合體。

而馬庫斯的觀點是,「符號操作本身就是與生俱來的,或者有另外一種東西是與生俱來的,這種東西間接促成了符號操作的產生」。

所以我們的研究重心要放在如何發現這個間接促成符號運算的媒體上。

即提出了假設,只要我們能弄清楚是什麼媒體讓系統達到可以學習符號抽象的程度,我們就能建構利用世界上所有知識的系統。

接下來,馬庫斯引經據典,梳理了人工智慧領域關於符號操作和神經網路辯論的歷史。

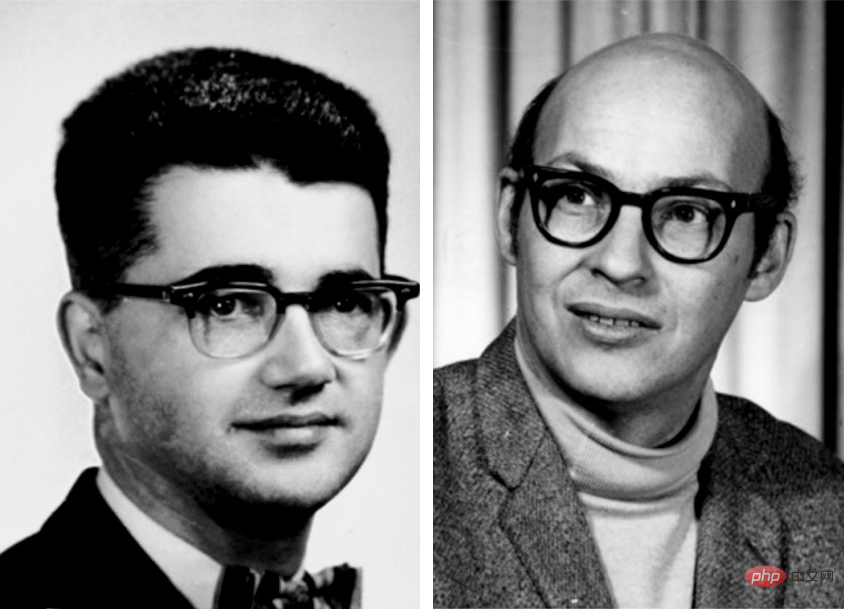

早期的人工智慧先驅如Marvin Minsky、John McCarthy認為符號操作是唯一合理的前進方式。

而神經網路先驅Frank Rosenblatt則認為,AI建立在神經節點疊加並處理數位輸入的結構上表現可能會更好。

事實上,這兩種可能性並不互相排斥。

AI所使用的神經網路並不是字面上的生物神經元網絡,相反,它是一個簡化的數字模型,它具備一些人類大腦的特性,但複雜性很小。

原則上,這些抽象符號可以以許多不同的方式連接起來,其中一些可以直接實現邏輯和符號運算。

Warren S. McCulloch 和Walter Pitts在1943年發表的A Logical Calculus of the Ideas Inmanent in Nervous Activity,明確承認了這種可能性。

其他人包括1950 年代的 Frank Rosenblatt 和 1980 年代的 David Rumelhart 和 Jay McClelland,提出了神經網路作為符號操作的替代方案。 Geoffrey Hinton 也普遍支持這一立場。

然後馬庫斯又接連把LeCun、Hinton和Yoshua Bengio等圖靈獎得主cue了個遍。

意思是光我說了不算,其他大佬都這麼說的!

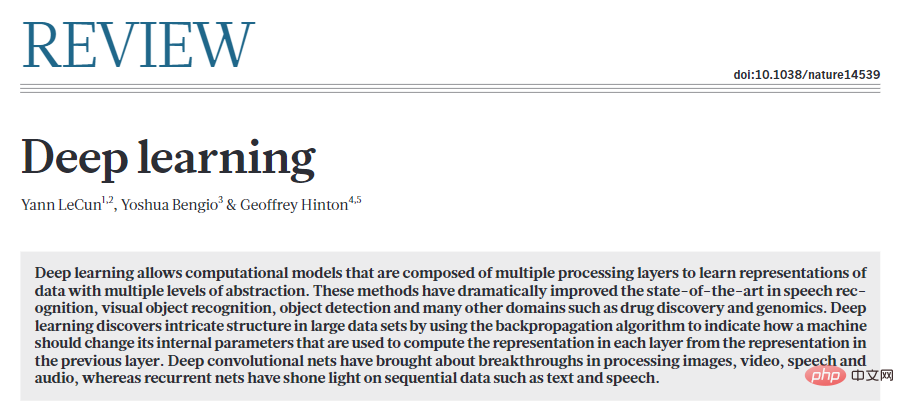

時間來到2015年,LeCun、Bengio和Hinton在Nature上寫了一篇關於深度學習的宣言式論文。

這篇文章以對符號的攻擊結束,認為「需要新的範式來透過對大向量的運算來取代基於規則的符號表達式運算」。

事實上,Hinton 非常確信符號是一條死胡同,同年他在史丹佛大學發表了一個名為「以太符號」的演講——將符號比喻為科學史上最大的錯誤之一。

上世紀80年代,他的兩位前合作者Rumelhart 和McClelland 也提出了類似的論點,他們在1986 年的一本著名著作中辯稱,符號不是「人類計算的本質」,引發了大辯論。

馬庫斯稱,2018年他寫了一篇文章為符號操作辯護時,LeCun不加解釋地否定了他關於混合AI的論點,在Twitter上將其斥為「大部分錯誤的觀點」。

然後又說,兩位著名的深度學習領域的大牛也表示支持混合 AI。

Andrew Ng在3月表示支援此類系統。 Sepp Hochreiter——LSTMs 的共同創造者,領先的學習序列深度學習架構之一,也做了同樣的事情,他在四月公開表示,最有希望的廣泛人工智能方法是神經符號人工智能。

而在LeCun和Browning的新觀點裡,符號操作其實是至關重要的,正如馬庫斯和Steven Pinker從1988年開始提出的觀點。

馬庫斯也就由此指責Lecun,「你的觀點我幾十年前就提出了,你的研究倒退了幾十年」 。

而且不只是我一個人說的,其他大佬也這麼認為。

LeCun 和Browning 的其餘文章大致可以分為三個部分:

1、對我的立場的錯誤描述2、努力縮小混合模型的範圍3、符號操作可能是透過學習而不是與生俱來的原因。

接下來馬庫斯又針對LeCun論文中的觀點進行反駁:

#LeCun和Browning說,「Marcus說,如果你一開始沒有符號操作,你就永遠不會擁有它」。

而事實上我在2001年的《代數思維》一書中明確承認,我們不確定符號操作是否是與生俱來的。

他們批評我「深度學習無法進一步進展」的言論,而我的實際觀點並不是DL在任何問題上都不會再有進展,而是深度學習本身對於組合性、推理等某些工作來說是錯誤的工具。

同樣,他們污衊我說系統中符號推理要麼有要麼沒有(1或0)。

這根本就是瞎說。

的確DALL-E不使用符號進行推理,但這並不意味著任何包含符號推理的系統都必須是有或沒有。

至少早在上世紀70年代的系統MYCIN中,就有純粹的符號系統可以進行各種定量推理。

符號操作先天性

符號操作能力是否可以透過學習而非從一開始就建立?

答案是肯定的。

馬庫斯稱,先前的實驗雖然不能保證符號操作的能力是與生俱來的,但幾乎與這一觀點別無二致。它們確實對任何依賴大量經驗的學習理論構成了挑戰。

並提出了以下2個主要的論點:

1 、可學習性

在2001年出版的The Algebraic Mind一書中,馬庫斯展示了某些系統都能夠學習符號操作。

一個系統,如果有一些內建的起點,將比一塊純粹的白板更能有效地了解這個世界。

事實上,就連LeCun自己最著名的工作——On Convolutional Neural Networks ——就是一個很好的例證:對神經網路學習方式的內建約束,從而大大提高了效率。很好地整合符號操作後,可能會帶來更大的收益。

2、人類嬰兒表現出一些符號操作的能力

在一系列經常被引用的規則學習實驗中,嬰兒們將抽像模式推廣到了他們所接受過訓練的具體例子之外。隨後對人類嬰兒內隱邏輯推理能力的研究更加證明了這一點。

另外,研究表明,例如蜜蜂可以以將太陽方位角函數推廣到它們從未見過的光照條件下。

在LeCun看來,學習符號等同於晚年獲得的東西,是因為年輕時需要更精確、更專業的技能。

而令人費解的是,在反對符號操作的先天性後,LeCun並沒有給出強有力的證據,證明符號操作是後天習得的。

如果一隻小山羊在出生後不久就可以爬下山坡,為什麼新生的神經網路不能開箱即用地結合一點符號操作呢?

同時,LeCun和Browning沒有具體說明,缺乏符號操作的內在機制,如何解決語言理解和推理中眾所周知的特定問題?

他們只是給一個微弱的歸納:由於深度學習已經克服了從1到N的問題,我們應該對它能克服N 1問題有信心。

人們應該懷疑深度學習是否已經達到了極限。鑑於最近在DALL-E 2、Gato和PaLM中看到的任務持續漸進式改進,不要將一時困難誤認為是「牆」似乎是明智的。深度學習不可避免的失敗之前已經被預言過,但押注它是不值得的。

樂觀是一方面,但要看清現實。

深度學習原則上面臨著一些特定的挑戰,主要在組合性、系統性和語言理解方面,所有這些都圍繞著一般化和「分佈遷移”。

現在,每個人都認識到分佈遷移是當前神經網路的致命弱點。當然,深度學習已經取得了進展,但是在這些基礎問題上,進展並不大。

在馬庫斯看來,符號運算可能有先天的情況與以往的情況大致相同:

1、目前的系統,在「代數思維」出現的20年後,即使面對海量的資料集和訓練,仍然無法可靠地提取符號運算(例如乘法)。

2、人類嬰兒的例子表明,在接受正規教育之前,他們有能力概括自然語言和推理的複雜方面。 3.一點內在的象徵意義可以大大提高學習效率。 AlphaFold 2的強大功能部分來自於精心建構的分子生物學與生俱來的表徵。

簡言之,世界可能大致分為三個垃圾箱:

一是在工廠完全安裝了符號操作設備的系統。

二是具有先天的學習裝置系統缺乏符號操作,但是在正確的資料和訓練環境下,有足夠的能力獲得它。

三是即使有足夠的訓練,也無法獲得完整的符號操作機制的系統。

目前的深度學習系統似乎屬於第三類:一開始沒有符號操作機制,並且在此過程中沒有可靠的符號操作機制。

當前,了解符號操作的來源是我們的首要任務。即便是神經網路最狂熱的支持者現在也意識到符號操作對於實現AI的重要性。

而這正是神經符號學界一直關注的問題: :如何讓資料驅動的學習和符號表示在單一的、更強大的智慧中協調一致地工作?

#以上是馬庫斯發文砲轟LeCun:只靠深度學習無法實現類人智能的詳細內容。更多資訊請關注PHP中文網其他相關文章!