也許你還沒注意到,人工智慧系統最近的表現越來越令人驚訝。

例如, OpenAI 的新模型DALL-E 2可以根據簡單的文字提示產生引人入勝的原始圖像。像 DALL-E 這樣的模型讓人們更難否認人工智慧具有創造力的概念。例如,考慮DALL-E對「一頭穿著牛仔夾克的嘻哈乳牛在錄音室錄製熱門單曲」的富有想像力的演繹。或者對於更抽象的範例,請查看DALL-E對舊Peter Thiel 行的解釋「我們想要飛行汽車,而不是140 個字元。」

與此同時,DeepMind 最近宣布了一種名為Gato的新模型,它可以單槍匹馬地執行數百種不同的任務,從玩電子遊戲到進行對話,再到用機械手臂堆疊現實世界的積木。幾乎所有以前的 AI 模型都能夠做一件事,而且只能做一件事——例如,下棋。因此,Gato 代表了朝著更廣泛、更靈活的機器智慧邁出的重要一步。

而今天的大型語言模型 (LLM)——從 OpenAI 的 GPT-3 到 Google 的 PaLM 再到 Facebook 的 OPT——擁有令人眼花繚亂的語言能力。他們幾乎可以就任何主題進行細微和深入的交談。他們可以自己產生令人印象深刻的原創內容,從商業備忘錄到詩歌。僅舉一個最近的例子,GPT-3 最近撰寫了一篇關於其自身的寫得很好的學術論文,目前正在接受同行評審,以便在著名的科學期刊上發表。

這些進步激發了人工智慧社群關於技術發展方向的大膽猜測和熱烈討論。

一些可靠的人工智慧研究人員認為,我們現在距離「通用人工智慧」(AGI)很近,這是一個經常討論的基準,指的是強大、靈活的人工智慧,可以在任何認知任務中勝過人類。上個月,一位名叫 Blake Lemoine 的 Google 工程師透過戲劇性地聲稱 Google 的大型語言模型LaMDA是有感知的而登上了頭條新聞。

對此類主張的抵制同樣強烈,許多 AI 評論員立即 否定了這種可能性。

那麼,我們要如何看待人工智慧領域最近的所有驚人進展?我們應該如何看待人工智慧和人工智慧感知等概念?

關於這些主題的公共論述需要以幾個重要的方式重新建構。認為超級智慧人工智慧即將到來的過度興奮的狂熱者,以及認為人工智慧最近的發展只是炒作的不屑一顧的懷疑論者,在他們對現代人工智慧的一些基本方面的思考中都偏離了標準。

通用人工智慧是一個不連貫的概念

人們經常忽略的關於人工智慧的一個基本原則是,人工智慧從根本上不同於人類智慧。

將人工智慧過於直接地類比為人類智慧是錯誤的。今天的人工智慧不僅僅是人類智慧的一種「進化程度較低」的形式。明天的超先進人工智慧也不會只是人類智慧的更強大版本。

許多不同的智慧模式和維度是可能的。最好不要將人工智慧視為人類智慧的不完美模仿,而是將其視為一種獨特的、外星的智慧形式,其輪廓和能力在基本方面與我們不同。

為了讓這一點更具體,簡單地考慮一下今天的人工智慧狀態。今天的人工智慧在某些領域遠遠超過了人類的能力——而在其他領域卻遠遠落後於人類。

舉個例子:半世紀以來, 「蛋白質摺疊問題」一直是生物學領域的一大挑戰。簡而言之,蛋白質折疊問題需要根據蛋白質的一維氨基酸序列預測蛋白質的三維形狀。數十年來,世界上幾代最聰明的人共同努力,未能解決這個挑戰。 2007 年的一位評論員將其描述為「現代科學中最重要但尚未解決的問題之一」。

2020 年底,DeepMind 的一個名為 AlphaFold 的 AI 模型為蛋白質折疊問題提供了解決方案。正如長期從事蛋白質研究的John Moult 所說,「這是歷史上第一次由AI 解決嚴重的科學問題。」

破解蛋白質折疊之謎需要空間理解和高維推理形式,而這根本超出了人類思維的掌握範圍。但並非超出現代機器學習系統的掌握範圍。

同時,任何健康的人類兒童都擁有遠遠超過世界上最複雜的人工智慧的「具身智慧」。

從很小的時候起,人類就可以毫不費力地做一些事情,例如玩接球、走過陌生的地形,或是打開廚房的冰箱吃點零食。事實證明,人工智慧很難掌握這些物理能力。

這被封裝在「莫拉維克悖論」中。正如AI 研究員莫拉維克( Hans Moravec) 在1980 年代所說:「讓電腦在智力測驗或下棋時表現出成人水準的表現相對容易,但很難或不可能讓電腦具備一歲兒童的技能。感知和流動性。”

莫拉維克對這個不直觀的事實的解釋是進化論的:“在人類大腦的大型、高度進化的感覺和運動部分中,編碼了十億年關於世界性質以及如何在其中生存的經驗。[另一方面,]我們稱之為高級推理的深思熟慮的過程,我相信,是人類思想的最薄薄的一層,它之所以有效,僅僅是因為它得到了這種更古老、更強大、雖然通常是無意識的感覺運動知識的支持。我們都是知覺和運動領域的傑出奧運選手,如此出色以至於我們讓困難看起來很容易。」

直到今天,機器人仍在與基本的身體能力作鬥爭。就在幾週前,一組DeepMind 研究人員在一篇新論文中寫道:「與非常年幼的孩子相比,當前的人工智慧系統對『直覺物理學』的理解相形見絀。」

這一切的結果是什麼?

沒有通用人工智慧這樣的東西。

AGI 既不可能也不不可能。相反,它作為一個概念是不連貫的。

智能不是單一的、定義明確的、可概括的能力,甚至也不是一組特定的能力。在最高層次上,智能行為只是一個代理獲取和使用有關其環境的知識來追求其目標。因為存在著大量(理論上是無限的)不同類型的代理、環境和目標,所以智能可以透過無數種不同的方式表現出來。

AI大神Yann LeCun總結得很好:「沒有通用人工智慧這種東西…即使是人類也是專用的。」

將「通用」或「真正的」人工智慧定義為可以做人類可以做的事情(但更好)的人工智慧——認為人類智慧是通用智慧——是短視的以人為中心。如果我們將人類智慧作為人工智慧發展的最終錨和標準,我們將錯過機器智慧可能具備的所有強大、深刻、意想不到、對社會有益、完全非人類的能力。

想像一下,一個人工智慧對地球大氣的組成有了原子級的理解,並且可以以極高的準確度動態預測整個系統將如何隨著時間的推移而演變。想像一下,如果它可以設計出一種精確、安全的地球工程幹預措施,我們在大氣中的某些地方沉積一定數量的某些化合物,從而抵消人類持續碳排放造成的溫室效應,從而減輕全球變暖對地球表面的影響。

想像一下,一個人工智慧可以將人體中的每一個生物和化學機制都細緻入微地理解到分子層次。想像一下,如果它可以因此開出量身定制的飲食來優化每個人的健康,可以精確診斷任何疾病的根本原因,可以產生新的個人化療法(即使它們還不存在)來治療任何嚴重的疾病。

想像一下,一個人工智慧可以發明一種協議,以一種安全地產生比消耗更多的能量的方式融合原子核,從而將核聚變解鎖為一種廉價、可持續、無限豐富的人類能源。

所有這些場景在今天仍然是幻想,對於今天的人工智慧來說是遙不可及的。關鍵在於,人工智慧的真正潛力在於這樣的道路——隨著新型智慧形式的發展,這些智慧形式完全不同於人類所能做到的任何事情。如果人工智慧能夠實現這樣的目標,誰會在乎它在整體上匹配人類能力的意義上是否是「通用的」?

將我們自己定位於「通用人工智慧」會限制和削弱這項技術的發展潛力。而且──因為人類智能不是一般智能,一般智能不存在──它首先在概念上是不連貫的。

成為人工智慧是什麼感覺?

這為我們帶來了一個關於人工智慧大局的相關話題,這個主題目前正受到公眾的廣泛關注:人工智慧是否或永遠是有感知能力的問題。

Google工程師 Blake Lemoine上個月公開斷言Google的一個大型語言模型已經變得有意識,這引發了一波爭議和評論浪潮。 (在形成任何明確的意見之前,值得自己閱讀Lemoine 和AI 之間討論的完整記錄。)

大多數人——尤其是人工智慧專家——認為Lemoine 的說法是錯誤的和不合理的。

Google在官方回應中表示:「我們的團隊已經審查了布萊克的擔憂,並告知他證據不支持他的說法。」 史丹佛大學教授Erik Brynjolfsson認為,感知人工智慧可能還需要50 年的時間。加里馬庫斯插話稱 Lemoine 的說法是“胡說八道”,並得出結論說“這裡沒有什麼可看的。”

整個討論的問題——包括專家輕描淡寫的解僱——的問題在於,根據定義,感知的存在與否是不可證明的、不可證偽的、不可知的。

當我們談論感知時,我們指的是代理人的主觀內在經驗,而不是任何外在的智力表現。沒有人——不是 Blake Lemoine、不是 Erik Brynjolfsson、不是 Gary Marcus——可以完全確定高度複雜的人工神經網路在內部體驗或不體驗什麼。

1974 年,哲學家托馬斯·內格爾發表了一篇題為《成為蝙蝠是什麼感覺? 》的文章。作為20 世紀最有影響力的哲學論文之一,這篇文章將眾所周知的難以捉摸的意識概念歸結為一個簡單、直觀的定義:如果有某種東西願意成為那個代理人,那麼代理人就是有意識的。例如,做我的隔壁鄰居,甚至做他的狗都像是什麼東西;但做他的郵箱一點也不像。

論文的一個關鍵訊息是,不可能以有意義的方式確切地知道成為另一個生物體或物種的感覺。其他有機體或物種越不像我們,它的內在體驗就越難接近。

內格爾以蝙蝠為例來說明這一點。他之所以選擇蝙蝠,是因為身為哺乳動物,它們是高度複雜的生物,但它們對生命的體驗與我們截然不同:它們會飛,它們使用聲納作為感知世界的主要手段,等等。

正如Nagel 所說(值得全文引用論文中的幾段):

「我們自己的經驗為我們的想像力提供了基本材料,因此想像力的範圍是有限的。試想一個人的手臂上有蹼,使人在黃昏和黎明時可以飛來飛去,嘴裡有蟲子,這無濟於事;一個人的視力很差,透過反射的高頻聲音訊號系統感知周圍的世界;那個人整天倒掛在閣樓上。

「就我所能想像的(這不是很遠)而言,它只告訴我像蝙蝠一樣行事會是什麼樣子。但這不是問題。我想知道蝙蝠成為蝙蝠是什麼感覺。然而,如果我試著想像這一點,我就會被限制在我自己的思想資源中,而這些資源不足以完成這項任務。我無法透過想像對我目前經驗的補充,或透過想像逐漸從中減去的片段,或是想像一些加法、減法和修改的組合來實現它。 」

與蝙蝠相比,人工神經網路對我們人類來說更加陌生和難以接近,蝙蝠至少是哺乳動物和碳基生命形式。

#同樣,太多評論者在這個主題上犯的基本錯誤(通常甚至沒有考慮過)是假設我們可以簡單地將我們對人類感知或智能的期望映射到人工智能。

我們無法以任何直接或第一手的方式確定甚至思考人工智慧的內在體驗。我們根本無法確定。

那麼,我們如何以富有成效的方式處理AI 感知這個話題呢?

我們可以從圖靈( Alan Turing) 在1950 年首次提出的圖靈測試中獲得靈感。圖靈測試經常受到批評或誤解,而且肯定是不完美的,它作為AI 領域的參考點經受住了時間的考驗,因為它捕捉到了某些基本見解關於機器智能的本質。

圖靈測試承認並接受了我們永遠無法直接訪問人工智慧內部體驗的現實。它的全部前提是,如果我們想衡量人工智慧的智能,我們唯一的選擇是觀察它的行為,然後得出適當的推論。(需要明確的是,圖靈關注的是評估機器的思考能力,而不一定是它的感知能力;不過,就我們的目的而言,相關的是基本原則。)

侯世達(Douglas Hofstadter) 特別雄辯地闡述了這個想法:「你怎麼知道當我與你交談時,我內心正在發生任何類似於你所說的'思考'的事情?圖靈測試是一個了不起的探針——就像物理學中的粒子加速器。就像在物理學中一樣,當您想了解原子或亞原子水平上發生的事情時,由於您無法直接看到它,因此您可以將加速粒子從相關目標上散射並觀察它們的行為。由此您可以推斷出目標的內部性質。圖靈測試將這個想法延伸到頭腦。它將思想視為不直接可見但可以更抽像地推斷其結構的“目標”。透過從目標頭腦中『分散』問題,你可以了解它的內部運作,就像在物理學中一樣。 」

為了在關於人工智慧感知的討論中取得任何進展,我們必須將自己定位在可觀察的表現上,作為內部體驗的代理;否則,我們會在不嚴謹、空洞、死胡同的辯論中兜圈子。

Erik Brynjolfsson 確信今天的人工智慧沒有感知能力。然而,他的評論表明他相信人工智慧最終將是有感知的。當他遇到真正有感知力的人工智慧時,他怎麼會知道呢?他會尋找什麼?

你是你的所作所為

在有關 AI 的辯論中,懷疑論者經常以簡化的方式描述該技術,以淡化其能力。

正如一位AI 研究人員在回應Blake Lemoine 新聞時所說的那樣:“使用更高維度的參數函數從符號和數據處理中希望獲得意識、理解或常識是很神秘的。”在最近的一篇部落格文章中,Gary Marcus 認為,今天的AI 模型甚至都不是“遠程智能的”,因為“它們所做的只是匹配模式並從海量統計數據庫中提取數據。” 他認為Google 的大型語言模型LaMDA 只是「文字電子表格」。

這種推理方式具有誤導性,是微不足道的。畢竟,如果我們這樣選擇,我們可以以類似的簡化方式構建人類智能:我們的大腦「只是」大量以特定方式相互連接的神經元,「只是」我們頭骨內的基本化學反應的集合。

但這沒有抓到重點。人類智慧的力量和魔力不在於特定的機制,而在於以某種方式產生的令人難以置信的湧現能力。簡單的基本功能可以產生深刻的智力系統。

最終,我們必須根據人工智慧的能力來判斷它。

如果我們將五年前的人工智慧狀態與今天的技術狀態進行比較,毫無疑問,由於自我監督學習等領域的突破,其能力和深度以顯著(並且仍在加速)的方式擴展,變壓器和強化學習。

人工智慧不像人類智慧。人工智慧何時以及是否會變得有感知力——在 Nagel 的表述中,它何時以及是否曾經「像某樣東西」成為一個人工智慧——它將無法與成為人類的情況相提並論。人工智慧是它自己獨特的、陌生的、迷人的、快速發展的認知形式。

重要的是人工智慧可以實現什麼。在基礎科學(如 AlphaFold)方面取得突破,應對氣候變遷等物種層面的挑戰,促進人類健康和長壽,加深我們對宇宙如何運作的理解——這些結果是對 AI 力量和複雜性的真正考驗。

以上是通用人工智慧、人工智慧感知和大型語言模型的詳細內容。更多資訊請關注PHP中文網其他相關文章!

Markitdown MCP可以將任何文檔轉換為Markdowns!Apr 27, 2025 am 09:47 AM

Markitdown MCP可以將任何文檔轉換為Markdowns!Apr 27, 2025 am 09:47 AM處理文檔不再只是在您的AI項目中打開文件,而是將混亂變成清晰度。諸如PDF,PowerPoints和Word之類的文檔以各種形狀和大小淹沒了我們的工作流程。檢索結構化

如何使用Google ADK進行建築代理? - 分析VidhyaApr 27, 2025 am 09:42 AM

如何使用Google ADK進行建築代理? - 分析VidhyaApr 27, 2025 am 09:42 AM利用Google的代理開發套件(ADK)的力量創建具有現實世界功能的智能代理!該教程通過使用ADK來構建對話代理,並支持Gemini和GPT等各種語言模型。 w

在LLM上使用SLM進行有效解決問題-Analytics VidhyaApr 27, 2025 am 09:27 AM

在LLM上使用SLM進行有效解決問題-Analytics VidhyaApr 27, 2025 am 09:27 AM摘要: 小型語言模型 (SLM) 專為效率而設計。在資源匱乏、實時性和隱私敏感的環境中,它們比大型語言模型 (LLM) 更勝一籌。 最適合專注型任務,尤其是在領域特異性、控制性和可解釋性比通用知識或創造力更重要的情況下。 SLM 並非 LLMs 的替代品,但在精度、速度和成本效益至關重要時,它們是理想之選。 技術幫助我們用更少的資源取得更多成就。它一直是推動者,而非驅動者。從蒸汽機時代到互聯網泡沫時期,技術的威力在於它幫助我們解決問題的程度。人工智能 (AI) 以及最近的生成式 AI 也不例

如何將Google Gemini模型用於計算機視覺任務? - 分析VidhyaApr 27, 2025 am 09:26 AM

如何將Google Gemini模型用於計算機視覺任務? - 分析VidhyaApr 27, 2025 am 09:26 AM利用Google雙子座的力量用於計算機視覺:綜合指南 領先的AI聊天機器人Google Gemini擴展了其功能,超越了對話,以涵蓋強大的計算機視覺功能。 本指南詳細說明瞭如何利用

Gemini 2.0 Flash vs O4-Mini:Google可以比OpenAI更好嗎?Apr 27, 2025 am 09:20 AM

Gemini 2.0 Flash vs O4-Mini:Google可以比OpenAI更好嗎?Apr 27, 2025 am 09:20 AM2025年的AI景觀正在充滿活力,而Google的Gemini 2.0 Flash和Openai的O4-Mini的到來。 這些尖端的車型分開了幾週,具有可比的高級功能和令人印象深刻的基準分數。這個深入的比較

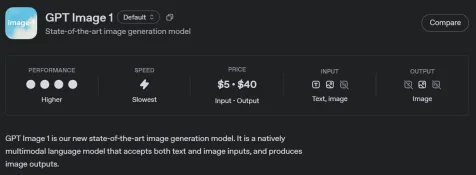

如何使用OpenAI GPT-Image-1 API生成和編輯圖像Apr 27, 2025 am 09:16 AM

如何使用OpenAI GPT-Image-1 API生成和編輯圖像Apr 27, 2025 am 09:16 AMOpenai的最新多模式模型GPT-Image-1徹底改變了Chatgpt和API的形像生成。 本文探討了其功能,用法和應用程序。 目錄 了解gpt-image-1 gpt-image-1的關鍵功能

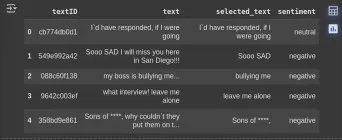

如何使用清潔行執行數據預處理? - 分析VidhyaApr 27, 2025 am 09:15 AM

如何使用清潔行執行數據預處理? - 分析VidhyaApr 27, 2025 am 09:15 AM數據預處理對於成功的機器學習至關重要,但是實際數據集通常包含錯誤。清潔行提供了一種有效的解決方案,它使用其Python軟件包來實施自信的學習算法。 它自動檢測和

AI技能差距正在減慢供應鏈Apr 26, 2025 am 11:13 AM

AI技能差距正在減慢供應鏈Apr 26, 2025 am 11:13 AM經常使用“ AI-Ready勞動力”一詞,但是在供應鏈行業中確實意味著什麼? 供應鏈管理協會(ASCM)首席執行官安倍·埃什肯納齊(Abe Eshkenazi)表示,它表示能夠評論家的專業人員

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

Atom編輯器mac版下載

最受歡迎的的開源編輯器

SAP NetWeaver Server Adapter for Eclipse

將Eclipse與SAP NetWeaver應用伺服器整合。

Dreamweaver Mac版

視覺化網頁開發工具

VSCode Windows 64位元 下載

微軟推出的免費、功能強大的一款IDE編輯器

WebStorm Mac版

好用的JavaScript開發工具