真的有這麼絲滑:3D頭髮建模新方法NeuralHDHair,浙大、ETH Zurich、CityU聯合出品

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB轉載

- 2023-04-09 12:31:091343瀏覽

近年来,虚拟数字人行业爆火,各行各业都在推出自己的数字人形象。毫无疑问,高保真度的 3D 头发模型可以显著提升虚拟数字人的真实感。与人体的其他部分不同,由于交织在一起的头发结构极其复杂,因此描述和提取头发结构更具挑战性,这使得仅从单一视图重建高保真的 3D 头发模型极其困难。一般来说,现有的方法都是通过两个步骤来解决这个问题:首先根据从输入图像中提取的 2D 方向图估计一个 3D 方向场,然后根据 3D 方向场合成头发丝。但这种机制在实践中仍在存在一些问题。

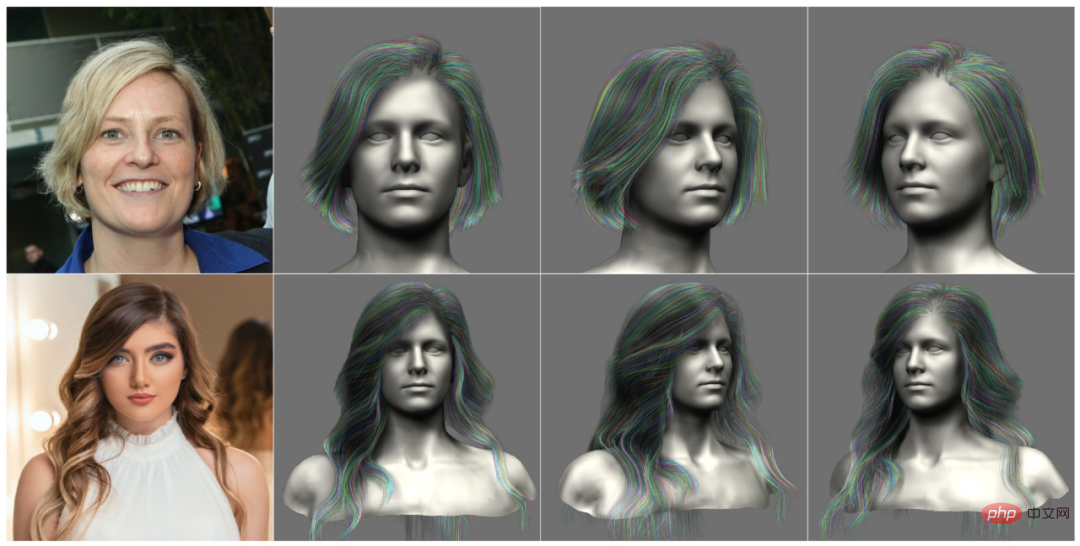

基于实践中的观察,研究者们正在寻求一个完全自动化和高效的头发模型建模方法,可以从具备细粒度特征的单一图像重建一个 3D 头发模型(如图 1),同时显示出高度的灵活性,比如重建头发模型只需要网络的一个前向传递。

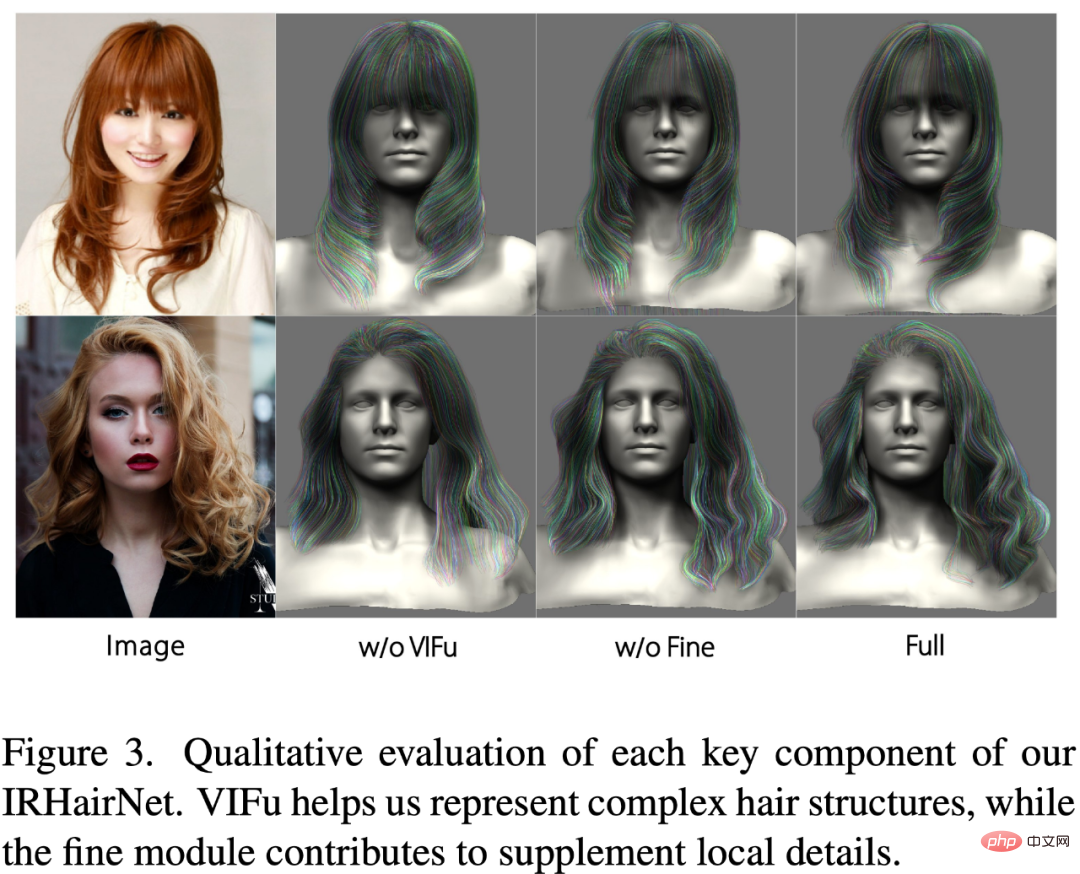

为了解决这些问题,来自浙江大学、瑞士苏黎世联邦理工学院和香港城市大学的研究者提出了 IRHairNet,实施一个由粗到精的策略来生成高保真度的 3D 方向场。具体来说,他们引入了一种新颖的 voxel-aligned 的隐函数(VIFu)来从粗糙模块的 2D 方向图中提取信息。同时,为了弥补 2D 方向图中丢失的局部细节,研究者利用高分辨率亮度图提取局部特征,并结合精细模块中的全局特征进行高保真头发造型。

为了有效地从 3D 方向场合成头发丝模型,研究者引入了 GrowingNet,一种基于深度学习利用局部隐式网格表征的头发生长方法。这基于一个关键的观察:尽管头发的几何形状和生长方向在全局范围内有所不同,但它们在特定的局部范围内具有相似的特征。因此,可以为每个局部 3D 方向 patch 提取一个高级的潜在代码,然后训练一个神经隐函数 (一个解码器) 基于这个潜在代码在其中生长头发丝。在每一个生长步骤之后,以头发丝的末端为中心的新的局部 patch 将被用于继续生长。经过训练后,它可适用于任意分辨率的 3D 定向场。

论文:https://arxiv.org/pdf/2205.04175.pdf

IRHairNet 和 GrowingNet 组成了 NeuralHDHair 的核心。具体来说,这项研究的主要贡献包括:

- 介绍了一种新颖的全自动单目毛发建模框架,其性能明显优于现有的 SOTA 方法;

- 介绍了一个从粗到细的毛发建模神经网络(IRHairNet) ,使用一个新颖的 voxel-aligned 隐函数和一个亮度映射来丰富高质量毛发建模的局部细节;

- 提出了一种基于局部隐函数的新型头发生长络(GrowingNet) ,可以高效地生成任意分辨率的头发丝模型,这种网络比以前的方法的速度实现了一定数量级的提升。

方法

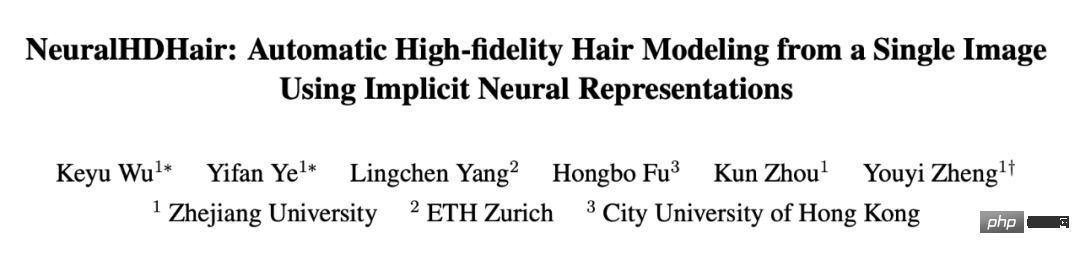

图 2 展示了 NeuralHDHair 的 pipeline。对于人像图像,首先计算其 2D 方向图,并提取其亮度图。此外,自动将它们对齐到相同的半身参考模型,以获得半身像深度图。然后,这三个图随后被反馈到 IRHairNet。

- IRHairNet 设计用于从单个图像生成高分辨率 3D 头发几何特征。这个网络的输入包括一个 2D 定向图、一个亮度图和一个拟合的半身深度图,这些都是从输入的人像图中得到的。输出是一个 3D 方向字段,其中每个体素内包含一个局部生长方向,以及一个 3D 占用字段,其中每个体素表示发丝通过 (1) 或不通过(0)。

- GrowingNet 设计用于从 IRHairNet 估计的 3D 定向场和 3D 占用字段高效生成一个完整的头发丝模型 ,其中 3D 占用字段是用来限制头发的生长区域。

更多方法细节可参考原论文内容。

实验

在这一部分,研究者通过消融研究评估了每个算法组件的有效性和必要性 (第 4.1 节),然后将本文方法与当前的 SOTA(第 4.2 节) 进行比较。实施细节和更多的实验结果可以在补充材料中找到。

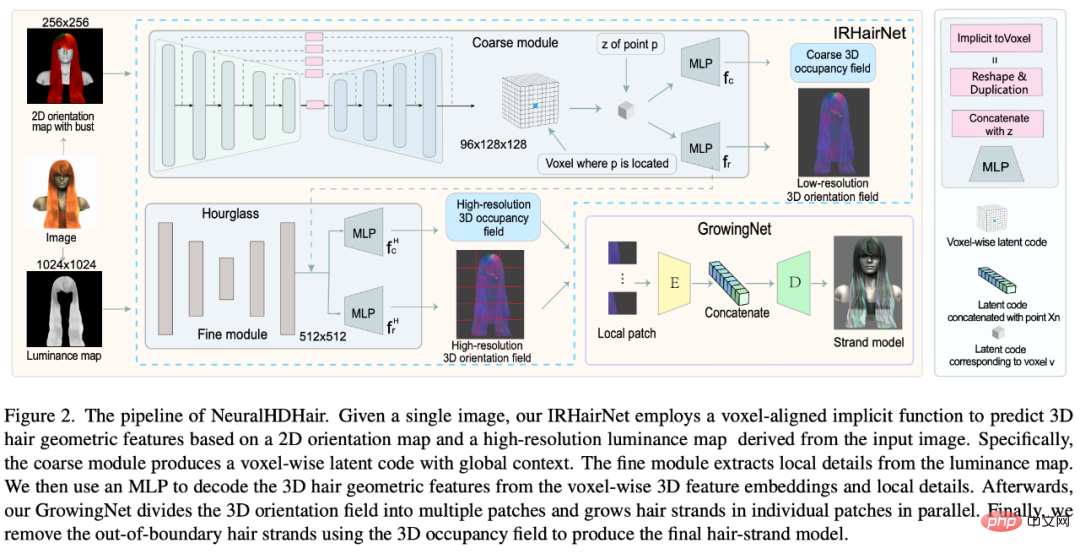

消融實驗

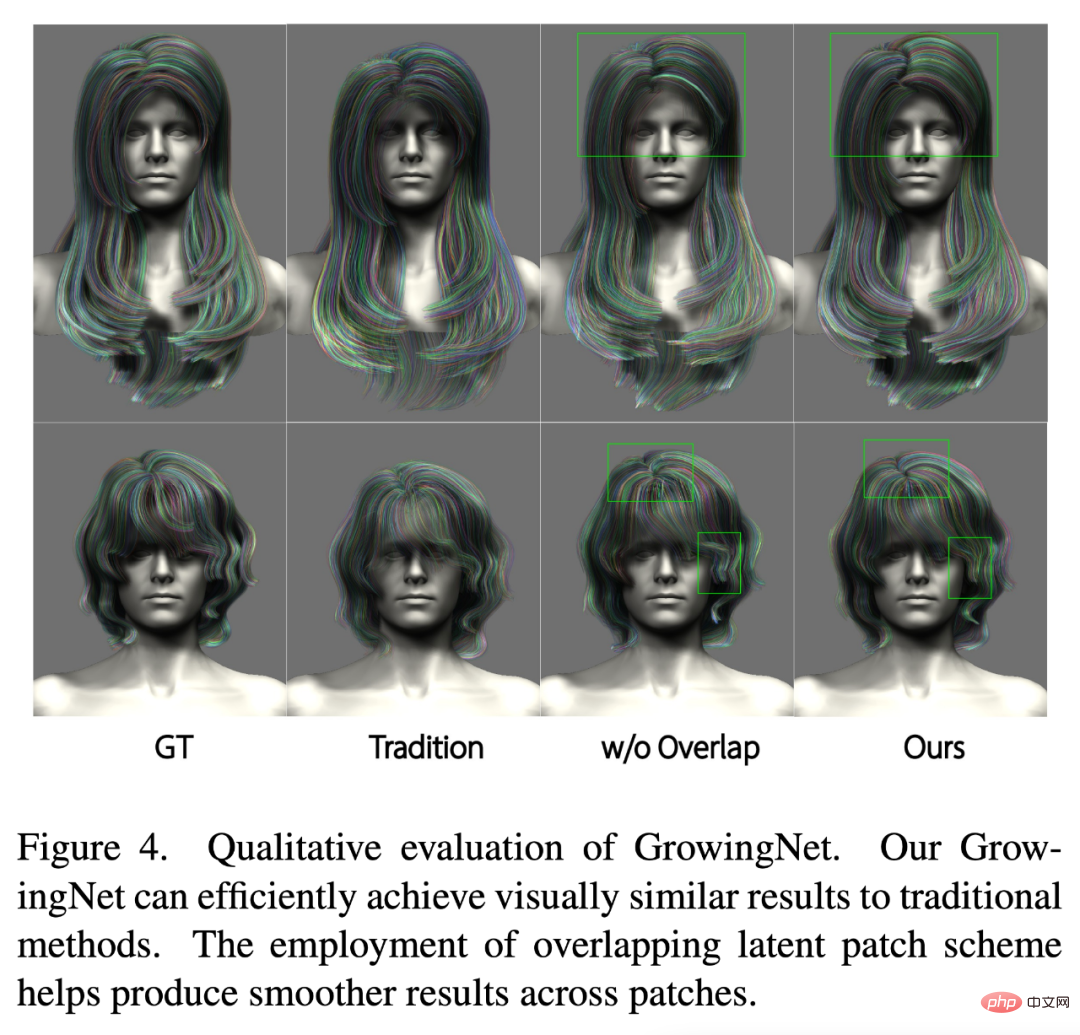

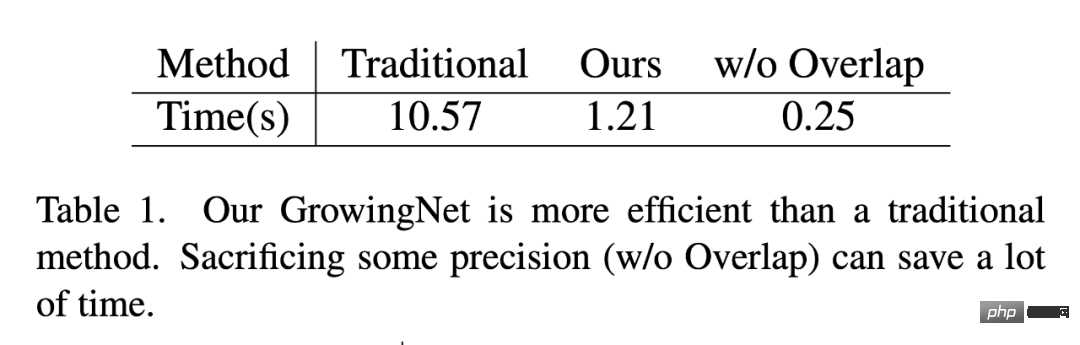

研究者從定性和定量的角度評估了 GrowingNet 的保真度和效率。首先對合成資料進行三組實驗:1)傳統的頭髮生長演算法,2)沒有重疊潛在 patch 方案的 GrowingNet,3)本文的完整模型。

如圖 4 和表 1 所示,與傳統的頭髮生長演算法相比,本文的 GrowingNet 在時間消耗上具有明顯的優勢,同時在視覺品質上保持了相同的生長性能。此外,透過比較圖4 的第三列和第四列,可以看到,如果沒有重疊潛在patch 方案,patch 邊界處的髮絲可能是不連續的,當髮絲的生長方向急劇變化時,這個問題就更加嚴重。不過值得注意的是,這種方案以略微降低精度為代價,大大提高了效率,提高效率對於其方便、高效地應用於人體數位化是具有重要意義的。

與SOTA 方法比較

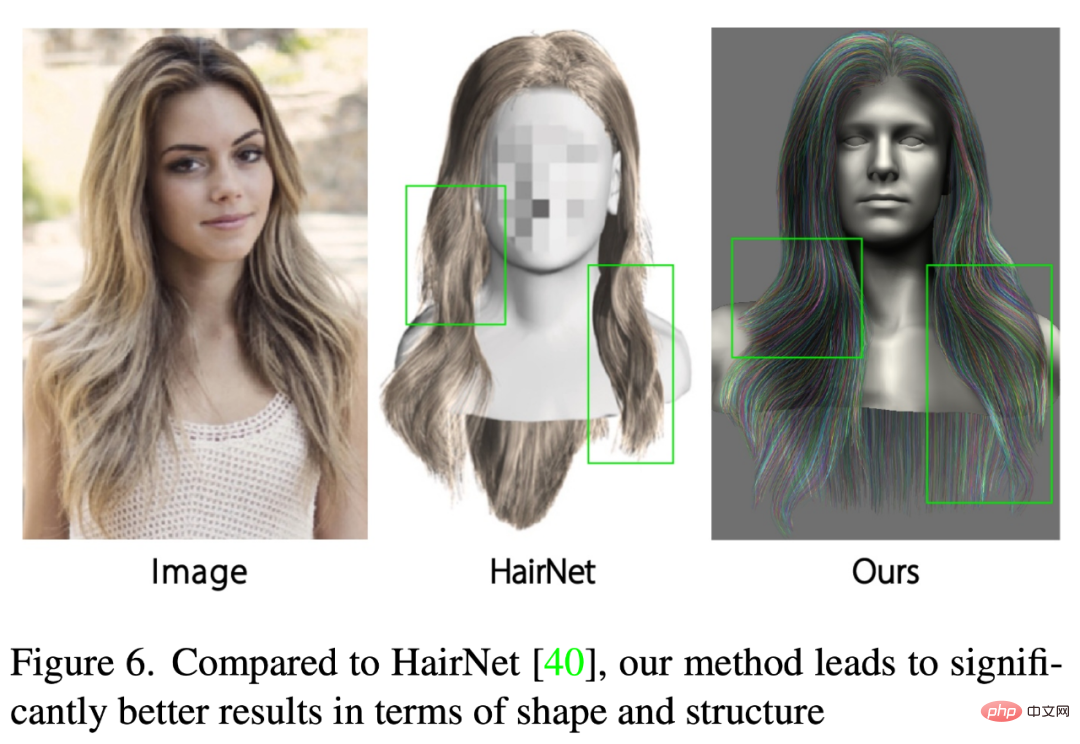

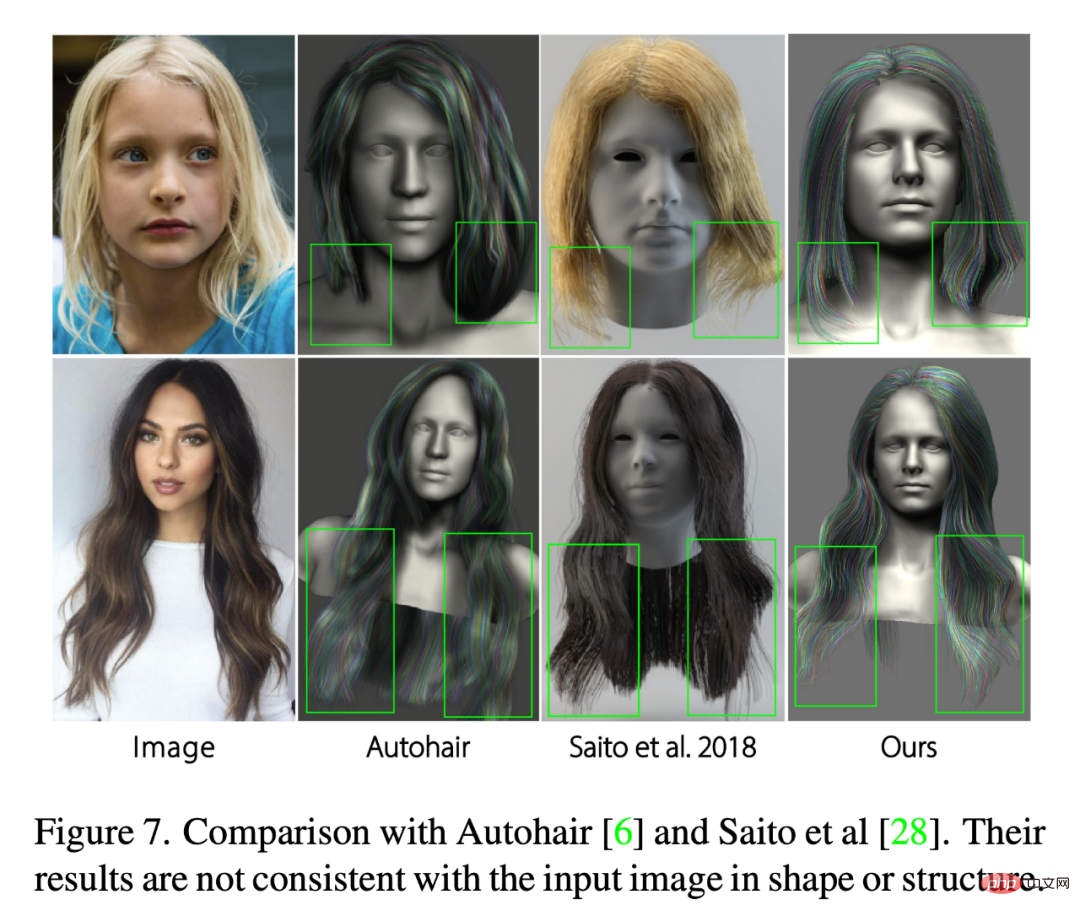

為了評估NeuralHDHair 的性能,研究者將其與一些SOTA 方法[6,28,30,36,40] 進行了比較。其中 Autohair 是基於數據驅動的方法進行頭髮合成,而 HairNet [40]忽略頭髮生長過程來實現端到端的頭髮建模。相較之下,[28,36]執行一個兩步驟策略,首先估計一個 3D 方向場,然後從中合成髮絲。 PIFuHD [30]是一種基於粗到細策略的單眼高解析度 3D 建模方法,可用於 3D 頭髮建模。

如圖 6 所示,HairNet 的結果看起來差強人意,但局部的細節,甚至整體的形狀與輸入影像中的頭髮不一致。這是因為該方法用一種簡單而粗糙的方式來合成頭髮,直接從單一的圖像中恢復無序的髮絲。

這裡也將重建結果與 Autohair[6]和 Saito[28]進行了比較。如圖 7 所示,雖然 Autohair 可以合成真實的結果,但結構上無法很好地匹配輸入影像,因為資料庫包含的髮型有限。另一方面,Saito 的結果缺乏局部細節,形狀與輸入影像不一致。相較之下,本文方法的結果更保持了頭髮的全局結構和局部細節,同時確保了頭髮形狀的一致性。

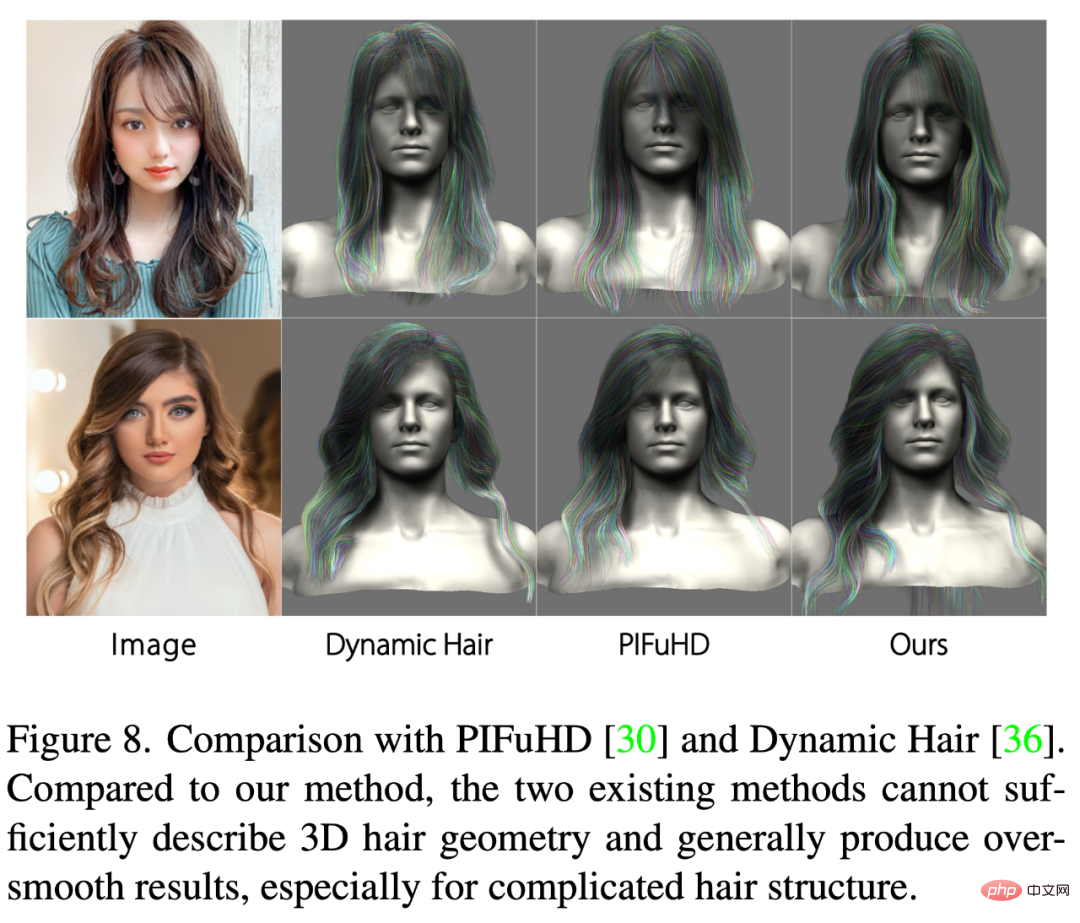

PIFuHD [30]和Dynamic Hair [36]則致力於估計高保真度的3D 頭髮幾何特徵,以產生真實的髮絲模型。圖 8 展示了兩個代表性的比較結果。可以看出,PIFuHD 中採用的像素級隱函數無法充分描繪複雜的頭髮,導致結果過於光滑,沒有局部細節,甚至沒有合理的全局結構。 Dynamic Hair 可以用較少的細節產生更合理的結果,而且其結果中的頭髮生長趨勢可以很好地匹配輸入圖像,但許多局部結構細節 (例如層次結構) 無法捕獲,特別是對於複雜的髮型。相較之下,本文的方法可以適應不同的髮型,甚至是極端複雜的結構,並充分利用全局特徵和局部細節,產生高保真度、高解析度的具有更多細節的 3D 頭髮模型。

以上是真的有這麼絲滑:3D頭髮建模新方法NeuralHDHair,浙大、ETH Zurich、CityU聯合出品的詳細內容。更多資訊請關注PHP中文網其他相關文章!