2021 年是自然語言處理(NLP)和機器學習(ML)非常高產的一年,現在是時候統計去年 NLP 和 ML 領域的論文了。

來自劍橋大學機器學習和自然語言處理的研究員MAREK REI 總結分析了2021 年經典論文,並歸納了2021 年ML 和NLP 出版物的統計數據,他對人工智慧產業的主要會議和期刊進行了分析,它們包括ACL、EMNLP、NAACL、EACL、CoNLL、TACL、CL、NeurIPS、AAAI、ICLR、 ICML。

論文的分析是使用一系列自動化工具完成的,可能並不完美,會存在一些紕漏和錯誤。出於某些原因,一些作者開始以模糊的形式發布他們的論文,以防止任何形式的內容複製或自動提取內容,分析過程排除了這些論文。

現在我們來看看 MAREK REI 統計結果。

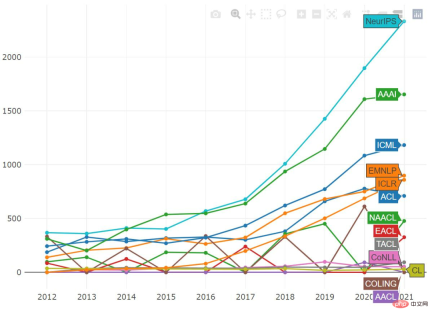

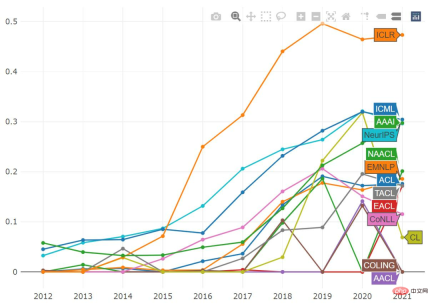

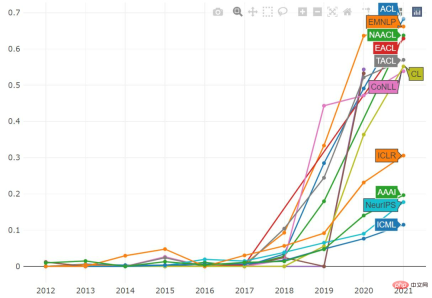

以學術會議統計數據

大多數會議的投稿量不斷上升並打破紀錄。 ACL 似乎是個例外, AAAI 幾乎趨於平穩,而 NeurIPS 仍保持穩定成長。

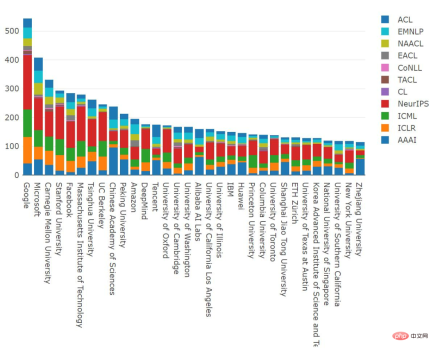

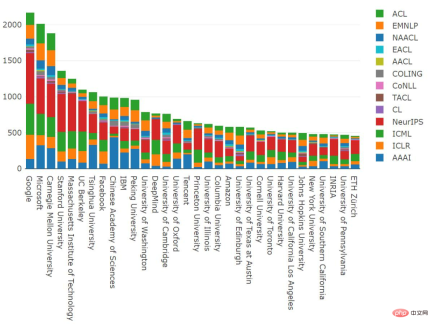

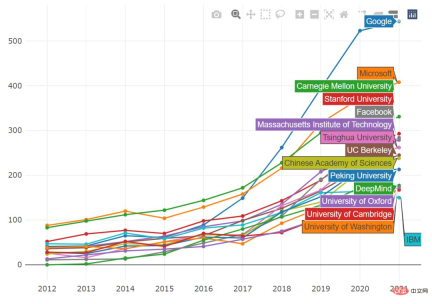

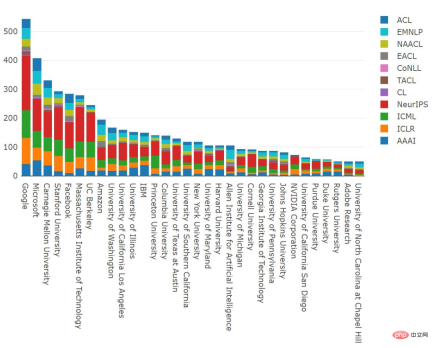

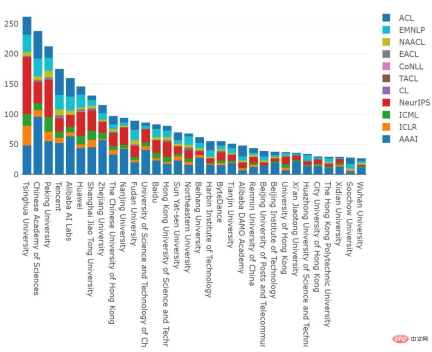

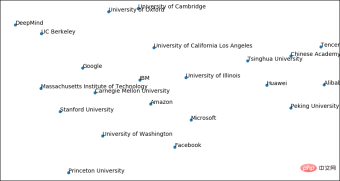

以機構統計

#2021 發表論文數斷層式領先的研究機構當屬谷歌;微軟排名第二;CMU、史丹佛大學、Meta 和MIT 排名緊隨其後,清華大學位居第七。微軟、CAS、亞馬遜、騰訊、劍橋、華盛頓和阿里巴巴在 NLP 會議上擁有相當大比例的論文脫穎而出,而其他頂級組織似乎主要關注 ML 領域。

從2012-2021 年的數據來看,Google發表了2170 篇論文位居第一,超過了微軟發表的2013 篇論文。 CMU 發表了 1881 篇論文,排名第三。

大多數機構也持續增加其年度出版數量。谷歌發表論文數量以前呈線性增長,現在這一趨勢有所緩解,但仍然比以前發表的論文多;CMU 去年有一個平台期,但今年已經彌補了這一點;IBM 似乎是唯一一家發表論文略有下滑的機構。

以作者統計

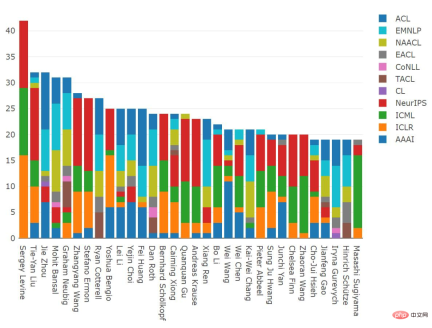

接下來,讓我們來看看2021年發表論文最多的研究人員。 Sergey Levine(加州大學柏克萊分校電機工程與電腦科學系助理教授)發表了42 篇論文,排名第一;劉鐵岩(微軟)、周杰(清華大學)、Mohit Bansal(北卡羅來納大學教堂山分校)、Graham Neubig(CMU)發表論文數量排名也比較前。

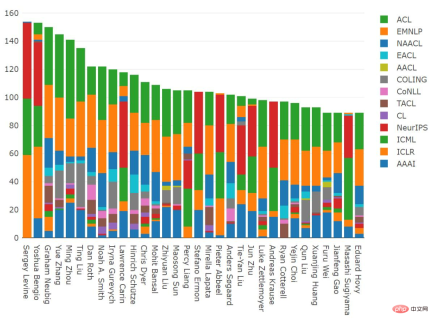

綜觀2012-2021 年,Sergey Levine 發表的論文位居榜首,去年他排名第六,今年一躍排名第一;Yoshua Bengio(蒙特利爾)、Graham Neubig (CMU)、張岳(西湖大學)、周明(創新工場首席科學家)、 Ting Liu (哈爾濱工業大學) 等人發表論文數量排名也比較靠前。

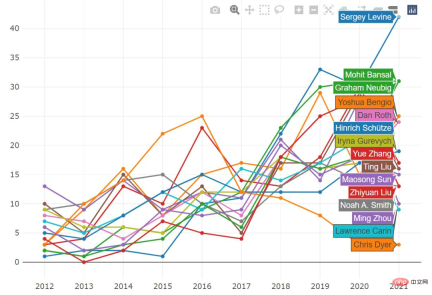

Sergey Levine 以相當大的優勢創造了新的記錄;Mohit Bansal 的論文數量也大幅增加,2021年發表了31 篇論文,與Graham Neubig 持平;Yoshua Bengio 的論文數量在2020 年有所減少,但現在又上升了。

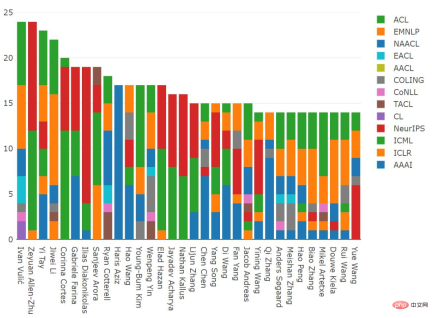

以第一作者發表論文統計

發表論文數量最多的研究者通常是博士後研究員和指導教授。相較之下,以第一作者身份發表論文較多的通常是從事實際研究的人。

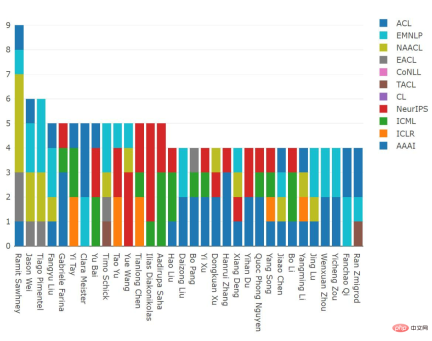

Ramit Sawhney(Tower Research Capital 技術總監)在2021 年發表了9 篇有影響力的論文,Jason Wei(Google)、Tiago Pimentel (劍橋大學博士生)分別發表了6 篇比較有影響力的論文。

從2012-2021 年分佈來看,Ivan Vulić (劍橋大學)和Zeyuan Allen-Zhu(微軟)都以第一作者身份發表了24 篇比較有影響力的論文,並列第一;Yi Tay (Google)和李紀為(香儂科技)排名第二,分別以第一作者身份發表了23 篇和22 篇論文比較有影響力的論文;Ilias Diakonikolas (威斯康辛大學麥迪遜分校)以第一作者身份發表了15 篇NeurIPS 論文。

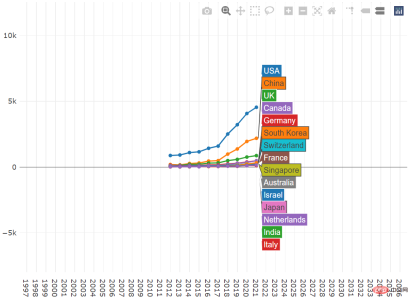

以國家統計

2021 年各國出版數量,美國出版品數量最多,中國和英國分別位列第2、第3。在美國和英國,NeurIPS 所佔比例最大,而 AAAI 在中國佔比最大。

縱座標由上到下分別為500、1000、1500、2000、2500,依次類別推

縱座標由上到下分別為500、1000、1500、2000、2500,依次類別推

#幾乎所有排名靠前的國家都在繼續增加其出版物數量,並在2021 年創造了新的記錄。對美國來說,這一成長是最大的,進一步擴大了領先優勢。

在美國,Google、微軟和 CMU 再次位居出版數量之首。

在中國,清華大學、中國科學院和北京大學在 2021 年發表的論文最多。

以主題相關度統計

透過視覺化得出,這些組織主要是根據地理位置的接近程度聚集在一起的,公司位於中間。

我們也可以將作者視覺化,不過這種視覺化有些難以理解。

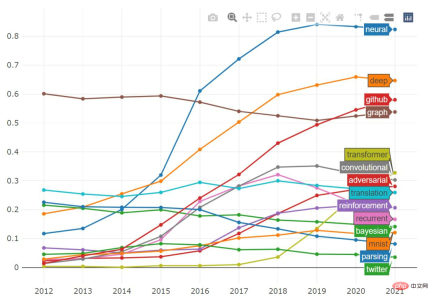

以關鍵字統計

我們也可以繪製包含特定關鍵詞的論文比例,並追蹤這一比例隨時間的變化。

「neural」一詞似乎有輕微的下降趨勢,雖然你仍可以在 80% 的論文中見到它。同時,「recurrent」和「convolutional」的比例也在下降,而「transformer」一詞出現在了 30% 以上的論文中。

如果單看「adversarial」一詞,我們會發現它在 ICLR 中很常見,幾乎一半的論文都提到了它。 ICML 和 NeurIPS 中的「adversarial」比例似乎之前已經達到頂峰,而 AAAI 還沒有。

在過去的幾年裡,「transformer」一詞變得非常流行。它在 NLP 論文中應用尤其廣泛,超過 50% 的已發表論文都包含它,在所有的 ML 會議中,它的受歡迎程度也在穩步上升。

以上是2021年ML與NLP學術統計:Google斷層第一,強化學習大牛Sergey Levine位居榜首的詳細內容。更多資訊請關注PHP中文網其他相關文章!

Kaggle Grandmasters使用的頂級Python圖書館Apr 17, 2025 am 10:03 AM

Kaggle Grandmasters使用的頂級Python圖書館Apr 17, 2025 am 10:03 AM解鎖Kaggle Grandmasters的秘密:頂級Python圖書館揭示了 Kaggle是數據科學競賽的主要平台,擁有精選的精英表演者:Kaggle Grandmasters。 這些人一貫提供Innova

AI PC會改變您的工作場所的10種方法-Analytics VidhyaApr 17, 2025 am 09:59 AM

AI PC會改變您的工作場所的10種方法-Analytics VidhyaApr 17, 2025 am 09:59 AM工作的未來:AI PC將如何徹底改變工作場所 人工智能(AI)集成到個人計算機(AI PC)中代表了工作場所技術的重大飛躍。 AI PC,定義為AI的融合

如何在Excel中冷凍窗格?Apr 17, 2025 am 09:56 AM

如何在Excel中冷凍窗格?Apr 17, 2025 am 09:56 AMExcel凍結窗格功能詳解:高效處理大型數據集 Microsoft Excel是組織和分析數據的優秀工具之一,而“凍結窗格”功能更是其一大亮點。此功能允許您固定特定行或列,使其在瀏覽其餘電子表格時保持可見,從而簡化數據監控和比較。本文將深入探討Excel凍結窗格功能的使用方法,並提供一些實用技巧和示例。 功能概述 Excel的凍結窗格功能可在滾動瀏覽大型數據集時,保持特定行或列可見,方便數據監控和比較。 提升導航效率,保持標題可見,簡化大型電子表格中的數據比較。 提供通過“視圖”選項卡和“凍

Neo4J與亞馬遜海王星:數據工程中的圖形數據庫Apr 17, 2025 am 09:52 AM

Neo4J與亞馬遜海王星:數據工程中的圖形數據庫Apr 17, 2025 am 09:52 AM導航互連數據的複雜性:Neo4J與亞馬遜海王星 在當今數據豐富的世界中,有效管理複雜的互連信息至關重要。儘管傳統數據庫仍然相關,但他們經常與HI鬥爭

META SAM 2:建築,應用和局限性-Analytics VidhyaApr 17, 2025 am 09:40 AM

META SAM 2:建築,應用和局限性-Analytics VidhyaApr 17, 2025 am 09:40 AMMeta的細分段的任何模型2(SAM-2):實時圖像和視頻細分方面的巨大飛躍 Meta再次通過SAM-2推動了人工智能的界限,SAM-2是計算機視覺的開創性進步

人工智能工作流程和消費者體驗的數據策略Apr 17, 2025 am 09:39 AM

人工智能工作流程和消費者體驗的數據策略Apr 17, 2025 am 09:39 AM通過AI增強數字消費者體驗:一種數據驅動的方法 數字景觀具有激烈的競爭力。 本文探討了人工智能(AI)如何顯著改善數字平台上的消費者體驗。我們會考試

穩定擴散中的位置編碼是什麼? - 分析VidhyaApr 17, 2025 am 09:34 AM

穩定擴散中的位置編碼是什麼? - 分析VidhyaApr 17, 2025 am 09:34 AM穩定的擴散:在文本到圖像中揭示位置編碼的力量 想像一下,從簡單的文本描述中產生令人嘆為觀止的高分辨率圖像。 這是穩定擴散的力量,一種尖端的文本對圖像模型

什麼是SQL中的模式?組件,優勢等Apr 17, 2025 am 09:33 AM

什麼是SQL中的模式?組件,優勢等Apr 17, 2025 am 09:33 AM了解SQL模式:綜合指南 想像一下為新建築設計藍圖。 就像建築師創建詳細的計劃一樣,SQL模式也提供了用於在數據庫中組織數據的藍圖。 本指南說明了什麼SQL模式

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

AI Hentai Generator

免費產生 AI 無盡。

熱門文章

熱工具

禪工作室 13.0.1

強大的PHP整合開發環境

記事本++7.3.1

好用且免費的程式碼編輯器

Safe Exam Browser

Safe Exam Browser是一個安全的瀏覽器環境,安全地進行線上考試。該軟體將任何電腦變成一個安全的工作站。它控制對任何實用工具的訪問,並防止學生使用未經授權的資源。

WebStorm Mac版

好用的JavaScript開發工具

mPDF

mPDF是一個PHP庫,可以從UTF-8編碼的HTML產生PDF檔案。原作者Ian Back編寫mPDF以從他的網站上「即時」輸出PDF文件,並處理不同的語言。與原始腳本如HTML2FPDF相比,它的速度較慢,並且在使用Unicode字體時產生的檔案較大,但支援CSS樣式等,並進行了大量增強。支援幾乎所有語言,包括RTL(阿拉伯語和希伯來語)和CJK(中日韓)。支援嵌套的區塊級元素(如P、DIV),