Meta最新影像生成工具火了,竟能把夢境畫成現實!

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB轉載

- 2023-04-08 17:11:041474瀏覽

AI在畫畫這塊兒,已經拿捏的死死的。

近日,Meta也整了一個AI「畫家」-Make-A-Scene。

還以為只是用文字生成畫作就這麼簡單嗎?

要知道,光是靠文字描述還有時候會「翻車」,就例如Google前段時間推出的「藝術家」Parti。

「一個沒有香蕉的盤子,旁邊有一個沒有柳橙汁的玻璃杯。」

這次,Make-A-Scene可以透過文字描述,再加上一張草圖,就能產生你想要的樣子。

構圖上下、左右、大小、形狀等各種元素都由你說了算。

就連LeCun也出來力推自家的產品了,創意就不用說了,關鍵還「可控」!

Make-A-Scene有多厲害,不如一起來看看。

Meta的神筆馬良

光說不練,假把式!

我們這就來看看,人們究竟會怎麼用Make-A-Scene,來實現他們的想像力。

研究團隊將和知名的人工智慧藝術家一起來進行Make-A-Scene的示範環節。

藝術家團隊可謂陣容強大,包括Sofia Crespo、Scott Eaton、Alexander Reben和Refik Anadol等等,這些大師都有第一手的應用生成性人工智慧的使用經驗。

研發團隊讓這些藝術家們用Make-A-Scene作為創作過程的一部分,邊使用邊回饋。

接下來,我們就來欣賞大師們用Make-A-Scene創作出的作品吧。

例如,Sofia Crespo是一位專注於自然和技術交融的藝術家。她很愛想像從來沒有存在過的人造生命形式感,所以她使用Make-A-Scene的素描和文字提示功能,創造了全新的「混合生物」。

例如,花形的水母。

Crespo利用它的自由繪畫功能,可以快速迭代新的想法。她表示,Make-A-Scene將有助於藝術家更好地發揮創造力,能讓藝術家使用更直覺的介面作畫。

(花型的水母)

Scott Eaton是藝術家、教育家和創意科技專家,他的工作是調研究當代現狀和技術之間的關係。

他用Make-A-Scene作為一種構成場景的方式,透過不同的提示來探索場景的變化,例如用類似「沙漠中沉沒和腐爛的摩天大樓」這種主題來強調氣候危機。

(沙漠中的摩天大樓)

Alexander Reben是藝術家、研究人員和機器人專家。

他認為,如果能對輸出有更多的掌控,確實有助於表達自己的藝術意圖。他將這些工具融入了他正在進行的系列作品之中。

而對於媒體藝術家和導演Refik Anadol來說,這個工具是一種促進想像力發展、更好地探索未知領域的方式。

其實,這個原型工具不只是為對藝術有興趣的人準備的。

研究團隊相信,Make-A-Scene可以幫助任何人更好地表達自己,包括那些沒什麼藝術細胞的人。

作為開始,研究團隊向美達公司的員工提供了一部分使用權。他們正在測試並提供關於他們使用Make-A-Scene經驗的回饋。

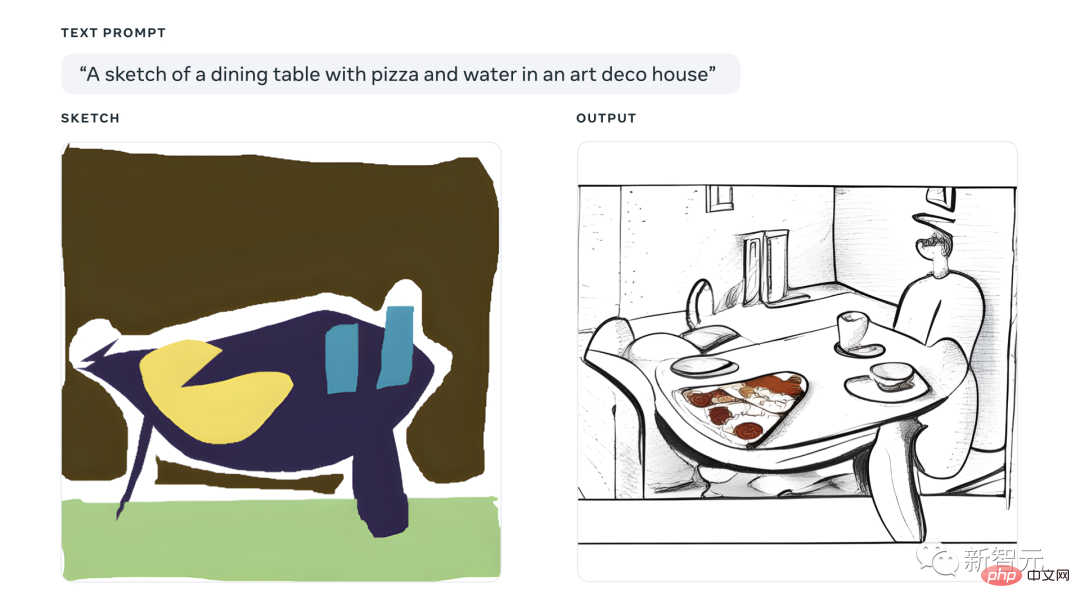

美達公司的專案經理Andy Boyatzis使用Make-A-Scene與他兩歲和四歲的孩子一起創作藝術。他們用俏皮的圖畫把他們的想法和想像力變成了現實。

以下就是他們的作品~

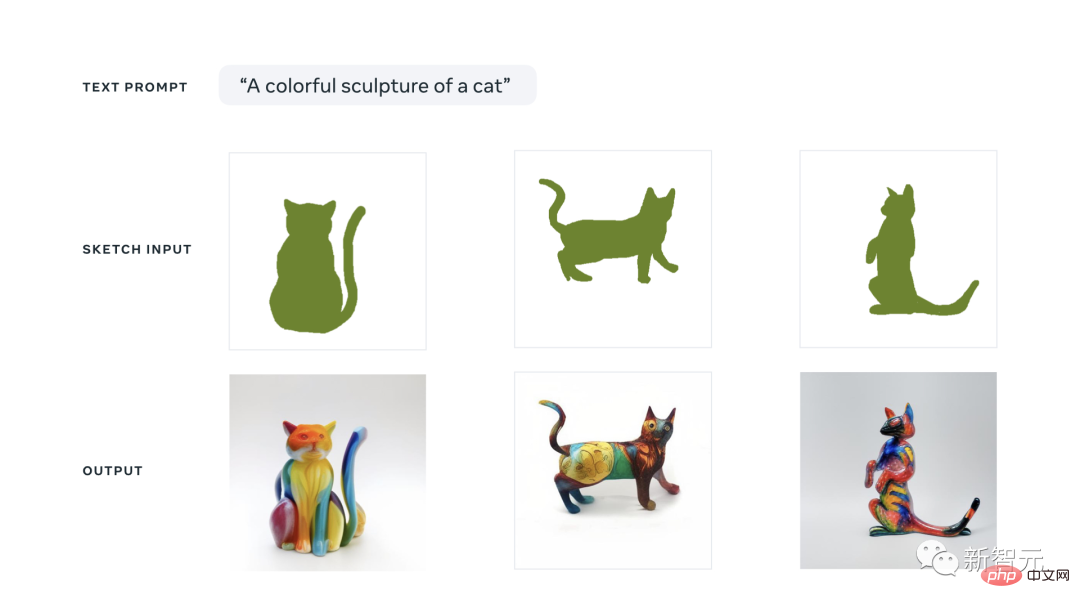

一隻五彩繽紛的雕塑貓~是不是很可愛。但這個色調其實有點不忍直視,像小孩把一大坨橡皮泥瞎揉在一起。

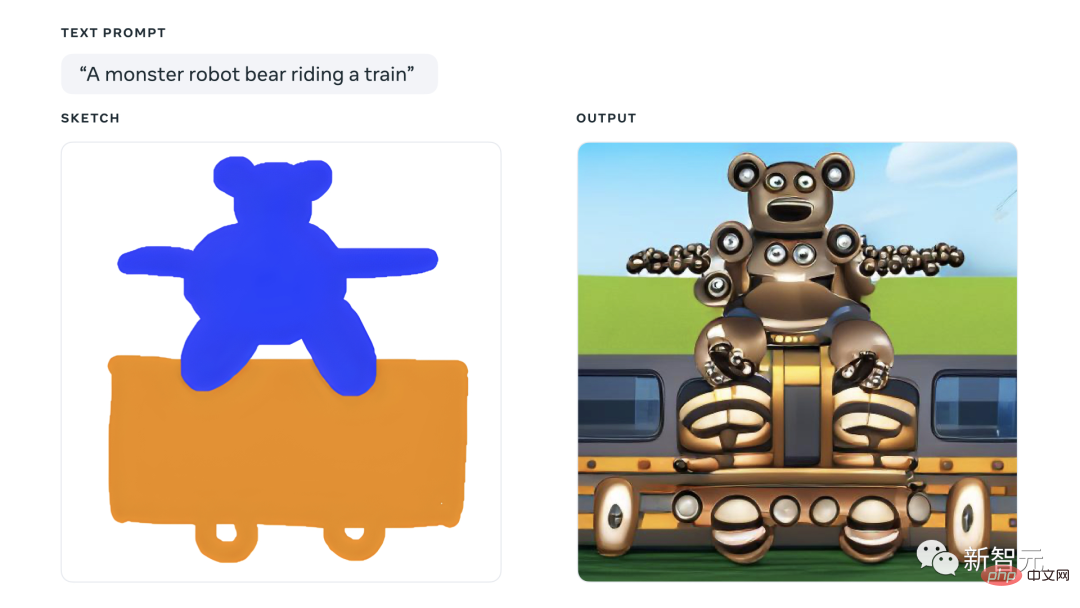

一隻乘坐火車的怪獸熊。說真的,密恐患者抓緊繞行。小編看完這張圖密恐直接竄到頂了。看看這詭異的胳膊,像臉一樣的身子,像眼珠子一樣的輪子...

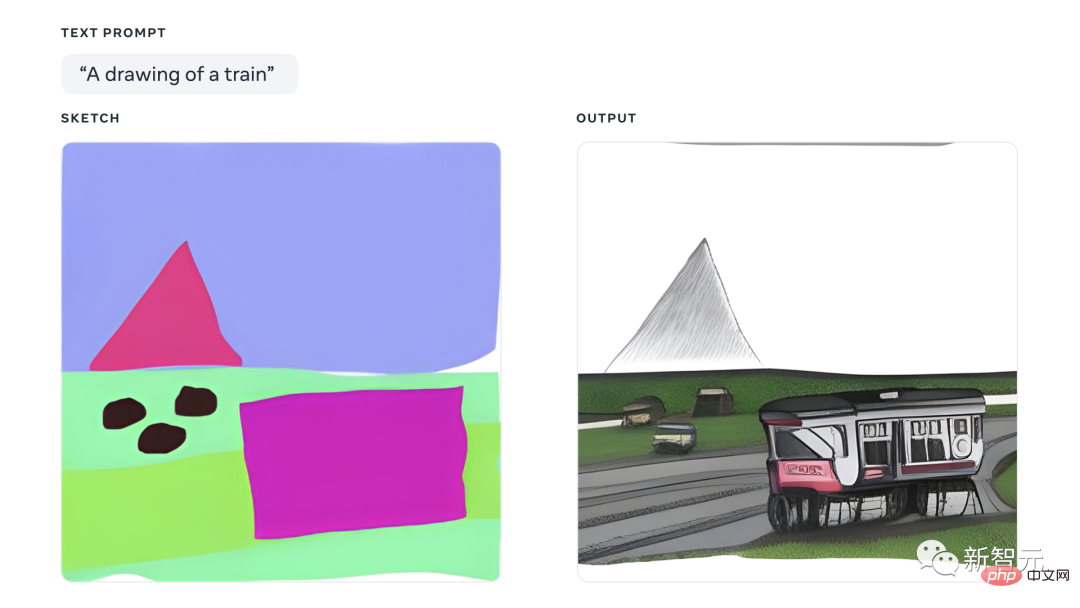

#一座山峰。講道理,這張圖蠻有意境的。但有沒有感覺,遠處的山和近處的小火車壓根不是一個畫風?

背後技術

雖然目前的方法提供了文字和圖像域之間還不錯的轉換,但它們仍然有幾個關鍵問題沒有很好地解決:可控性、人類感知、影像品質。

此模型的方法一定程度提高了結構一致性和影像品質。

整個場景由三個互補的語意分割群組(全景、人類和人臉)組成。

透過組合三個擷取的語意分割群組,網路學習產生語意的佈局和條件,產生最終影像。

為了創造場景的token空間,作者們採用了「VQ-SEG」,這是一項對「VQ-VAE」的改進。

在這個實作中,「VQ-SEG」的輸入和輸出都是m個通道。附加通道是分隔不同類別和實例的邊的對應。邊緣通道為同一類別的相鄰實例提供分離,並強調具有高度重要性的稀缺類別。

在訓練「VQ-SEG」網路時,由於每個人臉部分在場景空間中所佔的像素數量相對較少,因此導致了重建場景中代表人臉部分(如眼睛、鼻子、嘴唇、眉毛)的語意分割頻繁減少。

對此,作者們嘗試在分割人臉部分類別的基礎上採用加權二元交叉熵人臉損失,更加突顯人臉部分的重要性。此外,也將人臉部分的邊緣作為上述語意分割邊緣圖的一部分。

作者們採用了在ImageNet資料集上訓練的預訓練VGG網絡,而不是專門的人臉嵌入網絡,並引入了表示重建圖像和真實圖像之間感知差異的特徵匹配損失。

透過使用特徵匹配,為VQ-IMG中的encoder和decoder分別添加額外的上採樣層和下採樣層,便可以將輸出影像的分辨率從256×256進行提高。

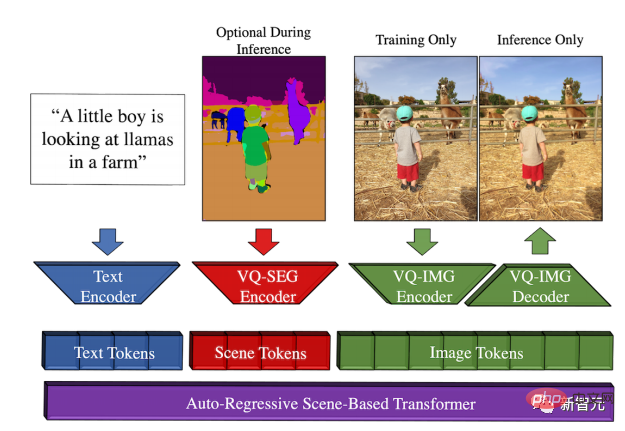

想必大家對Transformer並不陌生,那麼基於場景的Transformer又是什麼呢?

它依賴一個具有三個獨立連續的token空間的自回歸Transformer,即文字、場景和圖像。

token序列由BPE編碼器編碼的文字token、VQ-SEG編碼的場景token以及VQ-IMG編碼或解碼的圖像token組成。

在訓練基於場景的Transformer之前,每個編碼好的token序列都對應一個[文本,場景,圖像]元組,使用相應的encoder提取。

此外,作者們也採用了無分類器引導,即將無條件樣本引導到條件樣本的過程。

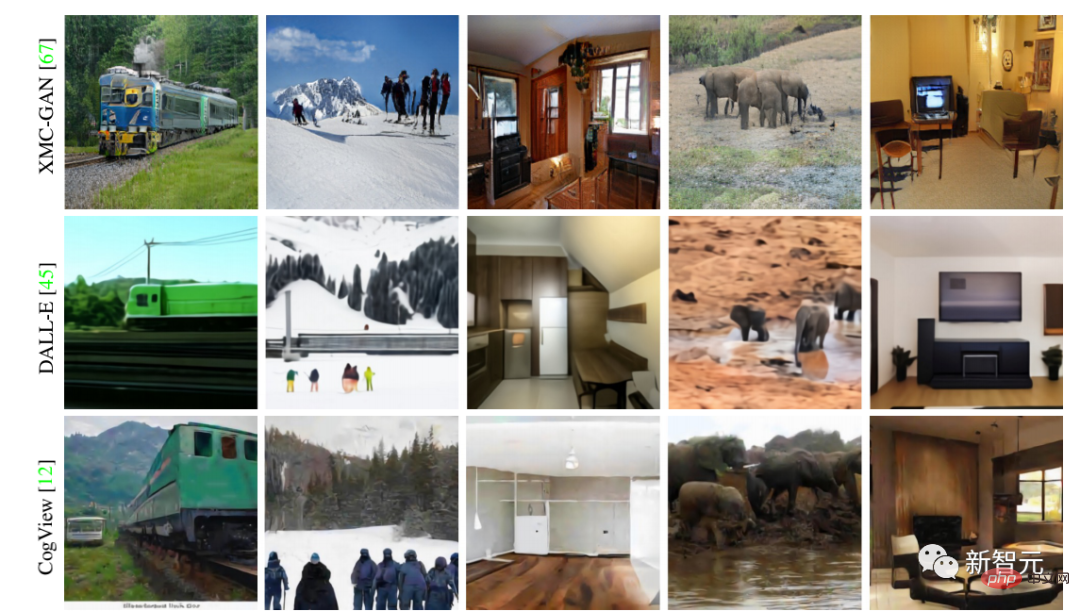

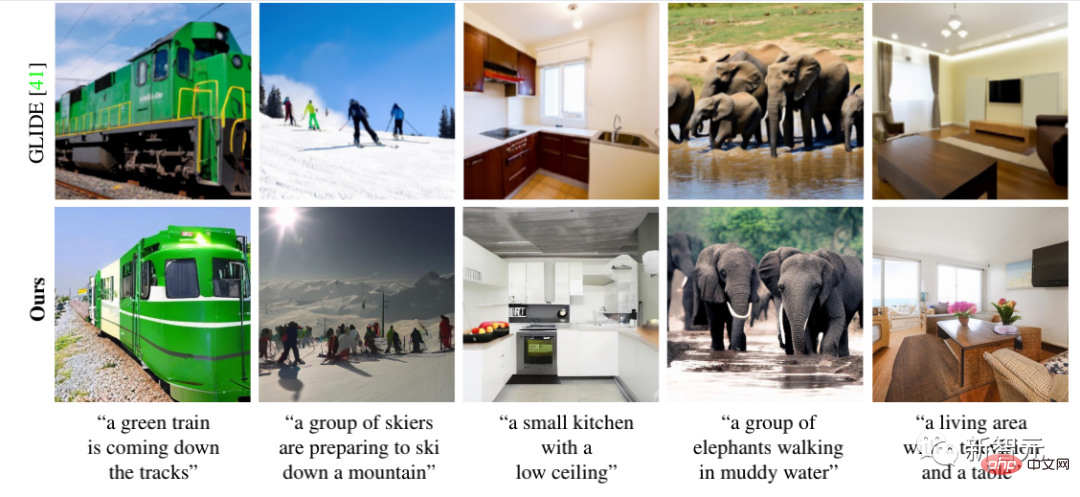

該模型實現了SOTA結果。具體看一下和之前方法的效果對比

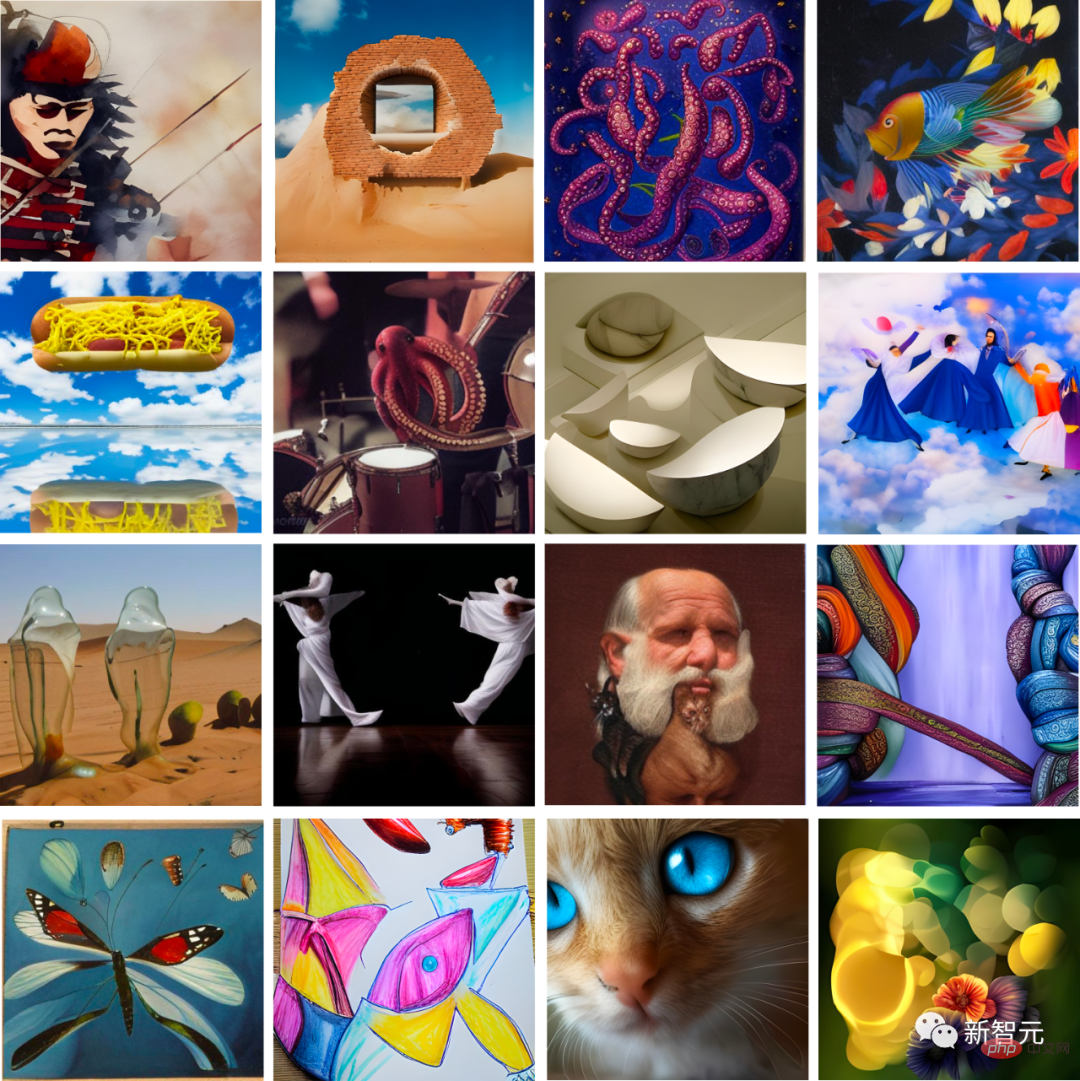

現在,研究人員也將Make-A-Scene整合了一個超分辨率網絡,就可以產生2048x2048、4倍解析度的影像。

如下:

其實,與其他生成AI模型一樣,Make-A-Scene透過對數百萬個範例影像進行訓練來學習視覺和文本之間的關係。

不可否認的是,訓練資料中反映的偏差會影響這些模型的輸出。

正如研究者所指出的那樣,Make-A-Scene還有很多地方有待提高。

以上是Meta最新影像生成工具火了,竟能把夢境畫成現實!的詳細內容。更多資訊請關注PHP中文網其他相關文章!