谷歌團隊推出新Transformer,優化全景分割方案

- PHPz轉載

- 2023-04-08 13:41:031533瀏覽

最近,GoogleAI團隊受Transformer和DETR的啟發提出了一種使用Mask Transformer進行全景分割的端到端解決方案。

全名為end-to-end solution for panoptic segmentation with mask transformers,主要用於產生分割MaskTransformer架構的擴充。

此解決方案採用像素路徑(由卷積神經網路或視覺Transformer組成)提取像素特徵,記憶體路徑(由Transformer解碼器模組組成)提取記憶體特徵,以及雙路徑Transformer用於像素特徵和記憶體之間的交互特徵。

然而,利用交叉注意力的雙路徑Transformer最初是為語言任務設計的,它的輸入序列由幾百個單字構成。

而對視覺任務尤其是分割問題來說,其輸入序列由數萬個像素組成,這不僅表明輸入規模的幅度要大得多,而且與語言單字相比也代表了較低級別的嵌入。

全景分割是一個電腦視覺問題,它是現在許多應用程式的核心任務。

它分為語意分割和實例分割兩部分。

語意分割就例如為影像中的每個像素分配語意標籤,例如「人」和「天空」。

而實例分割僅識別和分割圖中的可數對象,如“行人”和“汽車”,並進一步將其劃分為幾個子任務。

每個子任務單獨處理,並應用額外的模組來合併每個子任務階段的結果。

這個過程不僅複雜,而且在處理子任務和整合不同子任務結果時還會引入許多人工設計的先驗。

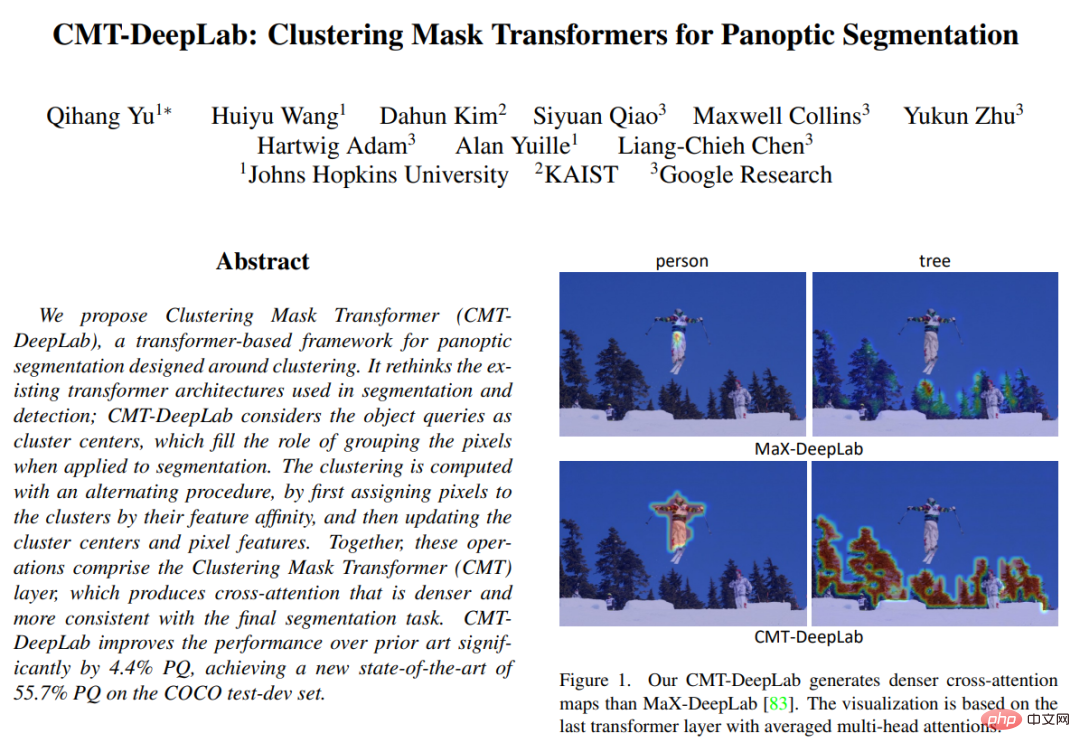

在CVPR 2022 上發表的「CMT-DeepLab: Clustering Mask Transformers for Panoptic Segmentation」中,文章提出從聚類的角度重新解讀並且重新設計交叉注意力cross attention(也就是將相同語意標籤的像素分在同一組),以便更好地適應視覺任務。

CMT-DeepLab 建立在先前最先進的方法 MaX-DeepLab 之上,並採用像素聚類方法來執行交叉注意,從而產生更密集和合理的注意圖。

kMaX-DeepLab 進一步重新設計了交叉注意力,使其更像 k-means 聚類演算法,對激活函數進行了簡單的更改。

結構總覽

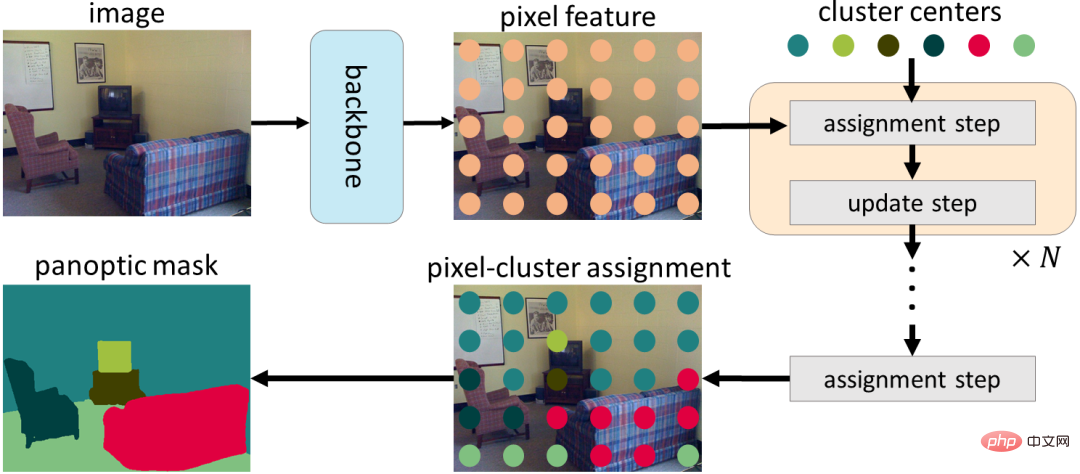

研究人員將從聚類的角度重新解釋,而不是直接將交叉注意力應用於視覺任務而不進行修改。

具體來說,他們注意到Mask Transformer 物件查詢可以被視為叢集中心(旨在將具有相同語義標籤的像素分組)。

交叉注意力的過程類似於k-means 聚類演算法,(1)將像素分配給聚類中心的迭代過程,其中可以將多個像素分配給單一聚類中心,而某些聚類中心可能沒有分配的像素,以及(2)透過平均分配給同一聚類中心的像素來更新聚類中心,如果沒有分配像素,則不會更新聚類中心)。

在CMT-DeepLab和kMaX-DeepLab中,我們從聚類的角度重新制定了交叉注意力,其中包括迭代聚類分配和聚類更新步驟

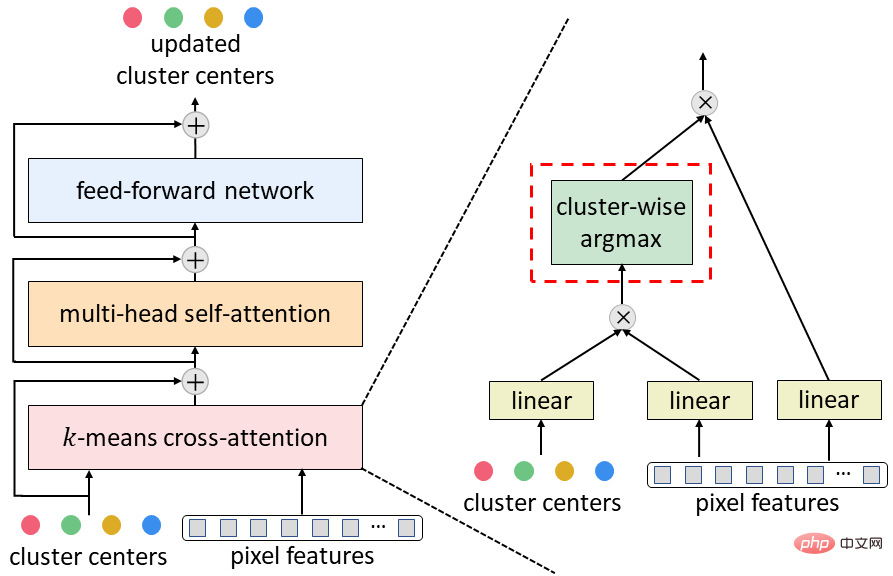

鑑於k-means聚類演算法的流行,在CMT-DeepLab中,他們重新設計了交叉注意力,以便空間方面的softmax操作(即沿圖像空間分辨率應用的softmax 操作),實際上將聚類中心分配給相反,像素是沿著集群中心應用的。

在 kMaX-DeepLab 中,我們進一步將空間方式的 softmax 簡化為集群方式的 argmax(即沿集群中心應用 argmax 操作)。

他們注意到 argmax 操作與 k-means 聚類演算法中使用的硬分配(即一個像素僅分配給一個簇)相同。

从聚类的角度重新构建MaskTransformer的交叉注意力,显著提高了分割性能,并简化了复杂的Masktransformer管道,使其更具可解释性。

首先,使用编码器-解码器结构从输入图像中提取像素特征。然后,使用一组聚类中心对像素进行分组,这些像素会根据聚类分配进一步更新。最后,迭代执行聚类分配和更新步骤,而最后一个分配可直接用作分割预测。

为了将典型的MaskTransformer解码器(由交叉注意力、多头自注意力和前馈网络组成)转换为上文提出的k-means交叉注意力,只需将空间方式的softmax替换为集群方式最大参数。

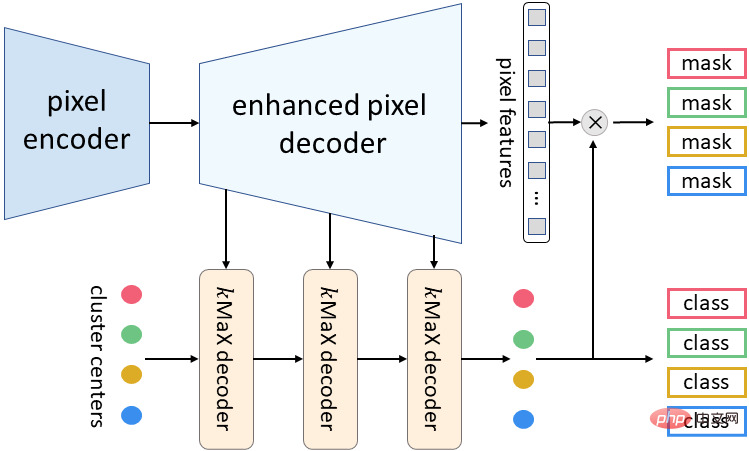

本次提出的 kMaX-DeepLab 的元架构由三个组件组成:像素编码器、增强像素解码器和 kMaX 解码器。

像素编码器是任何网络主干,用于提取图像特征。

增强的像素解码器包括用于增强像素特征的Transformer编码器,以及用于生成更高分辨率特征的上采样层。

一系列 kMaX 解码器将集群中心转换为 (1) Mask嵌入向量,其与像素特征相乘以生成预测Mask,以及 (2) 每个Mask的类预测。

kMaX-DeepLab 的元架构

研究结果

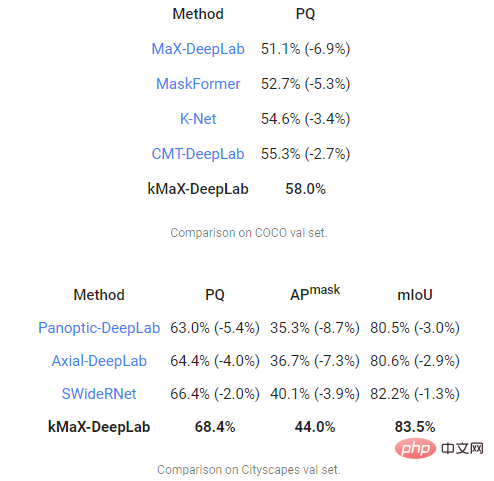

最后,研究小组在两个最具挑战性的全景分割数据集 COCO 和 Cityscapes 上使用全景质量 (PQ) 度量来评估 CMT-DeepLab 和 kMaX-DeepLab,并对比 MaX-DeepLab 和其他最先进的方法。

其中CMT-DeepLab 实现了显著的性能提升,而 kMaX-DeepLab 不仅简化了修改,还进一步提升了,COCO val set 上的 PQ 为 58.0%,PQ 为 68.4%,44.0% Mask平均精度(Mask AP),Cityscapes 验证集上的 83.5% 平均交集比联合(mIoU),没有测试时间增强或使用外部数据集。

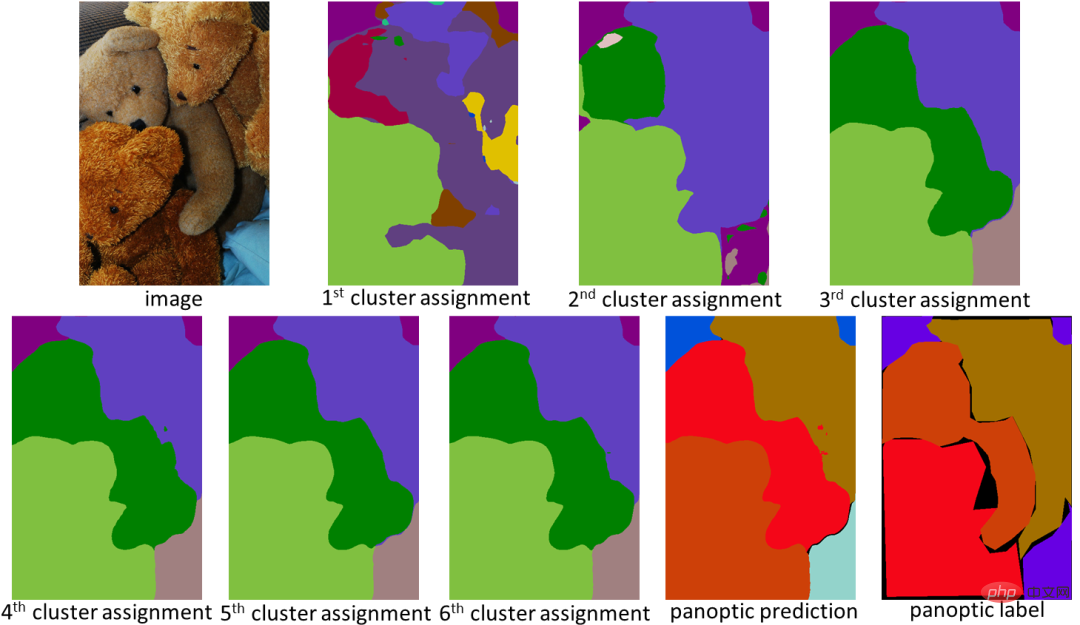

从聚类的角度设计,kMaX-DeepLab 不仅具有更高的性能,而且还可以更合理地可视化注意力图以了解其工作机制。

在下面的示例中,kMaX-DeepLab 迭代地执行聚类分配和更新,从而逐渐提高Mask质量。

kMaX-DeepLab 的注意力图可以直接可视化为全景分割,让模型工作机制更合理

结论

本次研究展示了一种更好地设计视觉任务中的MaskTransformer的方法。

通过简单的修改,CMT-DeepLab 和 kMaX-DeepLab 重新构建了交叉注意力,使其更像一种聚类算法。

因此,所提出的模型在COCO 和 Cityscapes数据集上实现了最先进的性能。

研究团队表示,他们希望 DeepLab2 库中 kMaX-DeepLab 的开源版本有助于未来对专用于视觉Transformer架构设计的研究。

以上是谷歌團隊推出新Transformer,優化全景分割方案的詳細內容。更多資訊請關注PHP中文網其他相關文章!