AIGC發展太快! Meta發布首個基於文字的4D影片合成器:3D遊戲建模師也要下崗了?

- 王林轉載

- 2023-04-08 11:21:15869瀏覽

AI生成模型在過去這段時間裡取了巨大的進展,就圖像領域來說,用戶可以透過輸入自然語言提示來產生圖像(如DALL-E 2,Stable Diffusion) ,也可以在時間維度上擴展產生連續的視訊(如Phenaki),或在空間維度上擴展直接生成3D模型(如Dreamfusion)。

但到目前為止,這些任務仍然處於孤立的研究狀態,彼此之間不存在技術交集。

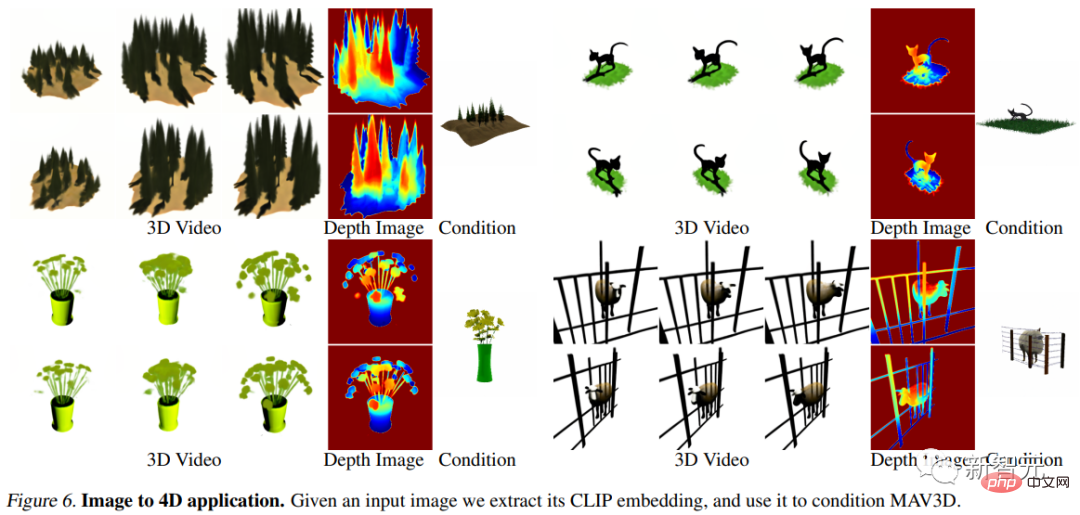

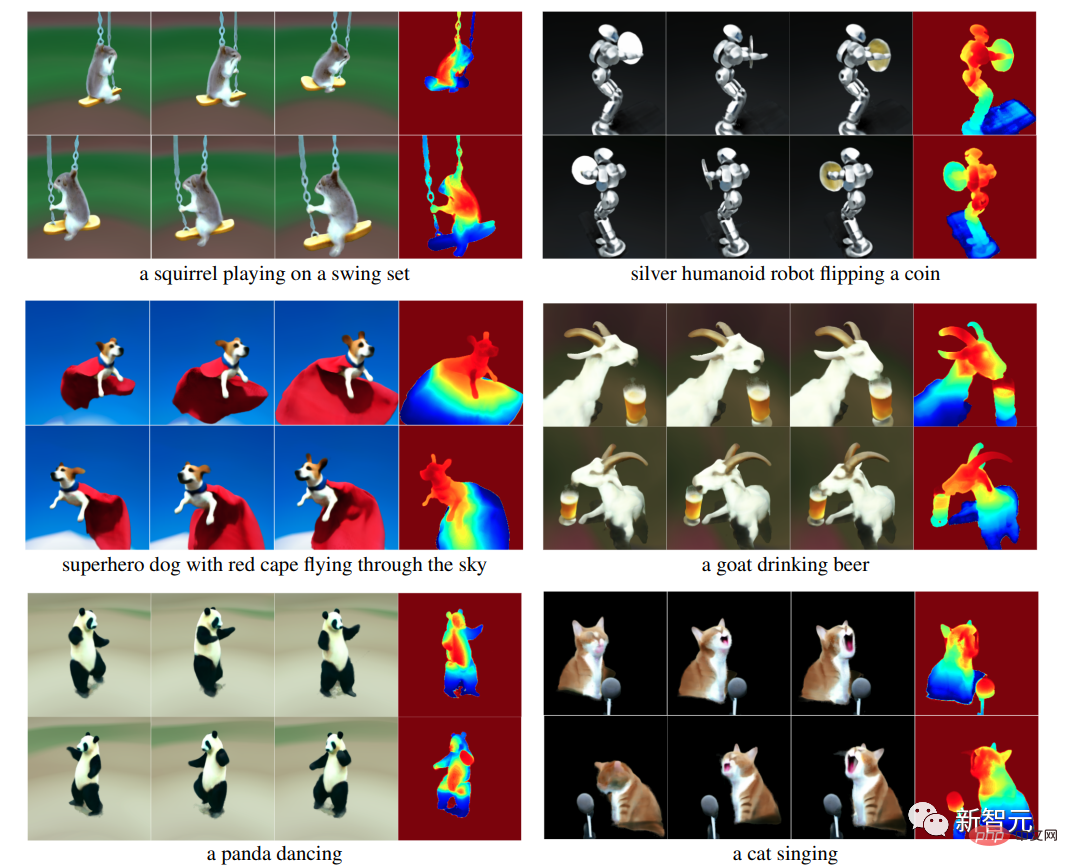

最近Meta AI的研究人員結合了視訊和三維生成模型的優勢,提出了一個全新的文本到四維(三維時間)生成系統MAV3D(MakeA-Video3D ),將自然語言描述作為輸入,並輸出一個動態的三維場景表示,可以從任意的視角進行渲染。

論文連結:https://arxiv.org/abs/2301.11280

專案連結:https://make-a-video3d.github.io/

#MAV3D也是第一個可以根據給定文字描述來產生三維動態場景的模型。

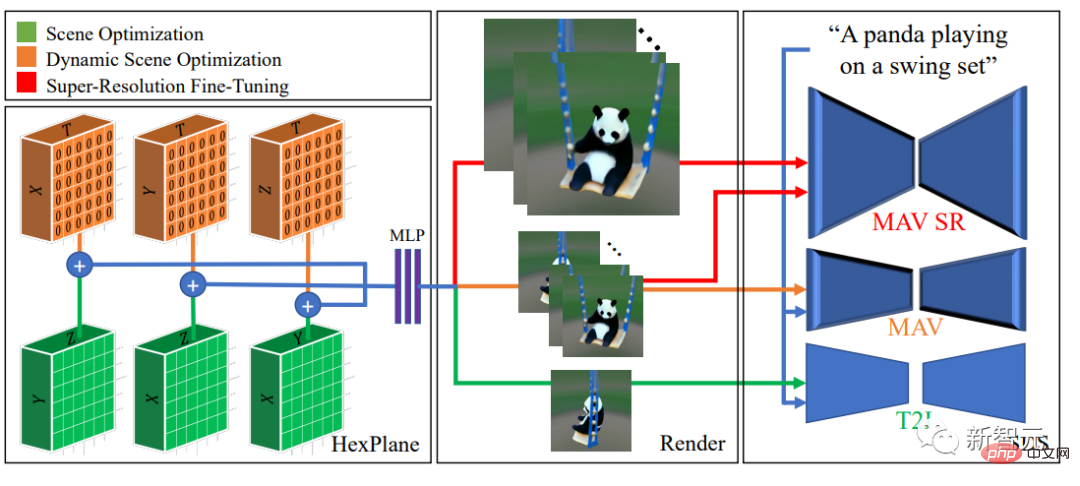

文中提出的方法使用了一個4D 動態神經輻射場(NeRF) ,透過查詢基於文本到視訊(T2V)擴散的模型來優化場景表現、密度和運動一致性,由提供的文字產生的動態視訊輸出可以從任何攝影機的位置和角度觀看,並且可以合成到任意的3D環境中。

此方法可用於為視訊遊戲、視覺效果或增強型和虛擬實境產生3D資產。

與圖像生成和視訊生成任務不同的是,網路上有大量的caption資料可供訓練,但卻連一個現成的4D模型集合都沒有。

柯基打球

##MAV3D的訓練不需要任何3D或4D資料,T2V 模型只需要在文字-影像對和未標記的影片上進行訓練。

在實驗部分,研究人員進行了全面的定量和定性實驗以證明方法的有效性,對先前建立的內部基線有明顯提升。

文本到4D動態場景由於缺乏訓練數據,研究人員為了解決這個任務構想了幾種想法。

一種方法可能是找到一個預先訓練好的二維視訊產生器,並從生成的影片中提煉出一個四維重建。不過從影片中重建可變形物體的形狀仍然是一個非常具有挑戰性的問題,即非剛性運動結構(Non-Rigid Structure from Motion, NRSfM)。

如果給定物體的多個同步視點(multiple simultaneous viewpoints),任務就變得簡單了。雖然多機位設定在真實資料中很少見,但研究人員認為,現有的視訊產生器隱含了生成場景的任意視點模型。

也就是說,可以將視訊產生器作為一個「統計」的多攝影機設定來重建可變形物體的幾何和光度。

MAV3D演算法透過優化動態神經輻射場(NeRF)與將輸入文字解碼成視頻,對物體周圍的隨機視點進行採樣來實現該目的。

直接使用視訊產生器來優化動態NeRF並沒有取得令人滿意的結果,實作過程中還有幾個難題需要攻克:

#1. 需要一個有效的、端到端可學習的動態三維場景表徵;

2. 需要一個有監督學習的資料來源,因為目前並不存在大規模的(文本,4D)對的資料集可供學習;

3. 需要在空間和時間維度上擴展輸出的分辨率,因為4D輸出需要大量的記憶體和運算能力;

MAV3D模型

MAV3D模型基於神經輻射場(NeRFs)的最新工作,結合了高效能(靜態)NeRFs和動態NeRFs中的成果,並將4D場景表示為六個多解析度特徵平面的集合。

為了在沒有相應(文本、4D)資料的情況下監督這種表示,研究人員提出了一個用於動態場景渲染的多階段訓練pipeline,並證明了每個組件在實現高品質結果中的重要性。

一個比較關鍵的觀察結果是,使用Text-to-Video(T2V)模型,利用Score Distillation Sampling(SDS)直接最佳化動態場景會導致視覺偽影和次優收斂。

所以研究者選擇先利用文字到圖像(T2I)模型,將靜態的三維場景與文字提示相匹配,然後再用動態的方式增強三維場景模型。

此外,模型中還引入了一個新的temporal-aware SDS損失和運動正則項,透過實驗證明了其對現實中和具有挑戰性的運動至關重要。

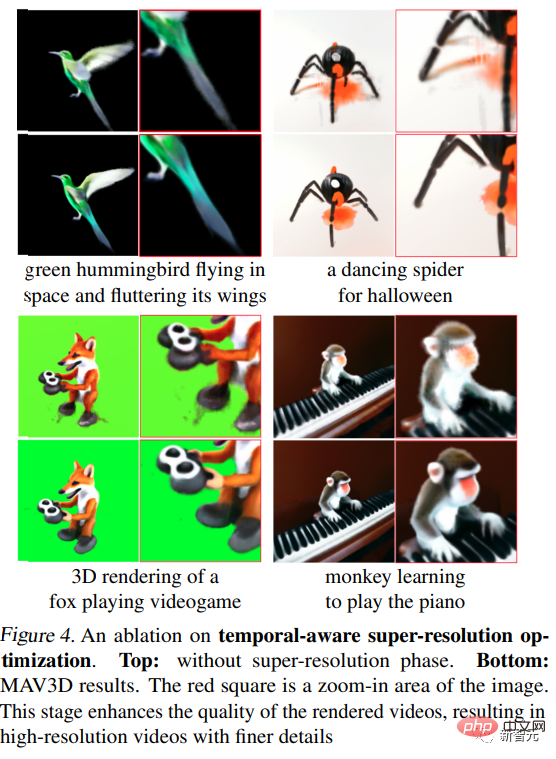

並且透過一個額外的temporal-aware超解析度微調階段擴展到更高解析度的輸出。

最後使用T2V模型的超級解析度模組的SDS來獲得高解析度的梯度資訊來進行有監督學習三維場景模型,增加其視覺保真度,能夠在推理過程中對更高解析度的輸出進行取樣。

實驗部分

評估指標

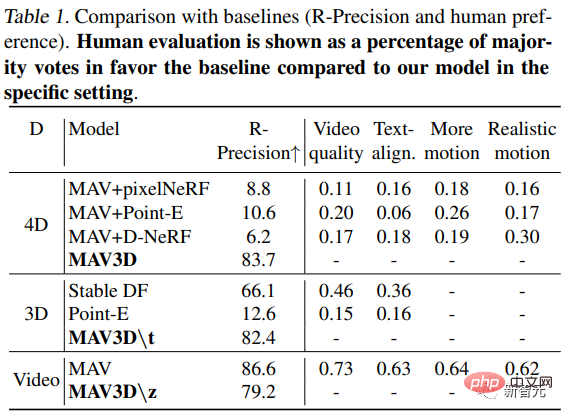

#使用CLIP R-Precision來評估產生的視頻,可以用於衡量文字和生成場景之間的一致性,可以反應輸入提示從渲染的框架中的檢索準確性。研究人員使用CLIP的ViT-B/32變體,並在不同的視圖和時間步中提取幀。

除此之外還使用了四個定性指標,透過詢問人類標註員在兩個生成的影片中的偏好,可以得出(i)影片質量;(ii)對文本提示的忠實度;(iii)運動量;以及(iv)運動的真實性。

Text-to-4D對比

#由於之前沒有文字轉4D的方法,所以研究人員建立了三個基於T2V生成方法的基線用於對比,二維幀的序列就會用三種不同的方法轉化為三維場景表示的序列。

第一個序列是透過one-shot神經場景渲染器(Point-E)得到;第二個是透過對每一幀獨立應用pixelNeRF產生的;第三個是應用D-NeRF結合使用COLMAP擷取的相機位置。

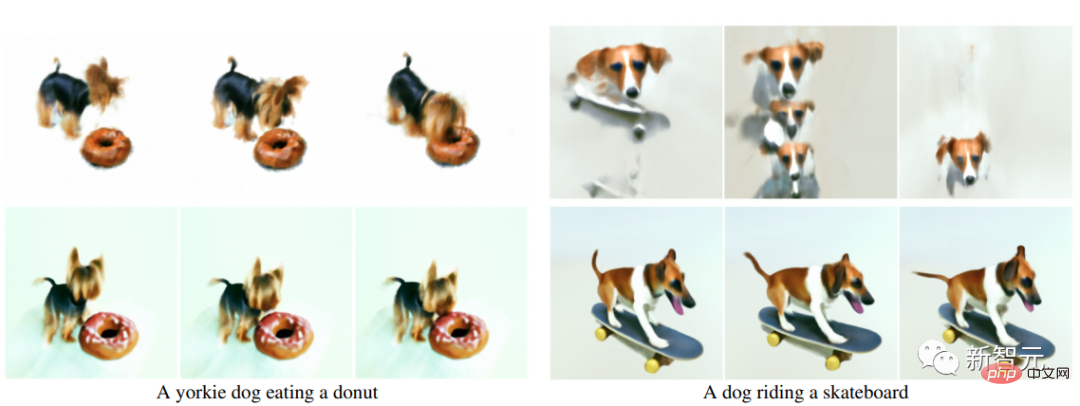

可以看出,該方法在客觀的R-精度指標上超過了基準模型,並且在所有指標上都得到了人類標註員更高的評價。

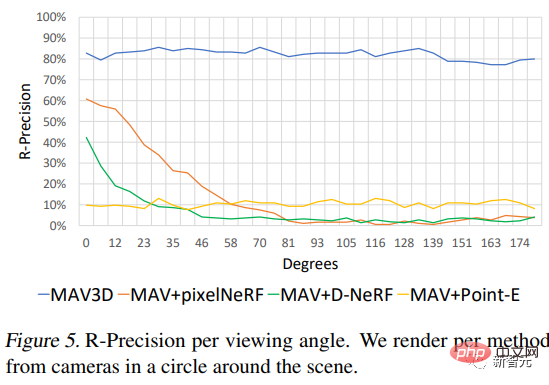

此外,研究人員也探討了此方法在不同相機視角下的表現。

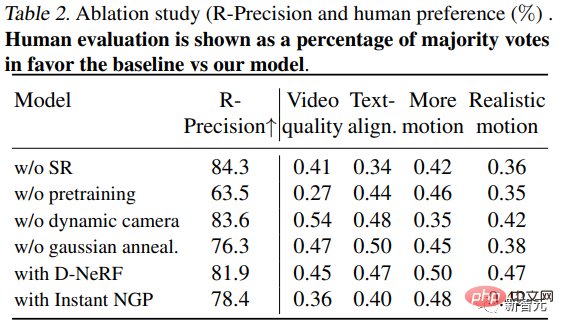

消融實驗

1、 在沒有場景中超在分辨率(SR)微調的情況下訓練的模型,其步驟數與MAV3D相同(階段3)的情況下,人類標註員在質量、文本對齊和運動方面都更傾向於選擇用SR訓練的模型。

此外,超解析度微調增強了渲染影片的質量,使高解析度影片具有更精細的細節和更少的雜訊。

2、無預訓練:在直接最佳化動態場景(沒有靜態場景預訓練)的步驟與MAV3D相同的情況下,結果是場景品質低得多或收斂性差:在73%和65%的情況下,用靜態預訓練的模型在影片品質和現實運動方面更受歡迎。

以上是AIGC發展太快! Meta發布首個基於文字的4D影片合成器:3D遊戲建模師也要下崗了?的詳細內容。更多資訊請關注PHP中文網其他相關文章!