重新審視AI,神經網路中概念符號湧現的發現與證明

- PHPz轉載

- 2023-04-07 21:51:011342瀏覽

本文圍繞著近期的兩項工作,討論神經網路中符號概念的湧現現象,即『深度神經網路的表徵是否是符號化的』的問題。如果我們繞過 「應用科技提升」 的視角,從 「科學發展」 的角度來重新審視 AI,證明 AI 模型中的符號湧現現象無疑是具有重大意義的。

1. 首先,目前大部分的可解釋性研究都在試圖將神經網路解釋為一個「清晰的」、「語意化的」、或“邏輯化的” 模型。但是,如果無法證明神經網路的符號湧現,如果神經網路內在表徵成分真的有大量的混亂成分,那麼大部分的可解釋性研究就失去了其基本事實依據。

2. 其次,若無法證明神經網路的符號湧現,深度學習的發展將會大概率困在「結構」、「損失函數」、「資料」 等外圍因素的層面,而無法直接高階的認知層面去實現知識層面的互動式學習。往這個方向發展需要更乾淨清晰的理論支撐。

因此,本文主要從以下三個面向介紹。

1. 如何定義神經網路所建模的符號化概念,以便可靠地發現神經網路的符號湧現現象。

2. 為什麼所量化的符號化概念可以認為是可信的概念(稀疏性、對神經網路表徵的universal matching、遷移性、分類性、對歷史解釋性指標的解釋)。

3. 如何證明符號化概念的湧現- 即理論證明當AI 模型在某些情況下(一個不嚴苛的條件),AI 模型的表徵邏輯可以解構為極少數的可遷移的符號化概念的分類效用(這部分會在4 月底公開討論)。

#論文網址:https://arxiv.org/pdf/2111.06206.pdf

論文網址:https://arxiv.org/pdf/2302.13080.pdf

#研究作者包括上海交通大學碩士二年級生李明傑、上海交通大學博士三年級學生任潔,李明杰和任潔都師從張拳石老師。他們所在的實驗室團隊常年做神經網路可解釋性的研究。對於可解釋性領域,研究者可以從不同角度來分析,有解釋表徵的,有解釋性能的,有相對可靠合理的,也有不合理的。但是,深入討論下去,對神經網路的解釋有兩個根本的願景,即「能否清晰且嚴謹地表示出神經網路所建模的概念」和「能否準確解釋出決定神經網路效能的因素」。

在「解釋神經網路所建模的概念」這一方向上,所有研究者都必須面對的一個核心問題—「神經網路的表徵到底是不是符號化概念化的」。如果這個問題回答不清楚,那麼後續的研究很難進行—— 如果神經網路的表徵本身都是混亂的,然後研究者強行用一堆「符號化的概念」 或「因果邏輯」 去解釋,這樣一來方向就錯了?神經網路符號化表徵的假設,是進行深入研究該領域的基礎,但是對此問題的論證往往讓人無從下手。

大部分研究者對神經網路的第一直覺是 「它不可能是符號化的吧?」神經網路畢竟不是圖模型。在一篇由Cynthia 等人撰寫的論文中《Stop explaining black box machine learning models for high stakes decisions and use interpretable models instead》 [3],讓人們誤以為對神經網路的事後解釋(post-hoc explanation)天然地是不可靠的。

那麼,神經網路內在表徵真的是非常混亂的?而不是清晰的、稀疏的、符號化的嗎?圍繞著這個問題,我們定義了博弈交互作用[4,5],證明了神經網路表徵瓶頸[6],研究了神經網路對視覺概念表徵的特徵[7,8],從而證明了交互概念與神經網路泛化和穩健性的關係[9,10,11,12],進而完善了沙普利值[13],但是實驗室前期僅圍繞「符號化表徵」 核心的周邊進行探索,始終無法直接探索神經網路表徵是否是符號化的。

這裡我們先說結論- 在大部分情況下,神經網路的表徵是清晰的、稀疏的、符號化的 #。這個結論背後有大量的理論證明,以及大量的實驗論證。在理論方面,我們目前的研究證明了一些可以支撐 “符號化” 的特性,但是目前證明還不足以對 “符號化表徵” 給出嚴謹明確的解答。未來幾個月,我們將會有更嚴謹、更全面的證明。

如何定義神經網路所建模的概念

在分析神經網路之前,我們需要先明確 「如何定義網路所建模的概念」。實際上,對於這個問題,之前已經有了相關研究[14,15],並且實驗結果也比較優異—— 但是,我們認為,“概念” 的定義在理論上應有“嚴謹性” 的數學保證。

因此,我們在論文[1] 中定義了 I(S) 這個指標,用來量化概念S 對於網路輸出的效用,這裡S指的是組成這一概念的所有輸入變數的集合。例如,給定一個神經網路和一個輸入句子x=“I think he is a green hand.”,每個單字可以看成網路的其中一個輸入變量,句中的三個字“a”,“green” ,「hand」 可以構成一個潛在的概念S={a,green,hand}。每個概念S 表示了S 中輸入變數之間的「與」 關係:當且僅當S 中的輸入變數全部出現時,此概念才被觸發,從而為網路輸出貢獻I (S) 的效用。而當 S 中任意變數被遮蔽時,I (S) 這部分效用就從原本的網路輸出中移除了。例如,對於S={a,green,hand} 這個概念,如果輸入句子中的「hand」一詞遮擋,那麼這個概念就不被觸發,網路輸出中也不會包含這個概念的效用I (S)。

我們證明了神經網路輸出總是可以被拆分為所有觸發概念效用總和。即在理論上,對於一個包含n 個輸入單元的樣本,最多有

# 種不同的遮蔽方式,我們總可以用『少量概念』的效用來『精確擬合』神經網路『所有

種'不同遮蔽樣本上的輸出值,從而證明了I (S) 的『嚴謹性』 。下圖給了一個簡單的例子。

。下圖給了一個簡單的例子。

除此之外,我們也證明了賽局互動概念I (S) 能夠解釋賽局理論中大量經典指標的基本機理,例如Shapley value [16]、Shapley interaction index [17],以及Shapley- Taylor interaction index [18]。具體地,我們可以將這三種指標表示為互動概念的不同線性和的形式。

實際上,課題組的前期工作已經基於博弈互動概念指標來定義Shapley value 的最優基準值[13] ,並探討視覺神經網路所建模的『原型視覺概念』及其『美觀度』[8]。

神經網路是否建模了清晰、符號化的概念表徵

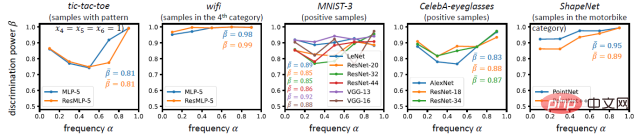

有了這個指標,我們進一步探索上述的核心問題:神經網路是否真的能從訓練任務中總結出清晰的、符號化的、概念化的表徵?所定義的互動概念真的能表示一些有意義的 “知識”,還是只是一個純粹從數學上湊出來的沒有明確意義的 tricky metrics?為此,我們從以下四個面向回答這個問題 —— 符號化概念化的表徵應滿足稀疏性、樣本間遷移性、網絡間遷移性,以及分類性。

要求一(概念稀疏性):神經網路所建模的概念應當是稀疏的

#不同於連結主義,符號主義的一個特性在於人們希望用少量的、稀疏的概念來表示網路學到的知識,而不是用大量、稠密的概念。實驗中我們發現,在大量潛在概念中,只有非常少量的顯著概念。即大部分互動概念的交互效用I (S) 趨近於0,故可以忽略,僅有極少量的交互概念有較顯著的交互效用I (S),這樣神經網路的輸出僅僅決定於少量概念的交互效用。換句話說,神經網路對於每個樣本的推論可以被簡潔地解釋為少量顯著概念的效用。

要求二(樣本間遷移性):神經網路所建模的概念在不同樣本間應當具有遷移性

在單一樣本上滿足稀疏性是遠遠不夠的,更重要的是,這些稀疏的概念表達應當能夠在不同樣本之間互相遷移。如果同一個交互作用概念可以在不同樣本中表徵,如果不同樣本總提取出類似的交互概念,那麼這個交互概念更可能代表一種有意義的普適的知識。反之,如果大部分交互概念僅在一兩個特定樣本上有表徵,那麼這樣所定義的交互更傾向於一個僅有數學定義但沒有物理意義的 tricky metric。在實驗中,我們發現,往往存在一個較小的概念字典,它能夠解釋神經網路為同類別樣本所建模的大部分概念。

我們也視覺化了一些概念,並且發現,相同的概念通常對不同的樣本產生類似的效果,這也驗證了概念在不同樣本之間的遷移性。

要求三(網路間遷移性):不同神經網路所建模的概念之間應具有遷移性

类似地,这些概念应当能够被不同的神经网络稳定地学到,无论是不同初始化的网络,还是不同架构的网络。虽然神经网络可以设计为全然不同的架构,建模不同维数的特征,但是如果不同的神经网络面对同一个具体任务可以实现『殊途同归』,即如果不同神经网络都可以稳定地学习到类似的一组交互概念,那么我们可以认为这组交互概念是面向这个任务的根本的表征。比如,如果不同的人脸检测网络都不约而同地建模了眼睛、鼻子、嘴之间的交互,那么我们可以认为这样的交互是更 “本质的”“可靠的”。在实验中,我们发现,越显著的概念越容易被不同的网络同时学到,相对比例的显著交互是被不同神经网络所共同建模的。

要求四(概念分类性):神经网络所建模的概念应当具有分类性

最后,对于分类任务而言,如果一个概念具有较高的分类性,那么它应当为大多数样本上的分类起到一致的正向作用(或是一致的负向作用)。较高的分类性可以验证这个概念可以独立地承担分类任务,从而更大可能的是一个可靠的概念,而不是不成熟的中间特征。我们同样设计了实验来验证这一性质,发现神经网络建模的概念往往具有较高的分类性。

综上所述,上面的四个方面表明,在大部分情况下,神经网络的表征是清晰的、稀疏的、符号化的。当然,神经网络也并不是每时每刻都能够建模这种清晰、符号化的概念,在少数极端情况下,神经网络学不到稀疏、可迁移的概念,具体请看我们的论文 [2]。

此外,我们还利用此交互来解释了大模型[22]。

神经网络的符号化表征在神经网络可解释性中的意义

1. 从可解释性领域发展的角度来看,最直接的意义就是为 “概念层面解释神经网络” 找到了一定的依据。如果神经网络本身的表征都不是符号化的,那么从符号化概念层面对神经网络的解释就只能是隔靴搔痒,解释的结果一定是似是而非的,并不能实质性的推导深度学习进一步的发展。

2. 从 2021 年开始,我们逐步构建了一个基于博弈交互的理论体系。发现基于博弈交互,我们可以统一解释两个核心问题 “怎样量化神经网络所建模的知识” 和 “怎样解释神经网络的表征能力”。在 “怎样量化神经网络所建模的知识” 方向上,除了本文提到的两个工作之外,课题组的前期工作已经基于博弈交互概念指标,来定义 Shapley value 的最优基准值 [13],并探索视觉神经网络所建模的『原型视觉概念』及其『美观度』[7,8]。

3. 在 “怎样解释神经网络的表征能力” 方向上,课题组证明了神经网络对不同交互的表征瓶颈 [6],研究了神经网络如何通过其所建模的交互概念来确定其泛化性 [12,19],研究神经网络所建模的交互概念与其对抗鲁棒性和对抗迁移性的关系 [9,10,11,20],证明了贝叶斯神经网络更难以建模复杂交互概念 [21]。

更多阅读请参考:

https://zhuanlan.zhihu.com/p/264871522/

以上是重新審視AI,神經網路中概念符號湧現的發現與證明的詳細內容。更多資訊請關注PHP中文網其他相關文章!