HuggingGPT火了:一個ChatGPT控制所有AI模型,自動幫人完成AI任務,網友:留口飯吃吧

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB轉載

- 2023-04-07 21:21:081867瀏覽

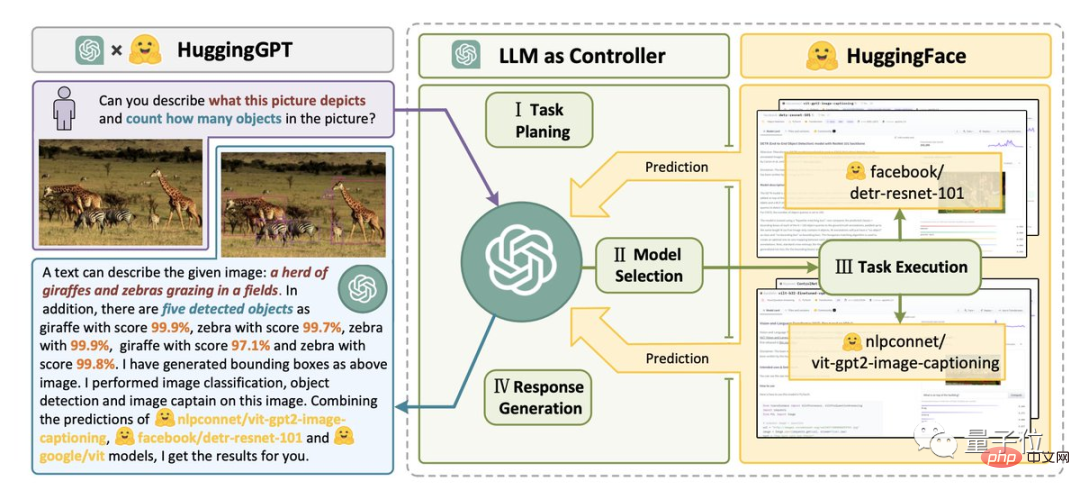

最強組合:HuggingFace ChatGPT -

HuggingGPT,它來了!

只要給定一個AI任務,例如「下面這張圖片裡有什麼動物,每種有幾隻」。

它就能幫你自動分析需要哪些AI模型,然後直接去呼叫HuggingFace上的對應模型,來幫你執行並完成。

整個過程,你要做的就只是用自然語言將你的需求輸出。

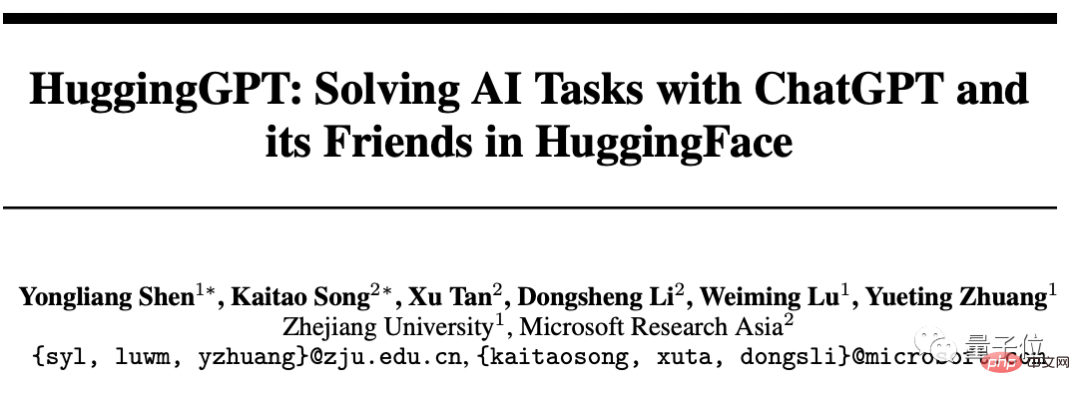

這項由浙大與微軟亞研院的合作成果,一發布就迅速爆火。

英偉達AI研究科學家Jim Fan直呼:

這是我本週讀到的最有趣的論文。它的想法非常接近「Everything App」(萬物皆App,被AI直接讀取資訊)。

而一位網友則「直拍大腿」:

這不就是ChatGPT「調包俠」嗎?

AI進化速度一日千里,給我們留口飯吃吧…

所以,具體怎麼回事?

HuggingGPT:你的AI模型“調包俠”

其實,若說這個組合物只是“調包俠”,那格局小了。

它的真正用義,是AGI。

如作者所言,邁向AGI的關鍵一步是能夠解決具有不同領域和模式的複雜AI任務。

我們目前的成果離此還有距離──大量模型只能出色地完成某一特定任務。

然而大語言模型LLM在語言理解、生成、互動和推理方面的表現,讓作者想到:

可以將它們作為中間控制器,來管理現有的所有AI模型,透過“調動和組合每個人的力量”,來解決複雜的AI任務。

在這個系統中,語言是通用的介面。

於是,HuggingGPT就誕生了。

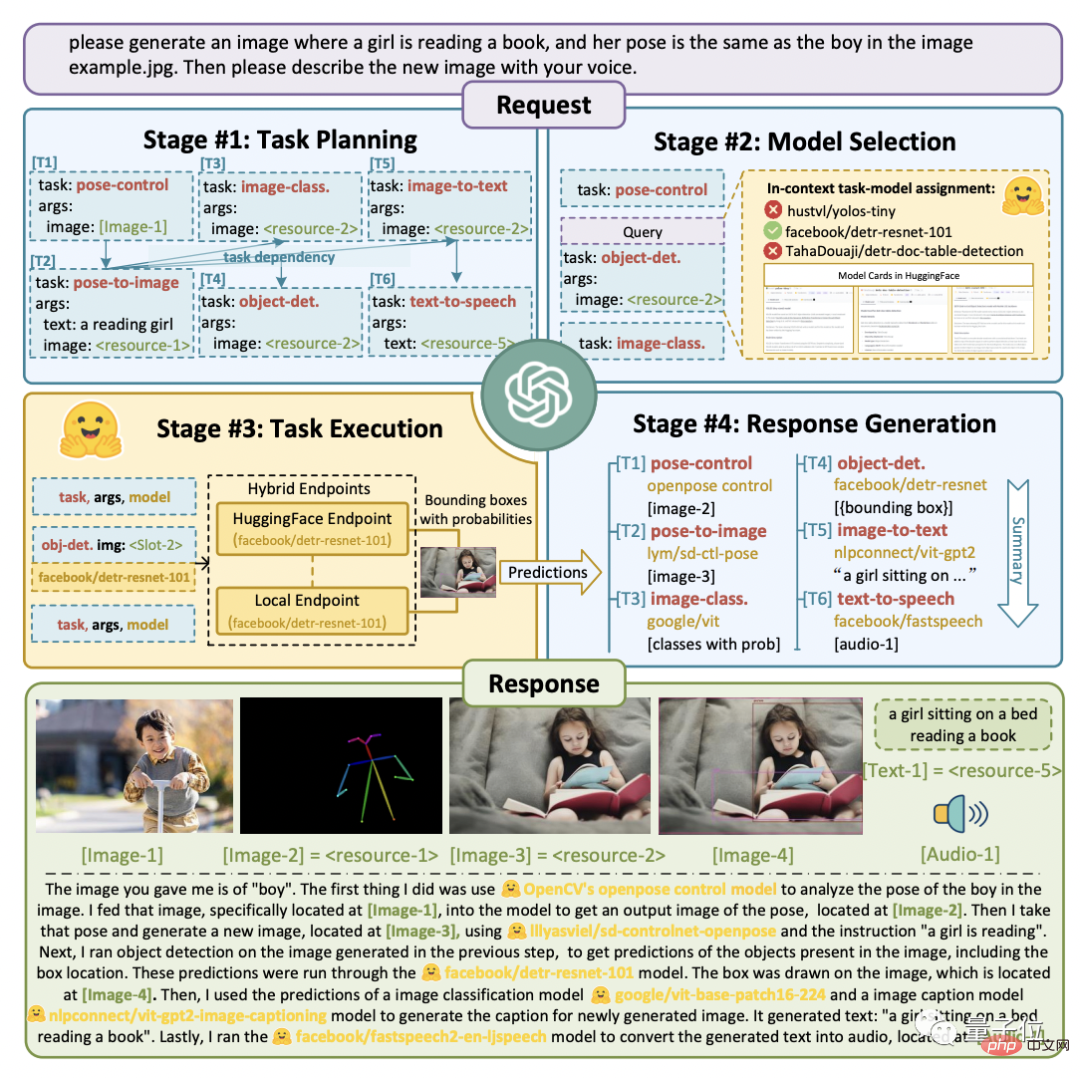

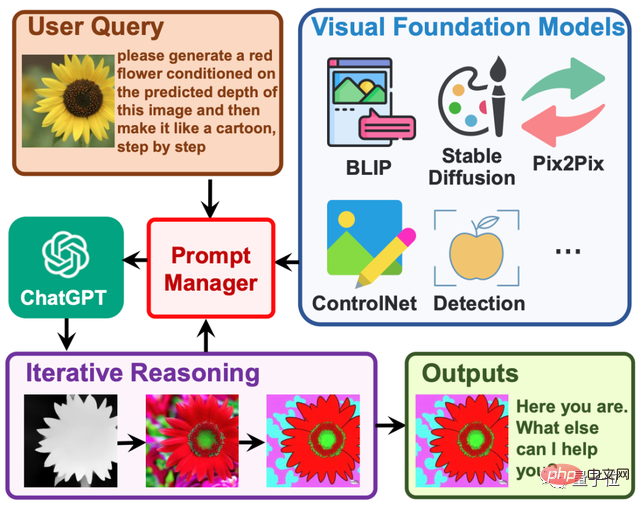

它的工程流程分為四個步驟:

首先,任務規劃。 ChatGPT將使用者的需求解析為任務列表,並確定任務之間的執行順序和資源依賴關係。

其次,模型選擇。 ChatGPT根據HuggingFace上託管的各專家模型的描述,為任務分配合適的模型。

接著,任務執行。混合端點(包括本地推理和HuggingFace推理)上被選定的專家模型根據任務順序和依賴關係執行分配的任務,並將執行資訊和結果給到ChatGPT。

最後,輸出結果。由ChatGPT總結各模型的執行過程日誌和推理結果,給出最終的輸出。

如下圖所示。

假定我們給出這樣一個請求:

請產生一個女孩正在看書的圖片,她的姿勢與example.jpg中的男孩相同。然後請用你的聲音描述新圖片。

可以看到HuggingGPT是如何將它拆解為6個子任務,並分別選定模型執行得到最終結果的。

具體效果怎麼樣?

作者採用gpt-3.5-turbo和text-davinci-003這兩個可以透過OpenAI API公開存取的變體,進行了實測。

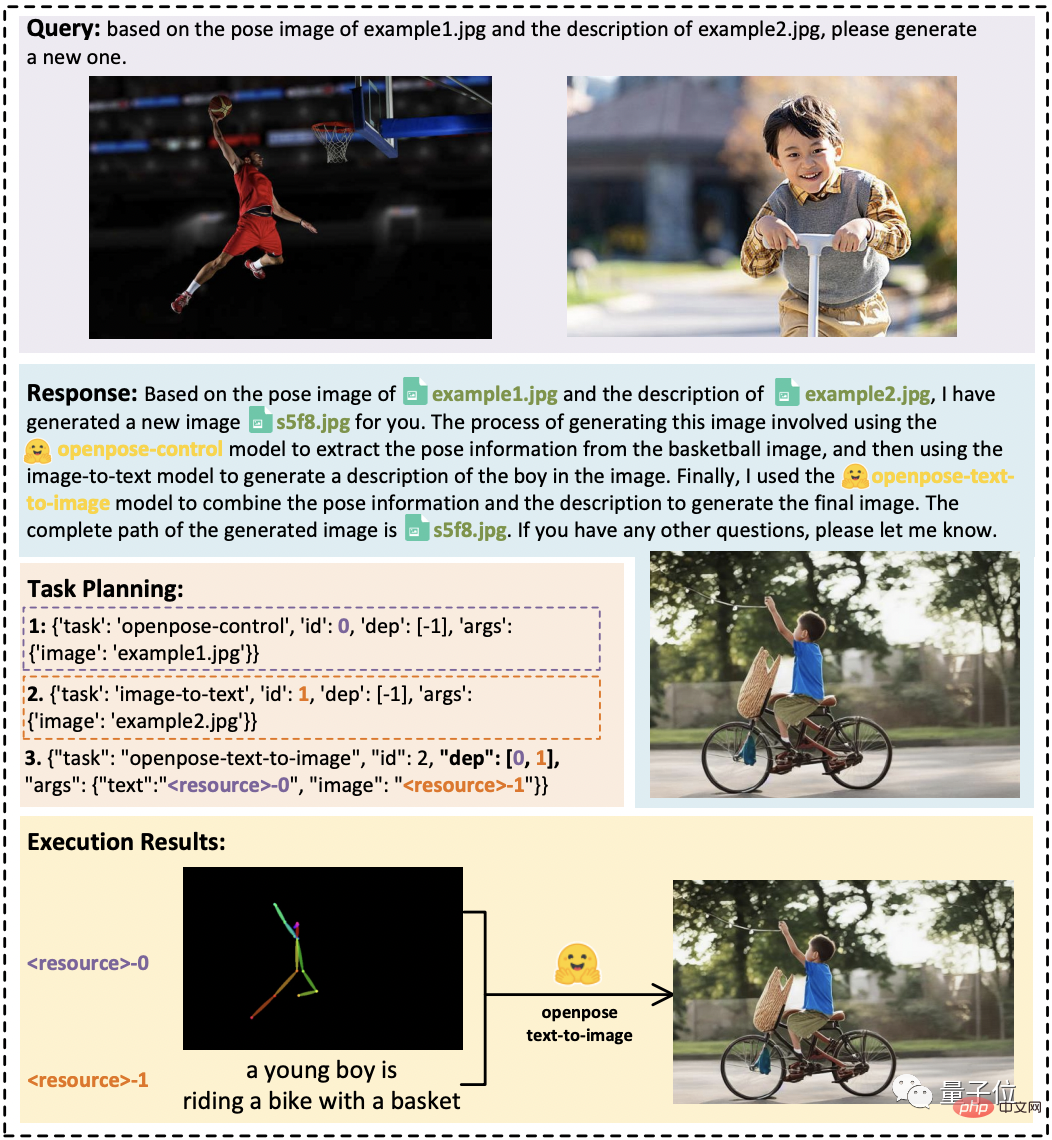

如下圖所示:

在任務之間存在資源依賴關係的情況下,HuggingGPT可以根據使用者的抽象請求正確解析出具體任務,完成圖片轉換。

在音訊和視訊任務中,它也展現了組織模型之間合作的能力,透過分別並行和串列執行兩個模型的方式,完了一段「太空人在太空中行走」的影片和配音作品。

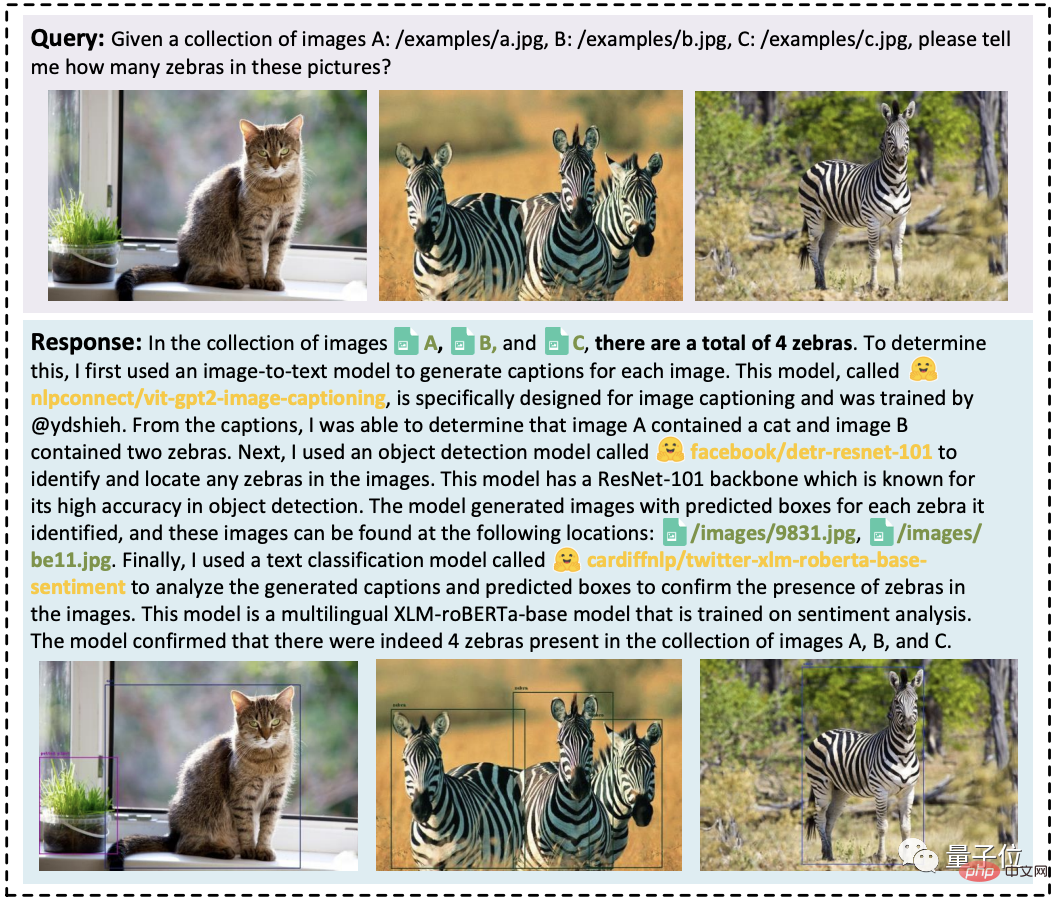

此外,它還可以整合多個使用者的輸入資源執行簡單的推理,例如在以下三張圖片中,數出其中有多少匹斑馬。

一句話總結:HuggingGPT可以在各種形式的複雜任務上表現出良好的效能。

專案已開源,名叫「賈維斯」

目前,HuggingGPT的論文已經發布,專案則正在建設中,程式碼只開源了一部分,已攬獲1.4k標星。

我們注意到,它的專案名稱很有意思,不叫本名HuggingGPT,而是鋼鐵人裡的AI管家賈維斯(JARVIS)。

有人發現它和3月份剛發布的Visual ChatGPT的想法非常像:後者HuggingGPT,主要是可調用的模型範圍擴展到了更多,包括數量和類型。

不錯,其實它們都有一個共同作者:微軟亞研院。

具體而言,Visual ChatGPT的一作是MSRA資深研究員吳晨飛,通訊作者為MSRA首席研究員段楠。

HuggingGPT則包含兩位共同一作:

Shen Yongliang,TA來自浙江大學,在MSRA實習期間完成此工作;

Song Kaitao,MSRA研究員。

其通訊作者為浙大計算機系教授莊越挺。

最後,對於這個強大新工具的誕生,網友們很是興奮,有人表示:

ChatGPT已成為人類創建的所有AI的總指揮官了。

也有人據此認為:

AGI可能不是LLM,而是由一個「中間人」LLM連接的多個相互關聯的模型。

那麼,我們是否已經開啟「半AGI」的時代了?

論文網址:https://www.php.cn/link/1ecdec353419f6d7e30857d00d0312d1

#計畫連結:https://www.php.cn/link/859555c74e9afd45ab771c615c1e49a6

#參考連結:#https://www.php.cn/ link/62d2b7ba91f34c0ac08aa11c359a8d2c

#以上是HuggingGPT火了:一個ChatGPT控制所有AI模型,自動幫人完成AI任務,網友:留口飯吃吧的詳細內容。更多資訊請關注PHP中文網其他相關文章!