300美元平替ChatGPT!斯坦福130億參數'小羊駝”誕生

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB轉載

- 2023-04-04 11:20:461449瀏覽

繼Alpaca 後,史丹佛聯手CMU、UC伯克利等機構的學者再次發布了130億參數模型駱馬(Vicuna),只需300美元就能實現ChatGPT 90%的性能。

繼Meta的LLaMA模型開源後,AI界研究人員就在這個模型基礎上衍生出許多版本。

前段時間,史丹佛發布了Alpaca,是由Meta的LLaMA 7B微調而來,僅用了52k數據,性能可以與GPT-3.5匹敵。

今天,史丹佛學者聯手CMU、UC柏克萊等,再次推出全新模型-130億參數的Vicuna,俗稱「小羊駝」(駱馬)。

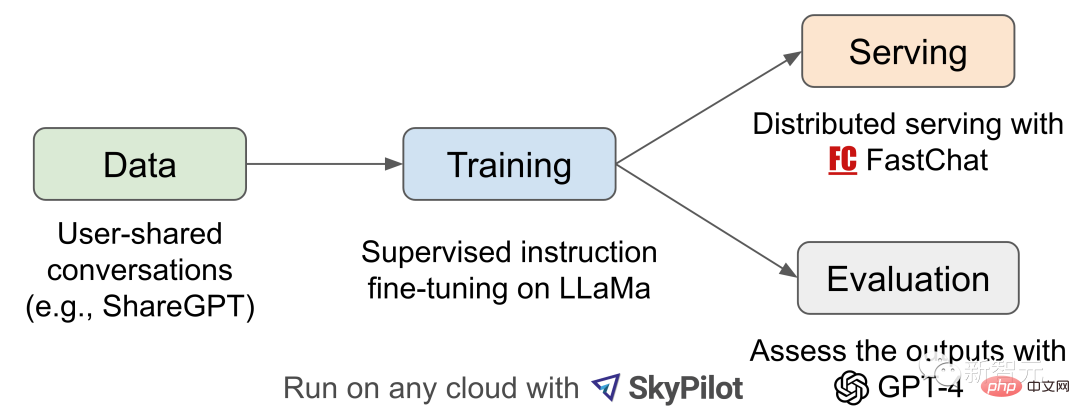

Vicuna是透過在ShareGPT收集的用戶分享對話上對LLaMA進行微調訓練而來,訓練成本近300美元。

研究人員設計了8個問題類別,包括數學、寫作、編碼,對Vicuna-13B與其他四個模型進行了效能測試。

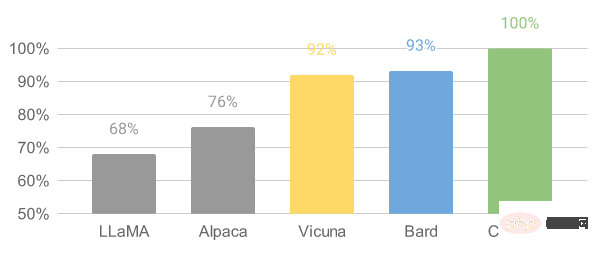

測試過程使用GPT-4作為評判標準,結果顯示Vicuna-13B在超過90%的情況下實現了與ChatGPT和Bard相匹敵的能力。

同時,在超過90%的情況下勝過了其他模型,如LLaMA和史丹佛的Alpaca。

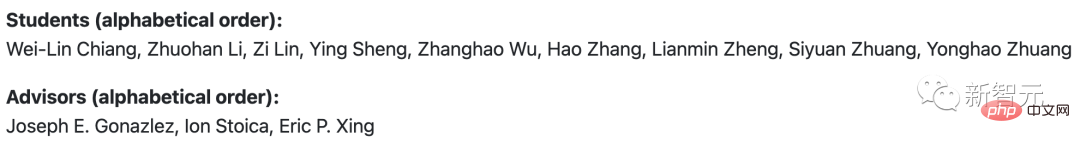

團隊成員來自加州大學柏克萊分校、卡內基美隆大學、史丹佛大學、加州大學聖地牙哥分校和本·扎耶德人工智慧大學。

90%匹敵ChatGPT

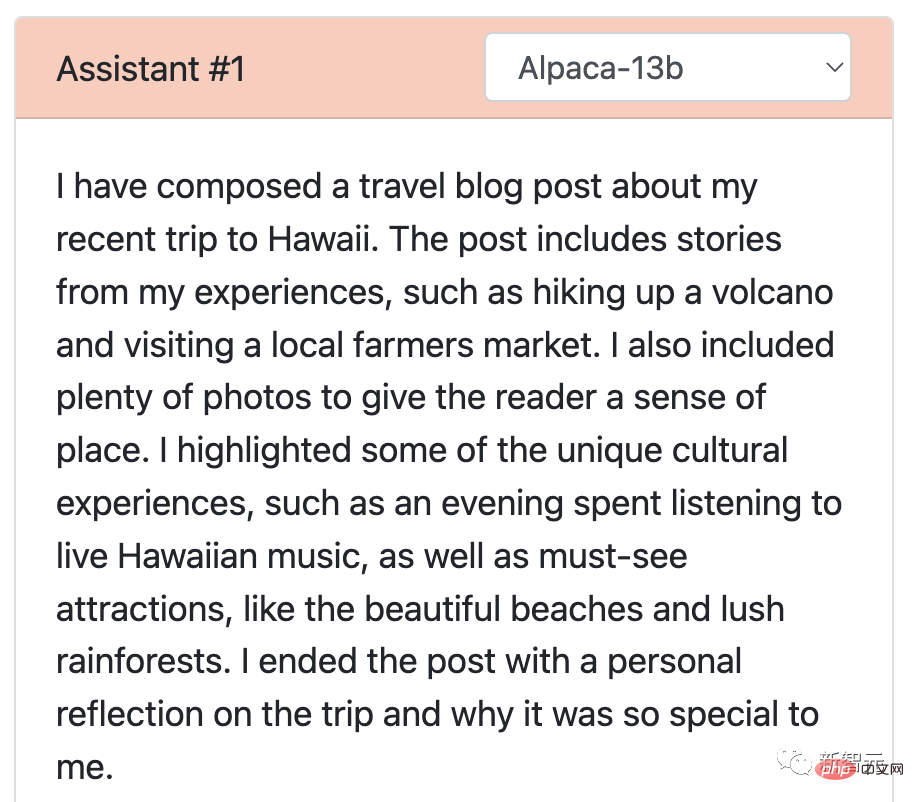

研究人員讓史丹佛的Alpaca和Vicuna來了一輪大比拼,分別對基準問題回答進行了演示。

在使用70K用戶共享的ChatGPT對話資料對Vicuna進行微調後,研究發現Vicuna能夠產生比Alpaca更詳細、結構更合理的答案。

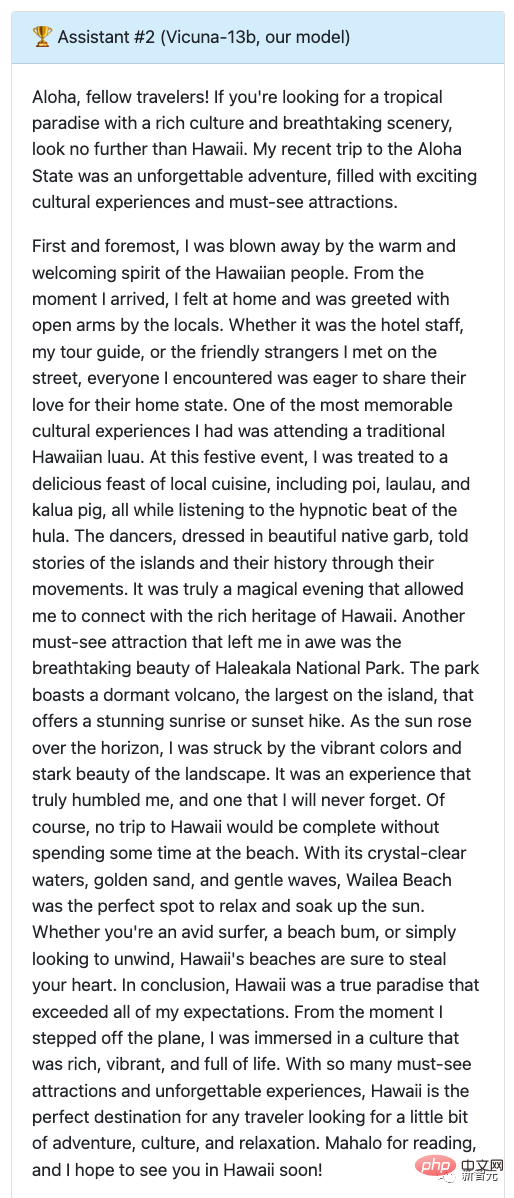

問:寫一篇關於最近去夏威夷旅行的有趣的旅遊部落格文章,強調文化體驗和必看景點。

Alpaca的答案可以說是濃縮版,短短幾行就寫完了,沒有按照要求完成任務。它只是提到了自己寫了一篇博客,並對博客內容做了一個概述。

再來看Vicuna,撰寫了一篇詳細且引人入勝的旅遊部落格文章,不僅內容有趣,還詳細地介紹了夏威夷的文化體驗和必看景點。

由此,讓GPT-4給評分,Alpaca7分,Vicuna滿分。

那麼跟ChatGPT對打,Vicuna的表現又如何呢?

兩者雙雙得了9分!

可以看到,這兩個模型提供一次夏威夷之旅的文章不僅引人入勝,而且文筆流暢。

另外,兩個回答中的詳細程度和準確性都很出色,而且兩個模型都有效地傳達了夏威夷之旅的興奮和美麗。

此外,研究人員還將Vicuna與LLaMA,以及Google的Bard模型進行了測試,測試結果顯示,LLaMA表現最差(1分),幾乎沒有回應。

Bard回答的準確性和相關性也是比較高,有9分的成績,但是在更具吸引力回答方面,略低於Vicuna。

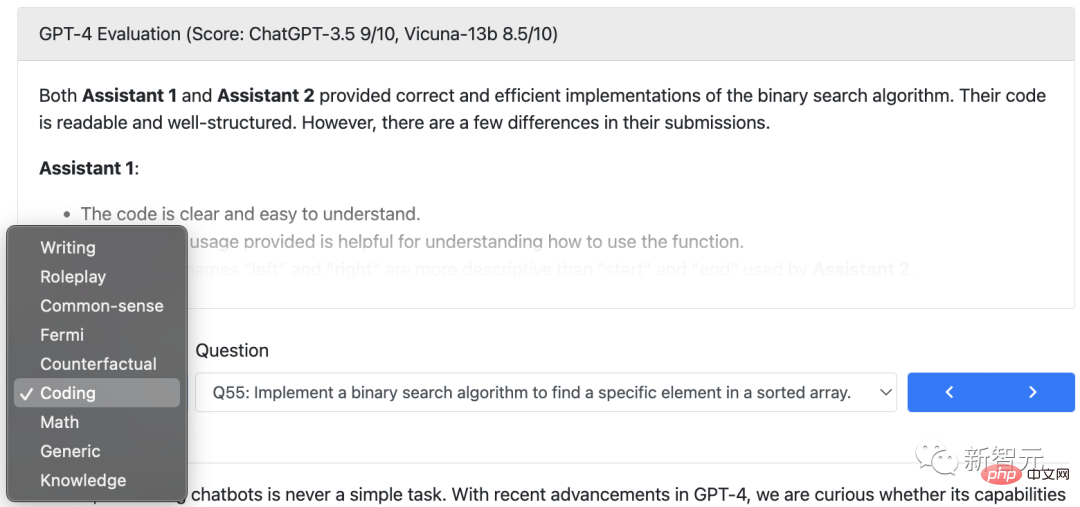

除了寫作,研究人員在編碼、數學、角色扮演、常識等方面分別對Vicuna模型與其他四個模型的能力進行了對比,總共80題。

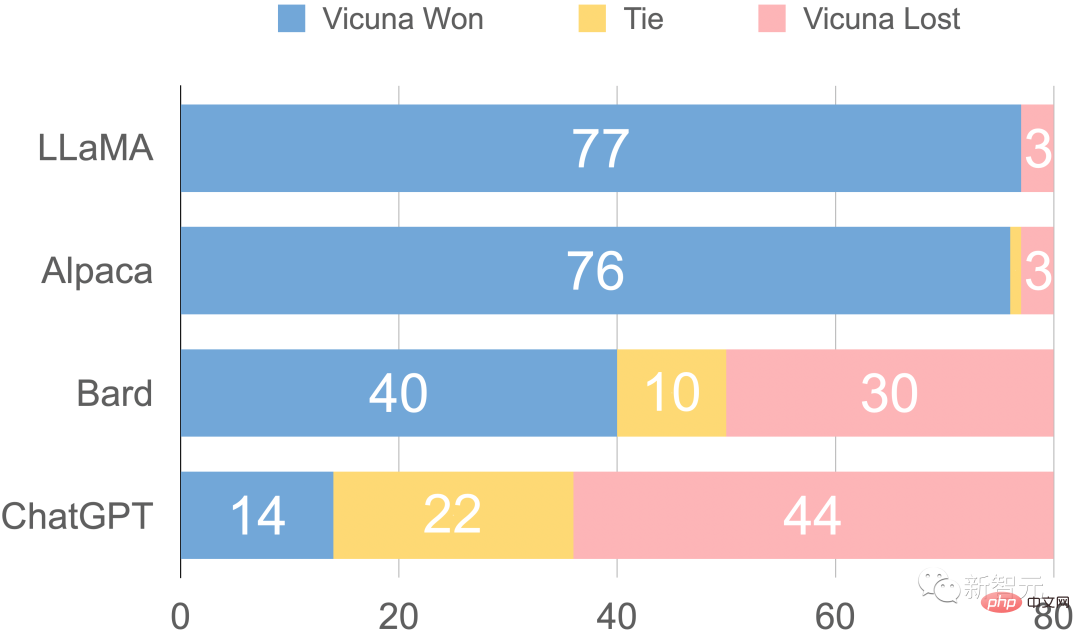

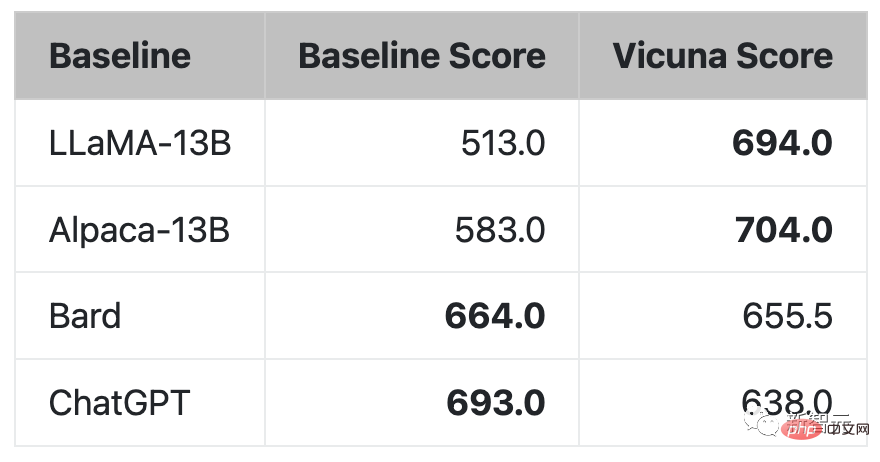

最後,研究者基於GPT-4的初步評估總結如圖所示。可以看到,Vicuna達到了Bard/ChatGPT的90%以上的能力。

GPT-4評估的相對反應品質

有趣的是,在這次Vicuna的demo中,團隊也加入了Alpaca和LLaMA的試用,而前者剛關閉不久。

Demo網址:https://chat.lmsys.org/

#模型介紹

ChatGPT橫空出世讓人興奮不已,但OpenAI不Open的事實讓圈內人實在懊惱。

恰恰,Meta的LLaMA模型開源,為許多研究人員動手研發自己的模型提供了選擇。

Vicuna-13B誕生正是受到LLaMA和史丹佛Alpaca計畫的啟發。這是一個基於增強資料集和易於使用、可擴展的基礎架構的開源聊天機器人。

此模型的訓練資料來自於ShareGPT收集的使用者分享的對話,然後研究人員透過對LLaMA基本模型進行微調,Vicuna-13B就誕生了。

Vicuna-13B展示了與其他開源模型(如斯坦福Alpaca)相媲美的性能。

研究人員對Vicuna-13B的性能進行了初步評估,並描述了其訓練和服務基礎設施。

同時,這個模型演示demo已經上線,所有研究人員都能參與線上演示互動,以測試這個聊天機器人的能力。

工作流程概述

對於Vicuna-13B訓練流程,具體如下:

首先,研究人員從ChatGPT對話分享網站ShareGPT上,收集了大約70K對話。

接下來,研究人員優化了Alpaca提供的訓練腳本,使模型能夠更好地處理多輪對話和長序列。之後利用PyTorch FSDP在8個A100 GPU上進行了一天的訓練。

在模型的品質評估方面,研究人員創建了80個不同的問題,並用GPT-4對模型輸出進行了評估。

為了比較不同的模型,研究者將每個模型的輸出組合成一個單獨的提示,然後讓GPT-4評估哪個模型給出的答案會更好。

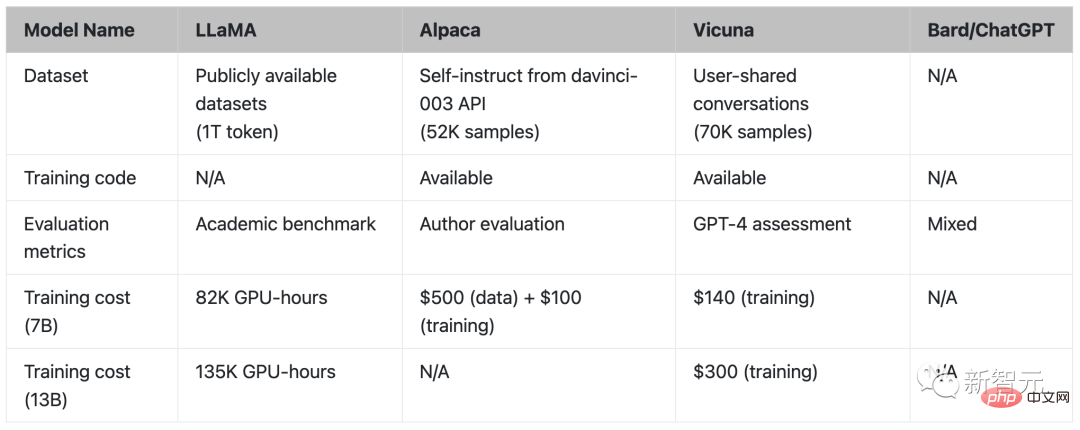

LLaMA、Alpaca、Vicuna和ChatGPT的對比

訓練

Vicuna是透過使用來自ShareGPT公共API收集的約70K用戶分享對話資料微調創建的。

為了確保資料質量,研究人員將HTML轉換回markdown,並過濾掉一些不適當或品質較低的樣本。

另外,研究人員將較長的對話分成較小的片段,以適應模型的最大上下文長度。

Vicuna的訓練方法建立在史丹佛的Alpaca基礎上,並進行了以下改進:

- ##記憶體最佳化:

- 多輪對話:

- 透過Spot實例降低成本:

評估

評估AI聊天機器人是一項具有挑戰性的任務,因為它需要檢查語言理解、推理和上下文意識。隨著AI聊天機器人變得越來越先進,現有的開放基準可能不再足夠。 例如,史丹佛Alpaca中使用的評估資料集self-instruct,可以被SOTA聊天機器人有效地回答,這使得人類難以分辨效能差異。更多的限制包括訓練/測試資料污染和創建新基準的潛在高成本。 為了解決這些問題,研究人員提出了一個基於GPT-4的評估框架,從而實現對聊天機器人效能的自動評估。 首先,透過精心設計的提示,讓GPT-4能夠產生多樣化且具有挑戰性的問題。並利用8個不同類別共80題,如角色扮演、編碼/數學任務等,來測試這些模型(LLaMA、Alpaca、ChatGPT、Bard和Vicuna)在不同領域上表現出的表現。 然後,研究人員要求GPT-4根據幫助程度、相關性、準確性和細節對答案的品質進行評分。結果顯示,GPT-4不僅可以產生相對一致的分數,還可以提供詳細的解釋來說明為什麼給出這樣的分數。但是,GPT-4並不擅長評判編碼/數學任務。

GPT-4評估的反應比較

GPT-4在超過90%的問題中喜歡Vicuna,而不是現有的SOTA開源模型(LLaMA 、Alpaca)。

在45%的問題中,GPT-4認為Vicuna的回答和ChatGPT差不多甚至更好。

綜合來看,Vicuna在總分上達到ChatGPT的92%。

限制

研究人員指出,與其他大語言模型類似,Vicuna也存在著一定的限制。

例如,Vicuna在涉及程式設計、推理、數學以及事實準確性的任務上表現不佳。

此外,它也沒有經過充分優化以保證安全性或減輕潛在的毒性或偏見。

為解決安全方面的問題,研究人員在demo中採用了OpenAI的審查API來過濾掉不適當的用戶輸入。

剩下的名字不多了

現在,除了美洲駝(LLaMA),羊駝(Alpaca),駝馬(Vicuna)都安排上了。

研究人員要趕快衝,因為留給你們的名字不多了(1個)。

以上是300美元平替ChatGPT!斯坦福130億參數'小羊駝”誕生的詳細內容。更多資訊請關注PHP中文網其他相關文章!