華人博士和Google科學家最新提出了預訓練視覺語言模型Vid2Seq,可以分辨和描述一段影片中的多個事件。這篇論文已被CVPR 2023接收。

最近,來自Google的研究員提出了一種用於描述多事件影片的預訓練視覺語言模型-Vid2Seq,目前已被CVPR23接收。

在以前,理解影片內容是一項具有挑戰性的任務,因為影片通常包含在不同時間尺度發生的多個事件。

例如,一個雪橇手將狗拴在雪橇上、然後狗開始跑的影片涉及一個長事件(狗拉雪橇)和一個短事件(狗被拴在雪橇上)。

而促進影片理解研究的一種方法是,透過密集視訊標註任務,該任務包括在一分鐘長的影片中對所有事件進行時間定位和描述。

論文地址:https://arxiv.org/abs/2302.14115

Vid2Seq架構用特殊的時間標記增強了語言模型,使其能夠在同一輸出序列中無縫預測事件邊界和文字描述。

為了對這個統一的模型進行預訓練,研究者透過將轉錄的語音的句子邊界重新表述為偽事件邊界,並將轉錄的語音句子作為偽事件的標註,來利用未標記的旁白影片。

Vid2Seq模型概述

由此產生的Vid2Seq模型在數以百萬計的旁白影片上進行了預訓練,提高了各種密集影片標註基準的技術水平,包括YouCook2、ViTT和ActivityNet Captions。

Vid2Seq也能很好地適用於few-shot的密集視訊標註設定、視訊段落標註任務和標準視訊標註任務。

用於密集視訊標註的視覺語言模型

多模態Transformer架構已經刷新了各種視訊任務的SOTA,例如動作辨識。然而,要讓這樣的架構適應在長達幾分鐘的影片中聯合定位和標註事件的複雜任務,並不簡單。

為了實現這個目標,研究者用特殊的時間標記(如文字標記)來增強視覺語言模型,這些時間標記代表影片中離散的時間戳,類似於空間領域的Pix2Seq。

對於給定的視覺輸入,所產生的Vid2Seq模型既可以接受輸入,也可以產生文字和時間標記的序列。

首先,這使得Vid2Seq模型能夠理解轉錄的語音輸入的時間訊息,它被投射為單一的標記序列。其次,這使Vid2Seq能夠聯合預測密集的事件標註,並在影片中以時間為基礎,同時產生單一的標記序列。

Vid2Seq架構包括一個視覺編碼器和一個文字編碼器,它們分別對視訊幀和轉錄的語音輸入進行編碼。產生的編碼隨後被轉發到文字解碼器,該解碼器自動預測密集事件標註的輸出序列,以及它們在影片中的時間定位。在這個架構初始化時有一個強大的視覺主幹和一個強大的語言模型。

對影片進行大規模預訓練

由於任務的密集性,為密集的影片標註手動收集註解的成本特別高。

因此,研究者使用了無標籤的解說影片對Vid2Seq模型進行預訓練,這些影片在規模上很容易取得。他們還使用了YT-Temporal-1B資料集,其中包括1800萬個涵蓋廣泛領域的旁白影片。

研究者使用轉錄的語音句子及其對應的時間戳作為監督,這些句子被投射為單一的token序列。

然後用一個生成目標對Vid2Seq進行預訓練,該目標教導解碼器僅預測給定視覺輸入的轉錄的語音序列,以及一個鼓勵多模態學習的去噪目標,要求模型在有噪音的轉錄語音序列和視覺輸入的情況下預測掩碼。特別是,透過隨機掩蓋跨度的token,把噪音添加到語音序列中。

下游任務的基準測室結果

由此產生的預訓練的Vid2Seq模型可以透過一個簡單的最大似然目標在下游任務中進行微調,該目標使用教師強迫(即在給在定先前的基礎真實token的情況下預測下一個token)。

經過微調,Vid2Seq在三個標準的下游密集視訊標註基準(ActivityNet Captions、YouCook2和ViTT)和兩個影片剪輯標註基準(MSR-VTT、MSVD)上超越了SOTA。

在論文中,還有額外的消融研究、定性結果,以及在few-shot設定和視訊段落標註任務中的結果。

定性測試

結果表明,Vid2Seq可以預測有意義的事件邊界和標註,而且預測的標註和邊界與轉錄的語音輸入有很大的不同(這也表明輸入中視覺標記的重要性)。

下一個範例有關於烹飪食譜中的一系列指令,是Vid2Seq對YouCook2驗證集的密集事件標註預測的例子:

#接下來是Vid2Seq對ActivityNet Captions驗證集的密集事件標註預測的例子,在所有這些影片中,都沒有轉錄的語音。

不過還是會有失敗的案例,像是下面標紅的這個畫面,Vid2Seq說是一個人對著鏡頭脫帽致敬。

對標SOTA

表5將Vid2Seq與最先進的密集視訊標註方法進行了比較:Vid2Seq在YouCook2、ViTT 和ActivityNet Captions這三個資料集上刷新了SOTA。

Vid2Seq在YouCook2和ActivityNet Captions上的SODA指標比PDVC和UEDVC分別增加了3.5和0.3分。且E2ESG在Wikihow上使用域內純文字預訓練,而Vid2Seq優於此方法。這些結果表明,預先訓練的Vid2Seq模型具有很強的密集事件標註能力。

表6評估了密集視訊標註模型的事件定位表現。與YouCook2和ViTT相比,Vid2Seq在處理密集視訊標註作為單一序列生成任務時更勝一籌。

然而,與PDVC和UEDVC相比,Vid2Seq在ActivityNet Captions上表現不佳。與這兩種方法相比,Vid2Seq整合了較少的關於時間定位的先驗知識,而另兩種方法包括特定的任務組件,如事件計數器或單獨為定位子任務訓練一個模型。

實作細節

- 架構

視覺時間transformer編碼器、文字編碼器和文字解碼器都有12層,12個頭,嵌入維度768,MLP隱藏維度2048。

文字編碼器和解碼器的序列在預訓練時被截斷或填充為L=S=1000個token,在微調期間,S=1000和L=256個token。在推理過程中,使用波束搜尋解碼,追蹤前4個序列並應用0.6的長度歸一化。

- 訓練

作者使用Adam優化器,β=(0.9, 0.999),沒有權重衰減。

在預訓練期間,使用1e^-4的學習率,在前1000次迭代中線性預熱(從0開始),並在其餘迭代中保持不變。

在微調期間,使用3e^-4的學習率,在前10%的迭代中線性預熱(從0開始),其餘90%的迭代中保持餘弦衰減(降至0)。過程中,使用32個視訊的批次量,並在16個TPU v4晶片上分割。

作者對YouCook2進行了40次epoch調整,對ActivityNet Captions和ViTT進行了20次epoch調整,對MSR-VTT進行了5次epoch調整,對MSVD進行了10次epoch調整。

結論

Google提出的Vid2Seq,是一種用於密集視訊標註的新型視覺語言模型,它可以有效地在無標籤的旁白影片上進行大規模的預訓練,並在各種下游密集視訊標註的基準上取得了SOTA的結果。

作者介紹

論文一作:Antoine Yang

Antoine Yang是法國國立電腦及自動化研究院Inria和巴黎高等師範學校École Normale Supérieure的WILLOW團隊的三年級博士生,導師為Antoine Miech, Josef Sivic, Ivan Laptev和Cordelia Schmid。

目前的研究重點是學習用於視訊理解的視覺語言模型。他於2019年在華為諾亞方舟實驗室實習,並在2020年獲得了巴黎綜合理工學院的工程學位和巴黎薩克雷國立大學的數學、視覺和學習碩士學位,2022年在谷歌研究院實習。

以上是Google推出多模態Vid2Seq,理解視訊IQ在線,字幕君不會下線了|CVPR 2023的詳細內容。更多資訊請關注PHP中文網其他相關文章!

在 Windows 11 上彻底删除不需要的显示语言的方法Sep 24, 2023 pm 04:25 PM

在 Windows 11 上彻底删除不需要的显示语言的方法Sep 24, 2023 pm 04:25 PM在同一设置上工作太久或与他人共享PC。您可能会安装一些语言包,这通常会产生冲突。因此,是时候删除Windows11中不需要的显示语言了。说到冲突,当有多个语言包时,无意中按Ctrl+Shift会更改键盘布局。如果不注意,这将是手头任务的障碍。所以,让我们直接进入方法!如何从Windows11中删除显示语言?1.从设置按+打开“设置”应用,从导航窗格中转到“时间和语言”,然后单击“语言和地区”。WindowsI单击要删除的显示语言旁边的省略号,然后从弹出菜单中选择“删除”。在出现的确认提示中单击“

给语言大模型加上综合视听能力,达摩院开源Video-LLaMAJun 09, 2023 pm 09:28 PM

给语言大模型加上综合视听能力,达摩院开源Video-LLaMAJun 09, 2023 pm 09:28 PM视频在当今社交媒体和互联网文化中扮演着愈发重要的角色,抖音,快手,B站等已经成为数以亿计用户的热门平台。用户围绕视频分享自己的生活点滴、创意作品、有趣瞬间等内容,与他人互动和交流。近期,大语言模型展现出了令人瞩目的能力。我们能否给大模型装上“眼睛”和“耳朵”,让它能够理解视频,陪着用户互动呢?从这个问题出发,达摩院的研究人员提出了Video-LLaMA,一个具有综合视听能力大模型。Video-LLaMA能够感知和理解视频中的视频和音频信号,并能理解用户输入的指令,完成一系列基于音视频的复杂任务,

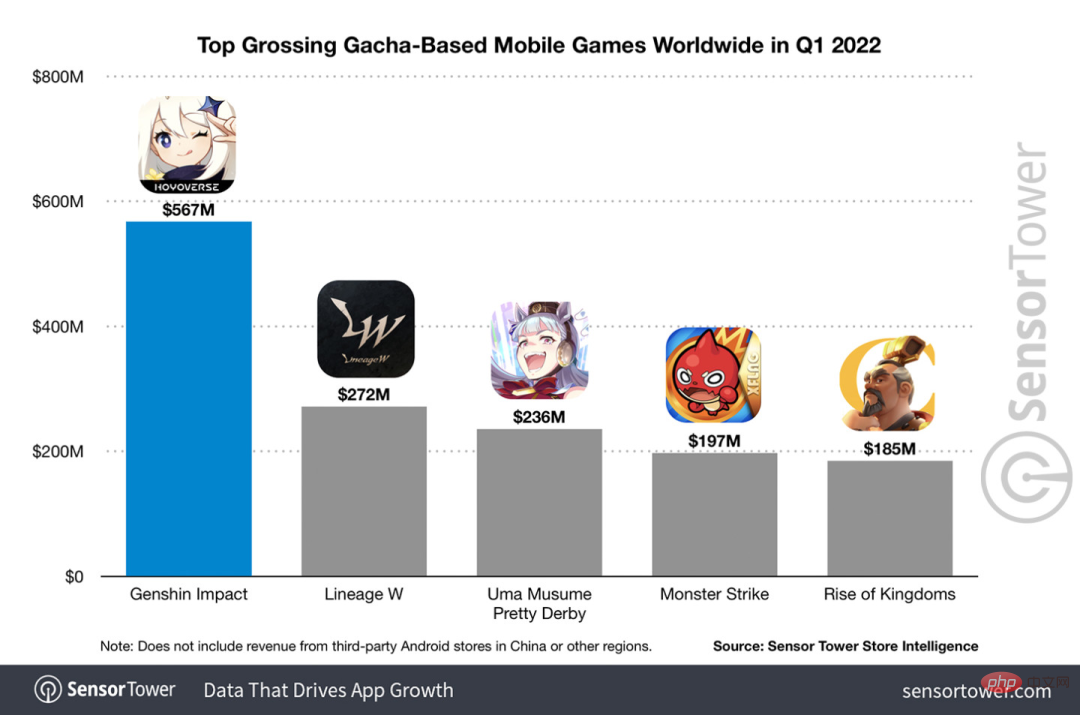

光动嘴就能玩原神!用AI切换角色,还能攻击敌人,网友:“绫华,使用神里流·霜灭”May 13, 2023 pm 07:52 PM

光动嘴就能玩原神!用AI切换角色,还能攻击敌人,网友:“绫华,使用神里流·霜灭”May 13, 2023 pm 07:52 PM说到这两年风靡全球的国产游戏,原神肯定是当仁不让。根据5月公布的本年度Q1季度手游收入调查报告,在抽卡手游里《原神》以5.67亿美金的绝对优势稳稳拿下第一,这也宣告《原神》在上线短短18个月之后单在手机平台总收入就突破30亿美金(大约RM130亿)。如今,开放须弥前最后的2.8海岛版本姗姗来迟,在漫长的长草期后终于又有新的剧情和区域可以肝了。不过不知道有多少“肝帝”,现在海岛已经满探索,又开始长草了。宝箱总共182个+1个摩拉箱(不计入)长草期根本没在怕的,原神区从来不缺整活儿。这不,在长草期间

吵翻天!ChatGPT到底懂不懂语言?PNAS:先研究什么是「理解」吧Apr 07, 2023 pm 06:21 PM

吵翻天!ChatGPT到底懂不懂语言?PNAS:先研究什么是「理解」吧Apr 07, 2023 pm 06:21 PM机器会不会思考这个问题就像问潜水艇会不会游泳一样。——Dijkstra早在ChatGPT发布之前,业界就已经嗅到了大模型带来的变革。去年10月14日,圣塔菲研究所(Santa Fe Institute)的教授Melanie Mitchell和David C. Krakauer在arXiv发布了一篇综述,全面调研了所有关于「大规模预训练语言模型是否可以理解语言」的相关争论,文中描述了「正方」和「反方」的论点,以及根据这些论点衍生的更广泛的智力科学的关键问题。论文链接:https://arxiv.o

GPT4ALL:终极开源大语言模型解决方案May 17, 2023 am 11:02 AM

GPT4ALL:终极开源大语言模型解决方案May 17, 2023 am 11:02 AM开源语言模型生态系统正在兴起,这些生态系统为个人提供综合资源以创建用于研究和商业目的的语言应用程序。本文深入研究GPT4ALL,它通过提供全面的搭建模块,使任何人都能开发类似ChatGPT的聊天机器人,从而超越了特定的使用案例。什么是GPT4ALL项目?GPT4ALL可以在使用最先进的开源大型语言模型时提供所需一切的支持。它可以访问开源模型和数据集,使用提供的代码训练和运行它们,使用Web界面或桌面应用程序与它们交互,连接到Langchain后端进行分布式计算,并使用PythonAPI进行轻松集

学Python,还不知道main函数吗Apr 12, 2023 pm 02:58 PM

学Python,还不知道main函数吗Apr 12, 2023 pm 02:58 PMPython 中的 main 函数充当程序的执行点,在 Python 编程中定义 main 函数是启动程序执行的必要条件,不过它仅在程序直接运行时才执行,而在作为模块导入时不会执行。要了解有关 Python main 函数的更多信息,我们将从如下几点逐步学习:什么是 Python 函数Python 中 main 函数的功能是什么一个基本的 Python main() 是怎样的Python 执行模式Let’s get started什么是 Python 函数相信很多小伙伴对函数都不陌生了,函数是可

Azure AI的文本转语音功能已经支持41种多语言语音Aug 10, 2023 pm 07:05 PM

Azure AI的文本转语音功能已经支持41种多语言语音Aug 10, 2023 pm 07:05 PMMicrosoft的AzureAI文本转语音服务允许你将文本转换为不同语言的语音。今年年初,AzureAI文本转语音引入了JennyMultilingual语音,允许客户跨区域设置以一致的角色生成语音。到目前为止,Jenny多语言语音支持14种语言。今天,Microsoft宣布将多语言语音功能扩展到41种语言和口音。今天,Microsoft还宣布了一个新的男声(RyanMultilingual),作为其多语言产品组合的一部分。这些新语音具有输入文本的自动语言预测功能。因此,这消除了手动标记的需要

计算机硬件能直接识别并执行的语言是什么Dec 25, 2020 pm 03:16 PM

计算机硬件能直接识别并执行的语言是什么Dec 25, 2020 pm 03:16 PM计算机硬件能直接识别并执行的语言是机器语言。机器语言是机器能直接识别的程序语言或指令代码,无需经过翻译,每一操作码在计算机内部都有相应的电路来完成它。

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

AI Hentai Generator

免費產生 AI 無盡。

熱門文章

熱工具

SublimeText3 Linux新版

SublimeText3 Linux最新版

Atom編輯器mac版下載

最受歡迎的的開源編輯器

ZendStudio 13.5.1 Mac

強大的PHP整合開發環境

禪工作室 13.0.1

強大的PHP整合開發環境

VSCode Windows 64位元 下載

微軟推出的免費、功能強大的一款IDE編輯器