requests是python實作的簡單易用的HTTP函式庫,使用起來比urllib簡潔很多

因為是第三方函式庫,所以使用前需要cmd安裝

pip install requests

安裝完成後import一下,正常則表示可以開始使用了。

基本用法:

requests.get()用於請求目標網站,類型是一個HTTPresponse類型

import requests response = requests.get('http://www.baidu.com') print(response.status_code) # 打印状态码 print(response.url) # 打印请求url print(response.headers) # 打印头信息 print(response.cookies) # 打印cookie信息print(response.text) #以文本形式打印网页源码 print(response.content) #以字节流形式打印

運行結果:

#狀態碼:200

各種請求方式:

import requests requests.get('http://httpbin.org/get') requests.post('http://httpbin.org/post') requests.put('http://httpbin.org/put') requests.delete('http://httpbin.org/delete') requests.head('http://httpbin.org/get') requests.options('http://httpbin.org/get')

基本的get請求

import requests response = requests.get('http://httpbin.org/get')print(response.text)

帶參數的GET請求:

第一種直接將參數放在url內

import requests response = requests.get(http://httpbin.org/get?name=gemey&age=22)print(response.text)

解析json

import requests response = requests.get('http://httpbin.org/get') print(response.text) print(response.json()) #response.json()方法同json.loads(response.text) print(type(response.json()))

以上是python如何安裝requests模組的詳細內容。更多資訊請關注PHP中文網其他相關文章!

python中CURL和python requests的相互转换如何实现May 03, 2023 pm 12:49 PM

python中CURL和python requests的相互转换如何实现May 03, 2023 pm 12:49 PMcurl和Pythonrequests都是发送HTTP请求的强大工具。虽然curl是一种命令行工具,可让您直接从终端发送请求,但Python的请求库提供了一种更具编程性的方式来从Python代码中发送请求。将curl转换为Pythonrequestscurl命令的基本语法如下所示:curl[OPTIONS]URL将curl命令转换为Python请求时,我们需要将选项和URL转换为Python代码。这是一个示例curlPOST命令:curl-XPOSThttps://example.com/api

Python爬虫Requests库怎么使用May 16, 2023 am 11:46 AM

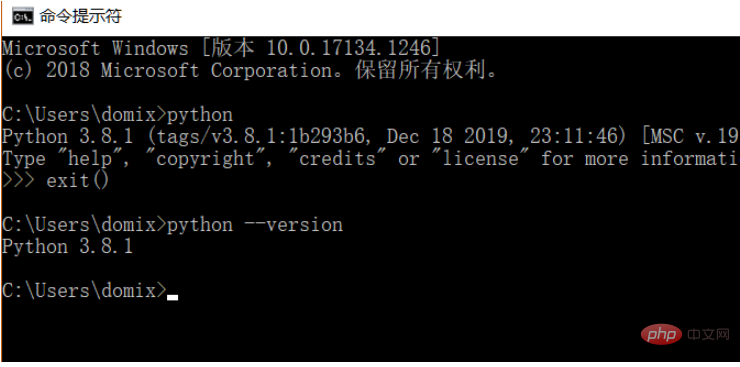

Python爬虫Requests库怎么使用May 16, 2023 am 11:46 AM1、安装requests库因为学习过程使用的是Python语言,需要提前安装Python,我安装的是Python3.8,可以通过命令python--version查看自己安装的Python版本,建议安装Python3.X以上的版本。安装好Python以后可以直接通过以下命令安装requests库。pipinstallrequestsPs:可以切换到国内的pip源,例如阿里、豆瓣,速度快为了演示功能,我这里使用nginx模拟了一个简单网站。下载好了以后,直接运行根目录下的nginx.exe程序就可

Python如何使用Requests请求网页Apr 25, 2023 am 09:29 AM

Python如何使用Requests请求网页Apr 25, 2023 am 09:29 AMRequests继承了urllib2的所有特性。Requests支持HTTP连接保持和连接池,支持使用cookie保持会话,支持文件上传,支持自动确定响应内容的编码,支持国际化的URL和POST数据自动编码。安装方式利用pip安装$pipinstallrequestsGET请求基本GET请求(headers参数和parmas参数)1.最基本的GET请求可以直接用get方法'response=requests.get("http://www.baidu.com/"

python requests post如何使用Apr 29, 2023 pm 04:52 PM

python requests post如何使用Apr 29, 2023 pm 04:52 PMpython模拟浏览器发送post请求importrequests格式request.postrequest.post(url,data,json,kwargs)#post请求格式request.get(url,params,kwargs)#对比get请求发送post请求传参分为表单(x-www-form-urlencoded)json(application/json)data参数支持字典格式和字符串格式,字典格式用json.dumps()方法把data转换为合法的json格式字符串次方法需要

使用Python的Requests和BeautifulSoup下载PDF文件Aug 30, 2023 pm 03:25 PM

使用Python的Requests和BeautifulSoup下载PDF文件Aug 30, 2023 pm 03:25 PMRequest和BeautifulSoup是可以在线下载任何文件或PDF的Python库。请求库用于发送HTTP请求和接收响应。BeautifulSoup库用于解析响应中收到的HTML并获取可下载的pdf链接。在本文中,我们将了解如何在Python中使用Request和BeautifulSoup下载PDF。安装依赖项在Python中使用BeautifulSoup和Request库之前,我们需要使用pip命令在系统中安装这些库。要安装request以及BeautifulSoup和Request库,

Python中使用Requests模块Sep 02, 2023 am 10:21 AM

Python中使用Requests模块Sep 02, 2023 am 10:21 AMRequests是一个Python模块,可用于发送各种HTTP请求。它是一个易于使用的库,具有许多功能,从在URL中传递参数到发送自定义标头和SSL验证。在本教程中,您将学习如何使用该库在Python中发送简单的HTTP请求。您可以在Python版本2.6–2.7和3.3–3.6中使用请求。在继续之前,您应该知道Requests是一个外部模块,因此在尝试本教程中的示例之前必须先安装它。您可以通过在终端中运行以下命令来安装它:pipinstallrequests安装模块后,您可以使用以下命令导入模

Python之requests怎么安装使用May 18, 2023 pm 07:49 PM

Python之requests怎么安装使用May 18, 2023 pm 07:49 PM1.准备工作首先呢,我们要确保我们已经之前安装requests库,如果没有安装,按照下面步骤按照库。pip安装无论是Windows、Linux还是Mac,都可以通过pip这个包管理工具来安装。在命令行下运行如下命令即可完成requests库的安装:pip3installrequests这是最简单的安装方式,推荐此种方法安装。验证安装为了验证库是否已经安装成功,可以在命令行下测试一下:importrequestsres=requests.get('https://www.baidu

Python爬虫之怎么使用BeautifulSoup和Requests抓取网页数据Apr 29, 2023 pm 12:52 PM

Python爬虫之怎么使用BeautifulSoup和Requests抓取网页数据Apr 29, 2023 pm 12:52 PM一、简介网络爬虫的实现原理可以归纳为以下几个步骤:发送HTTP请求:网络爬虫通过向目标网站发送HTTP请求(通常为GET请求)获取网页内容。在Python中,可以使用requests库发送HTTP请求。解析HTML:收到目标网站的响应后,爬虫需要解析HTML内容以提取有用信息。HTML是一种用于描述网页结构的标记语言,它由一系列嵌套的标签组成。爬虫可以根据这些标签和属性定位和提取需要的数据。在Python中,可以使用BeautifulSoup、lxml等库解析HTML。数据提取:解析HTML后,

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

AI Hentai Generator

免費產生 AI 無盡。

熱門文章

熱工具

Safe Exam Browser

Safe Exam Browser是一個安全的瀏覽器環境,安全地進行線上考試。該軟體將任何電腦變成一個安全的工作站。它控制對任何實用工具的訪問,並防止學生使用未經授權的資源。

SAP NetWeaver Server Adapter for Eclipse

將Eclipse與SAP NetWeaver應用伺服器整合。

SublimeText3漢化版

中文版,非常好用

DVWA

Damn Vulnerable Web App (DVWA) 是一個PHP/MySQL的Web應用程序,非常容易受到攻擊。它的主要目標是成為安全專業人員在合法環境中測試自己的技能和工具的輔助工具,幫助Web開發人員更好地理解保護網路應用程式的過程,並幫助教師/學生在課堂環境中教授/學習Web應用程式安全性。 DVWA的目標是透過簡單直接的介面練習一些最常見的Web漏洞,難度各不相同。請注意,該軟體中

Dreamweaver Mac版

視覺化網頁開發工具