Qwen剛剛發布了8種新車型,作為其最新家族Qwen3的一部分,展示了有希望的功能。旗艦型號QWEN3-235B-A22B優於其他大多數型號,包括DeepSeek-R1,OpenAi的O1,O3-Mini,Grok 3和Gemini 2.5-Pro,在標準基準測試中。同時,小QWEN3-30B-A3B的表現優於QWQ-32B,其作為新模型的活性參數約為10倍。具有如此高級的功能,這些模型被證明是廣泛應用程序的絕佳選擇。在本文中,我們將探討所有QWEN3模型的功能,並學習如何使用它們來構建抹布系統和AI代理。

目錄

- 什麼是qwen3?

- qwen3的主要特徵

- 如何通過API訪問QWEN3型號

- 使用qwen3為您的AI解決方案供電

- 先決條件

- 使用qwen3構建AI代理

- 使用qwen3構建抹布系統

- Qwen3的應用

- 結論

- 常見問題

什麼是qwen3?

Qwen3是QWEN家族中最新系列的大型語言模型(LLM),由8種不同的模型組成。其中包括QWEN3-235B-A22B,QWEN3-30B-A3B,QWEN3-32B,QWEN3-14B,QWEN3-8B,QWEN3-4B,QWEN3-1.7B和QWEN3-0.6B。所有這些模型均在Apache 2.0許可下發布,使其可向個人,開發人員和企業免費使用。

儘管其中6個模型是密集的,但這意味著它們在推理和培訓期間積極使用所有參數,但其中2個是開放加權的:

- QWEN3-235B-A22B:具有2350億參數的大型模型,其中220億個是激活參數。

- QWEN3-30B-A3B:一個較小的MUE,總參數為30億和30億個激活參數。

這是所有8種QWEN3模型的詳細比較:

| 型號 | 層 | 頭(Q/KV) | 領帶嵌入 | 上下文長度 |

| QWEN3-0.6B | 28 | 16/8 | 是的 | 32K |

| qwen3-1.7b | 28 | 16/8 | 是的 | 32K |

| qwen3-4b | 36 | 32/8 | 是的 | 32K |

| qwen3-8b | 36 | 32/8 | 不 | 128K |

| Qwen3-14b | 40 | 40/8 | 不 | 128K |

| QWEN3-32B | 64 | 64/8 | 不 | 128K |

| QWEN3-30B-A3B | 48 | 32/4 | 不 | 128K |

| QWEN3-235B-A22B | 94 | 64/4 | 不 | 128K |

這是桌子所說的:

-

層:圖層表示所使用的變壓器塊的數量。它包括多頭自我發揮機制,飼料向前網絡,位置編碼,層歸一化和剩餘連接。因此,當我說QWEN3-30B-A3B具有48層時,這意味著該模型使用48個變壓器塊,依次或併行堆疊。

-

頭:變形金剛使用多頭注意力,將其註意力機制分為幾個頭部,每個人都從數據中學習新方面。在這裡,Q/KV代表:

- Q(查詢頭):用於生成查詢的注意力頭的總數。

- KV(密鑰和值):每個注意塊的密鑰/值頭的數量。

注意:這些關注,查詢和價值的注意力與自我發揮產生的密鑰,查詢和值向量完全不同。

另請閱讀:QWEN3模型:如何訪問,性能,功能和應用程序

qwen3的主要特徵

以下是QWEN3模型的一些關鍵功能:

-

預訓練:訓練過程包括三個階段:

- 在第一階段,該模型在30萬億個令牌上進行了預測,上下文長度為4K令牌。這教授了模型的基本語言技能和常識。

- 在第二階段,通過增加諸如STEM,編碼和推理任務等知識密集數據的比例來提高數據質量。然後對模型進行了另外5萬億代幣的訓練。

- 在最後階段,通過將上下文長度增加到32K令牌來使用高質量的長上下文數據。這樣做是為了確保模型可以有效處理更長的輸入。

-

訓練後:為了開發能夠逐步推理和快速響應的混合模型,實施了四階段的訓練管道。這包括:

- 長鏈(COT)

- 基於推理的強化學習(RL)

- 思維模式融合

- 一般RL

-

混合思維模式: QWEN3模型採用混合方法來解決問題,具有兩種新模式:

- 思考模式:在這種模式下,模型會花費時間將復雜的問題語句分解為小的程序步驟來解決它。

- 非思想模式:在此模式下,模型提供了快速的結果,並且主要適合簡單的問題。

- 多語言支持: QWEN3模型支持119種語言和方言。這可以幫助來自世界各地的用戶從這些模型中受益。

- 即興代理能力: QWEN優化了QWEN3模型,以提高編碼和代理功能,並支持模型上下文協議(MCP)。

如何通過API訪問QWEN3型號

要使用QWEN3型號,我們將使用OpenRouter API通過API訪問它。這是這樣做的方法:

- 在OpenRouter上創建一個帳戶,然後轉到模型搜索欄以找到該模型的API。

- 選擇您選擇的模型,然後在著陸頁面上單擊“創建API密鑰”以生成新的API。

使用qwen3為您的AI解決方案供電

在本節中,我們將使用QWEN3構建AI應用程序的過程。我們將首先使用模型創建AI驅動的旅行計劃者代理,然後使用Langchain創建Q/A rag機器人。

先決條件

在使用QWEN3構建一些現實世界AI解決方案之前,我們需要首先介紹基本先決條件,例如:

- 熟悉命令提示或終端以及通過終端運行它們的能力。

- 能夠設置環境變量。

- python必須安裝:https://www.python.org/downloads/

- 關於Langchain的基礎知識:https://www.langchain.com/

使用qwen3構建AI代理

在本節中,我們將使用QWEN3創建一個AI驅動的旅行社,該旅行社將為您所訪問的城市或地方提供主要的旅行地點。我們還將使代理商能夠搜索Internet以查找更新的信息,並添加一個啟用貨幣轉換的工具。

步驟1:設置庫和工具

首先,我們將安裝和導入構建代理所需的必要庫和工具。

!

來自langchain.chat_models導入chatopenai

來自langchain。代理導入工具

來自langchain.tools進口Duckduckgosearchrun

來自langchain.satent

llm = chatopenai(

base_url =“ https://openrouter.ai/api/v1”,

api_key =“ your_api_key”,

型號=“ qwen/qwen3-235b-a22b:免費”

)

#網絡搜索工具

搜索= DuckDuckgoSearchRun()

#目標工具

def get_destination(目的地):

返回search.run(f“ {destination}}中的前3個旅遊景點”)

destinationTool =工具(

名稱=“目標推薦”,

func = get_destinations,

描述=“在城市找到最高的地方”

)

#貨幣工具

def convert_usd_to_inr(查詢):

量= [float(s)for query.split()if s.replace('。',',',1).isdigit()]

如果金額:

返回f“ {量[0]} usd = {量[0] * 83.2:.2f} inr”

返回“無法解釋金額”。

貨幣工具=工具(

名稱=“貨幣轉換器”,

func = convert_usd_to_inr,

描述=“根據靜態率將USD轉換為INR”

)

- search_tool: duckduckgosearchrun()使代理商可以使用Web搜索獲取有關流行旅遊景點的實時信息。

- DestinationTool:應用GET_DESTINATIONS()函數,該功能使用搜索工具在任何給定的城市中獲取前三名旅遊景點。

- 貨幣工具:使用convert_usd_to_inr()函數將價格從美元轉換為INR。您可以在功能中更改“ INR”,以將其轉換為您選擇的貨幣。

另請閱讀:與Huggingface,Langchain和Mistralai建立旅行助理聊天機器人

步驟2:創建代理

現在,我們已經初始化了所有工具,讓我們繼續創建一個可以使用工具並為旅行計劃的代理。

工具= [destinationTool,貨幣托工具]

代理= initialize_agent(

工具=工具,

llm = llm,

agent_type =“零射擊反應描述”,

冗長= true

)

def trip_planner(城市,usd_budget):

dest = get_destinations(城市)

inr_budget = convert_usd_to_inr(f“ {usd_budget} usd usd to inr”)

返回f“”這是您的旅行計劃:

*{city}*中的頂部斑點:

{dest}

*預算*:

{inr_budget}

享受您的一日遊! ”“”

- initialize_agent:此函數使用零拍反應方法創建用蘭鏈的代理,從而使代理可以理解工具描述。

- Agent_Type: “零射擊反應描述”使Agent LLM使用工具說明和輸入來確定在沒有事先知識的情況下應在某些情況下使用哪種工具。

- 冗長:冗長可以啟用代理商思維過程的記錄,因此我們可以監視代理做出的每個決定,包括所調用的所有交互和工具。

- Trip_planner:這是一個Python函數,它可以手動調用工具而不是依靠代理。它允許用戶為特定問題選擇最佳工具。

步驟3:初始化代理

在本節中,我們將初始化代理並觀察其響應。

#初始化代理

城市=“德里”

USD_BUDGET = 8500

#運行多代理計劃者

響應= agent.run(f“計劃一日遊{city},預算為{usd_budget} usd”)

從ipython.display導入降價,顯示

顯示(Markdown(響應))

- 代理的調用: Agent.run()通過提示使用用戶的意圖併計劃旅行。

輸出

使用qwen3構建抹布系統

在本節中,我們將創建一個RAG機器人,該機器人可以從知識庫中回答相關輸入文檔中的任何查詢。這提供了使用QWEN/QWEN3-235B-A22B的信息響應。該系統還將使用Langchain來產生準確和上下文感知的響應。

步驟1:設置庫和工具

首先,我們將安裝和導入構建抹布系統所需的必要庫和工具。

! 來自langchain_community.document_loaders import textloader 來自langchain.text_splitter導入tarnextsplitter 來自langchain_community.vectorstores導入色度 來自langchain.embeddings進口 從Langchain。鏈接進口檢索 來自langchain.chat_models導入chatopenai #加載您的文檔 loader = textloader(“/content/my_docs.txt”) docs = loader.load()

- 加載文檔: Langchain的“ Textloader”類將文檔加載文檔,例如PDF,TXT或DOC文件,該文件將用於Q/A檢索。在這裡,我已經上傳了my_docs.txt。

- 選擇矢量設置:我已經使用Chromadb來存儲和搜索矢量數據庫中的嵌入式Q/A過程。

步驟2:創建嵌入

現在,我們已經加載了文檔,讓我們繼續從中創建嵌入式,這將有助於放鬆檢索過程。

#分成大塊

splitter = prinateTextSplitter(chunk_size = 300,chunk_overlap = 50)

塊= splitter.split_documents(文檔)

#帶有擁抱面模型

embeddings = huggingFaceEmbedDings(model_name =“ all-minilm-l6-v2”)

db = chroma.from_documents(塊,嵌入=嵌入)

#設置Qwen llm來自OpenRouter

llm = chatopenai(

base_url =“ https://openrouter.ai/api/v1”,

api_key =“ your_api_key”,

型號=“ qwen/qwen3-235b-a22b:免費”

)

#創建抹布鏈

refierver = db.as_retriever(search_kwargs = {“ k”:2})

rag_chain = reterievalqa.from_chain_type(llm = llm,retriever = retriever)

- 文檔分配: targintextsplitter()將文本分成較小的塊,這將主要在兩件事中有所幫助。首先,它可以簡化檢索過程,其次,它有助於通過chunk_overlap從以前的塊中保留上下文。

- 嵌入文檔:嵌入文本將文本轉換為每個令牌設定維的嵌入向量。在這裡,我們使用的是300的chunk_size,這意味著每個單詞/令牌都將轉換為300維的向量。現在,此向量嵌入將對塊中的其他單詞具有該詞的所有上下文信息。

- 抹布鏈:抹布鏈將Chromadb與LLM結合在一起,形成抹布。這使我們能夠從文檔以及模型中獲得上下文意識的答案。

步驟3:初始化抹布系統

#問一個問題

響應= rag_chain.invoke({“ query”:“我該如何與MCP一起使用QWEN。請給我一個逐步指南以及必要的代碼shippets'})

顯示(Markdown(響應['result']))

- 查詢執行: RAG_CHAIN_INVOKE()方法將將用戶的查詢發送到抹布系統,然後從文檔存儲(Vector DB)檢索相關的上下文感知塊,並生成上下文感知的答案。

輸出

您可以在此處找到完整的代碼。

Qwen3的應用

以下是Qwen3在各行業中的更多應用:

- 自動編碼: QWEN3可以生成,調試並提供代碼文檔,這可以幫助開發人員無需手動努力解決錯誤。其22B參數模型在編碼方面表現出色,具有與DeepSeek-R1,Gemini 2.5 Pro和OpenAI的O3-Mini等模型相當的性能。

- 教育與研究: QWEN3存檔數學,物理學和邏輯推理問題的準確性很高。它也可以媲美雙子座2.5 pro,而擅長於Openai的O1,O3-Mini,DeepSeek-R1和Grok 3 Beta。

- 基於代理的工具集成: QWEN3還允許使用其工具稱呼模板將外部工具,API和MCP用於多步和多代理工作流程,從而在AI代理任務中領導。

- 高級推理任務: QWEN3使用廣泛的思維能力來提供最佳和準確的響應。該模型使用經過想法的鏈條來進行複雜的任務和非思想模式以進行優化的速度。

結論

在本文中,我們學會瞭如何構建QWEN3驅動的代理AI和抹布系統。 Qwen3的高性能,多語言支持和高級推理能力使其成為知識檢索和基於代理的任務的強大選擇。通過將QWEN3集成到抹布和代理管道中,我們可以得到準確,上下文感知和平穩的響應,從而使其成為AI驅動系統現實世界應用程序的有力競爭者。

常見問題

Q1。 QWEN3與其他LLM的抹布有何不同?A. QWEN3具有混合推理能力,使其可以對響應進行動態更改,從而使其可以優化抹布工作流程,以進行檢索和復雜分析。

Q2。整合抹布所需的工具是什麼?答:它主要包括矢量數據庫,嵌入模型,蘭鏈工作流程和訪問模型的API。

Q3。 Qwen3可以允許代理工作流中的多步工具鏈接嗎?是的,借助QWEN代理的內置工具調用模板,我們可以解析並啟用順序工具操作,例如Web搜索,數據分析和報告生成。

Q4。如何減少QWEN3代理響應中的延遲?答:可以在許多方面降低潛伏期,其中一些是:

1。使用QWEN3-30B-A3B之類的MOE模型,該模型只有30億個活動參數。

2。使用GPU優化的推論。

答:常見錯誤包括:

1。 MCP服務器初始化失敗,例如JSON格式和初始化。

2。工具響應配對錯誤。

3。上下文窗口溢出。

以上是如何使用qwen3構建抹布系統和AI代理的詳細內容。更多資訊請關注PHP中文網其他相關文章!

7強大的AI提示每個項目經理現在需要掌握May 08, 2025 am 11:39 AM

7強大的AI提示每個項目經理現在需要掌握May 08, 2025 am 11:39 AM聊天機器人像Chatgpt這樣的聊天機器人舉例說明了生成的AI,為項目經理提供了功能強大的工具來簡化工作流程並確保項目按計劃和預算範圍內保持。 但是,在製作正確的提示時有效使用鉸鏈。 精確,細節

通過AI本身的有益協助,定義難以捉摸的AGI的含義不明的含義May 08, 2025 am 11:37 AM

通過AI本身的有益協助,定義難以捉摸的AGI的含義不明的含義May 08, 2025 am 11:37 AM定義人工智能(AGI)的挑戰是重大的。 AGI進步的主張通常缺乏明確的基準,其定義是針對預定的研究方向而定制的。本文探討了一種新穎的定義方法

IBM認為2025展示watsonx.data在生成AI中的作用May 08, 2025 am 11:32 AM

IBM認為2025展示watsonx.data在生成AI中的作用May 08, 2025 am 11:32 AMIBM WATSONX.DATA:簡化企業AI數據堆棧 IBM將WATSONX.DATA定位為企業的關鍵平台,旨在加速精確而可擴展的生成AI解決方案。 這是通過簡化投訴來實現的

人形機器人機器的崛起即將到來。May 08, 2025 am 11:29 AM

人形機器人機器的崛起即將到來。May 08, 2025 am 11:29 AM在AI和材料科學領域的突破所推動的機器人技術的快速進步已準備好迎來人類機器人的新時代。 多年來,工業自動化一直是主要重點,但是機器人的功能迅速exp

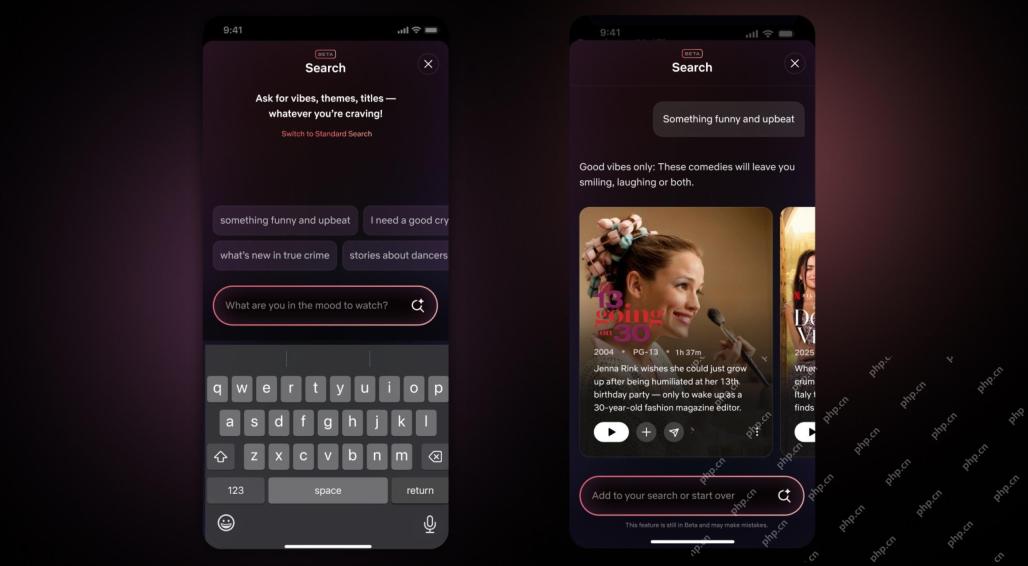

Netflix重新修改界面 - 首次亮相AI搜索工具和類似Tiktok的設計May 08, 2025 am 11:25 AM

Netflix重新修改界面 - 首次亮相AI搜索工具和類似Tiktok的設計May 08, 2025 am 11:25 AMNetflix 界面十年來最大更新:更智能、更個性化,擁抱多元內容 Netflix 週三宣布對其用戶界面進行十年來最大規模的改版,不僅外觀煥然一新,還增加了更多關於每個節目的信息,並引入了更智能的 AI 搜索工具,能夠理解模糊的概念(例如“氛圍”),以及更靈活的結構,以便更好地展示公司在新興的視頻遊戲、直播活動、體育賽事和其他新型內容方面的興趣。 為了緊跟潮流,新的移動端豎屏視頻組件將使粉絲更容易滾動瀏覽預告片和片段,觀看完整節目或與他人分享內容。這讓人聯想起無限滾動且非常成功的短視頻網站 Ti

在AGI之前很久:三個AI里程碑會挑戰您May 08, 2025 am 11:24 AM

在AGI之前很久:三個AI里程碑會挑戰您May 08, 2025 am 11:24 AM人工智能通用智能(AGI)的討論日益增多,促使許多人思考當人工智能超越人類智能時會發生什麼。這個時刻是近在咫尺還是遙遙無期,取決於你問誰,但我認為這並非我們應該關注的最重要的里程碑。哪些更早的人工智能里程碑會影響到每個人?哪些里程碑已經實現?以下是我認為已經發生的三件事。 人工智能超越人類弱點 在2022年的電影《社交困境》中,人文科技中心(Center for Humane Technology)的崔斯坦·哈里斯指出,人工智能已經超越了人類的弱點。這是什麼意思?這意味著人工智能已經能夠運用人類

Venkat Achanta在Transunion的平台轉型和AI野心May 08, 2025 am 11:23 AM

Venkat Achanta在Transunion的平台轉型和AI野心May 08, 2025 am 11:23 AMTransunion的首席技術官Ranganath Achanta在2021年末加入公司後加入公司以來,率先進行了重大的技術轉變。

當對AI的信任躍升時,生產力會隨之而來May 08, 2025 am 11:11 AM

當對AI的信任躍升時,生產力會隨之而來May 08, 2025 am 11:11 AM建立信任至關重要,對於成功採用業務的AI是至關重要的。 考慮到業務流程中的人類因素,這尤其如此。 像其他任何人一樣,員工對AI及其實施引起了人們的關注。 德勤研究人員是SC

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

SublimeText3 Linux新版

SublimeText3 Linux最新版

Dreamweaver Mac版

視覺化網頁開發工具

EditPlus 中文破解版

體積小,語法高亮,不支援程式碼提示功能

ZendStudio 13.5.1 Mac

強大的PHP整合開發環境

MantisBT

Mantis是一個易於部署的基於Web的缺陷追蹤工具,用於幫助產品缺陷追蹤。它需要PHP、MySQL和一個Web伺服器。請查看我們的演示和託管服務。