本文探討了四種突出的大語言模型(LLMS)的功能:Bert,Distilbert,Bart和T5,重點介紹其在文本摘要和問題回答中的應用。每個模型都具有獨特的建築優勢,從而影響了性能和效率。比較分析利用CNN/Dailymail數據集進行匯總,並將小隊數據集用於問答。

學習目標:參與者將學會區分這些LLM,了解文本摘要的核心原理和問題答案,根據計算需求和所需的輸出質量選擇適當的模型,實際實施這些模型,並使用現實世界中的數據集分析結果。

文本摘要:文章與Bart和T5進行了對比。 BART是一種雙向和自回歸的變壓器,在產生左右摘要之前,在雙向上進行了雙向處理文本,將Bert的雙向方法與GPT的自動回歸產生相結合。 T5是一種文本轉換變壓器,會產生抽象性摘要,通常會重新闡述內容以提出簡潔性。儘管T5通常更快,但在某些情況下,BART可能會表現出較高的流利度。

問題回答:比較著重於伯特和迪士伯特。雙向編碼器伯特(Bert)擅長理解上下文含義,並確定相關的文本細分以準確回答問題。 Distilbert是BERT的較小版本,可以通過減少的計算需求獲得可比的結果。儘管Bert為複雜查詢提供了更高的精度,但Distilbert的速度對於優先級快速響應時間的應用是有利的。

代碼實現和數據集:本文提供了使用transformers和datasets集庫的Python代碼,可以從擁抱面前進行。使用CNN/Dailymail數據集(用於摘要)和小隊數據集(用於答案)。每個數據集的一個子集用於效率。該代碼演示了每個模型的管道創建,數據集加載和性能評估。

績效分析和結果:該代碼包括分析摘要和提問績效的功能,衡量準確性和處理時間。結果顯示在表中,將每個模型產生的摘要和答案與它們各自的處理時間進行比較。這些結果突出了速度和產出質量之間的權衡。

關鍵見解和結論:分析表明,較輕的模型(Distilbert和T5)優先考慮速度,而較大的模型(Bert和Bart)優先級準確性和細節。模型的選擇取決於特定應用程序的要求,平衡速度和準確性。本文總結了關鍵外賣,並回答有關模型及其應用的常見問題。

以上是比較LLM的文本摘要和問題回答的詳細內容。更多資訊請關注PHP中文網其他相關文章!

研究數據持續多長時間?解釋如何獲取最新信息May 14, 2025 am 04:17 AM

研究數據持續多長時間?解釋如何獲取最新信息May 14, 2025 am 04:17 AM使用最新數據的Chatgpt可能性和技巧:插件,瀏覽和副詞 Chatgpt具有業務和學習的巨大潛力,但是學習數據的限制至2021年(GPT-3.5)。在本文中,我們將解釋如何使用插件和瀏覽功能,特定的使用示例以及與其他AI語言模型進行比較。 獲得知識和技能,有效地利用Chatgpt。 Openai的最新AI代理“ Openai Deep Research”

易於理解的解釋如何使用ChatGpt提高庫存管理效率!May 14, 2025 am 03:44 AM

易於理解的解釋如何使用ChatGpt提高庫存管理效率!May 14, 2025 am 03:44 AM即使對於中小型企業,易於實施!與Chatgpt和Excel的明智庫存管理 庫存管理是您業務的命脈。儲存過多和庫存的物品對現金流和客戶滿意度有嚴重影響。但是,目前的情況是,在成本方面引入全尺度庫存管理系統很高。 您想關注的是Chatgpt和Excel的組合。在本文中,我們將逐步解釋如何使用此簡單方法簡化庫存管理。 自動化數據分析,需求預測和報告以顯著提高運營效率等任務。而且,

易於理解的解釋如何檢查和切換chatgpt的版本!May 14, 2025 am 03:43 AM

易於理解的解釋如何檢查和切換chatgpt的版本!May 14, 2025 am 03:43 AM通過選擇chatgpt版本明智地使用AI!對最新信息以及如何檢查的詳盡說明 Chatgpt是一種不斷發展的AI工具,但其功能和性能因版本而異。在本文中,我們將以易於理解的方式解釋每個版本的Chatgpt的功能,如何檢查最新版本以及免費版本和付費版本之間的差異。選擇最佳版本,並充分利用您的AI潛力。 單擊此處以獲取有關Openai最新AI代理OpenAi Deep Research⬇️的更多信息 [chatgpt] openai d

解釋為什麼您不能將信用卡與Chatgpt的付費計劃一起使用以及如何處理的原因May 14, 2025 am 03:32 AM

解釋為什麼您不能將信用卡與Chatgpt的付費計劃一起使用以及如何處理的原因May 14, 2025 am 03:32 AMChatGPT付費訂閱的信用卡支付故障排除指南 使用ChatGPT付費訂閱時,信用卡支付可能會遇到問題。本文將探討信用卡被拒的原因以及相應的解決方法,從用戶自行解決的問題到需要聯繫信用卡公司的情況,提供詳盡的指南,助您順利使用ChatGPT付費訂閱。 OpenAI發布的最新AI代理,“OpenAI Deep Research”詳情請點擊⬇️ 【ChatGPT】OpenAI Deep Research詳解:使用方法及收費標準 目錄 ChatGPT信用卡支付失敗的原因 原因一:信用卡信息輸入錯誤 原

易於理解的解釋如何在Chatgpt中創建VBA宏!May 14, 2025 am 02:40 AM

易於理解的解釋如何在Chatgpt中創建VBA宏!May 14, 2025 am 02:40 AM對於初學者和對業務自動化感興趣的人,編寫VBA腳本(Microsoft Office的擴展程序)可能會覺得很困難。但是,ChatGpt使簡化和自動化業務流程變得容易。 本文以易於理解的方式解釋瞭如何使用ChatGpt開發VBA腳本。我們將詳細介紹特定的示例,包括從VBA的基礎到使用ChatGpt集成,測試和調試的所有內容,以及要注意的好處和點。為了提高編程技能並提高業務效率,

我無法使用ChatGpt插件功能!解釋在錯誤時該怎麼做May 14, 2025 am 01:56 AM

我無法使用ChatGpt插件功能!解釋在錯誤時該怎麼做May 14, 2025 am 01:56 AMChatGPT插件無法使用?這篇指南將幫助您解決問題!您是否遇到過ChatGPT插件無法使用或突然失效的情況? ChatGPT插件是提升用戶體驗的強大工具,但有時也會出現故障。本文將詳細分析ChatGPT插件無法正常工作的原因,並提供相應的解決方法。從用戶設置檢查到服務器故障排查,我們涵蓋了各種故障排除方案,助您高效利用插件完成日常任務。 OpenAI發布的最新AI代理——OpenAI Deep Research,詳情請點擊⬇️ [ChatGPT] OpenAI Deep Research詳解:使

chatgpt是否不遵循字符計數規範?關於如何處理這個問題的詳盡解釋!May 14, 2025 am 01:54 AM

chatgpt是否不遵循字符計數規範?關於如何處理這個問題的詳盡解釋!May 14, 2025 am 01:54 AM在使用chatgpt編寫句子時,有時您想指定字符數。但是,很難準確預測AI生成的句子的長度,並且匹配指定數量的字符並不容易。 在本文中,我們將解釋如何創建一個句子,其中chatgpt中的字符數量。我們將介紹有效的及時寫作,獲取適合您目的的答案的技術,並教您處理角色限制的技巧。此外,我們將解釋為什麼Chatgpt不擅長指定角色的數量及其工作方式,以及要謹慎和對策的要點。 本文

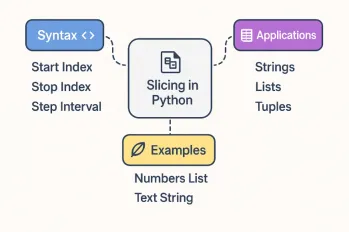

關於Python切片操作的所有內容May 14, 2025 am 01:48 AM

關於Python切片操作的所有內容May 14, 2025 am 01:48 AM對於每個Python程序員,無論是在數據科學和機器學習的領域還是軟件開發領域,Python切片操作都是最有效,最多功能和強大的操作之一。 Python切片語法

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

mPDF

mPDF是一個PHP庫,可以從UTF-8編碼的HTML產生PDF檔案。原作者Ian Back編寫mPDF以從他的網站上「即時」輸出PDF文件,並處理不同的語言。與原始腳本如HTML2FPDF相比,它的速度較慢,並且在使用Unicode字體時產生的檔案較大,但支援CSS樣式等,並進行了大量增強。支援幾乎所有語言,包括RTL(阿拉伯語和希伯來語)和CJK(中日韓)。支援嵌套的區塊級元素(如P、DIV),

SublimeText3漢化版

中文版,非常好用

WebStorm Mac版

好用的JavaScript開發工具

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver Mac版

視覺化網頁開發工具