如果您正在步入大數據世界,您可能聽說過 Apache Spark,這是一個強大的分散式運算系統。 PySpark 是 Apache Spark 的 Python 函式庫,因其速度、可擴展性和易用性的結合而深受資料愛好者的喜愛。但在本地電腦上設定它一開始可能會感覺有點嚇人。

不用擔心 - 本文將引導您完成整個過程,解決常見問題並使整個過程盡可能簡單。

什麼是 PySpark,為什麼要關心?

在開始安裝之前,我們先來了解一下 PySpark 是什麼。 PySpark 讓您可以使用 Python 來利用 Apache Spark 的強大運算能力。無論您是分析TB 級資料、建立機器學習模型還是運行ETL(Extract、Transform、Load)管道,PySpark 都可以讓您使用資料比以往更有效率。

現在您已經了解了 PySpark,讓我們來完成安裝過程。

第 1 步:確保您的系統符合要求

PySpark 在各種電腦上運行,包括 Windows、macOS 和 Linux。以下是成功安裝所需的內容:

- Java 開發套件 (JDK):PySpark 需要 Java(建議使用版本 8 或 11)。

- Python:確保您有 Python 3.6 或更高版本。

- Apache Spark Binary:您將在安裝過程中下載它。

要檢查您的系統準備:

- 開啟終端機或指令提示字元。

- 輸入 java -version 和 python —version 以確認 Java 和 Python 安裝。

如果您沒有安裝 Java 或 Python,請依照下列步驟操作:

- 對於Java:從Oracle官網下載。

- 對於 Python:存取 Python 的下載頁面。

第 2 步:安裝 Java

Java 是 Apache Spark 的支柱。安裝方法:

1.下載 Java:造訪 Java SE 開發工具包下載頁面。選擇適合您的作業系統的版本。

2.安裝 Java:執行安裝程式並依照指示操作。在 Windows 上,您需要設定 JAVA_HOME 環境變數。為此:

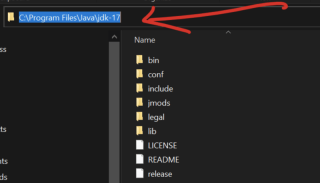

- 複製路徑變量,進入您機器上的本機磁碟,選擇program files,找java資料夾打開它你會看到jdk-17(你自己的版本可能不是 17)。打開它,你將能夠看到你的路徑並複製如下

在 Windows 搜尋列中搜尋 環境變數。

在系統變數下,按一下新建並將變數名稱設為JAVA_HOME,並將數值設為您在上面複製的Java安裝路徑(例如,C:Program檔案Javajdk-17)。

3.驗證安裝:開啟終端機或指令提示字元並輸入java-version。

步驟 3:安裝 Apache Spark

1.下載 Spark:造訪 Apache Spark 網站並選擇適合您需求的版本。使用 Hadoop 的預先建置套件(與 Spark 的常見配對)。

2.解壓縮檔:

- 在 Windows 上,使用 WinRAR 或 7-Zip 等工具來擷取檔案。

- 在 macOS/Linux 上,使用指令 tar -xvf Spark-.tgz

3.設定環境變數:

- 對於 Windows:將 Spark 的 bin 目錄加入系統的 PATH 變數。

- 對於 macOS/Linux:將以下行加入 .bashrc 或 .zshrc 或

export SPARK_HOME=/path/to/spark export PATH=$SPARK_HOME/bin:$PATH

檔案

4.

驗證安裝:開啟終端機並輸入spark-shell。您應該會看到 Spark 的互動式 shell 啟動。

-

第 4 步:安裝 Hadoop(可選但建議)

- 雖然 Spark 並不嚴格要求 Hadoop,但許多用戶安裝它是為了支援 HDFS(Hadoop 分散式檔案系統)。要安裝 Hadoop:

解壓縮檔案並設定 HADOOP_HOME 環境變數。

pip install pyspark

使用 Python 的 pip 工具安裝 PySpark 變得輕而易舉。只要運行:

pip install pysparkark.__version__)

要進行驗證,請開啟 Python shell 並輸入:

如果您看到版本號,恭喜! PySpark 已安裝?

步驟 6:測試您的 PySpark 安裝

樂趣就從這裡開始。讓我們確保一切順利:

from pyspark.sql import SparkSession

spark = SparkSession.builder.appName("PySparkTest").getOrCreate()

data = [("Alice", 25), ("Bob", 30), ("Cathy", 29)]

columns = ["Name", "Age"]

df = spark.createDataFrame(data, columns)

df.show()

:開啟文字編輯器並貼上以下程式碼:

另存為 test_pyspark.py執行腳本:

在終端機中,導航到腳本的目錄並輸入:

export SPARK_HOME=/path/to/spark export PATH=$SPARK_HOME/bin:$PATH

您應該會看到一個格式整齊的表格,其中顯示姓名和年齡。

常見問題故障排除

即使有最好的指導,也會出現問題。以下是一些常見問題和解決方案:

問題:java.lang.NoClassDefFoundError

解:仔細檢查您的 JAVA_HOME 和 PATH 變數。問題:PySpark安裝成功,但測試腳本失敗。

解決方案:確保您使用的是正確的 Python 版本。有時,虛擬環境可能會導致衝突。問題:spark-shell 指令不起作用。

解決方案:驗證 Spark 目錄是否已正確加入您的 PATH 。

為什麼在本地使用 PySpark?

許多使用者想知道為什麼要在本機上安裝 PySpark,因為 PySpark 主要用於分散式系統。原因如下:

- 學習:無需叢集即可實驗和學習 Spark 概念。

- 原型設計:在將小數據作業部署到更大的環境之前在本地測試它們。

- 方便:輕鬆偵錯問題並開發應用程式。

提高您的 PySpark 生產力

要充分利用 PySpark,請考慮以下提示:

設定虛擬環境:使用 venv 或 conda 等工具來隔離 PySpark 安裝。

與 IDE 整合:PyCharm 和 Jupyter Notebook 等工具讓 PySpark 開發更具互動性。

利用 PySpark 文件:存取 Apache Spark 的文件以取得深入指導。

參與 PySpark 社區

陷入困境是正常的,尤其是使用 PySpark 這樣強大的工具時。與充滿活力的 PySpark 社區聯繫以尋求幫助:

加入論壇:像 Stack Overflow 這樣的網站有專用的 Spark 標籤。

參加派對:Spark 和 Python 社群經常舉辦可供您學習和交流的活動。

關注部落格:許多數據專業人士在線上分享他們的經驗和教學。

結論

在本機上安裝 PySpark 起初可能看起來令人畏懼,但遵循這些步驟使其易於管理且有益。無論您是剛開始資料之旅還是提陞技能,PySpark 都能為您提供解決現實資料問題的工具。

PySpark 是 Apache Spark 的 Python API,是資料分析和處理的遊戲規則改變者。雖然它的潛力巨大,但在本地電腦上設定它可能會讓人感到具有挑戰性。本文逐步分解這個過程,涵蓋從安裝 Java 和下載 Spark 到使用簡單腳本測試您的設定的所有內容。

透過在本地安裝 PySpark,您可以建立資料工作流程原型、學習 Spark 的功能並測試小型項目,而無需完整叢集。

以上是如何在本機上安裝 PySpark的詳細內容。更多資訊請關注PHP中文網其他相關文章!

Python中的合併列表:選擇正確的方法May 14, 2025 am 12:11 AM

Python中的合併列表:選擇正確的方法May 14, 2025 am 12:11 AMTomergelistsinpython,YouCanusethe操作員,estextMethod,ListComprehension,Oritertools

如何在Python 3中加入兩個列表?May 14, 2025 am 12:09 AM

如何在Python 3中加入兩個列表?May 14, 2025 am 12:09 AM在Python3中,可以通過多種方法連接兩個列表:1)使用 運算符,適用於小列表,但對大列表效率低;2)使用extend方法,適用於大列表,內存效率高,但會修改原列表;3)使用*運算符,適用於合併多個列表,不修改原列表;4)使用itertools.chain,適用於大數據集,內存效率高。

Python串聯列表字符串May 14, 2025 am 12:08 AM

Python串聯列表字符串May 14, 2025 am 12:08 AM使用join()方法是Python中從列表連接字符串最有效的方法。 1)使用join()方法高效且易讀。 2)循環使用 運算符對大列表效率低。 3)列表推導式與join()結合適用於需要轉換的場景。 4)reduce()方法適用於其他類型歸約,但對字符串連接效率低。完整句子結束。

Python執行,那是什麼?May 14, 2025 am 12:06 AM

Python執行,那是什麼?May 14, 2025 am 12:06 AMpythonexecutionistheprocessoftransformingpypythoncodeintoExecutablestructions.1)InternterPreterReadSthecode,ConvertingTingitIntObyTecode,whepythonvirtualmachine(pvm)theglobalinterpreterpreterpreterpreterlock(gil)the thepythonvirtualmachine(pvm)

Python:關鍵功能是什麼May 14, 2025 am 12:02 AM

Python:關鍵功能是什麼May 14, 2025 am 12:02 AMPython的關鍵特性包括:1.語法簡潔易懂,適合初學者;2.動態類型系統,提高開發速度;3.豐富的標準庫,支持多種任務;4.強大的社區和生態系統,提供廣泛支持;5.解釋性,適合腳本和快速原型開發;6.多範式支持,適用於各種編程風格。

Python:編譯器還是解釋器?May 13, 2025 am 12:10 AM

Python:編譯器還是解釋器?May 13, 2025 am 12:10 AMPython是解釋型語言,但也包含編譯過程。 1)Python代碼先編譯成字節碼。 2)字節碼由Python虛擬機解釋執行。 3)這種混合機制使Python既靈活又高效,但執行速度不如完全編譯型語言。

python用於循環與循環時:何時使用哪個?May 13, 2025 am 12:07 AM

python用於循環與循環時:何時使用哪個?May 13, 2025 am 12:07 AMUseeAforloopWheniteratingOveraseQuenceOrforAspecificnumberoftimes; useAwhiLeLoopWhenconTinuingUntilAcIntiment.forloopsareIdealForkNownsences,而WhileLeleLeleLeleLeleLoopSituationSituationsItuationsItuationSuationSituationswithUndEtermentersitations。

Python循環:最常見的錯誤May 13, 2025 am 12:07 AM

Python循環:最常見的錯誤May 13, 2025 am 12:07 AMpythonloopscanleadtoerrorslikeinfiniteloops,modifyingListsDuringteritation,逐個偏置,零indexingissues,andnestedloopineflinefficiencies

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

MantisBT

Mantis是一個易於部署的基於Web的缺陷追蹤工具,用於幫助產品缺陷追蹤。它需要PHP、MySQL和一個Web伺服器。請查看我們的演示和託管服務。

Dreamweaver CS6

視覺化網頁開發工具

ZendStudio 13.5.1 Mac

強大的PHP整合開發環境

SublimeText3漢化版

中文版,非常好用