GitHub: https://github.com/chatsapi/ChatsAPI

圖書館: https://pypi.org/project/chatsapi/

人工智慧改變了各行各業,但有效部署人工智慧仍然是一項艱鉅的挑戰。複雜的框架、緩慢的反應時間和陡峭的學習曲線給企業和開發人員帶來了障礙。 ChatsAPI 是一個突破性的高性能 AI 代理框架,旨在提供無與倫比的速度、靈活性和簡單性。

在本文中,我們將揭示 ChatsAPI 的獨特之處、為何它能夠改變遊戲規則,以及它如何幫助開發人員以無與倫比的輕鬆性和效率建立智慧系統。

ChatsAPI 有何獨特之處?

ChatsAPI 不僅僅是另一個人工智慧框架;這是人工智慧驅動互動的一場革命。原因如下:

- 無與倫比的性能 ChatsAPI 利用 SBERT 嵌入、HNSWlib 和 BM25 混合搜尋來提供有史以來最快的查詢匹配系統。

速度:ChatsAPI 的回應時間為亞毫秒級,是全球最快的人工智慧代理框架。其 HNSWlib 支援的搜尋可確保快速檢索路線和知識,即使對於大型資料集也是如此。

效率:SBERT 和 BM25 的混合方法將語義理解與傳統排名系統結合起來,確保速度和準確性。

與法學碩士無縫整合

ChatsAPI 支援最先進的大型語言模型 (LLM),例如 OpenAI、Gemini、LlamaAPI 和 Ollama。它簡化了將法學碩士整合到您的應用程式中的複雜性,使您能夠專注於建立更好的體驗。動態路由匹配

ChatsAPI 使用自然語言理解 (NLU) 以無與倫比的精確度將使用者查詢與預定義路由動態配對。

使用 @trigger 等裝飾器輕鬆註冊路線。

使用 @extract 進行參數提取來簡化輸入處理,無論您的用例有多複雜。

- 設計簡單 我們相信強大和簡單可以共存。透過 ChatsAPI,開發人員可以在幾分鐘內建立強大的人工智慧驅動系統。無需再為複雜的設定或配置而苦惱。

ChatsAPI的優點

高效能查詢處理

傳統的人工智慧系統要么在速度上要么在準確性上苦苦掙扎,而 ChatsAPI 卻同時滿足了這兩點。無論是在龐大的知識庫中尋找最佳匹配,還是處理大量查詢,ChatsAPI 都表現出色。

靈活的框架

ChatsAPI 適應任何用例,無論您正在建置:

- 客戶支援聊天機器人。

- 智慧搜尋系統。

- 人工智慧驅動的電子商務、醫療保健或教育助理。

為開發者打造

由開發者設計,為開發者服務,ChatsAPI 提供:

- 快速入門:只需幾個步驟即可設定環境、定義路線並上線。

- 客製化:使用裝飾器自訂行為並根據您的特定需求微調效能。

- 輕鬆的 LLM 整合:輕鬆在 OpenAI 或 Gemini 等支援的 LLM 之間切換。

ChatsAPI 如何運作?

ChatsAPI 的核心是透過三個步驟來操作:

- 註冊路由:使用@trigger裝飾器定義路由並將它們與您的函數關聯。

- 搜尋和匹配:ChatsAPI 使用 SBERT 嵌入和 BM25 混合搜尋將使用者輸入與正確的路線動態配對。

- 擷取參數:透過@extract裝飾器,ChatsAPI自動擷取並驗證參數,更容易處理複雜的輸入。

結果呢?一個快速、準確且易於使用的系統。

使用案例

客戶支援

透過極快的查詢解析來自動化客戶互動。 ChatsAPI 確保用戶立即獲得相關答案,提高滿意度並降低營運成本。知識庫搜尋

使用戶能夠透過語義理解搜尋大量知識庫。混合 SBERT-BM25 方法可確保準確、情境感知的結果。對話式人工智慧

建立能夠即時理解並適應用戶輸入的對話式人工智慧代理。 ChatsAPI 與頂尖法學碩士無縫集成,提供自然、引人入勝的對話。

為什麼你應該關心?

其他框架承諾靈活性或效能 - 但沒有一個框架能夠像 ChatsAPI 一樣同時提供這兩者。我們創建了一個框架:

- 比市面上任何其他產品都快。

- 更簡單設定和使用。

- 更聰明,其獨特的混合搜尋引擎融合了語義和基於關鍵字的方法。

ChatsAPI 讓開發人員能夠釋放人工智慧的全部潛力,而無需擔心複雜性或效能緩慢的問題。

如何開始

ChatsAPI 入門很簡單:

- 安裝框架:

pip install chatsapi

- 定義您的路線:

from chatsapi import ChatsAPI

chat = ChatsAPI()

@chat.trigger("Hello")

async def greet(input_text):

return "Hi there!"

- 從訊息中提取一些數據

from chatsapi import ChatsAPI

chat = ChatsAPI()

@chat.trigger("Need help with account settings.")

@chat.extract([

("account_number", "Account number (a nine digit number)", int, None),

("holder_name", "Account holder's name (a person name)", str, None)

])

async def account_help(chat_message: str, extracted: dict):

return {"message": chat_message, "extracted": extracted}

Run your message (with no LLM)

@app.post("/chat")

async def message(request: RequestModel, response: Response):

reply = await chat.run(request.message)

return {"message": reply}

- 對話(與法學碩士)—完整範例

import os

from dotenv import load_dotenv

from fastapi import FastAPI, Request, Response

from pydantic import BaseModel

from chatsapi.chatsapi import ChatsAPI

# Load environment variables from .env file

load_dotenv()

app = FastAPI() # instantiate FastAPI or your web framework

chat = ChatsAPI( # instantiate ChatsAPI

llm_type="gemini",

llm_model="models/gemini-pro",

llm_api_key=os.getenv("GOOGLE_API_KEY"),

)

# chat trigger - 1

@chat.trigger("Want to cancel a credit card.")

@chat.extract([("card_number", "Credit card number (a 12 digit number)", str, None)])

async def cancel_credit_card(chat_message: str, extracted: dict):

return {"message": chat_message, "extracted": extracted}

# chat trigger - 2

@chat.trigger("Need help with account settings.")

@chat.extract([

("account_number", "Account number (a nine digit number)", int, None),

("holder_name", "Account holder's name (a person name)", str, None)

])

async def account_help(chat_message: str, extracted: dict):

return {"message": chat_message, "extracted": extracted}

# request model

class RequestModel(BaseModel):

message: str

# chat conversation

@app.post("/chat")

async def message(request: RequestModel, response: Response, http_request: Request):

session_id = http_request.cookies.get("session_id")

reply = await chat.conversation(request.message, session_id)

return {"message": f"{reply}"}

# set chat session

@app.post("/set-session")

def set_session(response: Response):

session_id = chat.set_session()

response.set_cookie(key="session_id", value=session_id)

return {"message": "Session set"}

# end chat session

@app.post("/end-session")

def end_session(response: Response, http_request: Request):

session_id = http_request.cookies.get("session_id")

chat.end_session(session_id)

response.delete_cookie("session_id")

return {"message": "Session ended"}

- 遵循 LLM 查詢的路由 — 單一查詢

await chat.query(request.message)

基準測試

基於傳統 LLM (API) 的方法通常每個請求需要大約四秒鐘的時間。相較之下,ChatsAPI 可以在一秒鐘內處理請求,通常在幾毫秒內,無需進行任何 LLM API 呼叫。

472ms內執行聊天路由任務(無快取)

21ms內執行聊天路由任務(快取後)

862ms內執行聊天路由資料擷取任務(無快取)

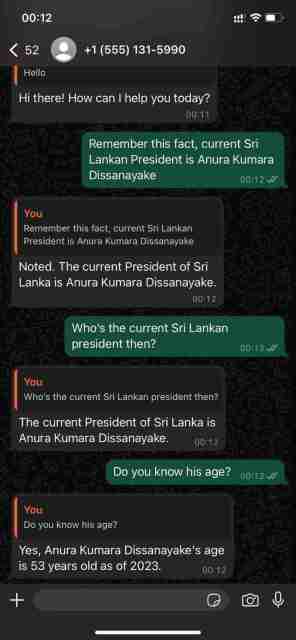

使用 WhatsApp Cloud API 展示其對話能力

ChatsAPI — 功能層次結構

ChatsAPI 不僅僅是一個框架;這是我們建構人工智慧系統並與之互動的方式的典範轉移。透過結合速度、準確性和易用性,ChatsAPI 為 AI 代理框架樹立了新基準。

立刻加入這場革命,了解 ChatsAPI 為何正在改變 AI 格局。

準備好潛水了嗎?立即開始使用 ChatsAPI,體驗 AI 開發的未來。

以上是ChatsAPI — 世界上最快的人工智慧代理框架的詳細內容。更多資訊請關注PHP中文網其他相關文章!

Python是按線執行的嗎?May 10, 2025 am 12:03 AM

Python是按線執行的嗎?May 10, 2025 am 12:03 AMPython不是嚴格的逐行執行,而是基於解釋器的機制進行優化和條件執行。解釋器將代碼轉換為字節碼,由PVM執行,可能會預編譯常量表達式或優化循環。理解這些機制有助於優化代碼和提高效率。

python中兩個列表的串聯替代方案是什麼?May 09, 2025 am 12:16 AM

python中兩個列表的串聯替代方案是什麼?May 09, 2025 am 12:16 AM可以使用多種方法在Python中連接兩個列表:1.使用 操作符,簡單但在大列表中效率低;2.使用extend方法,效率高但會修改原列表;3.使用 =操作符,兼具效率和可讀性;4.使用itertools.chain函數,內存效率高但需額外導入;5.使用列表解析,優雅但可能過於復雜。選擇方法應根據代碼上下文和需求。

Python:合併兩個列表的有效方法May 09, 2025 am 12:15 AM

Python:合併兩個列表的有效方法May 09, 2025 am 12:15 AM有多種方法可以合併Python列表:1.使用 操作符,簡單但對大列表不內存高效;2.使用extend方法,內存高效但會修改原列表;3.使用itertools.chain,適用於大數據集;4.使用*操作符,一行代碼合併小到中型列表;5.使用numpy.concatenate,適用於大數據集和性能要求高的場景;6.使用append方法,適用於小列表但效率低。選擇方法時需考慮列表大小和應用場景。

編譯的與解釋的語言:優點和缺點May 09, 2025 am 12:06 AM

編譯的與解釋的語言:優點和缺點May 09, 2025 am 12:06 AMCompiledLanguagesOffersPeedAndSecurity,而interneterpretledlanguages provideeaseafuseanDoctability.1)commiledlanguageslikec arefasterandSecureButhOnderDevevelmendeclementCyclesclesclesclesclesclesclesclesclesclesclesclesclesclesclesclesclesclesandentency.2)cransportedeplatectentysenty

Python:對於循環,最完整的指南May 09, 2025 am 12:05 AM

Python:對於循環,最完整的指南May 09, 2025 am 12:05 AMPython中,for循環用於遍歷可迭代對象,while循環用於條件滿足時重複執行操作。 1)for循環示例:遍歷列表並打印元素。 2)while循環示例:猜數字遊戲,直到猜對為止。掌握循環原理和優化技巧可提高代碼效率和可靠性。

python concatenate列表到一個字符串中May 09, 2025 am 12:02 AM

python concatenate列表到一個字符串中May 09, 2025 am 12:02 AM要將列表連接成字符串,Python中使用join()方法是最佳選擇。 1)使用join()方法將列表元素連接成字符串,如''.join(my_list)。 2)對於包含數字的列表,先用map(str,numbers)轉換為字符串再連接。 3)可以使用生成器表達式進行複雜格式化,如','.join(f'({fruit})'forfruitinfruits)。 4)處理混合數據類型時,使用map(str,mixed_list)確保所有元素可轉換為字符串。 5)對於大型列表,使用''.join(large_li

Python的混合方法:編譯和解釋合併May 08, 2025 am 12:16 AM

Python的混合方法:編譯和解釋合併May 08, 2025 am 12:16 AMpythonuseshybridapprace,ComminingCompilationTobyTecoDeAndInterpretation.1)codeiscompiledtoplatform-Indepententbybytecode.2)bytecodeisisterpretedbybythepbybythepythonvirtualmachine,增強效率和通用性。

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

WebStorm Mac版

好用的JavaScript開發工具

SublimeText3 英文版

推薦:為Win版本,支援程式碼提示!

Dreamweaver CS6

視覺化網頁開發工具

DVWA

Damn Vulnerable Web App (DVWA) 是一個PHP/MySQL的Web應用程序,非常容易受到攻擊。它的主要目標是成為安全專業人員在合法環境中測試自己的技能和工具的輔助工具,幫助Web開發人員更好地理解保護網路應用程式的過程,並幫助教師/學生在課堂環境中教授/學習Web應用程式安全性。 DVWA的目標是透過簡單直接的介面練習一些最常見的Web漏洞,難度各不相同。請注意,該軟體中

SublimeText3漢化版

中文版,非常好用