GitHub 是創新專案的寶庫,尤其是在不斷發展的人工智慧世界中。但是要篩選無數的儲存庫來找到那些結合了 AI 和 JavaScript 的儲存庫嗎?這就像在浩瀚的程式碼海洋中尋找寶石一樣。輸入我們的 Node.js 網路爬蟲——一個自動搜尋、提取儲存庫詳細資訊(如名稱、URL 和描述)的腳本。

在本教學中,我們將建立一個利用 GitHub 的爬蟲,尋找與 AI 和 JavaScript 搭配使用的儲存庫。讓我們深入研究程式碼並開始挖掘這些寶石。

第 1 部分:設定項目

初始化 Node.js 項目

首先為您的專案建立一個新目錄並使用 npm 對其進行初始化:

mkdir github-ai-crawler cd github-ai-crawler npm init -y

接下來,安裝必要的依賴項:

npm install axios cheerio

- axios :用於向 GitHub 發出 HTTP 請求。

- cheerio :用於解析和操作 HTML,類似 jQuery。

第 2 部分:了解 GitHub 的搜索

GitHub 提供了強大的搜尋功能,可透過 URL 查詢存取。例如,您可以使用下列查詢搜尋與 AI 相關的 JavaScript 儲存庫:

https://github.com/search?q=ai+language:javascript&type=repositories

我們的爬蟲將模倣此搜索,解析結果並提取相關詳細資訊。

第三部分:編寫爬蟲腳本

在專案目錄中建立一個名為crawler.js的檔案並開始編碼。

第 1 步:導入依賴項

const axios = require('axios');

const cheerio = require('cheerio');

我們使用 axios 來取得 GitHub 的搜尋結果,並使用 Cheerio 來解析 HTML。

第 2 步:定義搜尋 URL

const SEARCH_URL = 'https://github.com/search?q=ai+language:javascript&type=repositories';

此 URL 的目標是與 AI 相關並用 JavaScript 編寫的儲存庫。

2220 免費 資源 針對開發者! ❤️?? (每日更新)

1400 個免費 HTML 範本

351 篇免費新聞文章

67 個免費 AI 提示

315 個免費程式碼庫

52 個適用於 Node、Nuxt、Vue 等的免費程式碼片段和樣板!

25 個免費開源圖示庫

造訪 dailysandbox.pro 免費存取資源寶庫!

第 3 步:取得並解析 HTML

const fetchRepositories = async () => {

try {

// Fetch the search results page

const { data } = await axios.get(SEARCH_URL);

const $ = cheerio.load(data); // Load the HTML into cheerio

// Extract repository details

const repositories = [];

$('.repo-list-item').each((_, element) => {

const repoName = $(element).find('a').text().trim();

const repoUrl = `https://github.com${$(element).find('a').attr('href')}`;

const repoDescription = $(element).find('.mb-1').text().trim();

repositories.push({

name: repoName,

url: repoUrl,

description: repoDescription,

});

});

return repositories;

} catch (error) {

console.error('Error fetching repositories:', error.message);

return [];

}

};

這是發生的事情:

- 取得 HTML :axios.get 方法檢索搜尋結果頁。

- 使用 Cheerio 進行解析:我們使用 Cheerio 來導航 DOM,定位具有 .repo-list-item 等類的元素。

- 提取詳細資訊:對於每個儲存庫,我們提取名稱、URL 和描述。

第 4 步:顯示結果

最後,呼叫函數並記錄結果:

mkdir github-ai-crawler cd github-ai-crawler npm init -y

第 4 部分:運行爬網程序

儲存腳本並使用 Node.js 運行它:

npm install axios cheerio

您將看到與 AI 相關的 JavaScript 儲存庫列表,每個儲存庫都有其名稱、URL 和描述,整齊地顯示在您的終端中。

第 5 部分:增強爬蟲

想更進一步嗎?這裡有一些想法:

- 分頁 :透過使用 &p=2、&p=3 等修改 URL 來新增對取得多頁搜尋結果的支援

- 過濾:按星號或分岔過濾儲存庫,以優先考慮熱門項目。

- 儲存資料:將結果儲存到檔案或資料庫以供進一步分析。

儲存到 JSON 檔案的範例:

https://github.com/search?q=ai+language:javascript&type=repositories

自動化之美

透過這個爬蟲,您可以自動完成在 GitHub 上尋找相關儲存庫的繁瑣任務。不再需要手動瀏覽或無休止的點擊——您的腳本會完成艱苦的工作,在幾秒鐘內呈現結果。

有關 Web 開發的更多技巧,請查看 DailySandbox 並註冊我們的免費時事通訊以保持領先地位!

以上是在 Node.js 中建立網路爬蟲以發現 GitHub 上由 AI 驅動的 JavaScript 儲存庫的詳細內容。更多資訊請關注PHP中文網其他相關文章!

在JavaScript中替換字符串字符Mar 11, 2025 am 12:07 AM

在JavaScript中替換字符串字符Mar 11, 2025 am 12:07 AMJavaScript字符串替換方法詳解及常見問題解答 本文將探討兩種在JavaScript中替換字符串字符的方法:在JavaScript代碼內部替換和在網頁HTML內部替換。 在JavaScript代碼內部替換字符串 最直接的方法是使用replace()方法: str = str.replace("find","replace"); 該方法僅替換第一個匹配項。要替換所有匹配項,需使用正則表達式並添加全局標誌g: str = str.replace(/fi

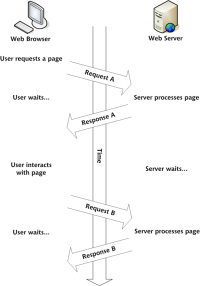

構建您自己的Ajax Web應用程序Mar 09, 2025 am 12:11 AM

構建您自己的Ajax Web應用程序Mar 09, 2025 am 12:11 AM因此,在這裡,您準備好了解所有稱為Ajax的東西。但是,到底是什麼? AJAX一詞是指用於創建動態,交互式Web內容的一系列寬鬆的技術。 Ajax一詞,最初由Jesse J創造

10個JQuery Fun and Games插件Mar 08, 2025 am 12:42 AM

10個JQuery Fun and Games插件Mar 08, 2025 am 12:42 AM10款趣味橫生的jQuery遊戲插件,讓您的網站更具吸引力,提升用戶粘性!雖然Flash仍然是開發休閒網頁遊戲的最佳軟件,但jQuery也能創造出令人驚喜的效果,雖然無法與純動作Flash遊戲媲美,但在某些情況下,您也能在瀏覽器中獲得意想不到的樂趣。 jQuery井字棋遊戲 遊戲編程的“Hello world”,現在有了jQuery版本。 源碼 jQuery瘋狂填詞遊戲 這是一個填空遊戲,由於不知道單詞的上下文,可能會產生一些古怪的結果。 源碼 jQuery掃雷遊戲

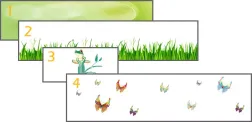

jQuery視差教程 - 動畫標題背景Mar 08, 2025 am 12:39 AM

jQuery視差教程 - 動畫標題背景Mar 08, 2025 am 12:39 AM本教程演示瞭如何使用jQuery創建迷人的視差背景效果。 我們將構建一個帶有分層圖像的標題橫幅,從而創造出令人驚嘆的視覺深度。 更新的插件可與JQuery 1.6.4及更高版本一起使用。 下載

如何在瀏覽器中優化JavaScript代碼以進行性能?Mar 18, 2025 pm 03:14 PM

如何在瀏覽器中優化JavaScript代碼以進行性能?Mar 18, 2025 pm 03:14 PM本文討論了在瀏覽器中優化JavaScript性能的策略,重點是減少執行時間並最大程度地減少對頁面負載速度的影響。

Matter.js入門:簡介Mar 08, 2025 am 12:53 AM

Matter.js入門:簡介Mar 08, 2025 am 12:53 AMMatter.js是一個用JavaScript編寫的2D剛體物理引擎。此庫可以幫助您輕鬆地在瀏覽器中模擬2D物理。它提供了許多功能,例如創建剛體並為其分配質量、面積或密度等物理屬性的能力。您還可以模擬不同類型的碰撞和力,例如重力摩擦力。 Matter.js支持所有主流瀏覽器。此外,它也適用於移動設備,因為它可以檢測觸摸並具有響應能力。所有這些功能都使其值得您投入時間學習如何使用該引擎,因為這樣您就可以輕鬆創建基於物理的2D遊戲或模擬。在本教程中,我將介紹此庫的基礎知識,包括其安裝和用法,並提供一

使用jQuery和Ajax自動刷新DIV內容Mar 08, 2025 am 12:58 AM

使用jQuery和Ajax自動刷新DIV內容Mar 08, 2025 am 12:58 AM本文演示瞭如何使用jQuery和ajax自動每5秒自動刷新DIV的內容。 該示例從RSS提要中獲取並顯示了最新的博客文章以及最後的刷新時間戳。 加載圖像是選擇

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

AI Hentai Generator

免費產生 AI 無盡。

熱門文章

熱工具

EditPlus 中文破解版

體積小,語法高亮,不支援程式碼提示功能

ZendStudio 13.5.1 Mac

強大的PHP整合開發環境

VSCode Windows 64位元 下載

微軟推出的免費、功能強大的一款IDE編輯器

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

Dreamweaver Mac版

視覺化網頁開發工具