如何使用擁抱臉部 AI 模型作為 API

- DDD原創

- 2024-11-16 05:21:031080瀏覽

在本指南中,我將向您展示如何使用 Hugging Face 模型作為 API,並以 Meta LLaMA-3.2-3B-Instruct 為例。該模型專為基於聊天的自動完成而設計,可以有效處理對話式人工智慧任務。讓我們設定 API 並開始吧!

步驟1:選擇抱臉模特

- 前往擁抱臉部模型並搜尋 Meta LLaMA-3.2-3B-Instruct 或您想要嘗試的任何其他模型。

- 進入模型頁面後,確認其支援推理 API,這允許其用作 API 端點。

第 2 步:建立 API 令牌

要存取 Hugging Face 的模型 API,您需要 API 令牌。

- 登入您的 Hugging Face 帳戶並導覽至您的設定 > 存取權杖。

選擇新令牌建立讀取令牌。這樣您就可以呼叫 API 進行推理,而無需修改或管理資源的權限。

安全地保存您的令牌,因為您需要它來進行 API 驗證。

第 3 步:為您的模型使用推理 API

Hugging Face 提供了無伺服器推理 API 來存取預先訓練的模型。此服務對免費用戶有費率限制,對專業帳戶則有增強的配額。

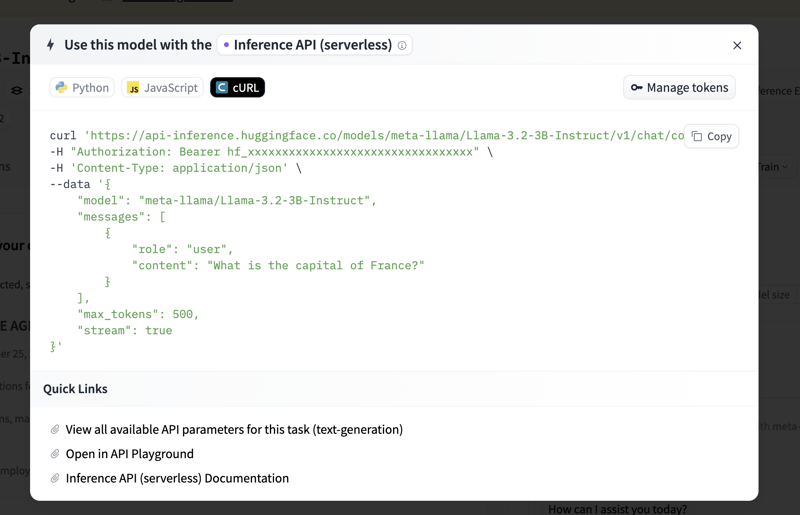

在 Meta LLaMA-3.2-3B-Instruct 模型頁面上,按一下 Inference API 標籤。此選項卡提供程式碼範例和其他 API 使用資訊。

您可以找到範例程式碼來開始。以下是如何設定基本的 Python 腳本來呼叫模型的 API。

第 4 步:處理費率限制和專業帳戶優勢

對於免費帳戶,API 速率限制適用,超過此限制可能會導致請求受到限制。如果您打算廣泛使用 API 或需要更快的回應,請考慮使用專業帳戶。更多詳情請參閱 Hugging Face 的定價頁面。

概括

依照這些步驟,您可以透過 API 使用 Meta LLaMA-3.2-3B-Instruct 或任何其他 Hugging Face 模型來執行聊天自動完成、對話式 AI 等任務。此設定非常靈活,可讓您將 AI 功能直接整合到您的應用程式中,無論是用於實驗還是生產目的。

現在您已準備好使用 Hugging Face 的強大模型來探索和建造!

以上是如何使用擁抱臉部 AI 模型作為 API的詳細內容。更多資訊請關注PHP中文網其他相關文章!

陳述:

本文內容由網友自願投稿,版權歸原作者所有。本站不承擔相應的法律責任。如發現涉嫌抄襲或侵權的內容,請聯絡admin@php.cn