以「垂直模型」引領AIGC商業化落地,FancyTech的技術路徑是什麼?

- 王林原創

- 2024-08-16 16:36:31576瀏覽

我們正在見證又一輪技術革新,這次是AIGC 為個體提供表達自我的工具,讓創作變得更加容易和普及,但背後的推動力卻並不是「大」模型。

兩年以來,AIGC 技術的發展速度超過所有人的想像,席捲了從文字、圖像到影片的各個領域。關於 AIGC 商業化路徑的討論從來沒有停止過,其中,有共識也有路線分化。

一方面,通用模型的強大能力令人驚嘆,在各行各業展現出應用潛力。特別是 DiT、VAR 等架構的提出,讓 Scaling Law 實現了從文字到視覺生成領域的跨越。在這法則的指引下,許多大模型廠商朝著增加訓練資料、算力投入和堆積參數的方向持續前進。

另一方面,我們也看到,通用模型並不意味著「通殺」,面對很多細分賽道的任務,一個「訓練有素」的垂直模型反而能夠取得更好的效果。

隨著大模型技術進入落地加速期,後一種商業化路徑獲得的關注快速增長。

這個演進過程中,一家來自中國的創業公司FancyTech 脫穎而出:它以面向商業類視覺內容生成的標準化產品快速拓展市場,比同行們更早一步驗證了“垂直模型”在產業落地層面的優越性。

環顧國內大模型創業圈,FancyTech 的商業化戰績是有目共睹的。但較少為人所知的是,這家誕生僅幾年的公司,憑藉怎樣的垂直模型和技術優勢跑在了賽道前列。

在一次專訪中,本站和 FancyTech 聊了聊他們正在做的技術探索。

FancyTech 發布影片垂直模型 DeepVideo

如何突破產業壁壘?

一般來說,在通用模型的零樣本泛化能力達到某個水準後,在其之上做微調就可用於下游任務。這也是當下許多大模型產品落地的打法。但從實際效果來看,光是「微調」還無法滿足產業應用需求,因為各產業的內容生成任務都有自己的特定而複雜的一套標準。

通用模型或許能完成好 70% 的常規任務,但客戶真正需要的是能 100% 滿足需求的「垂直模型」。以商業視覺設計為例,以往的相關工作均由有長期累積的專業人士完成,且需要根據品牌方的具體需求進行設計和調整,其中涵蓋大量的人工經驗。比起美觀度和指令遵循程度等指標,「商品還原度」是這項任務中品牌方更為重視的一點,也是品牌方是否願意付費的決定因素。

在自研面向商業圖像/ 視頻的垂直模型過程中,FancyTech 將核心挑戰拆解開來:如何讓商品足夠還原且融入背景,特別是在生成視頻中,實現商品的運動可控且不形變。

大模型技術發展到今天,對於應用層來說,走開源或閉源的路線已經不是最核心的問題。 FancyTech 的垂直模型是基於開源的底層演算法框架,疊加自有的資料標註重新訓練,只需數百張 GPU 持續訓練迭代即可取得好的生成效果。相較之下,「商品資料」和「訓練方式」這兩個因素對於最終的落地效果更為關鍵。

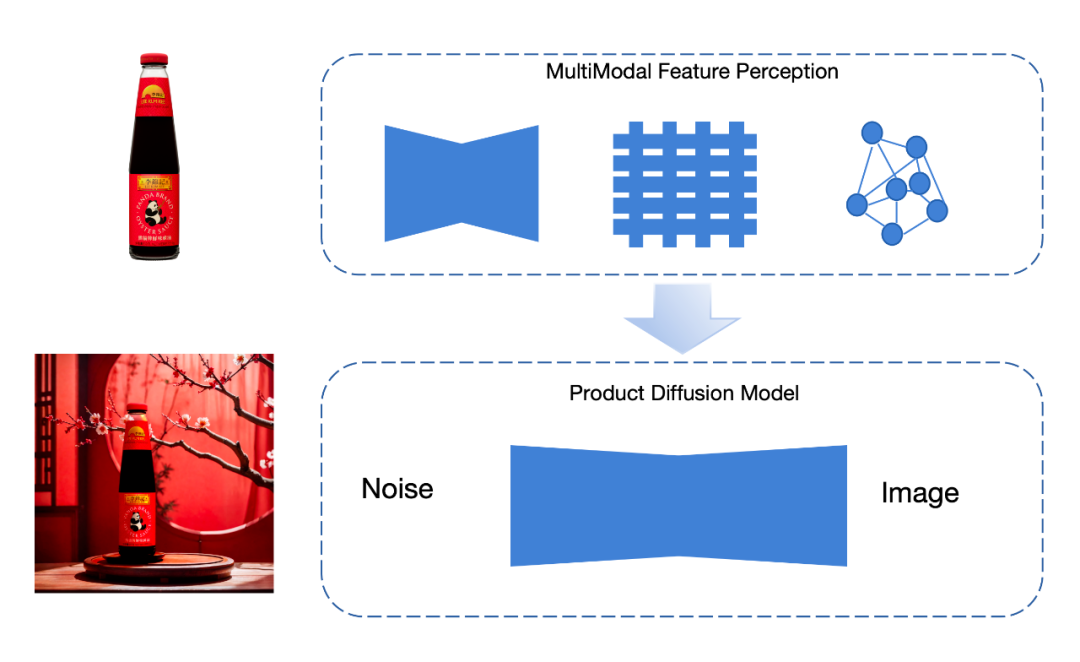

FancyTech 在累積大量 3D 訓練資料的前提下,引入了空間智慧的思路指導模型的 2D 內容產生。 具體來說,在影像類內容生成上,團隊提出「多模態特徵器」保證商品的還原,以特殊的資料擷取保證商品與背景的自然融合;在視訊類內容生成上,團隊重建了視訊生成的底層鏈路,定向地設計框架和進行資料工程,從而實現以商品為核心的視訊生成。

真・降維打擊:「空間智能」如何引導 2D 內容產生?

許多視覺生成類產品的效果之所以不盡如人意,核心原因就在於目前的圖像和視頻生成模型往往基於 2D 訓練數據進行學習,並沒有理解真正的物理世界。

這點在領域內已形成共識,部分研究者甚至認為,在自迴歸學習範式下,模型對世界的理解始終處於淺層。

但在商業視覺生成這項細分任務上,要想增強模型 3D 物理世界的理解、更好地生成 2D 內容,並非完全無解。

FancyTech 將「空間智慧」領域的研究思路遷移到了視覺生成模型的建構中。與一般生成式模型不同,空間智慧的想法是從大量感測器所獲得的原始訊號中學習,對感測器所獲得的原始訊號進行精確標定,以賦予模型感知和理解現實世界的能力。

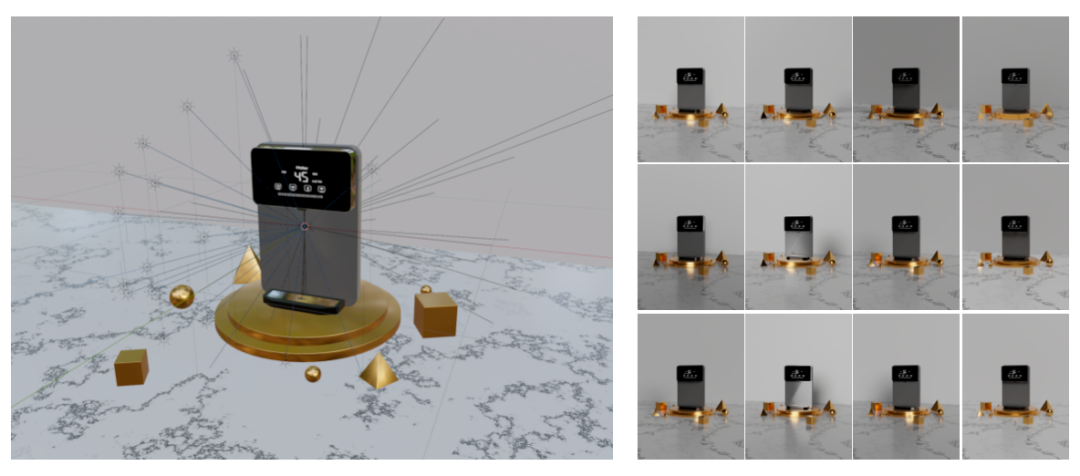

因此,FancyTech 以雷射雷達掃描取代傳統攝影棚拍攝,累積了大量的體現商品融入前後差異的高品質3D 資料對,並將3D 點雲資料與2D 資料結合起來共同作為模型訓練數據,增強模型對現實世界的理解。

我們知道,在任何視覺內容的生成中,光影效果的塑造都是極具挑戰性的任務。光照、發光體、逆光、光斑等元素能讓畫面的空間層次感更強,但這對生成式模型來說是個很難理解的「知識點」。

為了收集盡可能多的自然光影數據,FancyTech 在每個環境中建立了數十盞亮度和色溫均可調節的燈,意味著海量數據中的每一對都可以疊加多盞燈及不同亮度及色溫的變化。

這種高強度的數據收集模擬了真實拍攝場景的燈光,使其更加符合電商場景的特徵。

結合高品質的3D 資料積累,FancyTech 在演算法框架上進行了一系列創新,將空間演算法與影像、視訊演算法有機結合,讓模型更好地理解核心物體與環境的交互作用。

在訓練過程中,模型可以在一定程度上「湧現」出對物理世界的理解,對三維空間、深度、光的反射和折射,以及光在不同介質、不同材質中運行的結果都有更深的認知,最終實現了生成結果中商品的「強還原」和「超融合」。

「強還原」與「超融合」背後,有哪些演算法創新?

針對常見的商品場景影像產生任務,現階段的主流方法主要用貼圖的方式保證商品部分的還原度,然後基於 Inpainting 技術實現圖片場景的編輯。使用者選定需要改變的區域,輸入 Prompt 或提供參考影像,以引導商品場景產生。這種方法的融合效果較好,缺點是場景產生結果的可控性不高,例如不夠清晰或過於簡單,保證不了單次輸出的高可用率。

針對當前方法無法解決的問題,FancyTech 提出了一種自有的「多模態特徵器」,在多種維度上提取商品特徵,然後使用這些特徵生成融入後的場景圖。

提取特徵的工作可分為“全局特徵”和“局部特徵”,全局特徵包括商品的輪廓、顏色等要素,使用VAE 編碼器提取;局部特徵包括各處商品細節,使用圖神經網路提取。圖神經網路的一大好處是可以提取商品中各關鍵像素的資訊以及關鍵像素間的關係,提高對於商品內部的細節還原。

相比於圖像,視頻的生成還涉及商品本身的運動控制及其帶來的光影變化。對於通用的影片產生模型來說,困難在於無法針對影片中的某個部分進行獨立保護。為了解決這個問題,FancyTech 將任務拆解為「商品運動生成」和「影片場景融入」兩條支線。

第一步,FancyTech 設計了一些針對性的運動規劃方案,以控製商品在畫面中的運動,相當於預先「定住」商品在影片每一幀的畫面;

第二步,透過控制模組實現視訊可控生成。控制模組採用了靈活的設計,可相容於 U-net、DiT 等不同架構,便於擴充優化。

在資料層面,除了使用 FancyTech 的特有商品資料資源以提供控制訓練和商品保護之外,還加入了多個開源資料集以確保場景泛化能力。訓練方案結合了對比學習、課程學習,最終實現了商品的保護效果。

讓AIGC 時代的紅利

從垂直模型開始走向更多普通人

無論是「通用」還是「垂直」,兩條路線的終點都是商業化問題。

FancyTech 垂直模型落地最直接的受益者是品牌方,以往,從策劃、拍攝、剪輯,一段廣告影片的製作週期可能長達幾個星期。但在 AIGC 時代,創作這樣一段廣告影片只需要十幾分鐘而已,成本甚至只需要原來的五分之一。

憑藉著海量獨有數據和行業Know-how 的優勢,FancyTech 通過垂直模型的優勢贏得國內外廣泛的認可,與韓國合作夥伴攜手簽約了三星和LG;與東南亞的知名電商平台Lazada 開啟合作;在美國,受到了Kate Sommerville 和Solawave 等本土品牌的青睞;在歐洲,榮獲了LVMH 創新大獎,並與歐洲客戶深入合作。

在核心的垂直模型之外,FancyTech 還提供了 AI 短視頻全鏈路自動發布和數據反饋的能力,驅動商品銷售持續增長。

更重要的一點是,垂直模型讓一般大眾利用 AIGC 技術提高生產力的路徑具象化了。 例如,一個街頭傳統照相館在不增加專業設備和專業人員的情況下,借助 FancyTech 的產品,即可完成從簡單人像拍攝到專業級商業視覺素材製作的業務轉型。

現在只要拿起手機,幾乎每個人都能拍影片、錄影音樂,並與全世界分享他們的創作。想像一個AIGC 再一次釋放個人創造力的未來——

讓普通人跨越專業門檻,更輕鬆地將創意化為現實,從而讓每個行業的生產力實現飛躍,並產生更多的新興產業,AIGC 技術帶來的時代紅利,從這一刻起開始真正走向普通人。

以上是以「垂直模型」引領AIGC商業化落地,FancyTech的技術路徑是什麼?的詳細內容。更多資訊請關注PHP中文網其他相關文章!