ACL 2024獎項發表:華科大破解甲骨文最佳論文之一、GloVe時間檢驗獎

- 王林原創

- 2024-08-15 16:37:02820瀏覽

本屆 ACL 大會,投稿者「收穫滿滿」。

論文1:Missible:s1:Missible

-

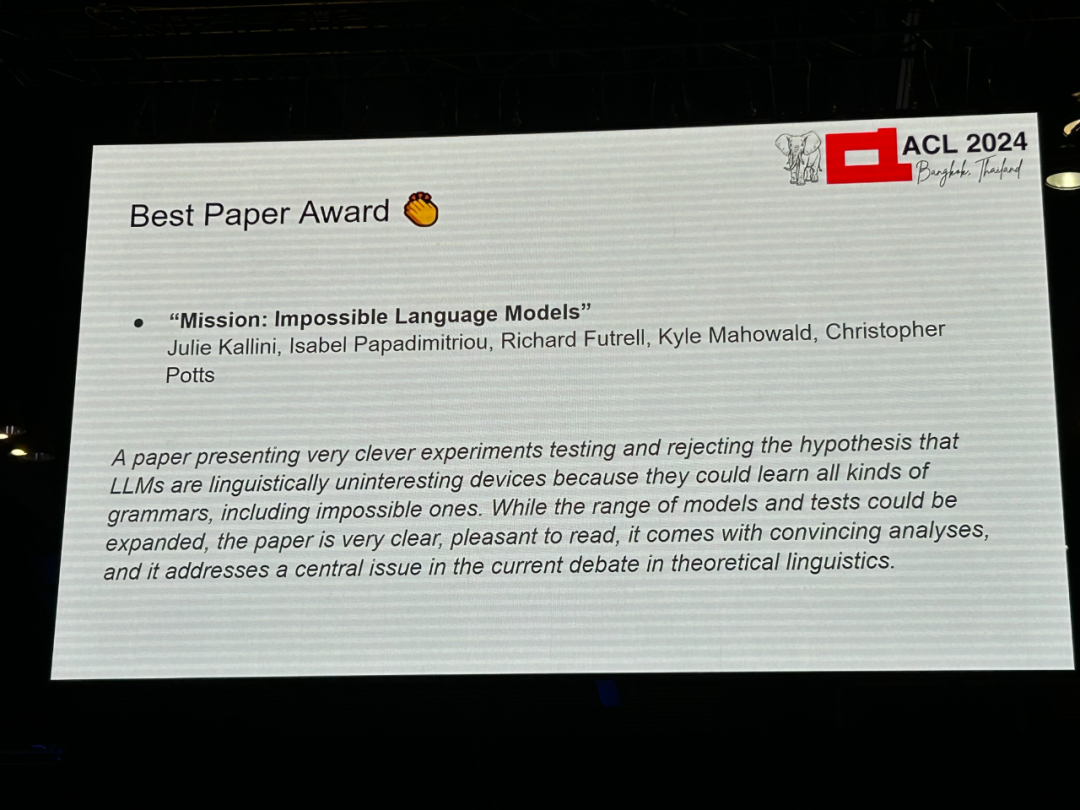

作者:Julie Kallini, Isabel Papadimitriou, Richard Futrell, Kyle Mahowald, Christopher Potts 機構:史丹佛大學、加州大學爾灣分校、德州大學奧斯汀分校 - 論文連結:https://arxiv.org/abs/2401.06416

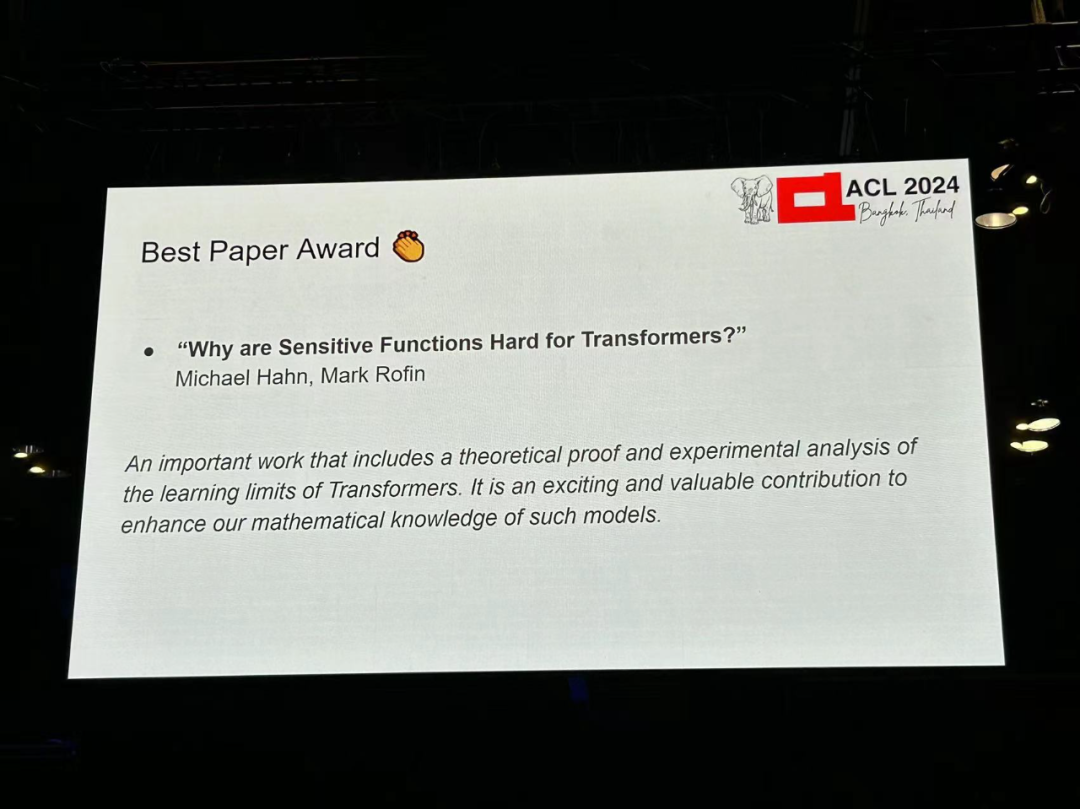

作者:Michael Hahn, onn%。 > - 機構:薩爾大學

- 論文連結:https://arxiv.org/abs/2402.09963

- 🎜>

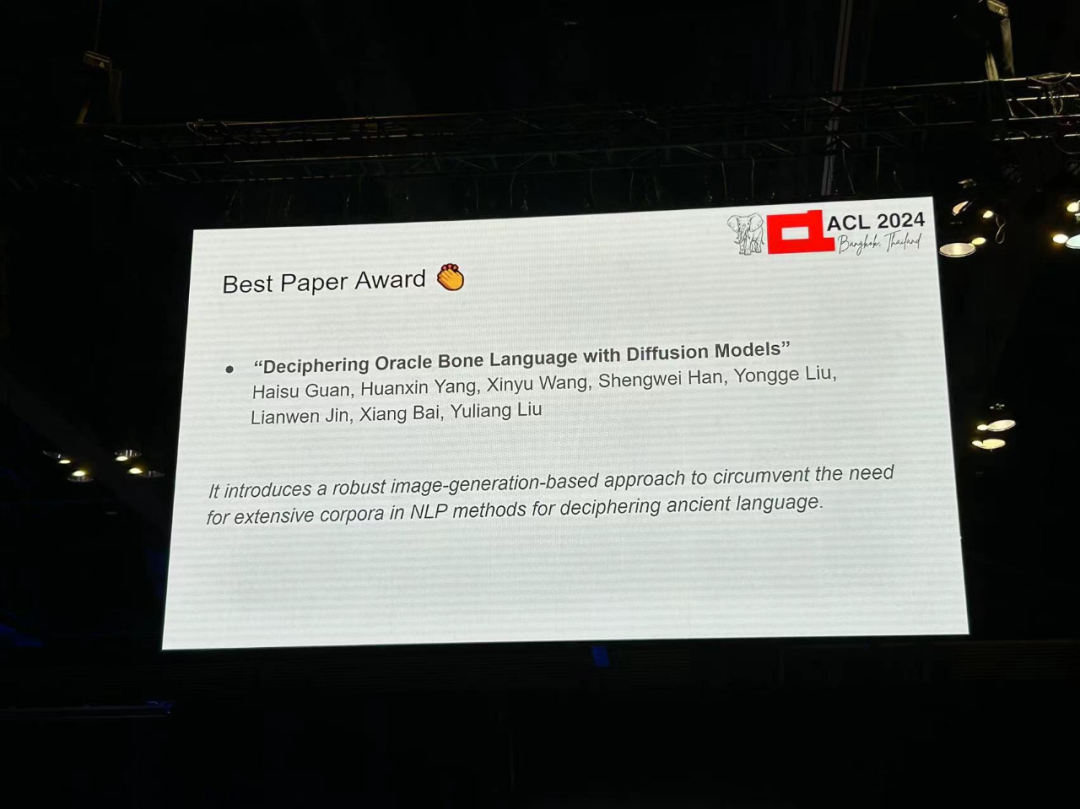

- 作者:Haisu Guan, Huanxin Yang, Xinyu Wang, Shengwei Han 等

- 機構:華中科技大學、阿德雷德大學、安陽師範學院、華南理工大學

論文簡介:甲骨文(Oracle Bone Script,OBS)起源於約3000 年前的中國商朝,是語言史上的基石,早於許多既定的書寫系統。儘管發現了數千份銘文,但仍有大量的甲骨文未被破譯,從而為這一古老的語言蒙上了一層神秘的面紗。現代 AI 技術的出現為甲骨文破解開闢了新的領域,對嚴重依賴大型文本語料庫的傳統 NLP 方法提出了挑戰。

本文介紹了一種採用影像產生技術的新方法,並開發了針對甲骨文破解最佳化的擴散模型 Oracle Bone Script Decipher (OBSD)。利用條件擴散策略,OBSD 為甲骨文破解生成了重要的線索,並為 古代語言的 AI 輔助分析開闢了新方向。為了驗證有效性,研究者在甲骨文資料集上進行了廣泛的實驗,定量結果證明了 OBSD 的有效性。

本文介紹了一種採用影像產生技術的新方法,並開發了針對甲骨文破解最佳化的擴散模型 Oracle Bone Script Decipher (OBSD)。利用條件擴散策略,OBSD 為甲骨文破解生成了重要的線索,並為 古代語言的 AI 輔助分析開闢了新方向。為了驗證有效性,研究者在甲骨文資料集上進行了廣泛的實驗,定量結果證明了 OBSD 的有效性。

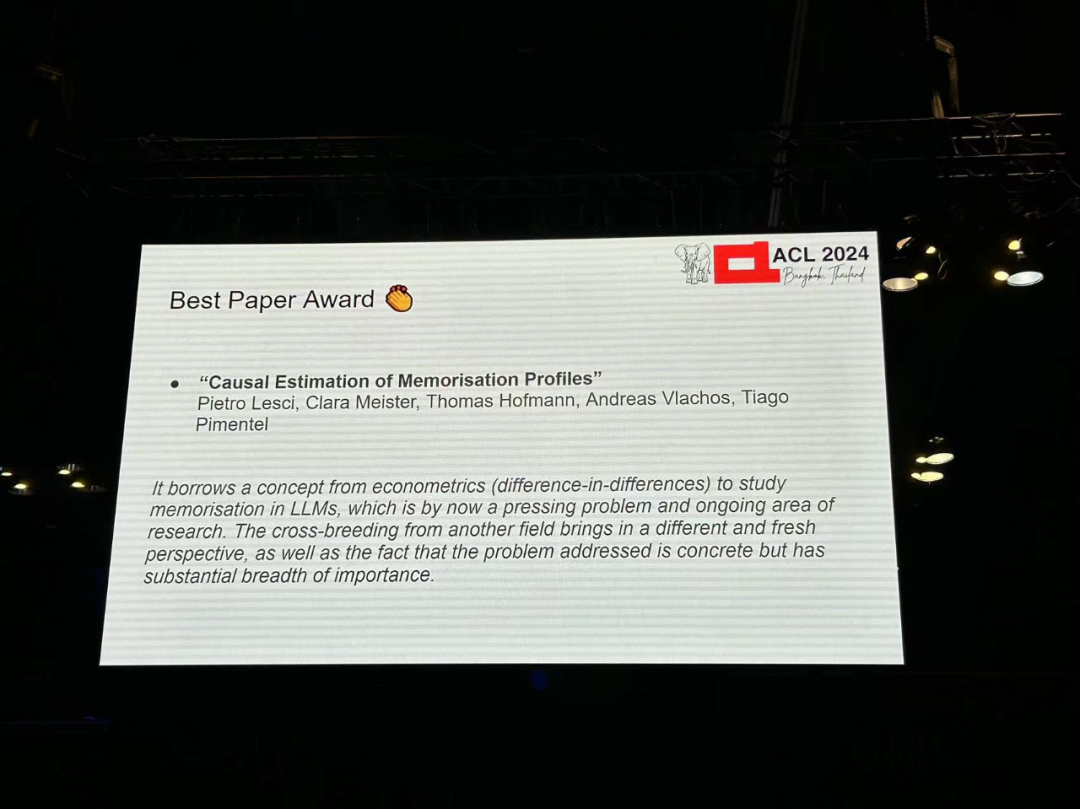

- 機構:劍橋大學、蘇黎世聯邦理工學院 機構:劍橋大學、蘇黎世聯邦理工學院

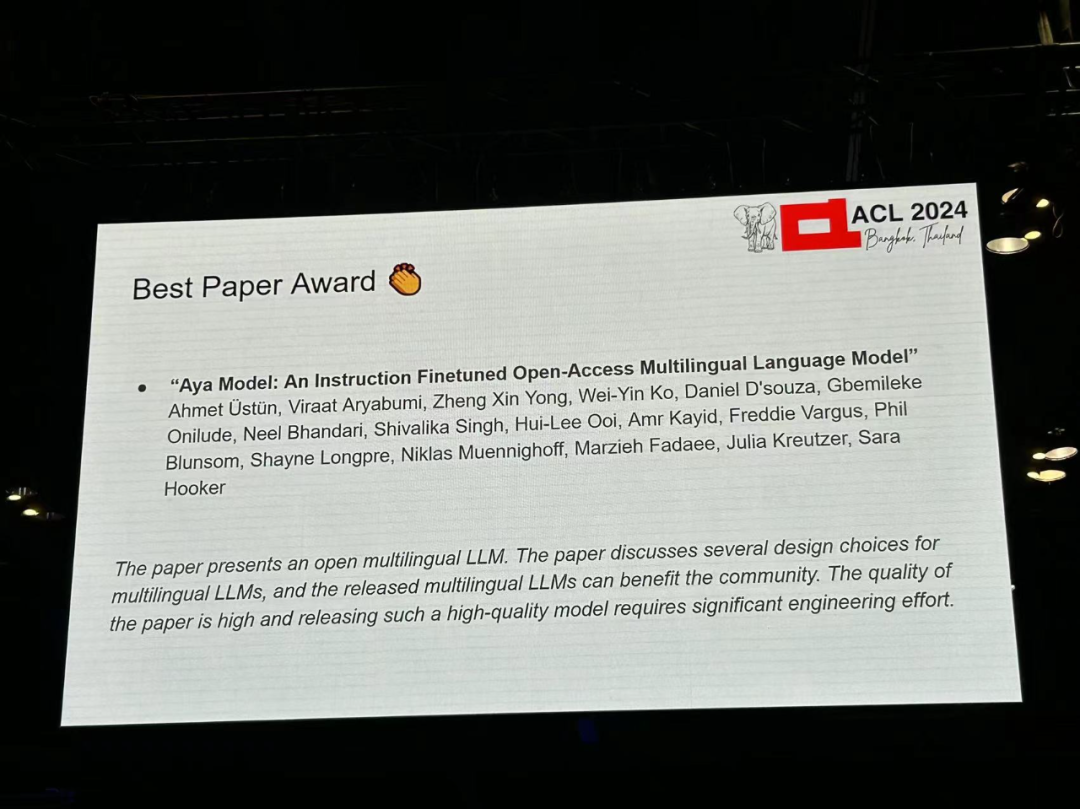

作者:Ah Viraat Aryabumi, Zheng Xin Yong, Wei-Yin Ko 等 機構:Cohere、布朗大學等 論文連結:https:// arxiv.org/pdf/2402.07827

- 機構:CMU、南加州大學

- 論文連結:https:/ /arxiv.org/pdf/2406.05930

論文7:Natural Language Satisfiability: Exploring the Problem Distribution and Evaluating Transformer-based Language Models(未公開)

論文7:Natural Language Satisfiability: Exploring the Problem Distribution and Evaluating Transformer-based Language Models(未公開)

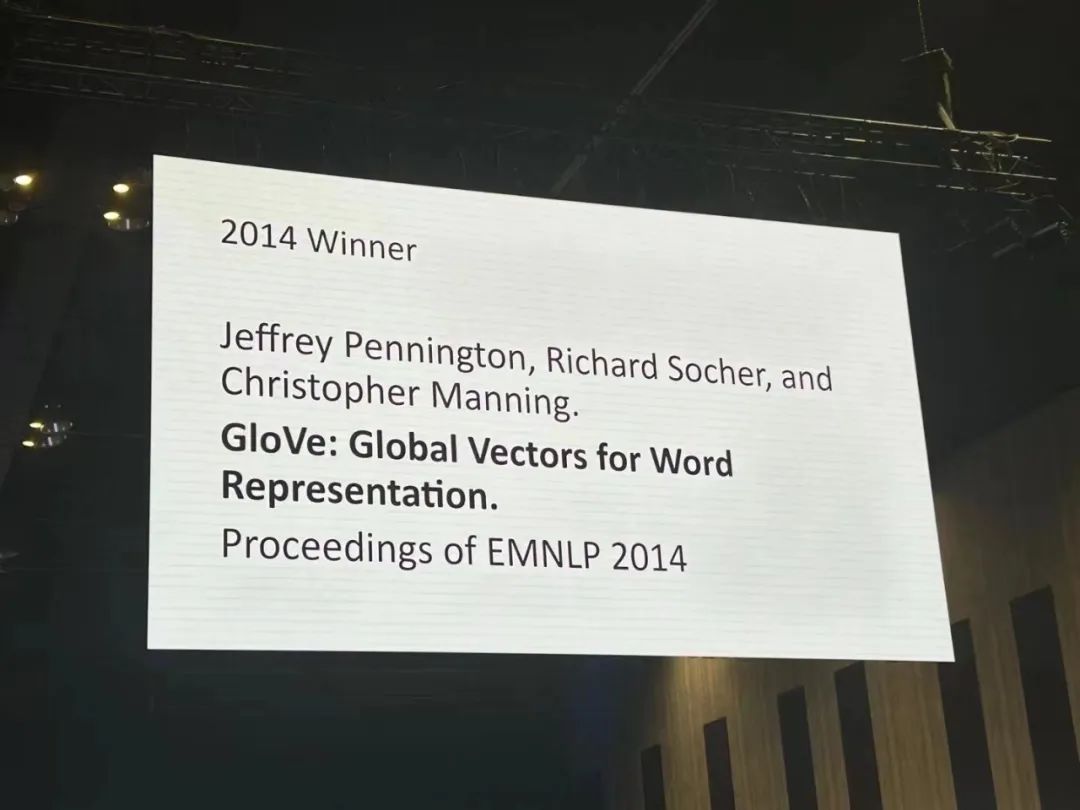

作者:Jeffrey Pennington, . Manning 機構:史丹佛大學 論文連結:https://aclanthology.org/D14-1162.pdf

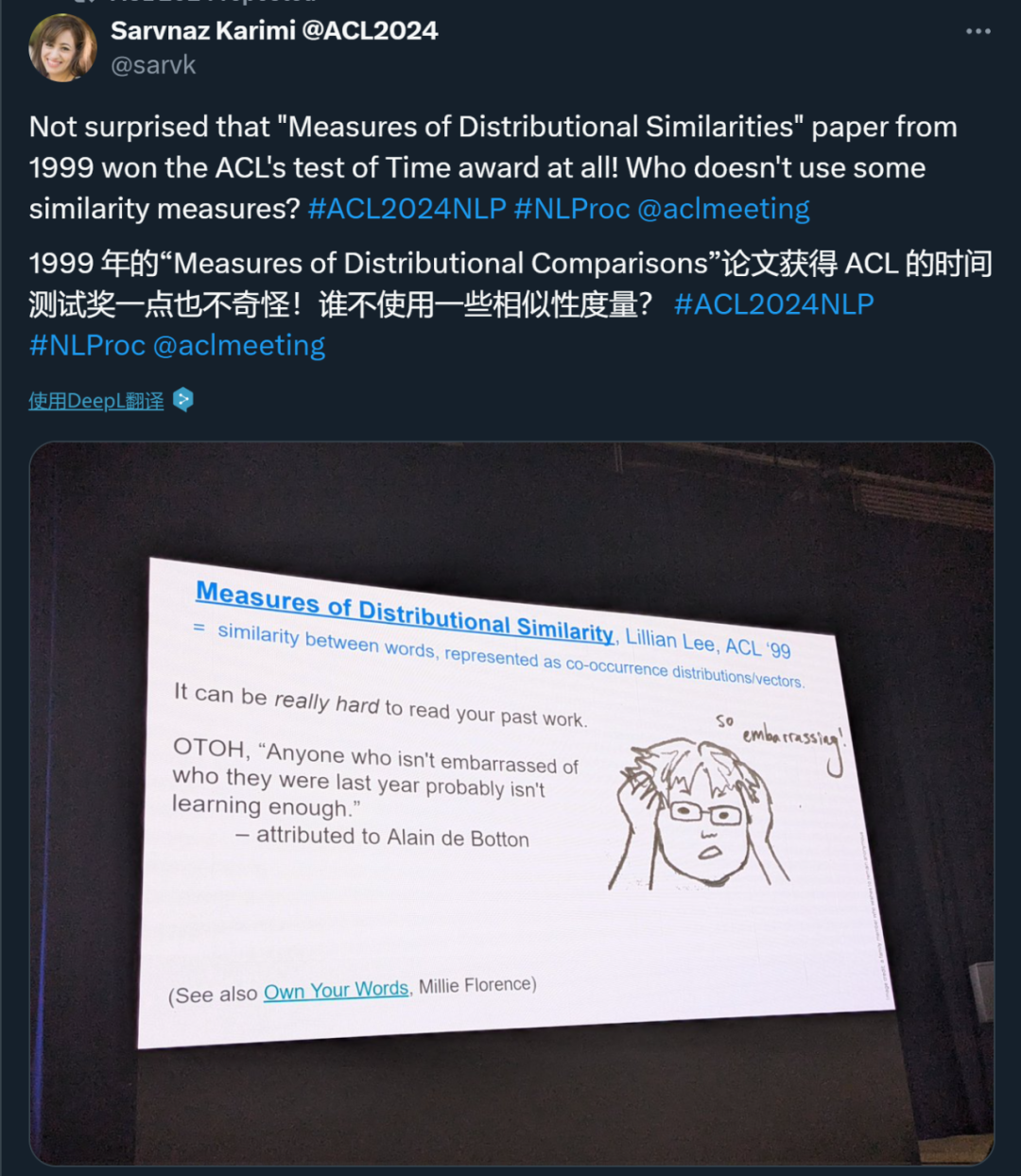

- 作者:Lillian Lee

- 機構:康乃爾大學

- 論文連結:https://aclanthology .org/P99-1004.pdf

論文簡介:作者研究了分佈相似性度量,目的是提高對未見共現事件的機率估計。他們的貢獻有三個面向:對一系列廣泛的度量方法進行實證比較;基於它們所包含的資訊對相似性函數進行分類;引入了一種新的函數,該函數在評估潛在代理分佈方面更為優越。

ACL 的終身成就獎頒給了 Ralph Grishman。 Ralph Grishman 是紐約大學電腦科學系的教授,專注於自然語言處理(NLP)領域的研究。他是 Proteus Project 的創始人,該計畫在資訊抽取(IE)方面做出了重大貢獻,推動了該領域的發展。

- 論文Side Tuning: Fast and Memory-Efficient Tuning of Quantized Large Language Models

- 作者:Zhengxin Zhang, Dan Zhao, Xupeng Miao, Gabriele Jia

- 機構:CMU、清華大學、鵬城實驗室等

- 論文2:L-Eval: Instituting Standardized Evaluation for Cons 🎜>

作者:Chenxin An, Shansan Gong, Ming Zhong, Xingjian Zhao, Mukai Li, Jun Zhang, Lingpeng Kong, Xipeng Qiu 機構:復旦大學、香港大學、伊利諾大學厄巴納- 香檳分校、上海AI Lab 論文連結:https://arxiv.org/abs/2307.11088

- 論文3:Causal-Guided Active Learning for Debiasing Large Language Models

- 論文連結:https://openreview.net /forum?id=idp_1Q6F-lC

- 論文4:CausalGym: Benchmarking causal intermarkingd

作者:Aryaman Arora, Dan Jurafsky, Christopher Potts 機構:史丹佛大學 機構:史丹佛大學

論文5:Don't Hallucinate, Abstain Hallucinate Knowledge Gaps via Multi-LLM Collaboration 作者:Shangbin Feng, Weijia Shi, Yike Wang, Wenxuan Ding, Vidhisha Balachandran, Yulia Tsvetkov

- 論文6:Speech Translation with Speech Foundation Models and Large Language Models: What is There and What is Missing?

- 作者:Marco Gaido, Sara Papi, Matteo Negri, Luisa Bentivogli

- 機構:義大利布魯諾・凱斯勒基金會

論文7:Must Notive? > - 作者:Steven Bird

- 機構:查爾斯達爾文大學

作者:Indraneil Paul、Goran Glavaš、Iryna Gurevych 機構:達姆施塔特工業大學等🎜> 機構:達姆施塔特工業大學等🎜 >-

論文連結:https://arxiv.org/abs/2403.03894

- 論文

- 作者:Matthias Stürmer 、 Veton Matoshi 等

- 機構:伯爾尼大學、史丹佛大學、史丹佛大學、史丹佛大學、史丹佛大學、史丹佛大學、史丹佛大學、史丹佛大學、史丹佛大學、史丹佛大學、史丹佛大學、如史丹佛大學、史丹福>

- 論文連結:https://arxiv.org/pdf/2306.02069

- 論文:PsySafe: A Comprehensive Framework for Psychological-based Attack, Defense, and Evaluation of Multi-agent System Safety

- 作者: Zaibin Zhang 、 Yongting Zhang Zhang ong Lijun Zhang Zhang 、 Huchuan Lu 、 Feng Zhao 、 Yu Qiao、Jing Shao

- 機構:上海人工智慧實驗室、大連理工大學、中國科學技術大學

- 論文連結:https://arxiv.org/pdf/2401.11880

- 論文11:Canargeud Language be Good Emotional Supporter? Mitigating Preference Bias on Emotional Support Conversation

- 作者:Dongjin Kang、Sunghwan Kim作者:Dongjin Kang、Sunghwan Kim

- 作者:Dongjin Kang、Sunghwan Kim

論文連結:https://arxiv.org/pdf/2402.13211

論文12:Political Compass or Spinning Arrow? Towards More Meaningful Evaluations for Values and Opinions in Large Language Models 作者:Paul Röttger 、 - 作者:Paul Röttger 、 作者:Paul Röttger 、Valentin Hofmann 等🎜>機構:博科尼大學、艾倫人工智慧研究院等論文連結:https://arxiv.org/pdf/2402.16786

論文13:Same Task, More Tokens: the Impact of Input Length on the Reasoning Performance of Large Language Models - 作者:Mosh Levy 、 Alon Jacoby 、 Yoav Goldberg

- 機構:巴伊蘭大學、艾倫人工智慧研究院

- 論文連結:https://arxiv.org/pdf/2402.14848

- 論文14 inDo>

論文14 inDolamas English? On the Latent Language of Multilingual Transformers 作者:Chris Wendler 、 Veniamin Veselovsky 等 機構:機構:學校桑

- 論文15:Getting Serious about Humor: Crafting Humor Datasets with Unfunny Large Language Models

- 作者:Zachary Horvitz 、 Jingru Chen 等

作者:Zachary Horvitz 、 Jingru Chen 等

- 論文連結:https://arxiv.org/pdf/2403.00794

- 論文16:Estimating the Level of Dialectness Predicts 呈現- Goldwater

- 機構:愛丁堡大學

-

論文17:G-DlG: Towards Gradient-based Dlverse and hiGh > 作者:Xingyuan Pan, Luyang Huang, Liyan Kang, Zhicheng Liu, Yu Lu, Shanbo Cheng - 機構:ByteDance Research

- 論文連結:https://arxiv.org/pdf/2405.12915

- 論文18:Media Framing: Atypology and Survey of Computational Approaches Across Disciplines

- 作者:Yulia Otmakhova, Shima Khanehzar, Lea Frermann

- 論文連結. net/pdf?id=9AV_zM56pwj

- 論文19:SPZ: A Semantic Perturbation Zod Data Augmentation-d Data Augment. Mixing for Alzheimer's Disease Detection

- 作者:FangFang Li、Cheng Huang、PuZhen Su、Jie Yin

- >論文20:Greed is All You Need: An Evaluation of Tokenizer Inference Methods

機構:內蓋夫本・古里安大學、麻省理工學院

作者:Omri Uzan、Craig W.Schmidt、Chris Tanner、Yuval Pinter 論文連結:https://arxiv.org/abs /2403.01289 - 論文21:Language Complexity and Speech Recocopment, Recottpixel,ott片>

- 作者:Chihiro Taquchi、David Chiang

- 論文連結:https://arxiv.org/abs/2406.09202

論文22:Steering Llamering Llamle via 1] 🎜> 機構:Anthropic、哈佛大學、哥廷根大學(德國)、 Center for Human-Compatible AI

- 論文連結:https://arxiv.org/abs/2312.06681

- 論文23:EconAgent: Large Language Model-Empowered Agents for Simulating Macroeconomic Activities

- 論文連結: https://arxiv.org/abs/2310.10436

- 論文24:M4LE:A Multi-Ability Multi-Rang Multie Multi-Task Multi-Domain Long-Context Evaluation Benchmark for Large Language Models

- 機構:香港中文大學、華為諾亞方舟實驗室、香港科技大學

- 論文連結:https ://arxiv.org/abs/2310.19240

- 論文25:CHECKWHY:論文25:CHECKWHY: Causal Fact Verific >作者:Jiasheng Si、Yibo Zhao、Yingjie Zhu、Haiyang Zhu、Wenpeng Lu、Deyu Zhou

論文26:On Efficient and Statistical Quality Estimation for Data Annotation - Ag Klie,Juan Haladjian,Marc Kirchner,Rahul Nair

- 機構:UKP Lab,、TU Darmstadt 、蘋果公司

- 論文連結:https:https //arxiv.org/pdf/2405.11919

- 論文27:Emulated Disalignment: Safety Alignment for Tignments Lfireignment: Safetyity !

- 作者:Zhanhui Zhou, Jie Liu, Zhichen Dong, Jiaheng Liu, Chao Yang, Wanli Ouyang, Yu Qiao 論文連結:https://arxiv.org/pdf/2402.12343

- 作者:Mohammed Safi Ur Rahman Khan, Priyam Mehta, Ananth Sankar 等

- 機構:Nilekani Centre at AI4Bharat、印度理工學院(馬德拉斯)、微軟等

- 論文連結:https ://arxiv.org/pdf/2403.06350

作者:Silvia Casola, Simona Frenda, Soda Marem Lo, Erhan Sezerer等 -

機構:都靈大學、aequa-tech、亞馬遜開發中心(義大利🎜> 機構:都靈大學、aequa-tech、亞馬遜開發中心(義大利)等 -

論文連結:https://assets.amazon.science/08/83/9b686f424c89b08e8fa0a6e1d020/multipico-multilingualual-perspecti-m-molm

- 作者:

- 機構:紐約大學、哈佛大學、MIT、加州大學聖迭戈分校、維吉尼亞大學、約翰霍普金斯大學

- 論文連結:https://arxiv.org/pdf/2401.08743

- 作者:Davis Yoshida, Kartik Goyal, Kevin Gt.機構:豐田工業大學芝加哥分校、喬治亞理工學院

- 論文連結:https://arxiv.org/pdf/2311.08817

機構:清華大學、上海交通大學、史丹佛大學、南洋理工大學 論文連結:https://arxiv.org/pdf/2312.09085 - 論文34:Let's Go Real Talk: Spoken Dialogue Model for Face-to-Face Conversation

- 作者:Se Jin Park, Chae Won Kim, Hyeongseop Rha, Minsusu等

- 機構:韓國科學技術院(KAIST)

- 論文連結:https://arxiv.org/pdf/2406.07867

作者:Dirk Groeneveld. > - 機構:艾倫人工智慧研究院、華盛頓大學等

- 論文連結:https://arxiv.org/pdf/2402.00838

- 作者:Julen Etxaniz、Oscar Sainz、Naiara Perez、Itziar Aldabe、German Artigau、Eneko Agirk、Naiara Perez、Itziar Aldabe、German Artigau、Eneko AgirT、Aitorl、Eneko Agirk、Aitor Aitor Soroa

- 連結:https://arxiv.org/pdf/2403.20266

> - 論文3:AppWorld: A Controllable World of Apps and People for Benchmarking Interactive Coding Agents

- 社會影響力獎

- 3 篇論文獲得 Social Impact Award。

- 獲獎理由:本文探討了AI 安全主題— 越獄,研究了社會科學研究領域內開發的一種方法。該研究非常有趣,並有可能對社區產生重大影響。

論文2:DIALECTBENCH: A NLP Benchmark for Dialects, Varieties, and Closely-Related Languages - 得獎理由:方言變異是NLP 和人工智慧領域未能充分研究的現象。然而,從語言和社會的角度來看,它的研究具有極高的價值,對應用也有重要的影響。本文提出了一個非常新穎的基準來研究 LLM 時代的這個問題。

論文3:Having Beer after Prayer? Measuring Cultural Bias in Large LanguageModels

- 論文28:IndicLLMSuite: A Blueprint for Creating Pre-training and Fine-Tuning Datasets for Indian Languages

- 論文29:MultiPIPI:C. 🎜>

- 31:MAP's not dead yet: Uncovering true language model modes by conditioning away degeneracy

- 作者:Roberto Navig, Marcogo等等

作者:Rongwu Xu, Brian S. Lin, Shujian Yang, Tiangi Zhang等

- >

筆> 作者, Jialiang Xu, Manling Li, Yi Fung, Chenkai Sun, Nan Jiang, Tarek F. Abdelzaher, Heng Ji

作者, Jialiang Xu, Manling Li, Yi Fung, Chenkai Sun, Nan Jiang, Tarek F. Abdelzaher, Heng Ji

以上是ACL 2024獎項發表:華科大破解甲骨文最佳論文之一、GloVe時間檢驗獎的詳細內容。更多資訊請關注PHP中文網其他相關文章!

Java 架构 Resource for Length map 事件 input li 线性回归 oracle 人工智能 transformer nlp https proteus 重构 自动化 kong gpt llama Access word Foundation

陳述:

本文內容由網友自願投稿,版權歸原作者所有。本站不承擔相應的法律責任。如發現涉嫌抄襲或侵權的內容,請聯絡admin@php.cn