Mamba 架構的大模型又一次向 Transformer 發起了挑戰。

Mamba 架構模型這次終於要「站」起來了?自 2023 年 12 月首次推出以來,Mamba 成為了 Transformer 的強大競爭對手。 此後,採用 Mamba 架構的模型不斷出現,例如 Mistral 發布的首個基於 Mamba 架構的開源大模型 Codestral 7B。 今天,阿布達比技術創新研究所(TII)發布了一個新的開源 Mamba 模型 ——Falcon Mamba 7B。

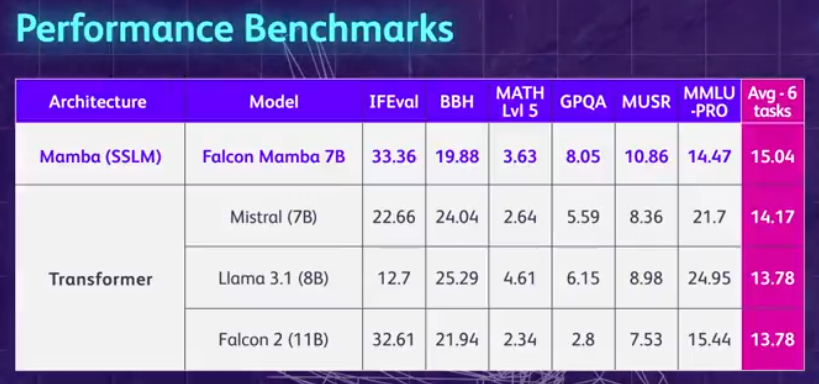

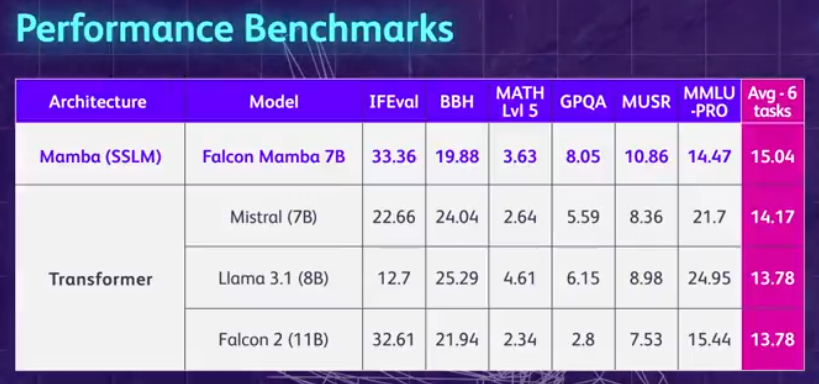

先來總結一波 Falcon Mamba 7B 的亮點:無需增加內存存儲,就可以處理任意長度的序列,並且能夠在單個 24GB A10 GPU 上運行。 目前可以在 Hugging Face 上查看並使用Falcon Mamba 7B,這個僅用因果解碼器的模型採用了新穎的 Mamba 狀態空間語言模型(StateState Space Language Model, SSLM)架構來處理各種文字產生任務。 從結果來看,Falcon Mamba 7B 在一些基準上超越同尺寸級別的領先模型,包括 Meta 的 Llama 3 8B、Llama 3.1 8B 和 Mistral 7B。

Falcon Mamba 7B 分為四個變體模型,分別是基礎版本、指令微調版本、4bit 版本和指令微調 4bit 版本。

作為一個開源模型, Falcon Mamba 7B 採用了基於 Apache 2.0 的許可證“Falcon License 2.0”,支持研究和應用目的。

Hugging Face 網址:https://huggingface.co/tiiuae/falcon-mamba-7b首個Mamba SSLM 架構模型。

一直以來,基於Transformer 的模型一直佔據著生成式AI 的統治地位,然而,研究人員注意到,Transformer 架構在處理較長的文字資訊時可能會遇到困難。 本質上,Transformer 中的注意力機制透過將每個單字(或token)與文本中的每個單字進行比較來理解上下文,它需要更多的運算能力和記憶體需求來處理不斷增長的上下文視窗。 但是如果不相應地擴展計算資源,模型推理速度就會變慢,超過一定長度的文本就沒法處理了。為了克服這些障礙,狀態空間語言模型(SSLM) 架構應運而生,該架構透過在處理單字時不斷更新狀態來運作,已成為一種有前途的替代方案,包括TII 在內的許多機構都在部署這種架構。 Falcon Mamba 7B 採用了卡內基美隆大學和普林斯頓大學研究人員最初在2023 年12 月的一篇論文中提出的 Mamba SSM 架構。 此架構使用一種選擇機制,允許模型根據輸入動態調整其參數。這樣,模型可以專注或忽略特定輸入,類似於注意力機制在 Transformer 中的工作方式,同時提供處理長文本序列(例如整本書)的能力,而無需額外的記憶體或計算資源。 TII 指出,該方法使模型適用於企業級機器翻譯、文字摘要、電腦視覺和音訊處理任務以及估計和預測等任務。 Falcon Mamba 7B > ,主要由 RefinedWeb 資料集組成,並添加了來自公共來源的高品質技術資料、程式碼資料和數學資料。所有資料透過 Falcon-7B/11B 標記器進行 tokenized 操作。 與其他 Falcon 系列模型類似,Falcon Mamba 7B 採用多階段訓練策略進行訓練,上下文長度從 2048 增加到了 8192。此外,受到課程學習概念的啟發,TII 在整個訓練階段精心選擇了混合數據,充分考慮了數據的多樣性和複雜性。 在最後的訓練階段,TII 使用了一小部分高品質精選資料(即來自 Fineweb-edu 的樣本),以進一步提升效能。 在256 個H100 80GB GPU 上完成的,採用了3D 並行(TP=1、PP=1、DP=256)與ZeRO 結合的策略。下圖為模型超參數細節,包括精確度、最佳化器、最大學習率、權重衰減和 batch 大小。

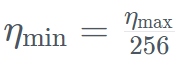

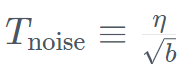

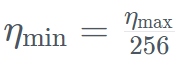

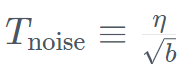

具體而言,Falcon Mamba 7B 經過了AdamW 優化器、WSD(預熱- 穩定- 衰減)學習率計劃的訓練, 並且在前50 GT 的訓練過程中,batch 大小從b_min=128 增加到了b_max =2048。 在穩定階段,TII 使用了最大學習率η_max=6.4×10^−4,然後使用超過500GT 的指數計劃將其衰減到最小值 。同時,TII 在加速階段採用了 BatchScaling 以重新調整學習率 η,使得 Adam 雜訊溫度

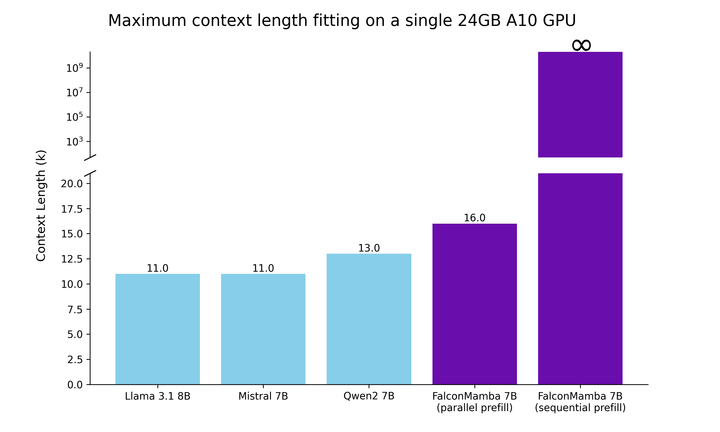

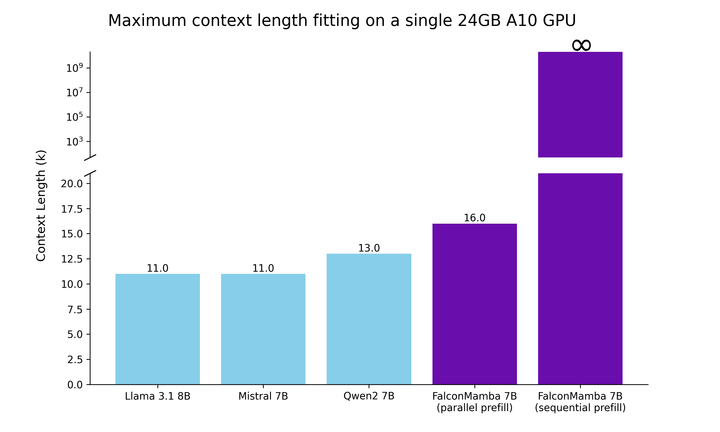

。同時,TII 在加速階段採用了 BatchScaling 以重新調整學習率 η,使得 Adam 雜訊溫度 保持恆定。 為了了解Falcon Mambau 77B與相同尺寸等級模型相比如何,研究進行了一項測試,以確定使用單一24GB A10GPU 時模型可以處理的最大上下文長度。 結果顯示,Falcon Mamba 能夠比目前的 Transformer 模型適應更大的序列,同時理論上能夠適應無限的上下文長度。

保持恆定。 為了了解Falcon Mambau 77B與相同尺寸等級模型相比如何,研究進行了一項測試,以確定使用單一24GB A10GPU 時模型可以處理的最大上下文長度。 結果顯示,Falcon Mamba 能夠比目前的 Transformer 模型適應更大的序列,同時理論上能夠適應無限的上下文長度。

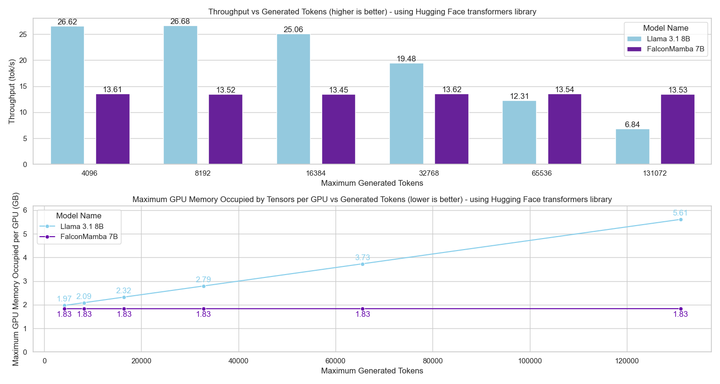

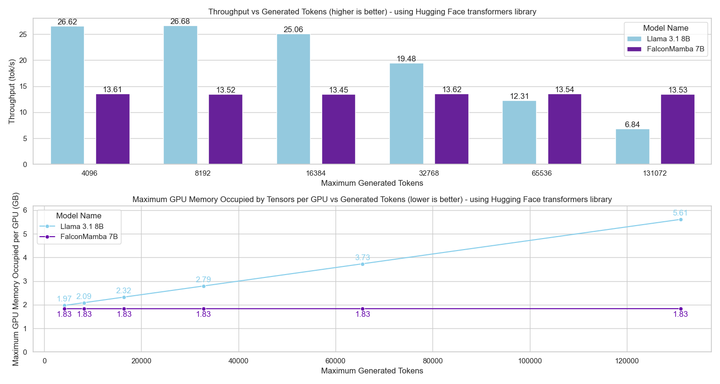

接下來,研究者使用批次大小為 1 ,硬體採用 H100 GPU 的設定中測量模型產生吞吐量。結果如下圖所示,Falcon Mamba 以恆定的吞吐量產生所有 token,且 CUDA 峰值記憶體沒有任何增加。對於 Transformer 模型,峰值記憶體會增加,生成速度會隨著產生的 token 數量的增加而減慢。

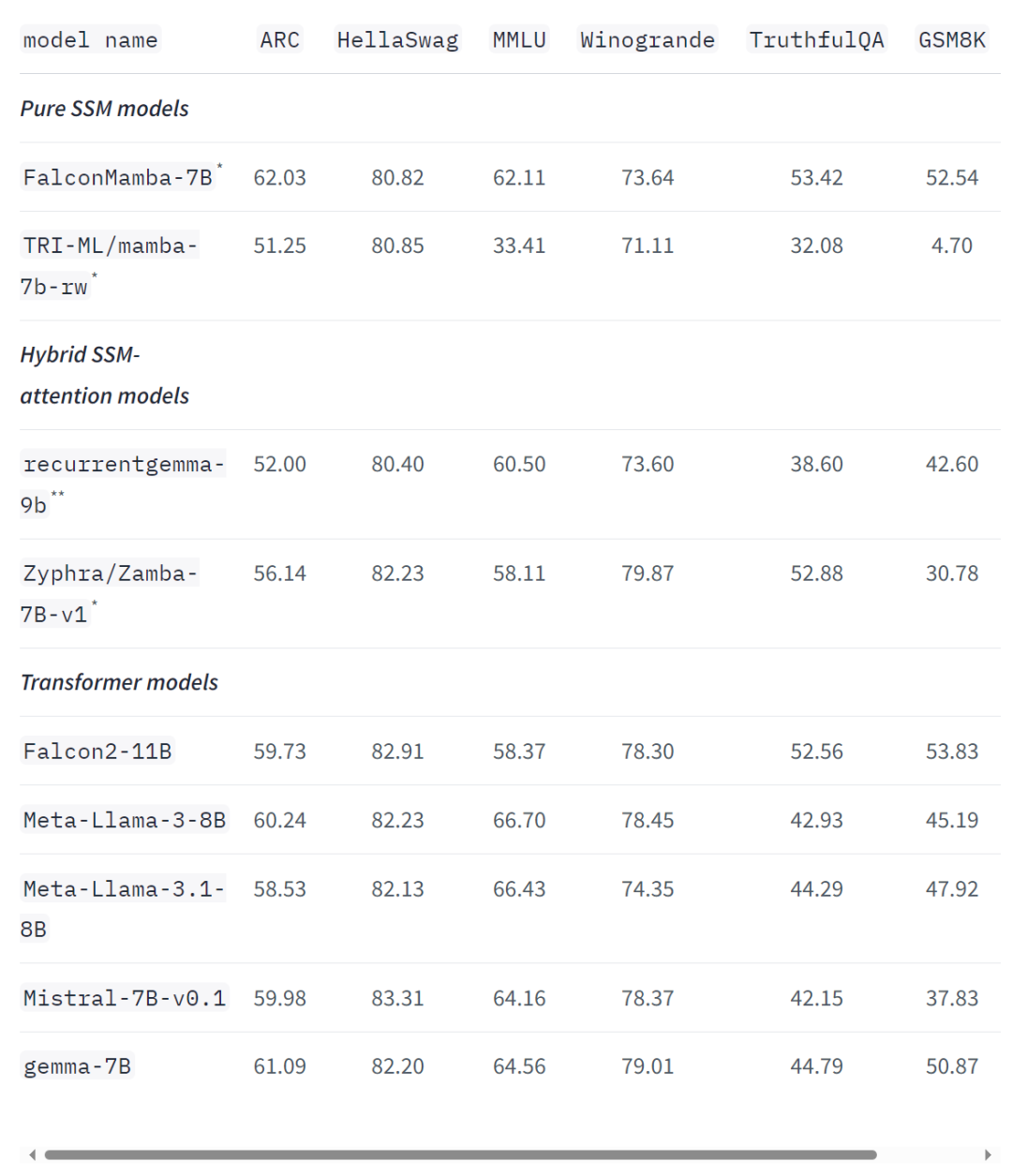

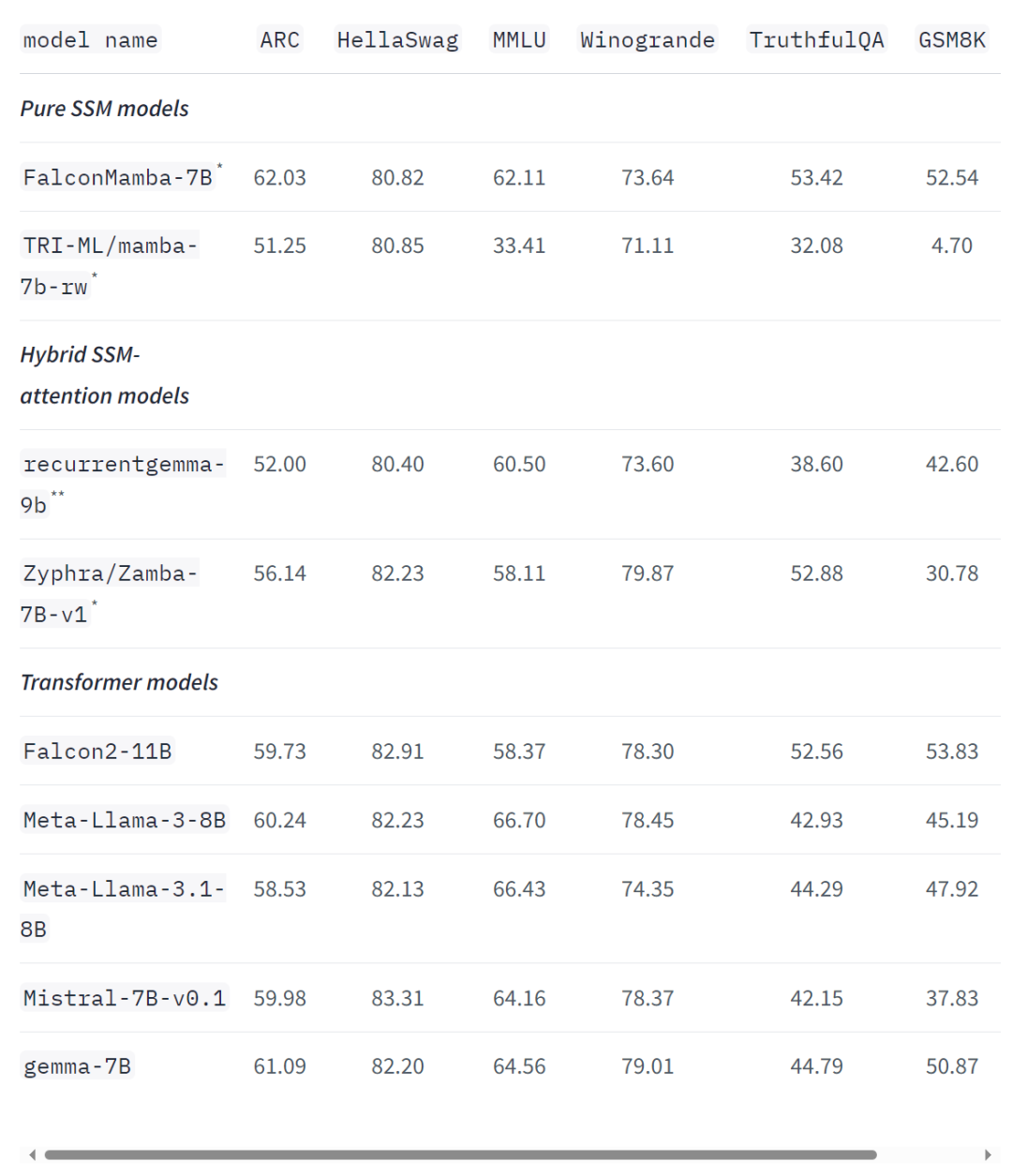

即使在標準的行業基準測試中,新模型的性能也優於或接近流行的 transformer 模型以及純狀態空間模型和混合狀態空間模型。 例如,在Arc、TruthfulQA 和GSM8K 基準測試中,Falcon Mamba 7B 的得分分別為62.03%,53.42% 和52.54%,超過了Llama 342% Llama 3.1 8B, Gemma 7B 和Mistral 7B。然而,在 MMLU 和 Hellaswag 基準測試中,Falcon Mamba 7B 遠遠落後於這些模型。

TII 首席研究員Hakim Hacid 在聲明中表示:Falcon Mamba 7B 的發布代表著該機構向前邁出的重大一步,它激發了新的觀點,並進一步推動了對智慧系統的探索。在 TII,他們正在突破 SSLM 和 transformer 模型的界限,以激發生成式 AI 的進一步創新。 目前,TII 的 Falcon 系列語言模型下載量已超過 4500 萬次 —— 成為阿聯酋最成功的 LLM 版本之一。 Falcon Mamba 7B 論文即將放出,大家可以等一等。 ://hugging.co/ blog/falconmambahttps://venturebeat.com/ai/falcon-mamba-7bs-powerful-new-ai-architecture-offers-alternative-to -transformer-models/以上是非Transformer架構站起來了!首個純無注意力大模型,超越開源巨頭Llama 3.1的詳細內容。更多資訊請關注PHP中文網其他相關文章!

。同時,TII 在加速階段採用了 BatchScaling 以重新調整學習率 η,使得 Adam 雜訊溫度

。同時,TII 在加速階段採用了 BatchScaling 以重新調整學習率 η,使得 Adam 雜訊溫度 保持恆定。

保持恆定。