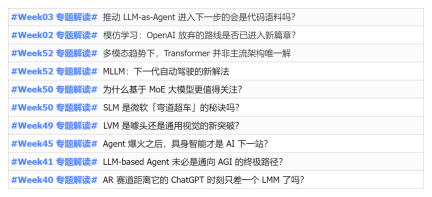

2023年,幾乎 AI 的每個領域都在以前所未有的速度進化,同時,AI也在不斷地推動著具身智慧、自動駕駛等關鍵賽道的技術邊界。在多模態趨勢下,Transformer 作為 AI 大模型主流架構的局面是否會撼動?為何探索基於 MoE (專家混合)架構的大模型成為業界新趨勢?大型視覺模型 (LVM)能否成為通用視覺的新突破? ……我們從過去的半年發布的2023年本站PRO會員通訊中,挑選了10 份針對以上領域技術趨勢、產業變革進行深入剖析的專題解讀,助您在新的一年裡為大展宏圖做好準備。這篇解讀來自2023年 Week50 業內通訊 ?

日期:12 月12 日

事件:Mistral AI 開源了基於MoE(Mixture-of-Experts,專家混合)架構的模型Mixtral 8x7B,其效能達到Llama 2 70B 和GPT -3.5 的水平"的事件進行延展解讀。

首先,弄清楚MoE 是什麼及其來龍去脈

1、概念:

MoEEEEEEEE (Mixture of Experts)是一種混合模型,由多個子模型(即專家)組成,每個子模型都是局部模型,專門處理輸入空間的子集。決定每個資料應該被哪個模型去訓練,從而減輕不同類型樣本之間的干擾。門控模型組成稀疏門控制的深度學習技術。 🎜>

① 在門控網路的訓練中,每個樣本都會被分配到一個或多個專家中;② 在專家網路的訓練中,每個專家都會被訓練以最小化其分配給它的樣本的誤差。整合學習是透過訓練練多個模型(基學習器)未解決相同問題,並且將它們的預測結果簡單組合(例如投票或平均)。整合學習的主要目標是透過減少過度擬合,提高泛化能力,以提高預測效能。常見的整合學習方法包括 Bagging,Boosting 和 Stacking。

4、MoE 歷史來源:

① MoE 的根源可以追溯到 1991 年的論文《 Adaptive Mixture of Local Experts》。這個想法與整合方法類似,目的是為由不同子網路組成的系統提供一種監督過程,每個單獨的網路或專家都專門處理輸入空間的不同區域。透過門控網路確定每個專家的權重。在訓練過程中,專家和門控都會被訓練。

為什麼基於 MoE 的大模型值得關注?

1、通常來講,模型規模的擴展會導致訓練成本顯著增加,計算資源的限製成為了大規模密集模型訓練的瓶頸。為了解決這個問題,基於稀疏 MoE 層的深度學習模型架構被提出。 2、稀疏混合專家模型(MoE)是一種特殊的神經網路架構,可以在不增加推理成本的情況下,為大型語言模型(LLM)增加可學習的參數,而指令調優(instruction tuning)則是一種訓練LLM 遵循指令的技術。 3、MoE+指令微調技術的結合,可大幅提升語言模型的效能。 2023 年7 月,Google、UC 柏克萊和MIT 等機構的研究者發表了論文《Mixture-of-Experts Meets Instruction Tuning: A Winning Combination for Large Language Models》,證明了混合專家模型(MoE)與指令調優的結合能夠讓大型語言模型(LLM)的效能大幅提升。① 具體來說,研究者在一組經過指令微調的稀疏混合專家模型FLAN-MOE 中,使用稀疏激活MoE,並用MoE 層替換Transformer 層的前饋組件,以提供更優的模型容量與運算彈性;其次,在FLAN 集合資料集的基礎上對FLAN-MOE 進行微調。

② 研究者基於上述方法研究在沒有指令調優的情況下在單一下游任務進行直接微調,在指令調優後對下游任務進行in-context 少樣本或零樣本泛化,以及在指令調優後對單一下游任務進行進一步微調等三種實驗設定下LLM 的效能差異。

③ 實驗結果表明,如果不使用指令調優,MoE 模型的性能通常不如與之計算能能力相當的密集模型。但當結合指令調優時,情況發生了變化。指令調優後的 MoE 模型(Flan-MoE)在多個任務上的表現超越了更大的密集模型,即使 MoE 模型的計算成本只是密集模型的三分之一。與密集模型相比。 MoE 模型從指令調優所獲得的效能提升更為顯著,因此當考慮計算效率與效能時,MoE 將成為大型語言模型訓練的有力工具。

4、此次,發布的 Mixtral 8x7B 模型同樣採用了稀疏混合專家網路。

① Mixtral 8x7B 是 decoder-only 的模型。前饋模組從 8 組不同的參數中進行選擇。在每一層網路中,對於每個 token,路由器網路選擇 8 組中的兩組(專家),來處理 token 並將其輸出累積組合。

② Mixtral 8x7B 模型在大多數基準測試中均匹配或優於 Llama 2 70B 以及 GPT3.5,推理速度快了 6 倍。

MoE 的重要優勢:稀疏性是什麼?

1、在傳統的密集模型中,對於每一個輸入都需要在完整的模型中進行計算。在稀疏混合專家模型中,處理輸入資料時只有少數專家模型被激活成者使用,而大部分專家模型處於未被激活狀態,這種狀態便是「稀疏」。而稀疏性是混合專家模型的重要優點,也是提升模型訓練和推理過程的效率的關鍵。

以上是PRO | 為什麼基於 MoE 的大模型更值得關注?的詳細內容。更多資訊請關注PHP中文網其他相關文章!

個人黑客將是一隻非常兇猛的熊May 11, 2025 am 11:09 AM

個人黑客將是一隻非常兇猛的熊May 11, 2025 am 11:09 AM網絡攻擊正在發展。 通用網絡釣魚電子郵件的日子已經一去不復返了。 網絡犯罪的未來是超個性化的,利用了容易獲得的在線數據和AI來製作高度針對性的攻擊。 想像一個知道您的工作的騙子

教皇獅子座XIV揭示了AI如何影響他的名字選擇May 11, 2025 am 11:07 AM

教皇獅子座XIV揭示了AI如何影響他的名字選擇May 11, 2025 am 11:07 AM新當選的教皇獅子座(Leo Xiv)在對紅衣主教學院的就職演講中,討論了他的同名人物教皇里奧XIII的影響,他的教皇(1878-1903)與汽車和汽車和汽車公司的黎明相吻合

AI可以使指導比以往任何時候都更有意義May 10, 2025 am 11:17 AM

AI可以使指導比以往任何時候都更有意義May 10, 2025 am 11:17 AM我完全同意。 我的成功與導師的指導密不可分。 他們的見解,尤其是關於業務管理,構成了我的信念和實踐的基石。 這種經驗強調了我對導師的承諾

AI發掘了採礦業的新潛力May 10, 2025 am 11:16 AM

AI發掘了採礦業的新潛力May 10, 2025 am 11:16 AMAI 增强型矿业设备 矿业作业环境恶劣且危险重重。人工智能系统通过将人类从最危险的环境中移除并增强人类能力,帮助提高整体效率和安全性。人工智能越来越多地用于为矿业作业中使用的自动驾驶卡车、钻机和装载机提供动力。 这些 AI 驱动的车辆能够在危险环境中精确作业,从而提高安全性和生产力。一些公司已经开发出用于大型矿业作业的自动驾驶采矿车辆。 在挑战性环境中运行的设备需要持续维护。然而,维护会使关键设备离线并消耗资源。更精确的维护意味着昂贵且必要的设备的正常运行时间增加以及显著的成本节约。 AI 驱动

為什麼AI代理會觸發25年來最大的工作場所革命May 10, 2025 am 11:15 AM

為什麼AI代理會觸發25年來最大的工作場所革命May 10, 2025 am 11:15 AMSalesforce首席執行官Marc Benioff預測了由AI代理商驅動的巨大的工作場所革命,這是Salesforce及其客戶群中已經進行的轉型。 他設想從傳統市場轉變為一個較大的市場,重點是

隨著AI採用的飆升,人力資源將搖滾我們的世界May 10, 2025 am 11:14 AM

隨著AI採用的飆升,人力資源將搖滾我們的世界May 10, 2025 am 11:14 AM人力資源中AI的崛起:與機器人同事一起導航勞動力 將人工智能集成到人力資源(HR)不再是未來派的概念。它正在迅速成為新現實。 這種轉變影響了人力資源專業人員和員工,DEM

5 Chatgpt提示突破收入高原May 10, 2025 am 11:13 AM

5 Chatgpt提示突破收入高原May 10, 2025 am 11:13 AM您的營收突破就在眼前。打破天花板,將您的業務提升到一個全新的高度。這是可能的。複製、粘貼並修改 ChatGPT 中的方括號內容,並保持相同的聊天窗口打開,以便上下文得以延續。 利用 ChatGPT 打破營收障礙:釋放您的增長潛力 10 倍增長思維 您的目標讓您感到厭倦。曾經讓您興奮的商業願景現在感覺令人痛苦地安全。您達到了目標,卻感覺空虛。成功者並非憑運氣。他們設定大膽的目標,既令人恐懼又令人振奮。他們將商業視為一場遊戲,您也可以如此。追求更高的賭注。夢想更大。計劃更大。執行更大。看著您的成果超

浪漫故事通過生成AI達到新的衷心高度May 10, 2025 am 11:12 AM

浪漫故事通過生成AI達到新的衷心高度May 10, 2025 am 11:12 AM讓我們探索浪漫和生成AI的令人興奮的交集。該分析是我正在進行的《福布斯》專欄的一部分,該列是AI的最新進步,重點關注有影響力的AI複雜性(請參閱此處的鏈接)。 重新定義浪漫:現代觀點 我們已經

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

SAP NetWeaver Server Adapter for Eclipse

將Eclipse與SAP NetWeaver應用伺服器整合。

記事本++7.3.1

好用且免費的程式碼編輯器

EditPlus 中文破解版

體積小,語法高亮,不支援程式碼提示功能

MinGW - Minimalist GNU for Windows

這個專案正在遷移到osdn.net/projects/mingw的過程中,你可以繼續在那裡關注我們。 MinGW:GNU編譯器集合(GCC)的本機Windows移植版本,可自由分發的導入函式庫和用於建置本機Windows應用程式的頭檔;包括對MSVC執行時間的擴展,以支援C99功能。 MinGW的所有軟體都可以在64位元Windows平台上運作。

ZendStudio 13.5.1 Mac

強大的PHP整合開發環境