AIxiv專欄是本站發布學術、技術內容的欄位。過去數年,本站AIxiv專欄接收通報了2,000多篇內容,涵蓋全球各大專院校與企業的頂尖實驗室,有效促進了學術交流與傳播。如果您有優秀的工作想要分享,歡迎投稿或聯絡報道。投稿信箱:liyazhou@jiqizhixin.com;zhaoyunfeng@jiqizhixin.com

吳翼,清華大學對齊資訊院助理影響,曾任OpenAI 全職學習師,大研究領域為人機交互,機器人學習等。 2019 年在美國加州大學柏克萊分校取得博士學位,師從 Stuart Russell 教授;2014 年大學部畢業於清華大學交叉資訊院(姚班)。其代表作包括:NIPS2016 最佳論文,Value Iteration Network;多智能體深度強化學習領域最高引用論文,MADDPG 演算法;OpenAI hide-and-seek 專案等。 如何讓大模型更好的遵從人類指令和意圖?如何讓大模型有更好的推理能力?如何讓大模型避免幻覺?能否解決這些問題,是讓大模型真正廣泛可用,甚至實現超級智慧(Super Intelligence)最為關鍵的技術挑戰。這些最困難的挑戰也是吳翼團隊長期以來的研究重點,大模型對齊技術(Alignment)所要攻克的難題。 對齊技術中,最重要的演算法框架就是根據人類回饋的強化學習(RLHF, Reinforcement Learning from Human Feedback)。 RLHF 根據人類對大模型輸出的偏好回饋,來學習基於人類回饋的獎勵函數(Reward Model),並進一步對大模型進行強化學習訓練,讓大模型在反覆迭代中學會辨別回覆的好壞,並實現模型能力提升。目前世界上最強的語言模型,例如 OpenAI 的 GPT 模型和 Anthropic 的 Claude 模型,都極為強調 RLHF 訓練的重要性。 OpenAI 和 Anthropic 內部也都開發了基於大規模 PPO 演算法的 RLHF 訓練系統進行大模型對齊。 然而,由於PPO 演算法流程複雜,算力消耗大,美國AI 公司的大規模RLHF 訓練系統也從不開源,所以儘管PPO 演算法非常強大,學術界的對齊工作卻一直很少採用複雜的PPO 演算法進行RLHF 研究,轉而普遍使用SFT(監督微調)或DPO(Direct Policy Optimization)等更簡化、更直接、對訓練系統要求更低的對齊演算法。 那麼,簡單的對齊演算法一定效果更好嗎?吳翼團隊發表在 ICML 2024 的工作 “Is DPO Superior to PPO for LLM Alignment? A Comprehensive Study” 仔細探討了 DPO 與 PPO 演算法的特點,並指出提升 RLHF 演算法效果的關鍵點。在該工作中,吳翼團隊基於自研的大規模RLHF 訓練系統,首次採用PPO 演算法及參數量更少的開源模型,在公認最困難的挑戰—— 程式碼生成任務CodeContest—— 上超過閉源大模型AlphaCode 41B。

相關成果被 ICML 2024 錄用為 Oral Presentation,並將在 7 月 23 日於 ICML 2024 第一個 Oral session Alignment-1 上和 OpenAI、Anthropic 等知名機構的工作一起進行公開匯報。

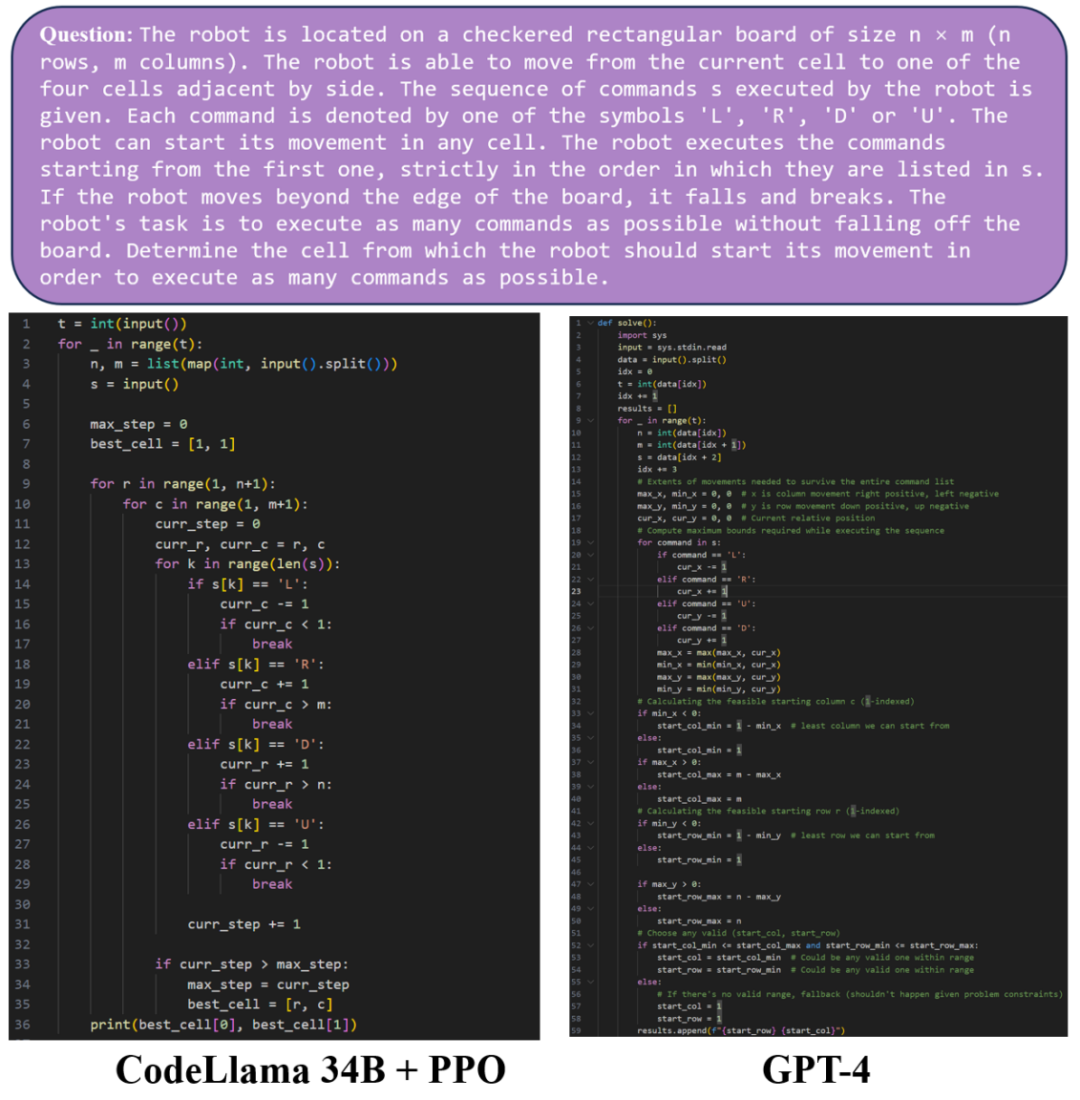

接下來讓我們比較一下GPT-4 和經過PPO 演算法訓練的CodeLlama 34B 模型在程式碼產生上的效果,在範例1 中,經過PPO 演算法訓練的CodeLlama 34B 模型與GPT-4 模型產生了品質相當的程式碼。

在範例 2 中,可以看到經過 PPO 演算法訓練的 CodeLlama 34B 模型與 GPT-4 模型都能產生完整且可運作的 python 程式碼。然而,在這個例子下,GPT-4 產生了錯誤的程式碼,在測試資料上無法正確輸出。而經過 PPO 演算法訓練的 CodeLlama 34B 模型產生的程式碼可以通過測試。

在 ICML 2024 的這篇論文中,研究團隊詳細探討了 DPO 與 PPO 演算法的特點,並指出提升 DPO 和 PPO 能力的關鍵點。

- 論文標題:Is DPO Superior to PPO for LLM Alignment? A Comprehensive Study

-

論文地址:https://arxiv.org/pdf/2404.107713717713/pdf/ DPO 演算法的限制

相比於PPO,DPO 使用離線資料而非線上取樣資料訓練。經過分析,DPO 演算法會導致訓練出的模型對訓練資料分佈以外的輸出產生偏好,在某些情況下產生不可預測的回應。

於是,為了提升 DPO 演算法的能力,研究團隊總結了兩個關鍵技術:在 RLHF 訓練前進行額外的 SFT 訓練,以及使用線上取樣資料而非離線資料

實驗表明,使用額外的SFT 訓練可以使base 模型以及reference 模型更偏向於資料集內的分佈,大大提升DPO 演算法效果;另一方面,使用線上取樣資料進行迭代訓練的DPO 演算法可以得到穩步提升,表現遠優於基礎的DPO 演算法。

PPO 演算法的關鍵點

除去DPO,論文中也總結了發揮PPO 最大能力的三個關鍵點:? size)

優勢歸一化(advantage normalization)以及對reference model 使用指數移動平均值進行更新(exponential moving average for the reference model)。

研究團隊成功使用 PPO 演算法在對話任務 Safe-RLHF/HH-RLHF 以及程式碼產生任務 APPS/CodeContest 上達到了 SOTA 的效果。

- 在對話任務上,研究團隊發現綜合了三個關鍵點的 PPO 演算法顯著優於 DPO 演算法以及線上取樣的 DPO 演算法 DPO-Iter。

在程式碼產生任務 APPS 和 CodeContest 上,基於開源模型 Code Llama 34B,PPO 演算法也達到了最強的水平,在 CodeContest 上超越了之前的 SOTA,AlphaCode 41B。

想要實現效果較好的大模型對齊,高效率的訓練系統是不可缺少的,在實現大規模強化學習訓練上,吳翼團隊有長期的積累,從2021 年開始就搭建了專屬的分散式增強學習框架。

- NeurIPS 2022 The Surprising Effectiveness of PPO in Cooperative Multi-Agent Games [1]:提出並開源了用於多智能體的強化學習並行訓練框架MAPPO,支持合作場景下的多智能體訓練,該工作被用於多智能體的強化學習並行訓練框架MAPPO,支持合作場景下的多智能體訓練,該工作被大量多智能體領域工作採用,目前論文引用量已超過1k。

- ICLR 2024 Scaling Distributed Reinforcement Learning to Over Ten Thousand Cores [2]: 提出了用於強化學習的分散式訓練框架,可輕鬆擴展至上萬個核心,加速比超越OpenAI 的大規模強化學習系統Rapid 。

- ReaLHF: Optimized RLHF Training for Large Language Models through Parameter Reallocation [3]: 最近,吳翼團隊進一步實現了分散式 RLHF 訓練框架 ReaLHF。吳翼團隊的 ICML Oral 論文正是基於 ReaLHF 系統產出的。 ReaLHF 系統經過長時間的開發,經歷大量的細節打磨,達到最優效能。相較於先前的開源工作,ReaLHF 可以在RLHF 這個比預訓練更複雜的場景下達到近乎線性的拓展性,同時具有更高的資源利用率,在128 塊A100 GPU 上也能穩定快速地進行RLHF訓練,相關工作已開源:https://github.com/openpsi-project/ReaLHF

除了提升大語言模型程式碼能力之外,吳翼團隊還採用多種將強化學習演算法和大模型結合的方式,實現了多種複雜LLM Agent,並且可以和人類進行複雜互動。 在 MiniRTS 中使用強化學習既能聽從人類指令也能做出最優決策的語言智能體 [4]。

在狼人殺中訓練策略多樣化的強化學習策略以提升大模型的決策能力 [5]。

在 Overcooked 遊戲中結合小模型與大模型實現能進行即時回饋的合作 Language Agent [6]。

結合強化學習訓練的機器人控制策略與大語言模型推理能力讓機器人能夠執行一系列複雜任務 [7]。

為了使大模型能真正走進千家萬戶,對齊技術是至關重要的,對於學術界和大模型從業者來說,好的開源工作和論文無疑會大大降低實驗成本和開發難度,也期待隨著科技發展,會有更多服務人類的大模型出現。 [1] Yu, Chao, Akash Velu, Eugene Vinitsky, Jiaxuan Gao, Yu Wang, Alexandre Bayen, and Yi Wu. "The surprising effectiveness of ppo in cooper

[2] Mei, Zhiyu, Wei Fu, Guangju Wang, Huanchen Zhang, and Yi Wu. "SRL: Scaling Distributed Reinforcement Learning to Over Ten Thousand Cores."

Wei Fu, Kaiwei Li, Guangju Wang, Huanchen Zhang, and Yi Wu. "ReaLHF: Optimized RLHF Training for Large Language Models through Parameter Reallocation."[4; Yutao Ouyang, Chao Yu, and Yi Wu. "Language-guided generation of physically realistic robot motion and control."[5] Xu, Zel, Chau, Zelel, Chajei 和 Yein, Yun, Zel, Chau* 「Language agents with reinforcement learning for strategic play in the werewolf game."[6] Liu, Jijia, Chao Yu, Jiaxuan Gao, Yuing X powered hierarchical language agent for real-time human-ai coordination."[7] Ouyang, Yutao, Jinhan Li, Yunfei Li, Zhongyu Li, horo, Koush Sreeu. Locomotion and Manipulation on a Quadrupedal Robot with Large Language Models."以上是ICML 2024 Oral | DPO是否比PPO更適合LLM,清華吳翼團隊最新揭秘的詳細內容。更多資訊請關注PHP中文網其他相關文章!