為了實現高精度的區域級多模態理解,本文提出了一種動態分辨率方案來模擬人類視覺認知系統。

本文作者來自中國科學院大學LAMP實驗室,其中第一作者趙毓鐘是中國科學院大學2023級博士生,共同作者劉峰是中國科學院大學2020級直博生。他們的主要研究方向是視覺語言模型和視覺目標感知。

論文標題:DynRefer: Delving into Region-level Multi-modality Tasks via Dynamic Resolution 論文連結:https://arxhttpsiv./ab ://github.com/callsys/DynRefer

動機

,其中

,其中 。這裡的

。這裡的 表示參考區域的邊界框,

表示參考區域的邊界框, 表示整個影像的尺寸,t 表示插值係數。在訓練過程中,我們從候選視圖中隨機選擇 n 個視圖,以模擬由於注視和眼球快速運動而產生的圖像。這些 n 個視圖對應於內插係數 t,即

表示整個影像的尺寸,t 表示插值係數。在訓練過程中,我們從候選視圖中隨機選擇 n 個視圖,以模擬由於注視和眼球快速運動而產生的圖像。這些 n 個視圖對應於內插係數 t,即 。我們固定保留僅包含參考區域的視圖(即

。我們固定保留僅包含參考區域的視圖(即 )。經實驗證明此視圖有助於保留區域細節,對於所有區域多模態任務都至關重要。

)。經實驗證明此視圖有助於保留區域細節,對於所有區域多模態任務都至關重要。

。如圖 3 左側所示。由於裁剪、調整大小和 RoI-Align 引入的空間誤差,這些區域嵌入在空間上並不對齊。受 deformable convolution 操作啟發,我們提出了一個對齊模組,透過將

。如圖 3 左側所示。由於裁剪、調整大小和 RoI-Align 引入的空間誤差,這些區域嵌入在空間上並不對齊。受 deformable convolution 操作啟發,我們提出了一個對齊模組,透過將  對齊到

對齊到  來減少偏差,其中

來減少偏差,其中  是僅包含參考區域的視圖編碼的區域嵌入。對於每個區域嵌入

是僅包含參考區域的視圖編碼的區域嵌入。對於每個區域嵌入 ,首先將其與

,首先將其與  連接,然後透過卷積層計算一個二維偏移圖。

連接,然後透過卷積層計算一個二維偏移圖。  的空間特徵然後根據二維偏移重新取樣。最後,對齊後的區域嵌入沿著通道維度連接並透過 linear 層進行融合。輸出進一步透過視覺重採樣模組,即 Q-former,進行壓縮,從而提取原始影像 x 的參考區域

的空間特徵然後根據二維偏移重新取樣。最後,對齊後的區域嵌入沿著通道維度連接並透過 linear 層進行融合。輸出進一步透過視覺重採樣模組,即 Q-former,進行壓縮,從而提取原始影像 x 的參考區域  的區域表示(圖 3 中的

的區域表示(圖 3 中的 )。

)。

透過隨機多視圖嵌入模組計算得到的區域表示

如圖 3(右)所示。透過使用標籤作為查詢,作為鍵和值,計算預定義標記的置信度來完成標記過程。我們從真值字幕中解析出標籤,以監督識別解碼器。 ii) 區域 - 文本對比學習。類似於區域標記解碼器,解碼器

轉換為語言描述。

轉換為語言描述。

。視圖一是固定的(

。視圖一是固定的( ),視圖二隨機選擇或固定。

),視圖二隨機選擇或固定。  ,我們可以得到具有動態解析度特性的區域表示。為了評估不同動態解析度下的特性,我們訓練了一個雙視圖(n=2)的 DynRefer 模型,並在四個多模態任務上進行評估。從圖 4 中的曲線可以看出,對於沒有情境資訊的視圖(

,我們可以得到具有動態解析度特性的區域表示。為了評估不同動態解析度下的特性,我們訓練了一個雙視圖(n=2)的 DynRefer 模型,並在四個多模態任務上進行評估。從圖 4 中的曲線可以看出,對於沒有情境資訊的視圖( ),屬性偵測(Attribute detection)獲得了更好的結果。這可以解釋為這種任務通常需要詳細的區域資訊。而對於區域級字幕(Region-level captioning)和密集字幕生成(Dense captioning)任務,需要上下文豐富的視圖(

),屬性偵測(Attribute detection)獲得了更好的結果。這可以解釋為這種任務通常需要詳細的區域資訊。而對於區域級字幕(Region-level captioning)和密集字幕生成(Dense captioning)任務,需要上下文豐富的視圖(  ),以便完整理解參考區域。需要注意的是,過多上下文的視圖(

),以便完整理解參考區域。需要注意的是,過多上下文的視圖( )會降低所有任務的效能,因為它們引入了過多與區域無關的資訊。當已知任務類型時,我們可以根據任務特性採樣適當的視圖。當任務類型未知時,我們首先建立一組在不同插值係數 t 下的候選視圖集合,

)會降低所有任務的效能,因為它們引入了過多與區域無關的資訊。當已知任務類型時,我們可以根據任務特性採樣適當的視圖。當任務類型未知時,我們首先建立一組在不同插值係數 t 下的候選視圖集合, 。從候選集中,透過貪婪搜尋演算法採樣 n 個視圖。搜尋的目標函數定義為:

。從候選集中,透過貪婪搜尋演算法採樣 n 個視圖。搜尋的目標函數定義為: 其中

其中 表示第 i 個視圖的插值係數,

表示第 i 個視圖的插值係數, 表示第 i 個視圖,pHASH (・) 表示感知圖像雜湊函數,

表示第 i 個視圖,pHASH (・) 表示感知圖像雜湊函數, 表示異或操作。為了從全域視角比較視圖的訊息,我們利用 "pHASH (・)" 函數將視圖從空間域轉換到頻域,然後編碼成雜湊碼。對於

表示異或操作。為了從全域視角比較視圖的訊息,我們利用 "pHASH (・)" 函數將視圖從空間域轉換到頻域,然後編碼成雜湊碼。對於 這一項,我們減少上下文豐富視圖的權重,以避免引入過多冗餘資訊。

這一項,我們減少上下文豐富視圖的權重,以避免引入過多冗餘資訊。

Line 1-6:隨機動態多視圖要優於固定視圖。 Line 6-10:透過最大化資訊選擇視圖優於隨機選擇視圖。 Line 10-13:多任務訓練可以學習得到更好的區域表徵。

以上是超越CVPR 2024方法,DynRefer在區域級多模態辨識任務上,多項SOTA的詳細內容。更多資訊請關注PHP中文網其他相關文章!

如何使用Florence -2 -Analytics Vidhya執行計算機視覺任務Apr 19, 2025 am 10:21 AM

如何使用Florence -2 -Analytics Vidhya執行計算機視覺任務Apr 19, 2025 am 10:21 AM介紹 原始變壓器的引入為當前的大語言模型鋪平了道路。同樣,在引入變壓器模型之後,引入了視覺變壓器(VIT)。喜歡

使用Langchain Text Splitters -Analytics Vidhya拆分數據的7種方法Apr 19, 2025 am 10:11 AM

使用Langchain Text Splitters -Analytics Vidhya拆分數據的7種方法Apr 19, 2025 am 10:11 AMLangchain文本拆分器:優化LLM輸入以提高效率和準確性 我們上一篇文章介紹了Langchain的文檔加載程序。 但是,LLM具有上下文窗口大小的限制(以代幣測量)。 超過此限制會截斷數據,comp

免費生成的AI課程:開創創新的未來Apr 19, 2025 am 10:01 AM

免費生成的AI課程:開創創新的未來Apr 19, 2025 am 10:01 AM生成的AI:革命性的創造力和創新 生成的AI通過按下按鈕來創建文本,圖像,音樂和虛擬世界來改變行業。 它的影響跨越視頻編輯,音樂製作,藝術,娛樂,HEA

使用通用句子編碼器和Wikiqa創建QA模型Apr 19, 2025 am 10:00 AM

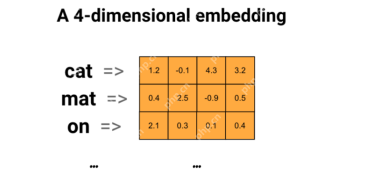

使用通用句子編碼器和Wikiqa創建QA模型Apr 19, 2025 am 10:00 AM利用嵌入模型的力量來回答高級問題 在當今信息豐富的世界中,立即獲得精確答案的能力至關重要。 本文展示了使用強大的提問(QA)模型

前十名必須閱讀機器學習研究論文Apr 19, 2025 am 09:53 AM

前十名必須閱讀機器學習研究論文Apr 19, 2025 am 09:53 AM本文探討了十個徹底改變人工智能(AI)和機器學習(ML)的開創性出版物。 我們將研究神經網絡和算法的最新突破,並解釋驅動現代AI的核心概念。 Th

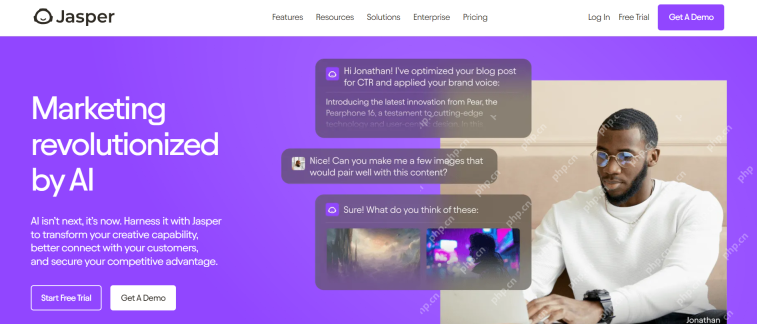

替換SEO機構的11個AI工具 - 分析VidhyaApr 19, 2025 am 09:49 AM

替換SEO機構的11個AI工具 - 分析VidhyaApr 19, 2025 am 09:49 AMAI在SEO中的崛起:超過SEO代理商的前11個工具 AI的快速發展已深刻地重塑了SEO景觀。 旨在提高頂級搜索引擎排名的企業正在利用AI優化其在線策略的能力。 來自AU

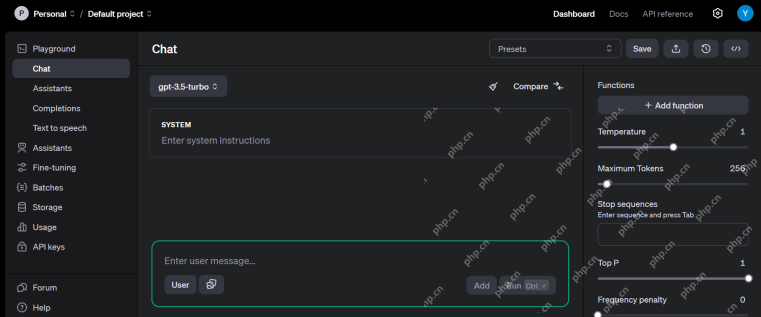

前10個免費的AI遊樂場供您在2025年嘗試-Analytics VidhyaApr 19, 2025 am 09:45 AM

前10個免費的AI遊樂場供您在2025年嘗試-Analytics VidhyaApr 19, 2025 am 09:45 AM探索2024年最好的免費AI遊樂場:綜合指南 訪問正確的工具和平台是在不斷發展的人工智能(AI)領域學習和創新的關鍵。 AI遊樂場提供了絕佳的機會

矢量數據庫中索引算法的詳細指南Apr 19, 2025 am 09:41 AM

矢量數據庫中索引算法的詳細指南Apr 19, 2025 am 09:41 AM介紹 向量數據庫是專門的數據庫,旨在有效地存儲和檢索高維矢量數據。 這些向量代表數據點的特徵或屬性,範圍從數十到數千個維度,具體取決於

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

AI Hentai Generator

免費產生 AI 無盡。

熱門文章

熱工具

Dreamweaver Mac版

視覺化網頁開發工具

記事本++7.3.1

好用且免費的程式碼編輯器

mPDF

mPDF是一個PHP庫,可以從UTF-8編碼的HTML產生PDF檔案。原作者Ian Back編寫mPDF以從他的網站上「即時」輸出PDF文件,並處理不同的語言。與原始腳本如HTML2FPDF相比,它的速度較慢,並且在使用Unicode字體時產生的檔案較大,但支援CSS樣式等,並進行了大量增強。支援幾乎所有語言,包括RTL(阿拉伯語和希伯來語)和CJK(中日韓)。支援嵌套的區塊級元素(如P、DIV),

Safe Exam Browser

Safe Exam Browser是一個安全的瀏覽器環境,安全地進行線上考試。該軟體將任何電腦變成一個安全的工作站。它控制對任何實用工具的訪問,並防止學生使用未經授權的資源。

SAP NetWeaver Server Adapter for Eclipse

將Eclipse與SAP NetWeaver應用伺服器整合。