英偉達新研究:上下文長度虛標嚴重,32K性能合格的都不多

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB原創

- 2024-06-05 16:22:471207瀏覽

無情戳穿「長上下文」大模型的虛標現象-

英偉達新研究發現,包括GPT-4在內的10個大模型,產生達到128k甚至1M上下文長度的都有。

但一番考驗下來,在新指標「有效上下文」上縮水嚴重,能達到32K的都不多。

新基準名為RULER,包含檢索、多跳追蹤、聚合、問答四大類共13項任務。 RULER定義了“有效上下文長度”,即模型能保持與Llama-7B基線在4K長度下同等性能的最大長度。

這項研究被學者評價為「非常有洞察力」。

不少網友看到這項新研究後,也非常想看到上下文長度王者玩家Claude和Gemini的挑戰結果。 (論文中並未涵蓋)

一起來看英偉達是如何定義「有效的上下文」指標。

測試任務更多、更難

要評測大模型的長文本理解能力,得先選個好標準,現圈內流行的ZeroSCROLLS、L-Eval、LongBench、InfiniteBench等,要么僅評估了模型檢索能力,要么受限於先驗知識的干擾。

所以英偉達剔除的RULER方法,一句話概括就是「確保評估專注於模型處理和理解長上下文的能力,而不是從訓練資料中回憶資訊的能力」。

RULER的評測資料減少了對「參數化知識」的依賴,也就是大模型在訓練過程中已經編碼到自身參數裡的知識。

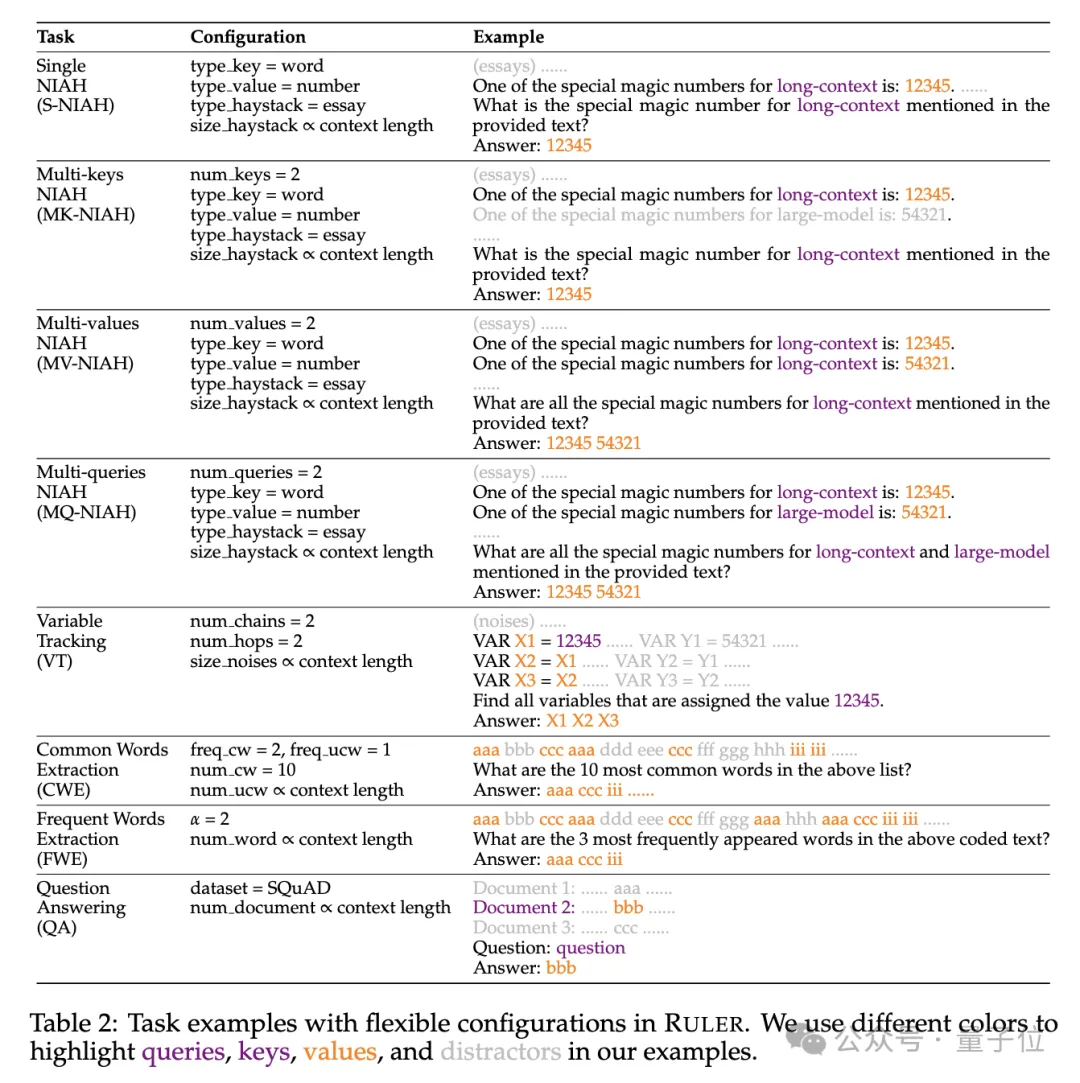

具體來說,RULER基準擴展了流行的「大海撈針」測試,新增四大類任務。

檢索方面,從海撈針標準的單針檢索任務出發,又加入如下新類型:

- 多針檢索(Multi-keys NIAH, MK-NIAH):上下文中插入多個幹擾針,模型需檢索指定的那一個

- 多值檢索(Multi-values NIAH, MV-NIAH):一個鍵(key)對應多個值(values),模型需要擷取與特定鍵關聯的所有值。

- 多重查詢檢索(Multi-queries NIAH, MQ-NIAH):模型需根據多個查詢在文字中檢索出相應的多個針。

除了升級版檢索,RULER還增加了多重跳躍追蹤(Multi-hop Tracing)挑戰。

具體來說,研究人員提出了變數追蹤(VT),模擬了指涉消解(coreference resolution)的最小任務,要求模型追蹤文本中變數的賦值鏈,即使這些賦值在文本中是非連續的。

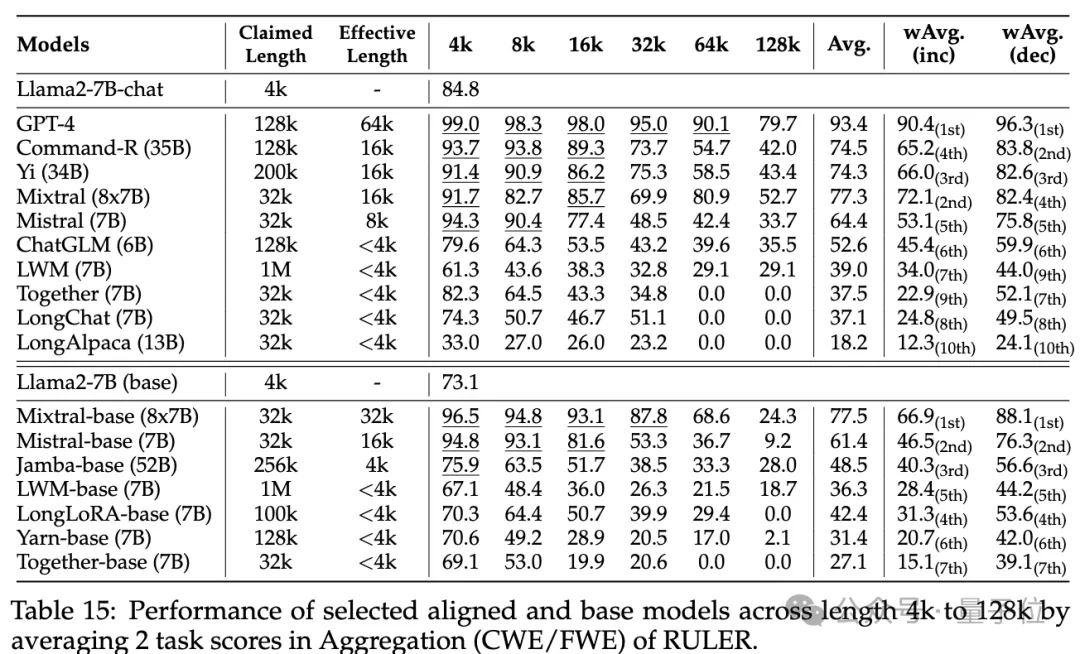

挑戰第三關是聚合(Aggregation),包含:

- 常見詞彙擷取(Common Words Extraction, CWE):模型需要從文本中提取出現次數最多的常見詞彙。

- 頻繁詞彙提取(Frequent Words Extraction, FWE):與CWE類似,但是詞彙的出現頻率是根據其在詞彙表中的排名和Zeta分佈參數α來決定的。

挑战第四关是问答任务(QA),在现有阅读理解数据集(如SQuAD)的基础上,插入大量干扰段落,考查长序列QA能力。

各模型上下文实际有多长?

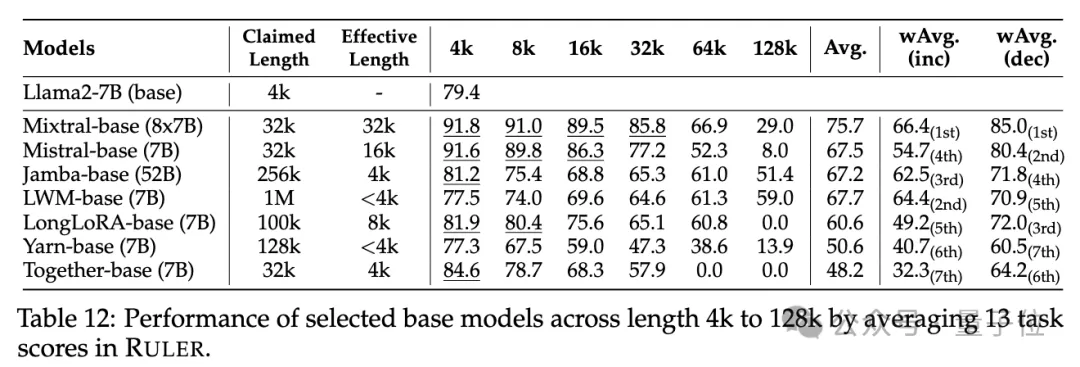

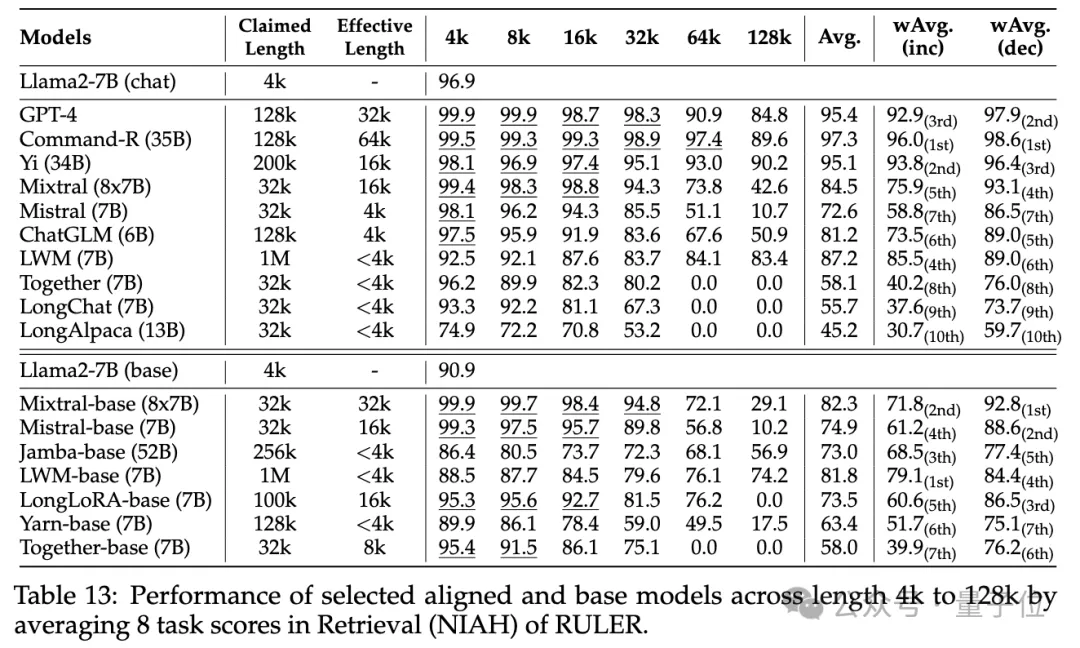

实验阶段,如开头所述,研究人员评测了10个声称支持长上下文的语言模型,包括GPT-4,以及9个开源模型开源模型Command-R、Yi-34B、Mixtral(8x7B)、Mixtral(7B)、ChatGLM、LWM、Together、LongChat、LongAlpaca。

这些模型参数规模范围从6B到采用MoE架构的8x7B不等,最大上下文长度从32K到1M不等。

在RULER基准测试中,对每个模型评测了13个不同的任务,覆盖4个任务类别,难度简单到复杂的都有。对每项任务,生成500个测试样例,输入长度从4K-128K共6个等级(4K、8K、16K、32K、64K、128K)。

为了防止模型拒绝回答问题,输入被附加了answer prefix,并基于recall-based准确性来检查目标输出的存在。

研究人员还定义了“有效上下文长度”指标,即模型在该长度下能保持与基线Llama-7B在4K长度时的同等性能水平。

为了更细致的模型比较,使用了加权平均分数(Weighted Average, wAvg)作为综合指标,对不同长度下的性能进行加权平均。采用了两种加权方案:

- wAvg(inc):权重随长度线性增加,模拟以长序列为主的应用场景

- wAvg(dec):权重随长度线性减小,模拟以短序列为主的场景

来看结果。

普通大海捞针和密码检索测试看不出差距,几乎所有模型在其声称的上下文长度范围内均取得满分。

而使用RULER,尽管很多模型声称能够处理32K token或更长的上下文,但除了Mixtral外,没有模型在其声称的长度上保持超过Llama2-7B基线的性能。

其他结果如下,总的来说,GPT-4在4K长度下表现最佳,并且在上下文扩展到128K时显示出最小的性能下降(15.4%)。

开源模型中排名前三的是Command-R、Yi-34B和Mixtral,它们都使用了较大的基频RoPE,并且比其它模型具有更多的参数。

此外,研究人员还对Yi-34B-200K模型在增加输入长度(高达256K)和更复杂任务上的表现进行了深入分析,以理解任务配置和失败模式对RULER的影响。

他们还分析了训练上下文长度、模型大小和架构对模型性能的影响,发现更大的上下文训练通常会带来更好的性能,但对长序列的排名可能不一致;模型大小的增加对长上下文建模有显著好处;非Transformer架构(如RWKV和Mamba)在RULER上的表现显著落后于基于Transformer的Llama2-7B。

更多细节,感兴趣的家银们可以查看原论文。

论文链接:https://arxiv.org/abs/2404.06654

以上是英偉達新研究:上下文長度虛標嚴重,32K性能合格的都不多的詳細內容。更多資訊請關注PHP中文網其他相關文章!