- masyarakat

- Belajar

- Perpustakaan Alatan

- Masa lapang

Rumah > Soal Jawab > teks badan

现在可以从网上下载这些代码,怎么进行部署和运行代码

从github上下载了关于分布式的代码,不知道怎么用,求各位大神指点下。。。

下面是网址

https://github.com/rolando/scrapy-redis

环境已经按照上面的配置好了,但不知道如何实现分布式。

分布式我是这样理解的,有一个redis服务器,从一个网页上获取url种子,并将url种子放到redis服务器了,然后将这些url种子分配给其他机器。中间存在调度方面的问题,以及服务器和机器间的通信。

谢谢。。。

PHP中文网2017-04-24 09:13:57

Saya rasa perkara ini tidak dapat digambarkan dengan jelas dalam satu atau dua ayat.

Entri blog ini yang saya rujuk sebelum ini, saya harap ia dapat membantu anda.

Izinkan saya bercakap tentang pemahaman peribadi saya.

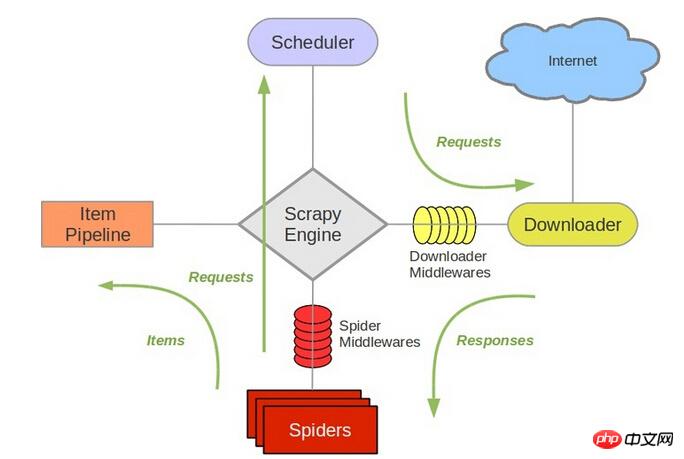

scrapy menggunakan python milik collection.deque yang dipertingkatkan untuk menyimpan request yang hendak dirangkak Bagaimana dua atau lebih Spider berkongsi deque ini?

Baris gilir untuk dirangkak tidak boleh dikongsi dan pengedaran adalah karut. scrapy-redis menyediakan penyelesaian, menggantikan collection.deque dengan pangkalan data redis dan berbilang perangkak menyimpan redis untuk dirangkak daripada pelayan request yang sama, supaya berbilang spider boleh pergi ke yang sama Baca dalam pangkalan data, supaya masalah utama pengedaran diselesaikan.

Nota: tidak menggantikan redis untuk menyimpan request, scrapy boleh diedarkan terus!

ialah penjadual scrapy. 待爬队列

SchedulerRujuk struktur

scrapy Ia bertanggungjawab untuk beratur

Ia bertanggungjawab untuk beratur

seterusnya untuk dirangkak, dsb. Oleh itu, selepas menggantikan redis, komponen lain mesti ditukar. request

requestJadi, pemahaman peribadi saya ialah agak mudah untuk menggunakan perangkak yang sama pada berbilang mesin, penempatan teragih

blog saya. Dan tugasan ini, termasuk penyahduplikasi URL, adalah fungsi rangka kerja redis yang telah ditulis.

scrapy-redisAlamat rujukan ada di sini Anda boleh memuat turun contoh untuk melihat pelaksanaan khusus. Saya juga telah mengusahakannya baru-baru ini

scrapy-redisJika anda mempunyai sebarang kemajuan baharu, anda boleh berkongsi dengan kami.

黄舟2017-04-24 09:13:57

@伟兴 Hello, saya melihat komen ini pada 15.10.11 Adakah anda mempunyai sebarang keputusan sekarang?

Bolehkah anda mengesyorkan beberapa blog anda Terima kasih~

Anda boleh menghubungi saya chenjian158978@gmail.com