Rumah > Artikel > Peranti teknologi > Docker melengkapkan penggunaan tempatan model besar sumber terbuka LLama3 dalam masa tiga minit

Docker melengkapkan penggunaan tempatan model besar sumber terbuka LLama3 dalam masa tiga minit

- 王林ke hadapan

- 2024-04-26 10:19:211380semak imbas

Gambaran Keseluruhan

LLaMA-3 (Model Bahasa Besar Meta AI 3) ialah model kecerdasan buatan generatif sumber terbuka berskala besar yang dibangunkan oleh Syarikat Meta. Ia tidak mempunyai perubahan besar dalam struktur model berbanding LLaMA-2 generasi sebelumnya.

Model LLaMA-3 dibahagikan kepada versi skala yang berbeza, termasuk kecil, sederhana dan besar, untuk menyesuaikan diri dengan keperluan aplikasi dan sumber pengkomputeran yang berbeza. Saiz parameter model kecil ialah 8B, saiz parameter model sederhana ialah 70B, dan saiz parameter model besar mencapai 400B. Walau bagaimanapun, semasa latihan, matlamatnya adalah untuk mencapai kefungsian berbilang modal dan berbilang bahasa, dan hasilnya dijangka setanding dengan GPT 4/GPT 4V.

Pasang Ollama

Ollama ialah alat perkhidmatan model bahasa besar (LLM) sumber terbuka yang membolehkan pengguna menjalankan dan menggunakan model bahasa besar pada mesin tempatan mereka. Ollama direka bentuk sebagai rangka kerja yang memudahkan proses mengatur dan mengurus model bahasa besar dalam bekas Docker, menjadikan proses itu cepat dan mudah. Pengguna boleh menjalankan model bahasa berskala besar sumber terbuka dengan cepat seperti Llama 3 secara tempatan melalui operasi baris arahan yang mudah.

Alamat tapak web rasmi: https://ollama.com/download

Pictures

Pictures

Ollama ialah alat yang menyokong berbilang platform, termasuk Mac dan Linux, dan menyediakan imej Docker untuk memudahkan proses pemasangan. Pengguna boleh mengimport dan menyesuaikan lebih banyak model dengan menulis Modelfile, yang serupa dengan peranan Dockerfile. Ollama juga menampilkan API REST untuk menjalankan dan mengurus model, dan set alat baris perintah untuk interaksi model.

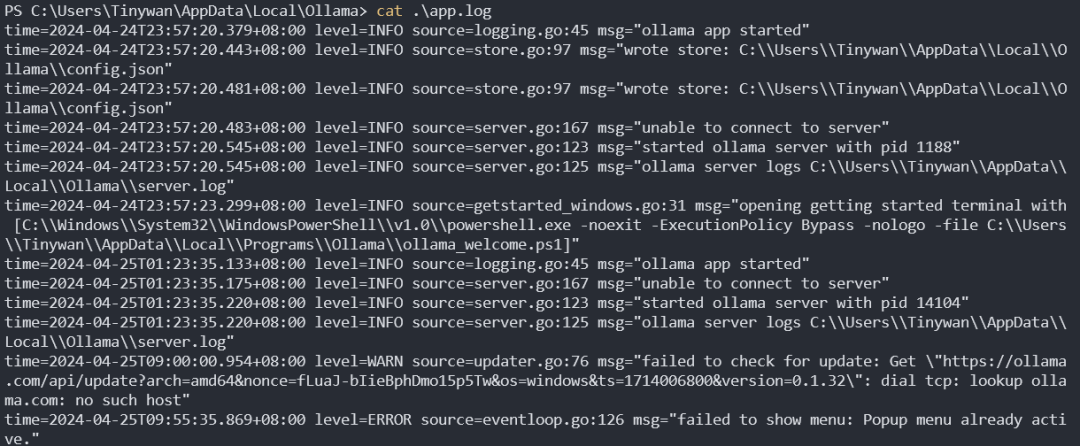

Log permulaan perkhidmatan Ollama

Gambar

Gambar

Pengurusan model

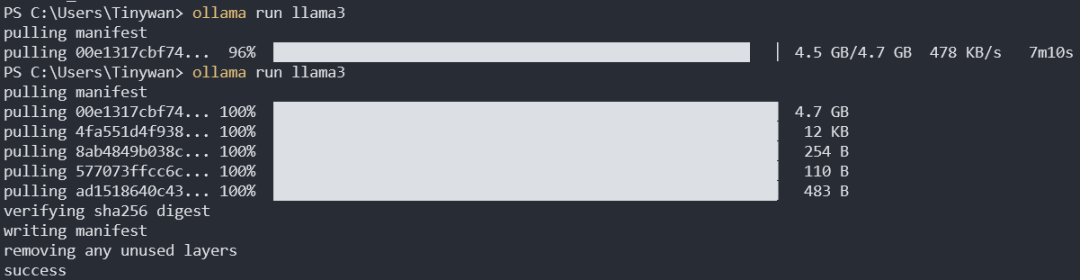

Muat turun model

ollama pull llama3:8b

Muat turun lalai ialah llama3:8b. Titik bertindih sebelum titik bertindih di sini mewakili nama model, dan bertindih bertindih selepas tag mewakili tag Anda boleh melihat semua tag llama3 dari sini

gambar

gambar

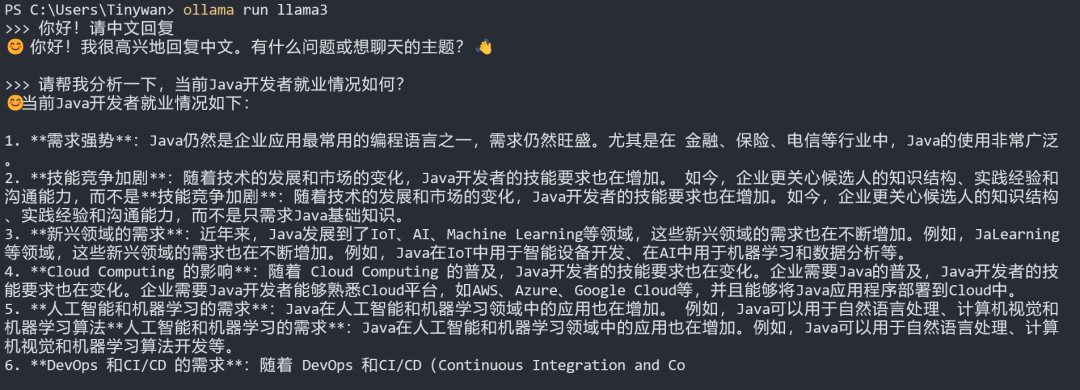

pengujian model

Nota: Jika anda mahu model itu. balas dalam bahasa Cina, sila masukkan dahulu: Hello! Sila balas dalam bahasa Cina

gambar

gambar

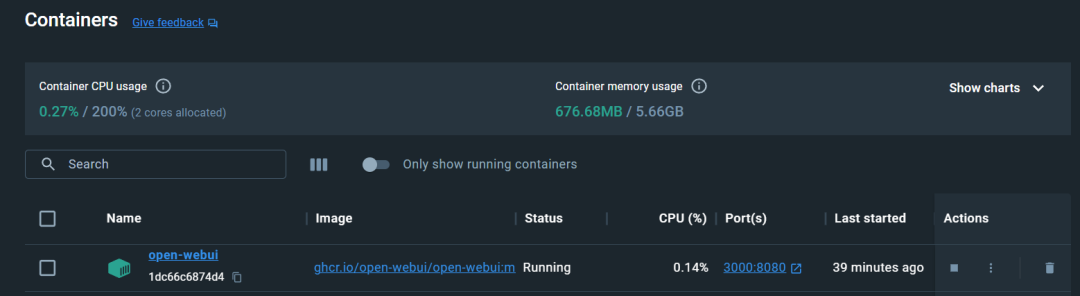

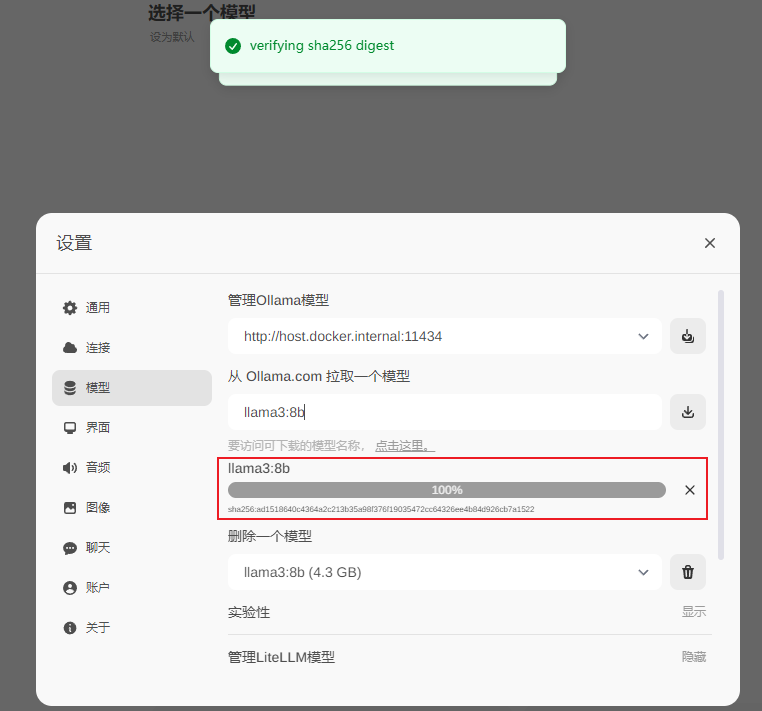

Konfigurasikan Open-WebUI

Jalankan di bawah CPU

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

gambar

gambar

gambar

Gambar

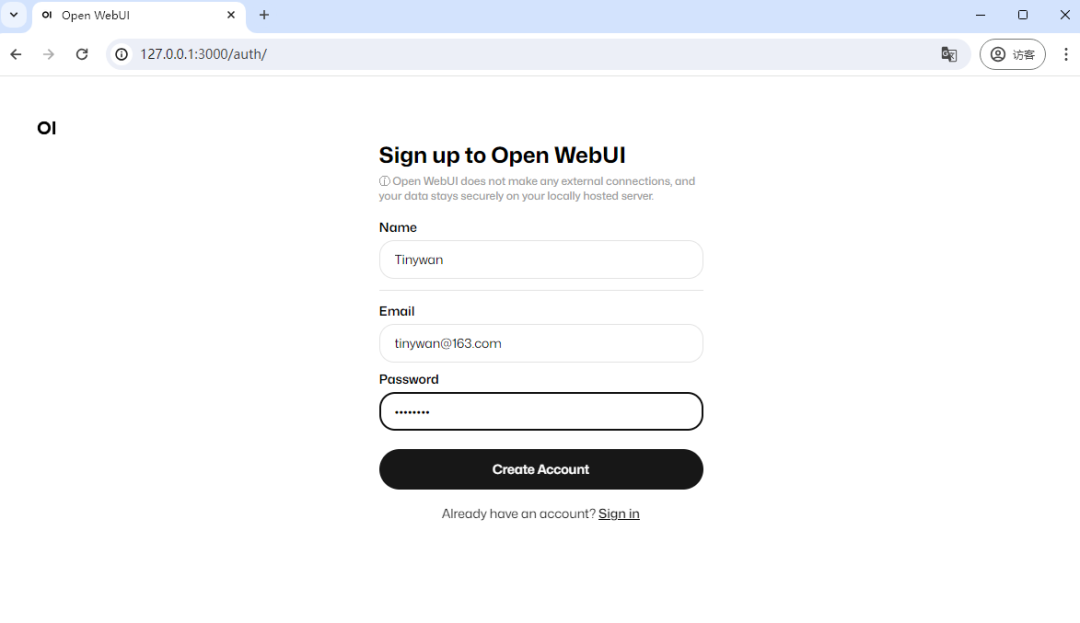

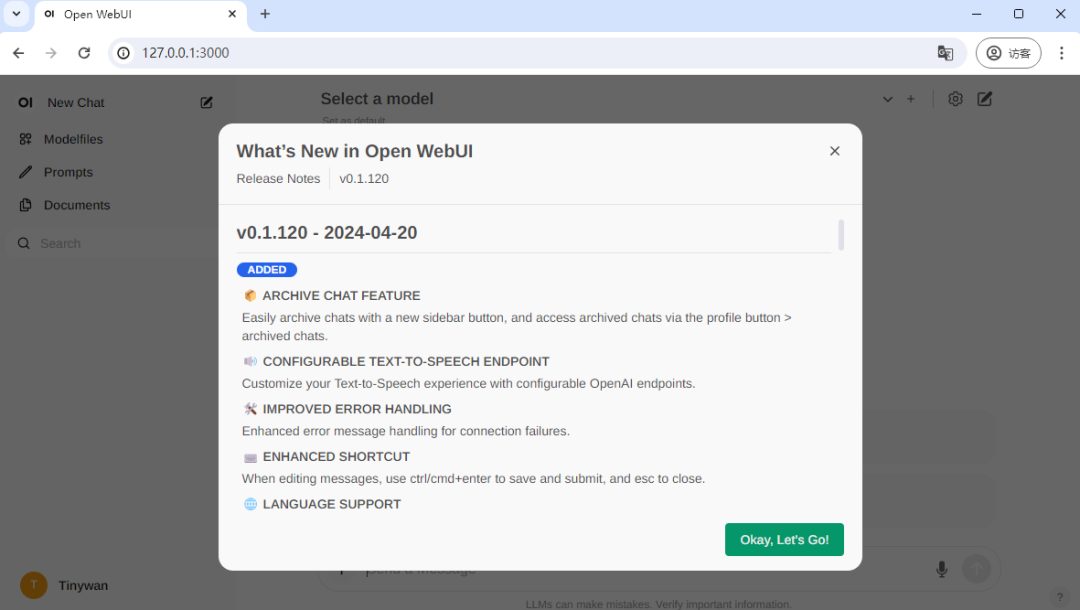

Anda perlu daftar untuk lawatan pertama, di sini saya daftar akaun, pendaftaran selesai dan login berjaya

Anda perlu daftar untuk lawatan pertama, di sini saya daftar akaun, pendaftaran selesai dan login berjaya

Gambar

Gambar

llama3:8b🎜

gambar

gambar

Muat turun selesai

gambar

gambar

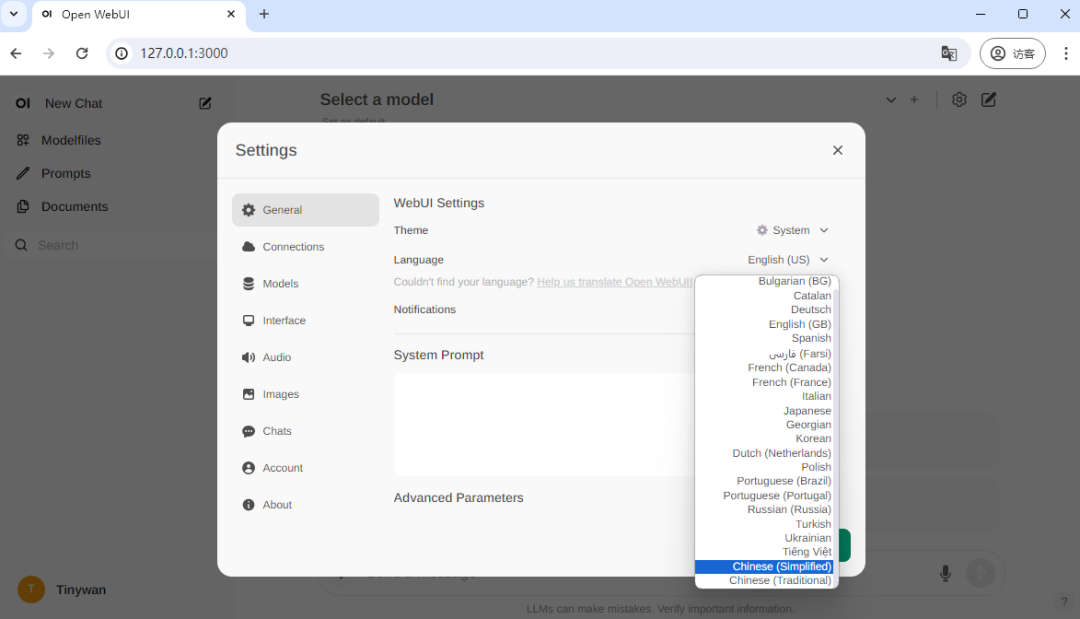

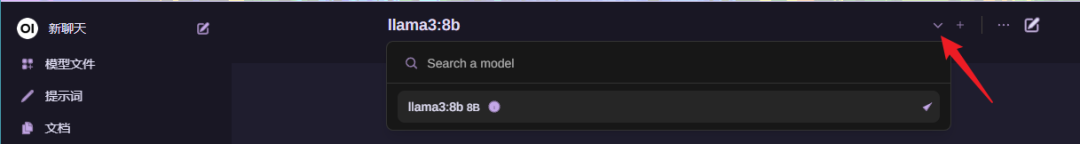

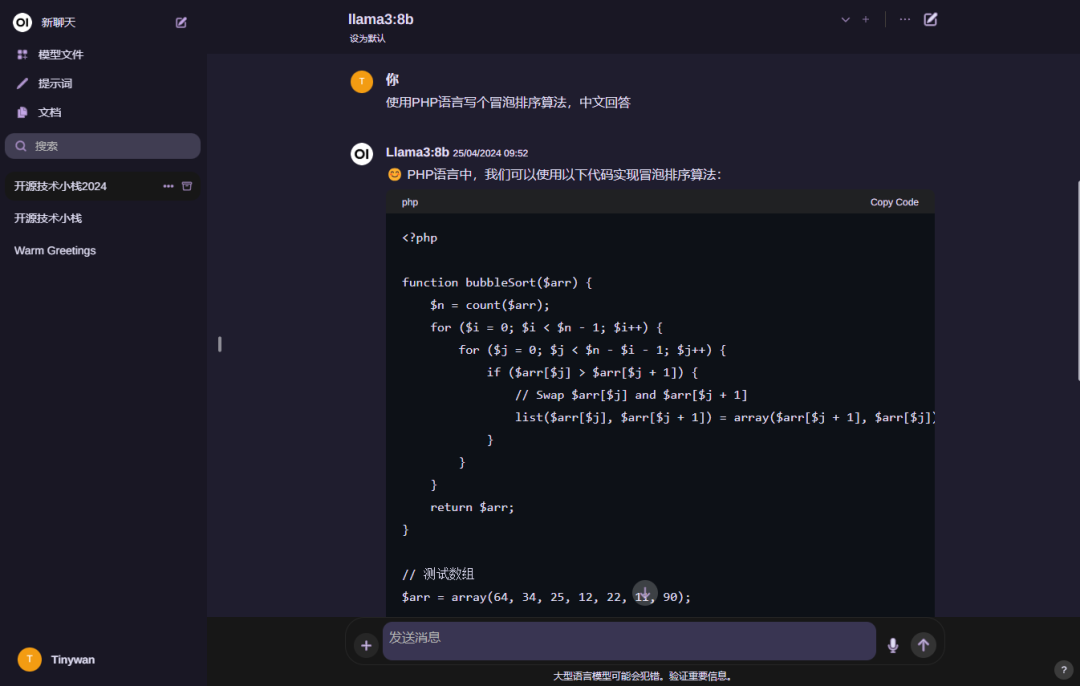

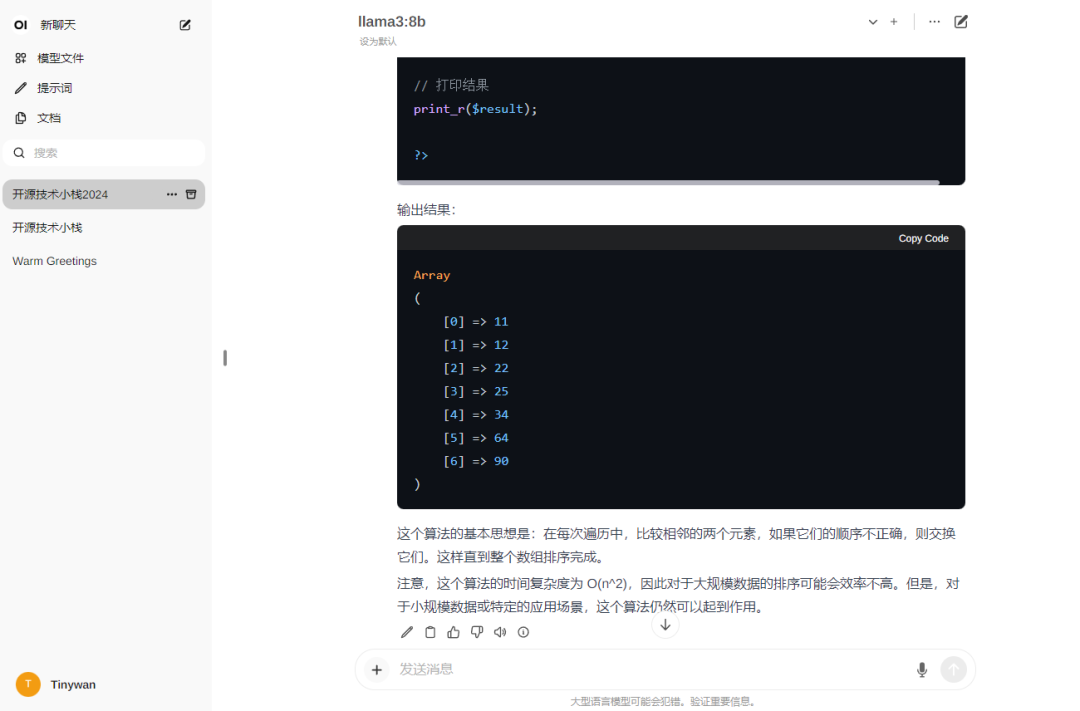

Gunakan

Pilih model

gambar anda

gambar anda

gambar

gambar

Nota: Jika anda mahu model membalas dalam bahasa Cina, Sila masukkan dahulu: Hello! Sila balas dalam bahasa cina

Atas ialah kandungan terperinci Docker melengkapkan penggunaan tempatan model besar sumber terbuka LLama3 dalam masa tiga minit. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!