Lajur AIxiv ialah lajur di mana tapak ini menerbitkan kandungan akademik dan teknikal. Dalam beberapa tahun kebelakangan ini, lajur AIxiv laman web ini telah menerima lebih daripada 2,000 laporan, meliputi makmal terkemuka dari universiti dan syarikat utama di seluruh dunia, mempromosikan pertukaran dan penyebaran akademik secara berkesan. Jika anda mempunyai kerja yang sangat baik yang ingin anda kongsikan, sila berasa bebas untuk menyumbang atau hubungi kami untuk melaporkan. E-mel penyerahan: liyazhou@jiqizhixin.com; zhaoyunfeng@jiqizhixin.com.

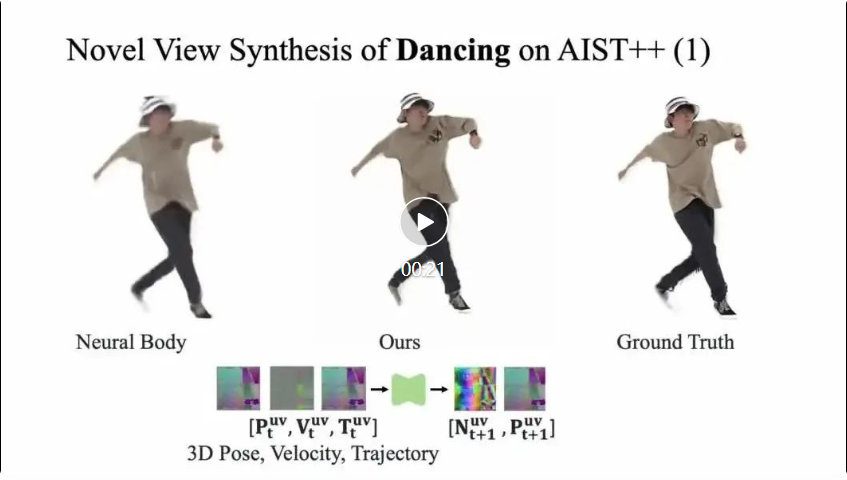

Dalam aktiviti harian, pergerakan orang sering menyebabkan gerakan sekunder pakaian dan dengan itu menghasilkan lipatan pakaian yang berbeza, yang memerlukan pemahaman tentang geometri dan pergerakan badan dan pakaian manusia (postur manusia dan dinamik Velocity, dsb. .) dan penampilan dimodelkan secara dinamik secara serentak. Memandangkan proses ini melibatkan interaksi fizikal tidak tegar yang kompleks antara orang dan pakaian, representasi tiga dimensi tradisional selalunya sukar dikendalikan. Pembelajaran rendering manusia digital dinamik daripada jujukan video telah mencapai kemajuan yang besar dalam beberapa tahun kebelakangan ini, kaedah sedia ada sering menganggap rendering sebagai pemetaan saraf daripada postur manusia kepada imej, menggunakan paradigma "pengekod gerakan-ciri-penampilan" Penyahkod. Paradigma ini adalah berdasarkan kehilangan imej untuk penyeliaan Ia terlalu menumpukan pada pembinaan semula setiap bingkai imej dan tidak mempunyai pemodelan kesinambungan gerakan Oleh itu, adalah sukar untuk memodelkan gerakan kompleks secara berkesan seperti "gerakan badan manusia dan gerakan berkaitan pakaian ". Untuk menyelesaikan masalah ini, pasukan S-Lab dari Universiti Teknologi Nanyang di Singapura mencadangkan paradigma baharu pembinaan semula badan manusia yang dinamik dengan pembelajaran bersama rupa gerakan, dan mencadangkan perwakilan gerakan tiga satah berdasarkan permukaan badan manusia (triplane berasaskan permukaan), yang menyatukan pemodelan fizik gerakan dan pemodelan penampilan dalam satu rangka kerja, membuka idea baharu untuk meningkatkan kualiti pemaparan badan manusia yang dinamik. Paradigma baharu ini secara berkesan memodelkan gerakan yang melekat pada pakaian dan boleh digunakan untuk mempelajari pembinaan semula badan manusia yang dinamik daripada video yang bergerak pantas (seperti menari) dan menghasilkan bayang-bayang yang berkaitan dengan gerakan. Kecekapan pemaparan adalah 9 kali lebih pantas daripada kaedah pemaparan voxel 3D, dan kualiti imej LPIPS dipertingkatkan sebanyak kira-kira 19 mata peratusan.

- Tajuk kertas: SurMo: Surface-based 4D Motion Modelling for Dynamic Human Rendering

-

Alamat kertas: https://arxiv.org/pdf/2404.01225.pdf ://taohuumd.github.io/projects/SurMo

-

Pautan Github: https://github.com/TaoHuUMD/SurMo

Mensasarkan kelemahan paradigma sedia ada "Motion Encoder-Motion Features-Appearance Decoder" yang hanya menumpukan pada pembinaan semula penampilan dan mengabaikan pemodelan kesinambungan gerakan, paradigma baharu SurMo dicadangkan: "①Motion Encoder-Motion Features-②Motion Decoder, ③ penyahkod". Seperti yang ditunjukkan dalam rajah di atas, paradigma dibahagikan kepada tiga peringkat:

- Berbeza daripada kaedah sedia ada yang memodelkan gerakan dalam ruang tiga dimensi yang jarang, SurMo mencadangkan berdasarkan medan manifold permukaan manusia (atau padat ruang UV Bertekstur dua dimensi) pemodelan gerakan empat dimensi (XYZ-T), dan mewakili gerakan melalui tiga satah (tiga satah berasaskan permukaan) yang ditakrifkan pada permukaan badan manusia.

- Cadangkan penyahkod fizik gerakan untuk meramalkan keadaan gerakan bingkai seterusnya berdasarkan ciri gerakan semasa (seperti postur tiga dimensi, kelajuan, trajektori gerakan, dsb.), seperti pesongan spatial pergerakan—permukaan vektor normal dan pesongan temporal—halaju, ke Ini memodelkan kesinambungan ciri gerakan.

- Penyahkodan rupa empat dimensi, penyahkodan temporal bagi ciri gerakan untuk menghasilkan video sudut pandangan bebas tiga dimensi, terutamanya dilaksanakan melalui pemaparan saraf tekstur voxel hibrid (Rendering Tekstur Volumetrik Hibrid, HVTR [Hu et al. 2022]) .

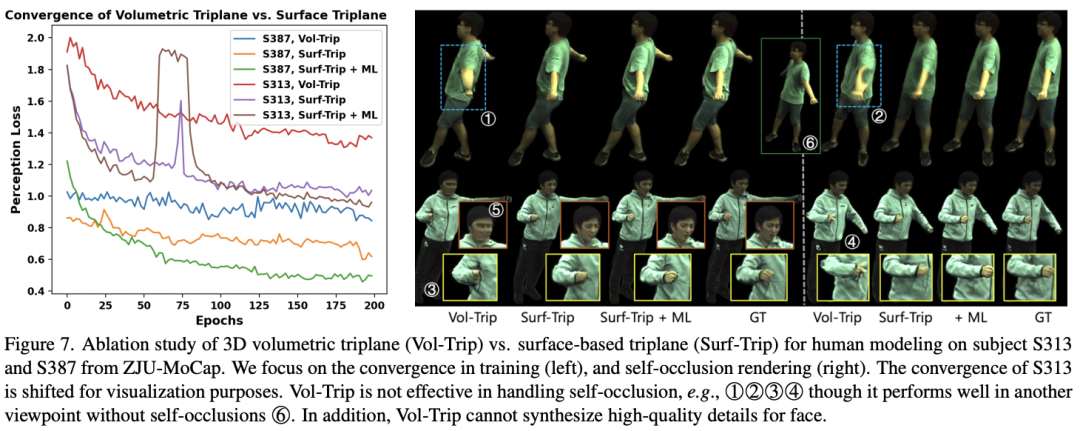

SurMo boleh mempelajari pemaparan manusia yang dinamik daripada video berdasarkan kehilangan pembinaan semula dan kehilangan musuh latihan hujung ke hujung. Kajian ini menjalankan penilaian eksperimen ke atas 3 set data dengan jumlah 9 jujukan video manusia dinamik: ZJU-MoCap [Peng et al.], AISTt al . 2021] MPII-RRDC [Habermann et al. 2021]. kesan jujukan masa (penampilan berubah-ubah masa), terutamanya 2 jujukan, dikaji, seperti yang ditunjukkan dalam rajah di bawah. Setiap jujukan mengandungi gerak isyarat yang serupa tetapi muncul dalam trajektori gerakan yang berbeza, seperti ①②, ③④, ⑤⑥. SurMo boleh memodelkan trajektori gerakan dan oleh itu menjana kesan dinamik yang berubah mengikut masa, manakala kaedah berkaitan menjana hasil yang hanya bergantung pada postur, dengan lipatan pakaian hampir sama di bawah trajektori yang berbeza. . Jujukan itu dirakam pada pentas bunyi dalaman, dan keadaan pencahayaan menghasilkan bayang-bayang berkaitan gerakan pada penghibur disebabkan isu oklusi diri. SurMo boleh memulihkan bayang-bayang ini, seperti ①②, ③④, ⑦⑧ di bawah pemaparan sudut pandang baharu. Kaedah kontras HumanNeRF [Weng et al.] tidak dapat memulihkan bayang-bayang berkaitan gerakan. Selain itu, SurMo boleh membina semula gerakan aksesori pakaian yang berubah mengikut trajektori gerakan, seperti lipatan berbeza dalam pergerakan melompat ⑤⑥, manakala HumanNeRF tidak dapat membina semula kesan dinamik ini. . . , serta pemodelan gerakan medan manifold permukaan manusia (manifold permukaan) yang dicadangkan oleh SurMo, khususnya membandingkan triplane Volumetrik dan triplane berasaskan Surface, seperti yang ditunjukkan dalam rajah di bawah. Boleh didapati bahawa triplane Volumetrik ialah ungkapan yang jarang, dengan hanya kira-kira 21-35% ciri yang digunakan untuk pemaparan, manakala penggunaan ciri triplane berasaskan Surface boleh mencapai 85%, jadi ia mempunyai lebih banyak kelebihan dalam mengendalikan oklusi diri, seperti seperti (d) yang ditunjukkan. Pada masa yang sama, triplane berasaskan Surface boleh mencapai pemaparan lebih pantas dengan menapis titik jauh dari permukaan dalam pemaparan voxel, seperti ditunjukkan dalam Rajah (c).

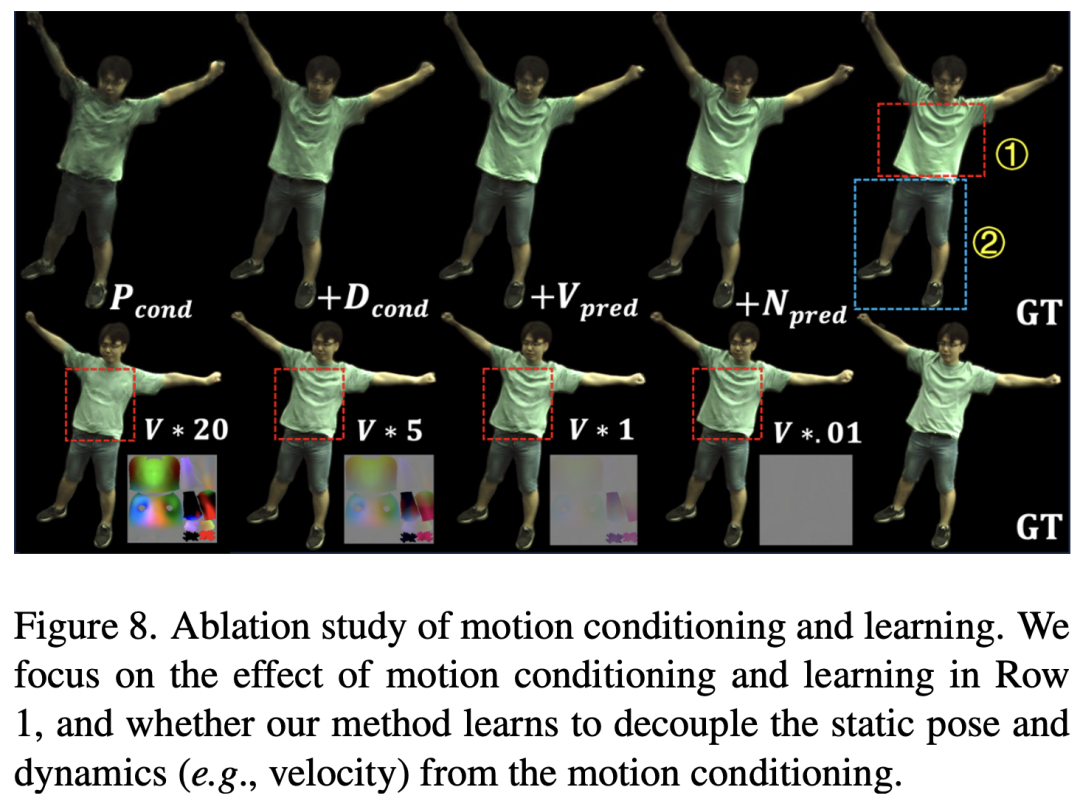

Pada masa yang sama, kajian ini menunjukkan bahawa triplane berasaskan Surface boleh menumpu lebih cepat daripada triplane Volumetric semasa proses latihan, dan mempunyai kelebihan yang jelas dalam butiran lipatan pakaian dan oklusi diri, seperti yang ditunjukkan dalam rajah di atas. SurMo mengkaji kesan pemodelan gerakan melalui eksperimen ablasi, seperti yang ditunjukkan dalam rajah di bawah. Keputusan menunjukkan bahawa SurMo boleh memisahkan ciri statik gerakan (seperti postur tetap pada bingkai tertentu) dan ciri dinamik (seperti kelajuan). Sebagai contoh, apabila kelajuan ditukar, lipatan pakaian rapat kekal tidak berubah, seperti ①, manakala lipatan pakaian longgar sangat dipengaruhi oleh kelajuan, seperti ②, yang konsisten dengan pemerhatian harian.

Atas ialah kandungan terperinci CVPR 2024 |. AI juga boleh memulihkan skirt terbang ketika menari mencadangkan paradigma baharu untuk rendering badan manusia yang dinamik. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!