Rumah >Peranti teknologi >AI >Dokumen berbilang modal Alibaba 7B memahami model besar memenangi SOTA baharu

Dokumen berbilang modal Alibaba 7B memahami model besar memenangi SOTA baharu

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBke hadapan

- 2024-04-02 11:31:271012semak imbas

Pemahaman dokumen pelbagai modKeupayaan SOTA baharu!

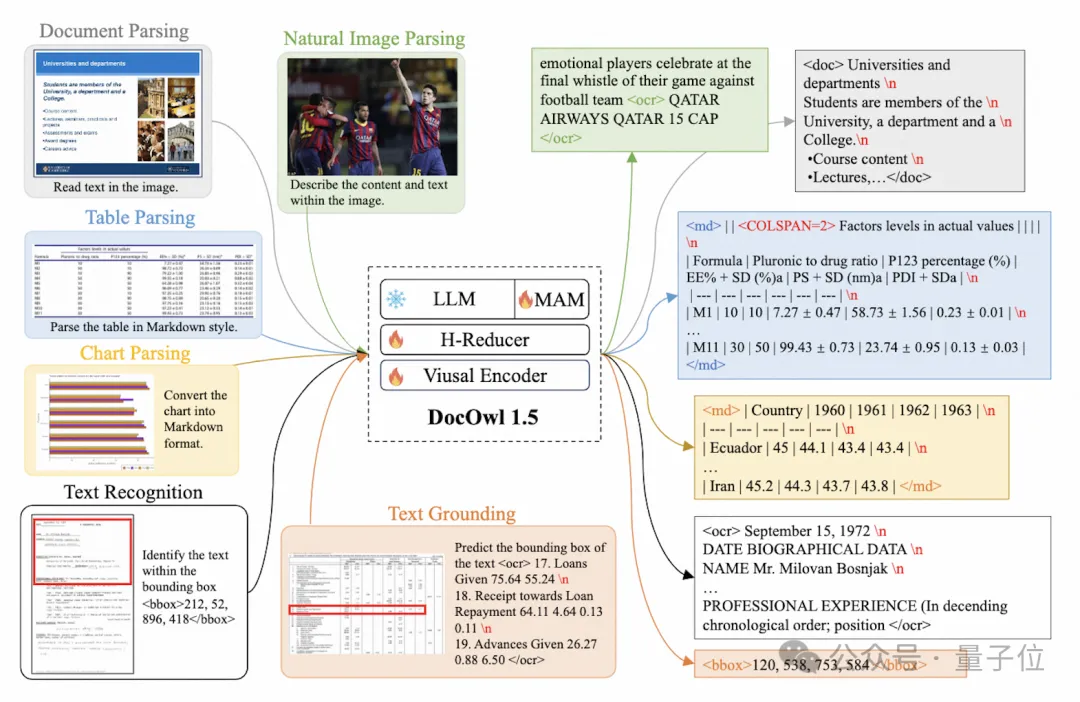

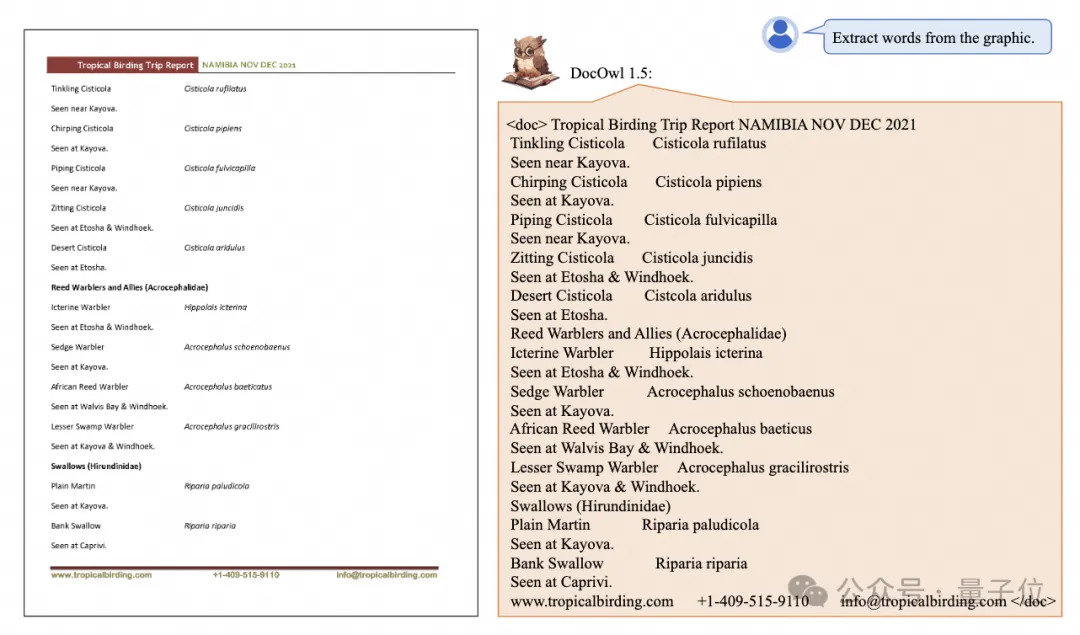

Pasukan Alibaba mPLUG mengeluarkan kerja sumber terbuka terkini mPLUG-DocOwl 1.5, yang mencadangkan satu siri penyelesaian untuk empat cabaran utama pengecaman teks imej resolusi tinggi, pemahaman struktur dokumen sejagat, mengikut arahan dan pengenalan pengetahuan luaran .

Tanpa berlengah lagi, mari kita lihat kesannya dahulu.

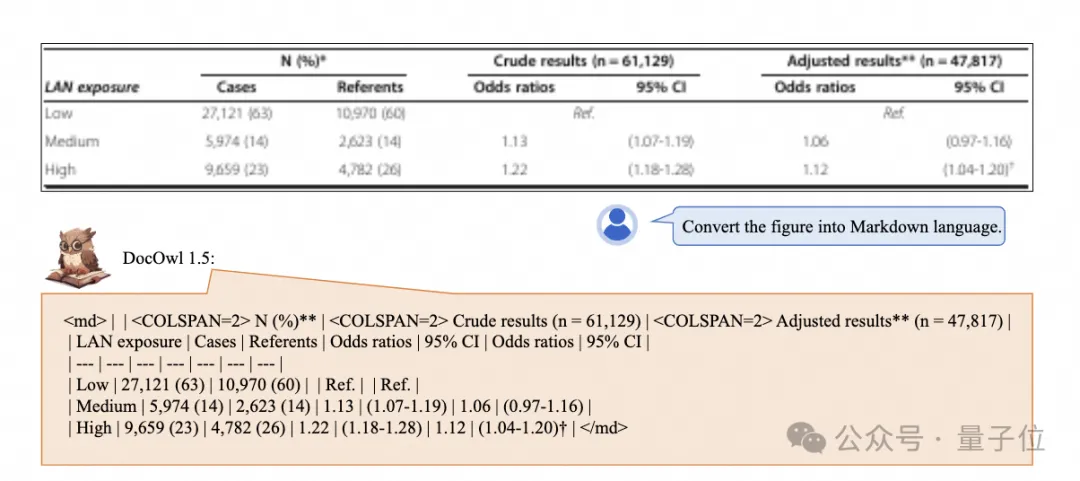

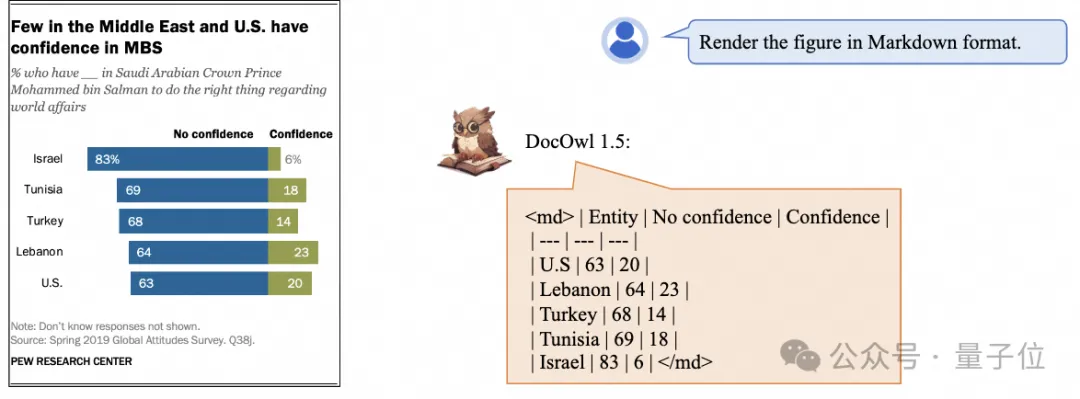

Pengiktirafan satu klik dan penukaran carta dengan struktur kompleks ke dalam format Markdown:

Carta gaya berbeza tersedia:

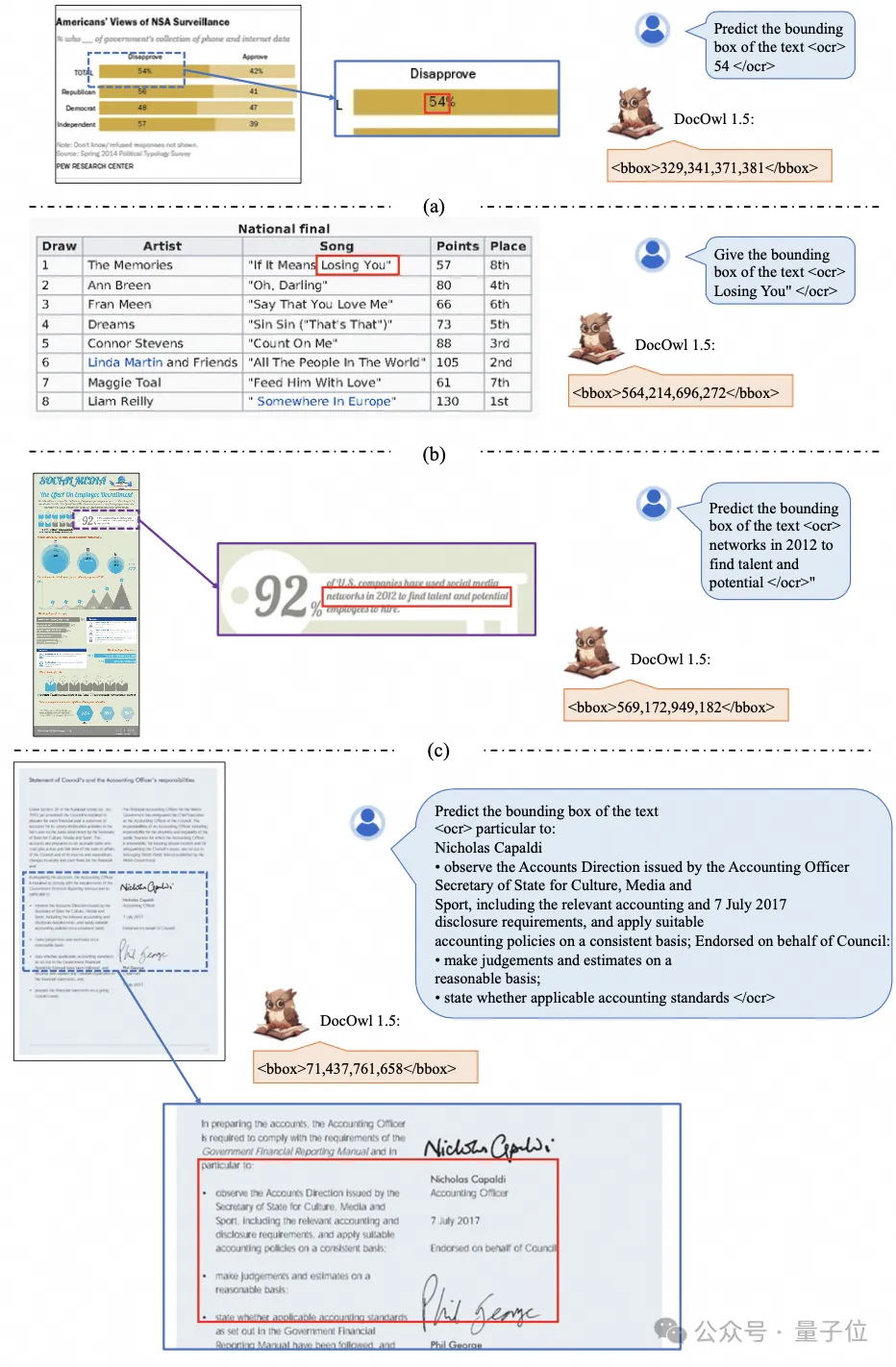

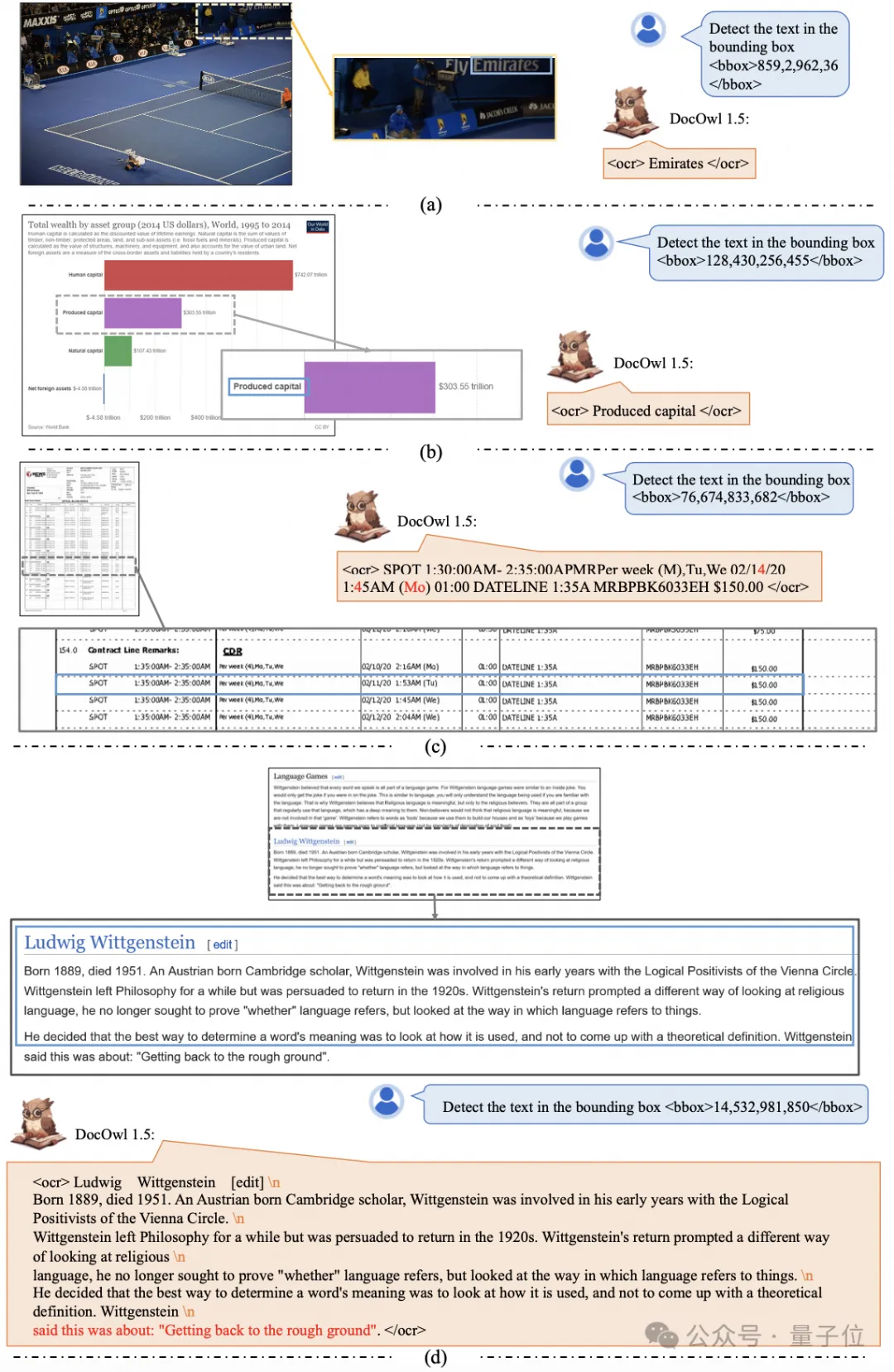

Pengecaman dan kedudukan teks yang lebih terperinci juga boleh dikendalikan:🜎

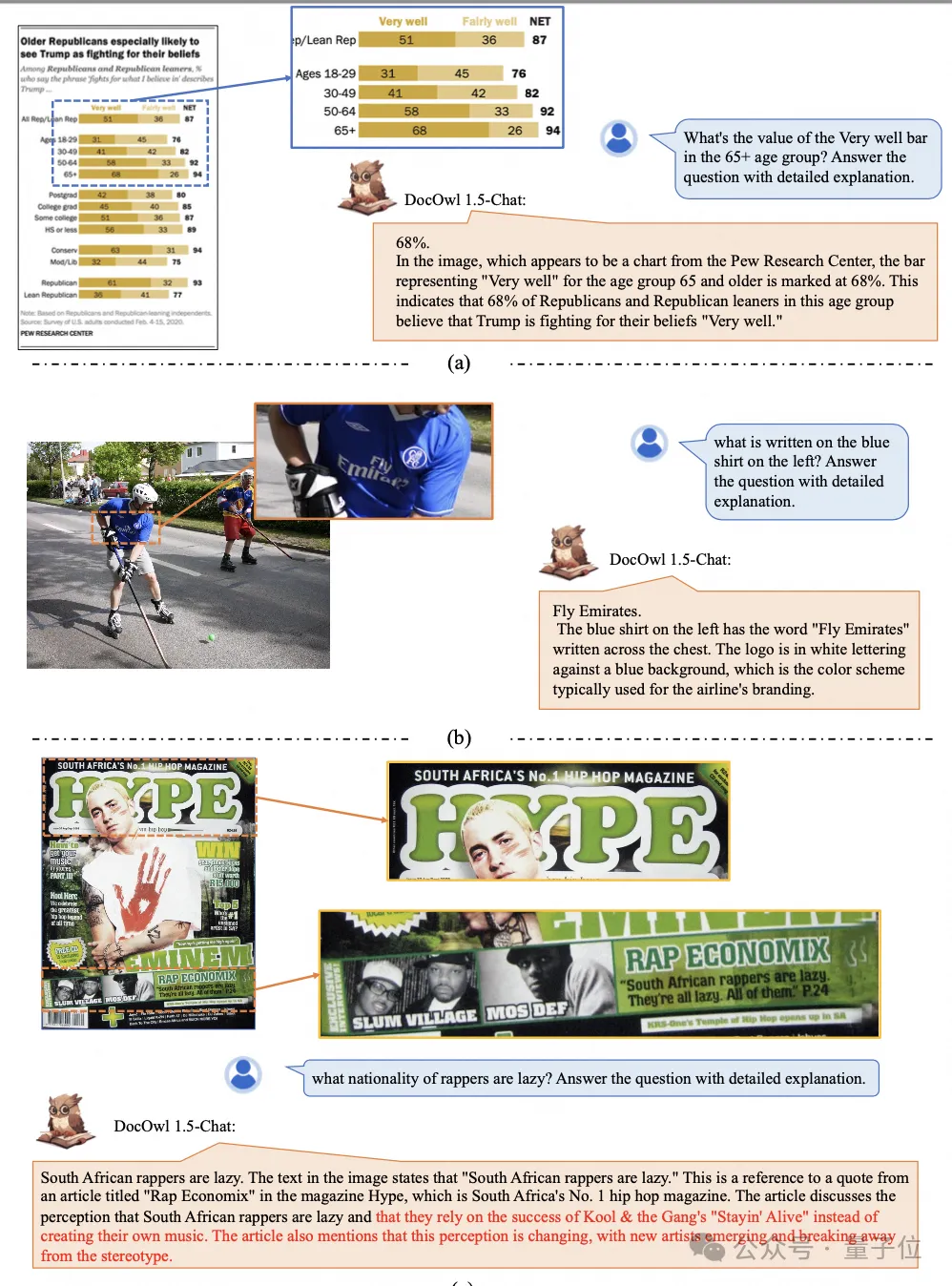

juga boleh dikendalikan dengan mudahBeri juga penjelasan terperinci tentang pemahaman dokumen:

Anda mesti tahu bahawa "pemahaman dokumen" pada masa ini merupakan senario penting untuk pelaksanaan model bahasa besar Terdapat banyak produk di pasaran untuk membantu pembacaan dokumen, dan beberapa terutamanya menggunakan sistem OCR untuk membaca teks Pengecaman dan pemahaman teks dengan LLM boleh mencapai keupayaan pemahaman dokumen yang baik.

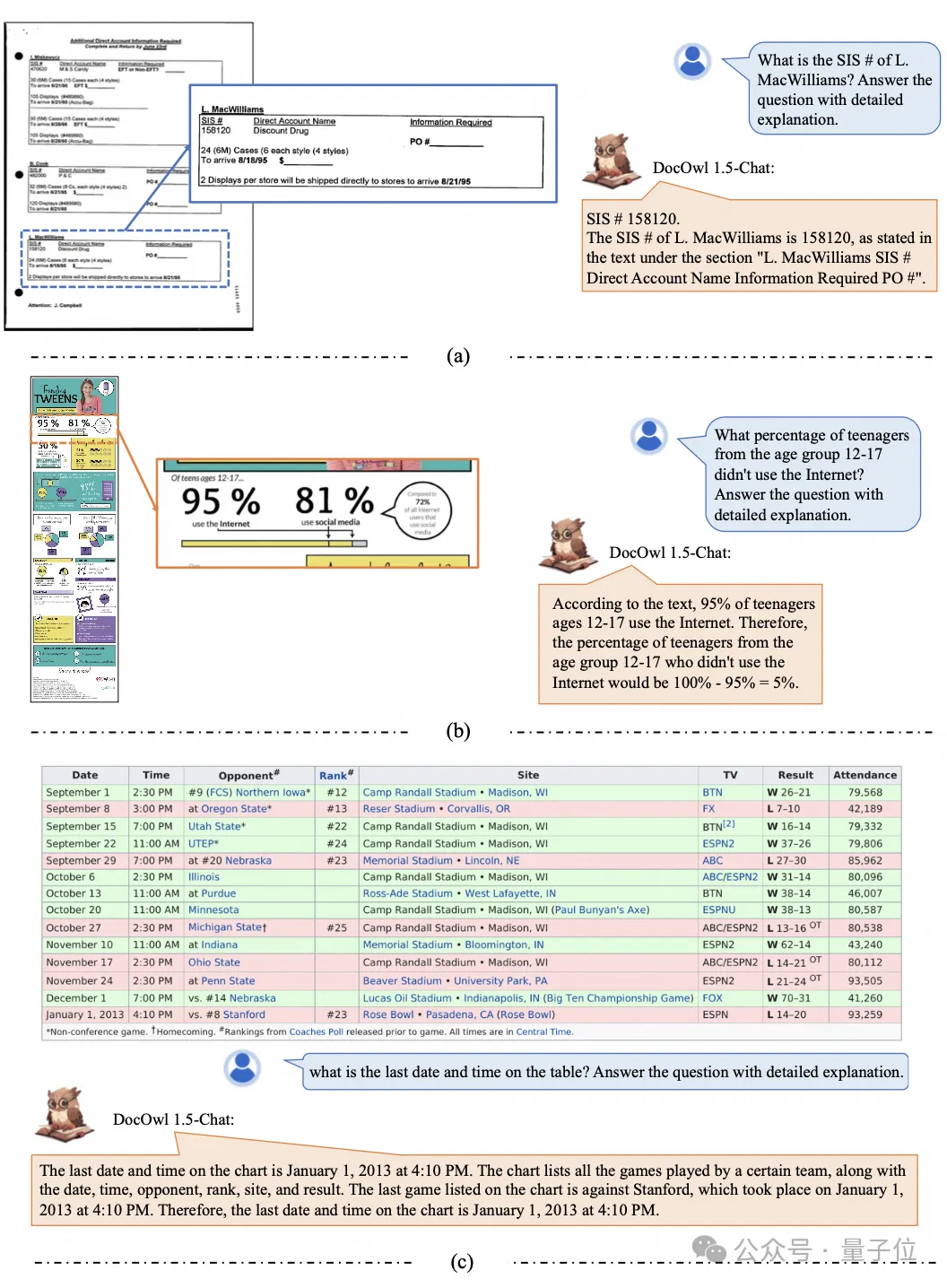

Selain keupayaan untuk memberikan jawapan mudah pada penanda aras, melalui sejumlah kecil "penjelasan terperinci"  (penaakulan)

(penaakulan)

Pasukan Alibaba mPLUG telah melabur dalam penyelidikan pemahaman dokumen berbilang modal sejak Julai 2023, dan telah mengeluarkan secara berturut-turut mPLUG-DocOwl, UReader, mPLUG-PaperOwl, mPLUG-DocOwl 1.5 dan sumber terbuka siri model pemahaman dokumen besar dan data latihan.

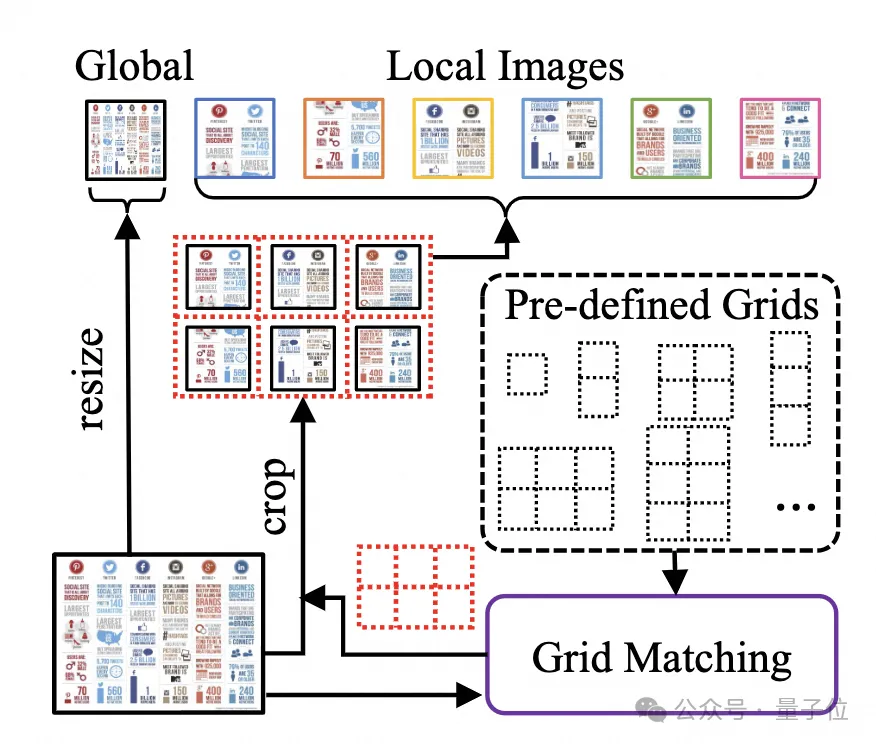

Artikel ini bermula daripada karya terkini mPLUG-DocOwl 1.5, menganalisis cabaran utama dan penyelesaian berkesan dalam bidang "pemahaman dokumen pelbagai mod". Cabaran 1: Pengecaman teks imej resolusi tinggiBerbeza daripada imej biasa, imej dokumen dicirikan oleh pelbagai bentuk dan saiz, yang boleh termasuk imej dokumen bersaiz A4, imej jadual pendek dan lebar serta halaman web mudah alih yang panjang dan sempit Tangkapan skrin, imej adegan rawak, dsb. diedarkan dalam pelbagai resolusi. Apabila model besar berbilang modal arus perdana mengekod imej, ia selalunya menskalakan secara langsung saiz imej Contohnya, skala mPLUG-Owl2 dan QwenVL kepada 448x448, dan skala LLaVA 1.5 kepada 336x336. Hanya menskalakan imej dokumen akan menyebabkan teks dalam imej menjadi kabur dan cacat, menjadikannya tidak dapat dikenali. Untuk memproses imej dokumen, mPLUG-DocOwl 1.5 meneruskan pendekatancutting

pendahulunya URReader Struktur model ditunjukkan dalam Rajah 1:

△struktur UReader

. Ia pertama kali dicadangkan untuk mendapatkan satu siri sub-imej melalui Modul Pemotongan penyesuaian bentuk bebas parameter

berdasarkan model besar berbilang mod sedia ada Setiap sub-imej dikodkan oleh pengekod resolusi rendah untuk mengarahkan semantik melalui model bahasa.Strategi pemotongan graf ini boleh menggunakan maksimum keupayaan pengekod visual tujuan umum sedia ada (seperti CLIP ViT-14/L)

untuk pemahaman dokumen,sangat mengurangkan kos latihan semula pengekod visual resolusi tinggi . Modul pemotongan yang disesuaikan dengan bentuk ditunjukkan dalam Rajah 2:

△Rajah 2: Modul pemotongan penyesuaian bentuk.

Cabaran 2: Pemahaman struktur dokumen umum

Untuk pemahaman dokumen yang tidak bergantung pada sistem OCR, mengenali teks ialah keupayaan asas untuk mencapai pemahaman semantik dan pemahaman struktur kandungan dokumen memerlukan pemahaman tajuk jadual dan Surat-menyurat antara baris dan lajur Memahami carta memerlukan pemahaman struktur yang pelbagai seperti graf garis, graf bar dan carta pai Memahami kontrak memerlukan pemahaman pasangan nilai kunci yang pelbagai seperti tandatangan tarikh.

mPLUG-DocOwl 1.5 memfokuskan pada menyelesaikan keupayaan pemahaman struktur seperti dokumen umum Melalui pengoptimuman struktur model dan peningkatan tugas latihan, ia telah mencapai keupayaan pemahaman dokumen umum yang lebih kukuh.

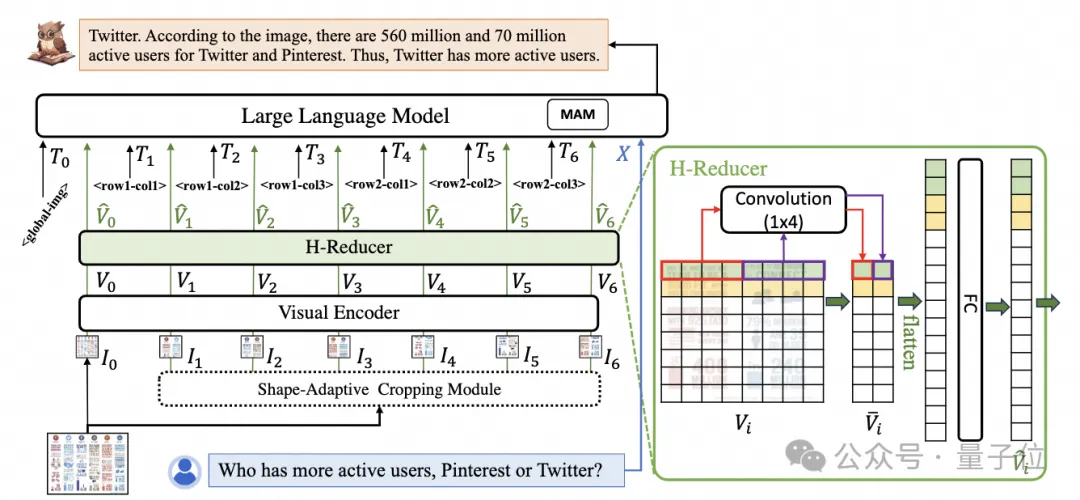

Dari segi struktur, seperti yang ditunjukkan dalam Rajah 1, mPLUG-DocOwl 1.5 meninggalkan modul sambungan bahasa visual Abstractor dalam mPLUG-Owl/mPLUG-Owl2, menggunakan H-Reducer berdasarkan "konvolusi + lapisan bersambung sepenuhnya" untuk ciri pengagregatan Dan penjajaran ciri .

Berbanding dengan Abstractor berdasarkan pertanyaan yang boleh dipelajari, H-Reducer mengekalkan hubungan kedudukan relatif antara ciri visual dan memindahkan maklumat struktur dokumen yang lebih baik kepada model bahasa.

Berbanding dengan MLP yang mengekalkan panjang jujukan visual, H-Reducer sangat mengurangkan bilangan ciri visual melalui konvolusi, membolehkan LLM memahami imej dokumen resolusi tinggi dengan lebih cekap.

Memandangkan teks dalam kebanyakan imej dokumen disusun secara mendatar dahulu, dan semantik teks dalam arah mendatar adalah koheren, H-Reducer menggunakan bentuk lilitan 1x4 dan saiz langkah. Dalam kertas itu, penulis membuktikan melalui eksperimen perbandingan yang mencukupi keunggulan H-Reducer dalam pemahaman struktur dan bahawa 1x4 adalah bentuk agregat yang lebih umum.

Dari segi tugas latihan, mPLUG-DocOwl 1.5 mereka bentuk pembelajaran struktur bersatu (Pembelajaran Struktur Bersepadu) tugasan untuk semua jenis gambar, seperti yang ditunjukkan dalam Rajah 3.

△Rajah 3: Pembelajaran Struktur Bersatu

Pembelajaran Struktur Bersatu bukan sahaja merangkumi analisis teks imej global, tetapi juga pengecaman dan kedudukan teks berbutir-butir.

Dalam tugas menghurai teks imej global, untuk imej dokumen dan imej halaman web, ruang dan pemisah baris boleh digunakan untuk paling biasa mewakili struktur teks untuk jadual, pengarang memperkenalkan aksara khas untuk mewakili berbilang baris dan lajur berdasarkan; Sintaks penurunan nilai penerangan dan teks adegan adalah sama penting, jadi bentuk penerangan gambar yang disambung dengan teks adegan digunakan sebagai sasaran penghuraian.

Dalam tugasan "Pengecaman dan Kedudukan Teks", untuk lebih sesuai dengan pemahaman imej dokumen, pengarang mereka bentuk pengecaman dan kedudukan teks pada empat butiran perkataan, frasa, baris dan blok Kotak sempadan diwakili oleh a nombor integer diskret, dan julat 0-999.

Untuk menyokong pembelajaran struktur bersatu, penulis membina set latihan komprehensif DocStruct4M, meliputi pelbagai jenis imej seperti dokumen/halaman web, jadual, carta, imej semula jadi, dsb.

Selepas pembelajaran struktur bersatu, DocOwl 1.5 mempunyai keupayaan analisis berstruktur dan kedudukan teks imej dokumen dalam pelbagai medan.

△ Rajah 4: Parsing teks berstruktur

As ditunjukkan dalam Rajah 4 dan Rajah 5:

△ Rajah 5: Pengiktirafan teks dan kedudukan multi-granulariti

Challenge 3: Arahan berikut

"Mengikuti Arahan"(Mengikuti Arahan) memerlukan model berdasarkan keupayaan pemahaman dokumen asas dan melaksanakan tugas yang berbeza mengikut arahan pengguna, seperti pengekstrakan maklumat, soal jawab, penerangan gambar, dsb.

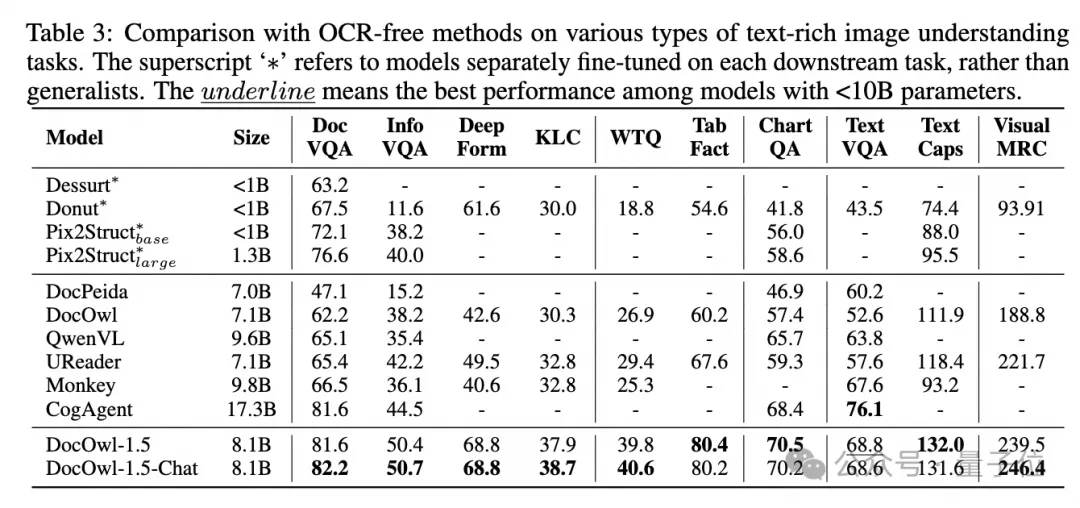

Meneruskan amalan mPLUG-DocOwl, DocOwl 1.5 menyatukan pelbagai tugas hiliran ke dalam bentuk soal jawab arahan Selepas pembelajaran struktur bersatu, model umum dalam bidang dokumen diperoleh melalui latihan bersama pelbagai tugas(generalis). .

Selain itu, untuk membolehkan model mempunyai keupayaan untuk menerangkan secara terperinci, mPLUG-DocOwl telah cuba memperkenalkan arahan teks biasa untuk memperhalusi data untuk latihan bersama, yang mempunyai kesan tertentu tetapi tidak sesuai. Dalam DocOwl 1.5, penulis membina sejumlah kecil data penjelasan terperinci(DocReason25K) melalui GPT3.5 dan GPT4V berdasarkan masalah tugasan hiliran.

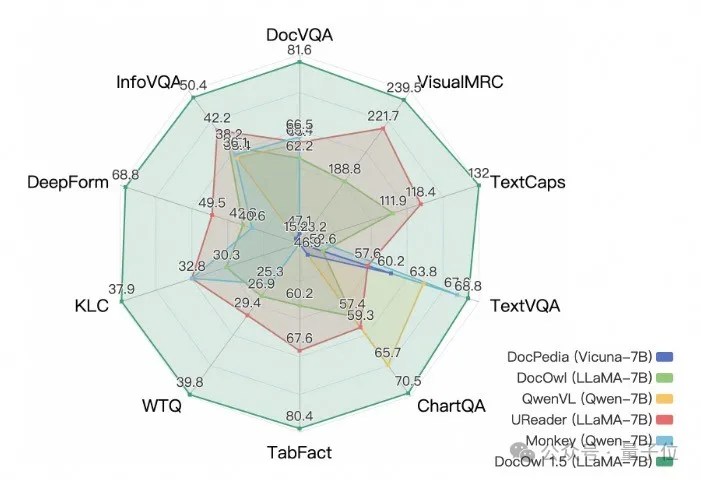

Dengan menggabungkan tugas hiliran dokumen dan DocReason25K untuk latihan, DocOwl 1.5-Chat boleh mencapai hasil yang lebih baik pada penanda aras:

△ Rajah 6: Pemahaman Dokumen Penilaian Penanda Aras

: dan

: dan

: dan : dan : △Rajah 7: Penjelasan terperinci tentang pemahaman dokumen

Cabaran 4: Pengenalan pengetahuan luaran

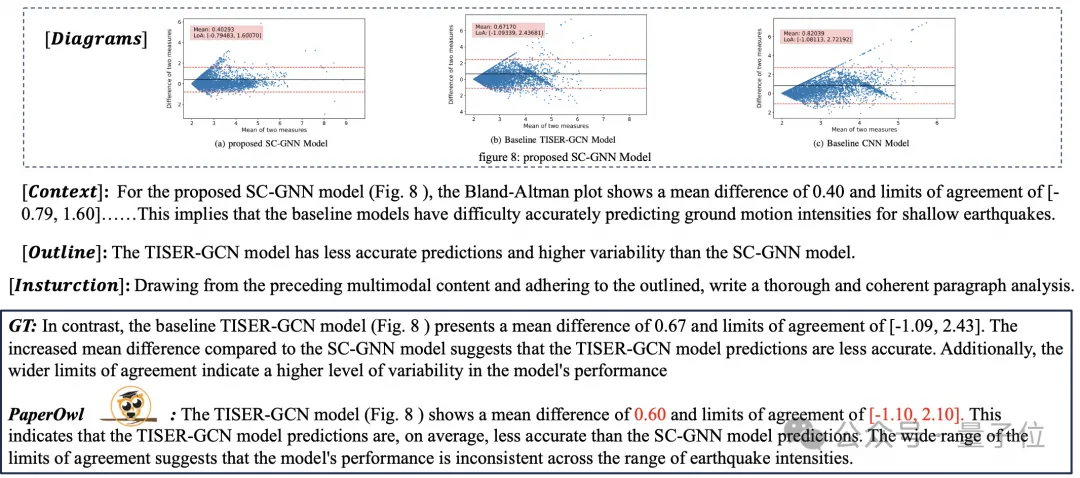

Gambar dokumen Disebabkan kekayaan maklumat, pemahaman sering memerlukan pengenalan pengetahuan tambahan, seperti istilah profesional dan maknanya dalam bidang khas dll. Untuk mengkaji cara memperkenalkan pengetahuan luaran untuk pemahaman dokumen yang lebih baik, pasukan mPLUG bermula dalam bidang kertas dan mencadangkan mPLUG-PaperOwl, membina set data analisis carta kertas berkualiti tinggi M-Paper, melibatkan 447k kertas definisi tinggi carta.

Data ini menyediakan konteks untuk carta dalam kertas sebagai sumber luar pengetahuan, dan mereka bentuk "titik penting"

(garis besar) sebagai isyarat kawalan untuk analisis carta untuk membantu model memahami niat pengguna dengan lebih baik.

Berdasarkan UReader, pengarang memperhalusi mPLUG-PaperOwl pada M-Paper, yang menunjukkan keupayaan analisis carta kertas awal, seperti yang ditunjukkan dalam Rajah 8. . Secara umum, artikel ini bermula daripada model besar pemahaman dokumen berbilang modal 7B yang dikeluarkan baru-baru ini mPLUG-DocOwl 1.5 dan meringkaskan empat cabaran utama pemahaman dokumen berbilang modal tanpa bergantung pada OCR("Teks imej resolusi tinggi pengiktirafan", "Pemahaman struktur dokumen sejagat", "Pengikut arahan", "Pengenalan pengetahuan luaran")

dan penyelesaian yang diberikan oleh pasukan Alibaba mPLUG.Walaupun mPLUG-DocOwl 1.5 telah meningkatkan prestasi pemahaman dokumen model sumber terbuka, ia masih jauh di belakang model besar sumber tertutup dan keperluan kehidupan sebenar Masih terdapat ruang untuk penambahbaikan dalam pengecaman teks, pengiraan matematik, umum tujuan, dsb. dalam pemandangan semula jadi.

Pasukan mPLUG akan mengoptimumkan lagi prestasi DocOwl dan sumber terbuka Semua orang dialu-alukan untuk terus memberi perhatian dan mengadakan perbincangan mesra.Pautan GitHub: https://github.com/X-PLUG/mPLUG-DocOwl

Pautan kertas: https://arxiv.org/abs/2403.12895

Atas ialah kandungan terperinci Dokumen berbilang modal Alibaba 7B memahami model besar memenangi SOTA baharu. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Mybatis结果生成键值对

- ps图片怎么保存ai格式

- ai将图片描出轮廓的基本步骤

- CMS sumber terbuka yang terkenal: Dreamweaver CMS akan mengucapkan selamat tinggal kepada percuma, dan era sumber terbuka semakin berkurangan!

- JavaScript: Bagaimana untuk mengalih keluar pasangan nilai kunci yang sepadan dengan kunci yang diberikan daripada objek?