Rumah >Peranti teknologi >AI >GPT-4 hanya mendapat 7.1 mata dalam setiap kategori, mendedahkan tiga kelemahan utama dalam keupayaan kod model besar Ujian penanda aras terkini ada di sini

GPT-4 hanya mendapat 7.1 mata dalam setiap kategori, mendedahkan tiga kelemahan utama dalam keupayaan kod model besar Ujian penanda aras terkini ada di sini

- PHPzke hadapan

- 2024-04-01 12:41:01853semak imbas

Jurutera perisian AI pertama Devin telah diumumkan secara rasmi, serta-merta meledakkan seluruh komuniti teknologi.

Walaupun Devin tidak dapat menyelesaikan tugas pengekodan dengan mudah, dia boleh menyelesaikan keseluruhan kitaran pembangunan perisian secara bebas - daripada perancangan projek hingga penggunaan. Dia cuba sedaya upaya untuk menggali, tetapi tidak terhad kepada membina tapak web, mencari dan membetulkan pepijat secara bebas, melatih dan memperhalusi model AI, dsb.

Keupayaan pembangunan perisian yang "luar biasa kuat" ini telah membuatkan ramai pengkode putus asa, berseru: "Adakah penghujung pengaturcara benar-benar akan datang?" Penanda aras SWE-Bench amat menarik perhatian.

SWE-Bench ialah ujian untuk menilai keupayaan kejuruteraan perisian AI, memfokuskan pada keupayaan model besar untuk menyelesaikan masalah GitHub sebenar. Devin mendahului senarai dengan kadar penyelesaian masalah bebas sebanyak 13.86%, "membunuh serta-merta" skor GPT-4 hanya 1.74%, meninggalkan banyak model AI yang besar jauh di belakang. Prestasi hebat ini membuatkan orang tertanya-tanya:

"Apakah peranan yang akan dimainkan oleh AI dalam pembangunan perisian masa hadapan

Makmal Kepintaran Buatan Shanghai bekerjasama dengan penyelidik dari ByteDance SE Lab dan SWE- Pasukan Bench mencadangkan penanda aras ujian baharu?" DevBench, mendedahkan buat pertama kalinya sejauh mana model besar boleh bermula dari PRD,

menyiapkan reka bentuk, pembangunan, dan ujian projek yang lengkap. DevBench ialah yang pertama menilai prestasi model besar di semua peringkat daripada dokumen keperluan produk (PRD) hingga menyelesaikan pembangunan projek, termasuk reka bentuk perisian, pembinaan persekitaran pergantungan, penjanaan kod peringkat asas kod, ujian integrasi dan ujian unit .

, ketidakupayaan untuk menulis skrip Bina yang lebih kompleks (skrip binaan), dan parameter panggilan fungsi tidak sepadan dan isu lain. Model bahasa yang besar masih jauh untuk dapat menyelesaikan pembangunan projek perisian bersaiz kecil dan sederhana secara bebas.

Pada masa ini, kertas kerja DevBench telah diterbitkan pada platform pracetak arXiv, dan kod serta data yang berkaitan adalah sumber terbuka di GitHub.(Pautan di penghujung artikel)

Apakah tugas DevBench?

△

Gambar menunjukkan gambaran keseluruhan rangka kerja DevBench  Tanda aras pengaturcaraan tradisional sering menumpukan pada satu aspek penjanaan kod dan tidak dapat mencerminkan sepenuhnya kerumitan tugas pengaturcaraan dunia sebenar. Kemunculan DevBench mematahkan had ini Ia mensimulasikan pelbagai peringkat pembangunan perisian melalui satu siri tugasan yang direka dengan teliti, dengan itu menyediakan platform untuk penilaian menyeluruh keupayaan LLM.

Tanda aras pengaturcaraan tradisional sering menumpukan pada satu aspek penjanaan kod dan tidak dapat mencerminkan sepenuhnya kerumitan tugas pengaturcaraan dunia sebenar. Kemunculan DevBench mematahkan had ini Ia mensimulasikan pelbagai peringkat pembangunan perisian melalui satu siri tugasan yang direka dengan teliti, dengan itu menyediakan platform untuk penilaian menyeluruh keupayaan LLM.

DevBench dibina berdasarkan lima tugas utama

, setiap satu memfokuskan pada peringkat utama kitaran hayat pembangunan perisian, dan reka bentuk modular membolehkan ujian dan penilaian bebas bagi setiap tugas. Reka bentuk perisian:

Gunakan dokumen keperluan produk PRD untuk mencipta gambar rajah UML dan reka bentuk seni bina untuk memaparkan kelas, atribut, perhubungan dan susun atur struktur perisian. Tugasan ini merujuk kepada MT-Bench dan menggunakan kaedah penilaian LLM-sebagai-Hakim. Penilaian terutamanya berdasarkan dua petunjuk utama: prinsip umum reka bentuk perisian (seperti kohesi tinggi dan gandingan rendah, dll.) dan kesetiaan (kesetiaan) . Tetapan persekitaran:

Janakan fail pergantungan yang diperlukan untuk memulakan persekitaran pembangunan berdasarkan dokumen keperluan yang disediakan. Semasa proses penilaian, fail kebergantungan akan dibina dalam persekitaran pengasingan asas yang diberikan (bekas docker) melalui arahan penanda aras. Kemudian, dalam persekitaran pergantungan yang dibina oleh model ini, tugasan menilai kadar kejayaan melaksanakan kod penanda aras dengan melaksanakan kod penggunaan contoh penanda aras (penggunaan contoh) dalam gudang kod. Pelaksanaan kod:

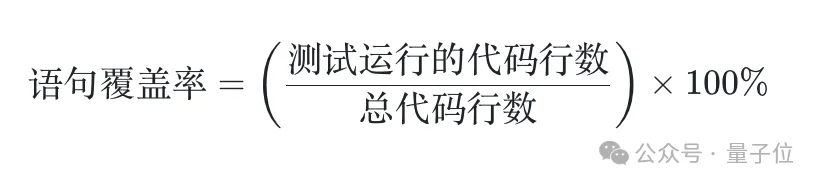

Berdasarkan dokumen keperluan dan reka bentuk seni bina, model perlu melengkapkan penjanaan fail kod keseluruhan pangkalan kod. DevBench membangunkan rangka kerja ujian automatik dan menyesuaikannya untuk bahasa pengaturcaraan khusus yang digunakan, menyepadukan PyTest Python, GTest C++, JUnit Java dan Jest JavaScript. Tugas ini menilai kadar lulus pangkalan kod yang dijana model yang melaksanakan ujian penyepaduan penanda aras dan ujian unit dalam persekitaran penanda aras. Ujian integrasi: Model menjana kod ujian integrasi berdasarkan keperluan untuk mengesahkan fungsi antara muka luaran pangkalan kod. Tugas ini menjalankan ujian integrasi yang dijana pada kod pelaksanaan garis dasar dan melaporkan kadar lulus ujian. Ujian unit: Model menjana kod ujian unit berdasarkan keperluan. Sekali lagi, tugas ini menjalankan ujian unit yang dijana pada kod pelaksanaan garis dasar. Sebagai tambahan kepada penunjuk kadar lulus, tugasan ini juga memperkenalkan penunjuk penilaian liputan penyata untuk menilai secara kuantitatif kesempurnaan ujian. Proses penyediaan data DevBench merangkumi tiga peringkat: penyediaan gudang, pembersihan kod dan penyediaan dokumen. Pada akhirnya, set data DevBench mengandungi 4 bahasa pengaturcaraan, berbilang medan dan sejumlah 22 pangkalan kod. Kerumitan repositori kod ini dan kepelbagaian paradigma pengaturcaraan yang digunakan menyediakan cabaran penting untuk model bahasa. Beberapa contoh menarik: TextCNN Bolehkah model besar menulis sepenuhnya model TextCNN untuk klasifikasi binari teks? Mampu menarik set data daripada HF sendiri dan menjalankan latihan adalah keperluan asas. Model ini juga perlu menyesuaikan hiperparameter, merekodkan log, dan menyimpan pusat pemeriksaan mengikut keperluan dokumen, sambil memastikan kebolehulangan percubaan. . rangka kerja akhir , bolehkah model mengatasi dengan mudah projek bahagian hadapan di mana konflik versi mungkin berlaku? (https://github.com/open-compass/DevBench/tree/main/benchmark_data/javascript/login-registration) People Management Bagaimana model SQLite menguasai penciptaan dan pengurusan SQLite pangkalan data? Sebagai tambahan kepada operasi asas tambah, padam, ubah suai dan pertanyaan, bolehkah model itu merangkum pengurusan dan pengendalian maklumat kakitangan kampus dan pangkalan data hubungan ke dalam alat baris arahan yang mudah digunakan? . industri filem dan televisyen ? Model itu perlu mendapatkan data daripada API TMDB dan membina rangkaian hubungan antara pelakon popular melalui kerjasama mereka dalam filem. (https://github.com/open-compass/DevBench/tree/main/benchmark_data/java/Actor_relationship_game) ArXiv digest Gajet induk ArXiv juga telah diambil semula dengan mudah? API ArXiv tidak menyokong fungsi "menapis kertas dalam N hari terakhir", tetapi ia boleh "menyisih mengikut masa penerbitan" Bolehkah model itu digunakan untuk membangunkan alat carian kertas yang berguna? (https://github.com/open-compass/DevBench/tree/main/benchmark_data/python/ArXiv_digest) Penemuan eksperimenPasukan penyelidik menggunakan DevBench untuk menganalisis LLM4 yang popular pada masa ini, termasuk GPT-4 yang popular - Turbo diuji sepenuhnya. Keputusan menunjukkan bahawa walaupun model ini berfungsi dengan baik pada tugas pengaturcaraan mudah, mereka masih menghadapi kesukaran yang ketara apabila berhadapan dengan cabaran pembangunan perisian dunia sebenar yang kompleks. Terutama apabila berurusan dengan struktur kod dan logik yang kompleks, prestasi model perlu dipertingkatkan. DevBench bukan sahaja mendedahkan batasan LLM sedia ada dalam pembangunan perisian, tetapi juga memberikan cerapan berharga untuk penambahbaikan model masa hadapan. Melalui ujian penanda aras ini, penyelidik dapat memahami dengan lebih baik kekuatan dan kelemahan LLM, dengan itu mengoptimumkannya dalam cara yang disasarkan dan menggalakkan pembangunan AI selanjutnya dalam bidang kejuruteraan perisian. Devin mendahului di SWE-Bench Bolehkah prestasi cemerlangnya diperluaskan kepada senario penilaian lain? Memandangkan keupayaan pembangunan perisian AI terus berkembang, pertempuran antara pengekod dan AI ini amat dinanti-nantikan. DevBench kini telah menyertai sistem penilaian keupayaan model besar OpenCompass OpenCompass ialah kedai sehenti untuk pelbagai model seperti model bahasa besar dan model besar berbilang modal yang dibangunkan dan dilancarkan oleh. platform Penilaian Kecerdasan Buatan Shanghai. OpenCompass mempunyai ciri-ciri kebolehulangan, dimensi keupayaan komprehensif, sokongan model yang kaya, penilaian cekap teragih, paradigma penilaian yang pelbagai dan pengembangan fleksibel. Berdasarkan sistem kecekapan berbilang peringkat dan rantaian alat yang berkualiti tinggi, OpenCompass telah menginovasi beberapa kaedah penilaian kecekapan dan menyokong pelbagai penanda aras penilaian dwibahasa berkualiti tinggi dalam bahasa Cina dan Inggeris, meliputi bahasa dan pemahaman, akal fikiran dan penaakulan logik, pengiraan dan aplikasi matematik, dan banyak lagi aspek seperti keupayaan pengekodan bahasa pengaturcaraan, ejen, penciptaan dan dialog boleh mencapai diagnosis menyeluruh tentang keupayaan sebenar model besar. DevBench telah meluaskan keupayaan penilaian OpenCompass dalam bidang ejen. Kertas DevBench: https://arxiv.org/abs/2403.08604

Apakah data yang terkandung dalam DevBench?

Terdapat juga sistem penilaian model besar OpenCompass

GitHub: https://github.com/open-compass/devBench/

OpenCompass/openhub.com kompas/kompas terbuka

Atas ialah kandungan terperinci GPT-4 hanya mendapat 7.1 mata dalam setiap kategori, mendedahkan tiga kelemahan utama dalam keupayaan kod model besar Ujian penanda aras terkini ada di sini. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!