Rumah >Peranti teknologi >AI >Satu artikel untuk memahami cabaran teknikal dan strategi pengoptimuman untuk memperhalusi model bahasa besar

Satu artikel untuk memahami cabaran teknikal dan strategi pengoptimuman untuk memperhalusi model bahasa besar

- WBOYke hadapan

- 2024-03-20 23:01:02822semak imbas

Hello semua, nama saya Luga. Hari ini kami akan terus meneroka teknologi dalam ekosistem kecerdasan buatan, terutamanya LLM Penalaan Halus. Artikel ini akan terus menganalisis teknologi Penalaan Halus LLM secara mendalam untuk membantu semua orang memahami mekanisme pelaksanaannya dengan lebih baik supaya ia boleh digunakan dengan lebih baik pada pembangunan pasaran dan bidang lain.

LLM (Model Bahasa Besar) menerajui gelombang baharu teknologi kecerdasan buatan. AI lanjutan ini mensimulasikan kebolehan kognitif dan bahasa manusia dengan menganalisis sejumlah besar data menggunakan model statistik untuk mempelajari corak kompleks antara perkataan dan frasa. Fungsi berkuasa LLM telah menimbulkan minat yang kuat daripada banyak syarikat terkemuka dan peminat teknologi, yang tergesa-gesa untuk menerima pakai penyelesaian inovatif ini yang didorong oleh kecerdasan buatan, bertujuan untuk meningkatkan kecekapan operasi, mengurangkan beban kerja, mengurangkan perbelanjaan kos, dan akhirnya memberi inspirasi. idea yang lebih inovatif yang mencipta nilai perniagaan.

Namun, untuk benar-benar merealisasikan potensi LLM, kuncinya terletak pada "penyesuaian". Iaitu, cara perusahaan boleh mengubah model umum pra-latihan kepada model eksklusif yang memenuhi keperluan perniagaan unik mereka sendiri dan menggunakan senario kes melalui strategi pengoptimuman khusus. Memandangkan perbezaan antara perusahaan yang berbeza dan senario aplikasi, adalah amat penting untuk memilih kaedah penyepaduan LLM yang sesuai. Oleh itu, menilai dengan tepat keperluan kes penggunaan khusus dan memahami perbezaan dan pertukaran halus antara pilihan penyepaduan yang berbeza akan membantu perusahaan membuat keputusan termaklum.

Apakah Penalaan Halus?

Dalam era popularisasi pengetahuan hari ini, tidak pernah semudah ini untuk mendapatkan maklumat dan pendapat tentang AI dan LLM. Walau bagaimanapun, mencari jawapan profesional yang praktikal dan khusus konteks tetap menjadi cabaran. Dalam kehidupan seharian kita, kita sering menghadapi salah faham seperti ini: secara umumnya dipercayai bahawa model Penalaan Halus (penalaan halus) adalah satu-satunya (atau mungkin cara terbaik) untuk LLM memperoleh pengetahuan baharu. Malah, sama ada anda menambah pembantu kolaboratif pintar pada produk anda atau menggunakan LLM untuk menganalisis sejumlah besar data tidak berstruktur yang disimpan dalam awan, data sebenar dan persekitaran perniagaan anda merupakan faktor utama dalam memilih pendekatan LLM yang betul.

Dalam banyak kes, selalunya lebih berkesan untuk menggunakan strategi alternatif yang kurang kompleks untuk dikendalikan, lebih mantap kepada set data yang kerap berubah, dan menghasilkan keputusan yang lebih dipercayai dan tepat daripada kaedah penalaan halus tradisional. Walaupun penalaan halus ialah teknik penyesuaian LLM biasa yang melaksanakan latihan tambahan pada model pra-latihan pada set data tertentu untuk menyesuaikannya dengan lebih baik kepada tugas atau domain tertentu, ia juga mempunyai beberapa pertukaran dan pengehadan yang penting.

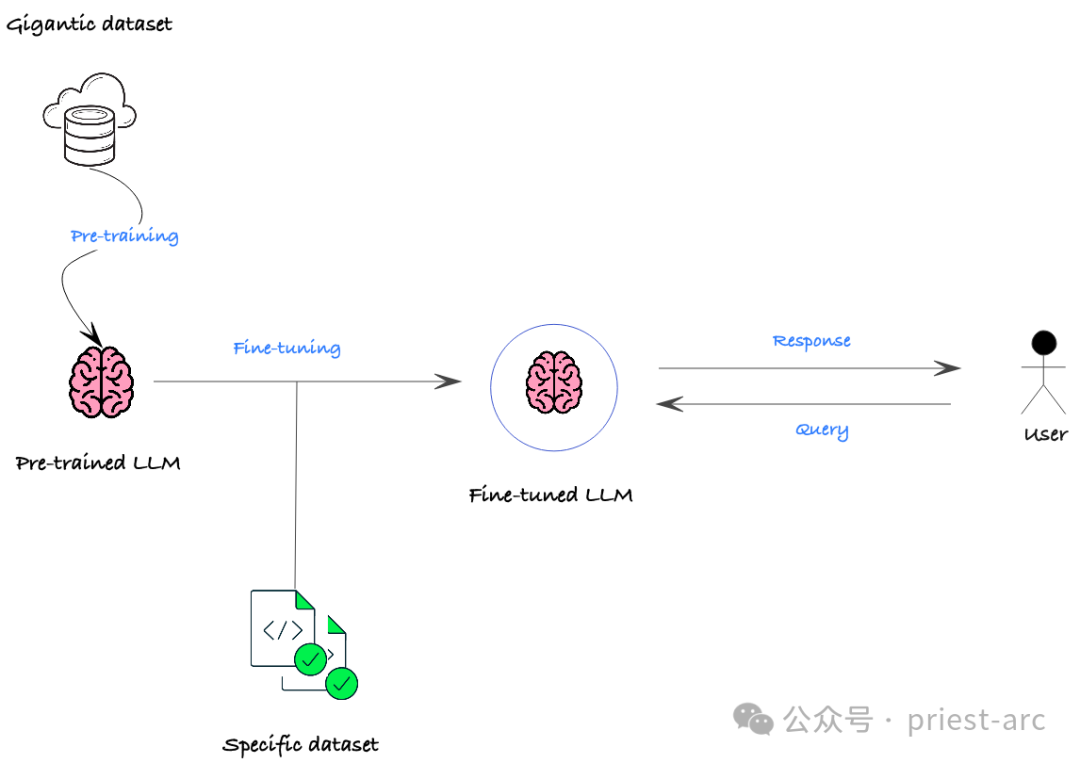

Jadi, apakah itu Fine-Tuning?

LLM (Large Language Model) fine-tuning merupakan salah satu teknologi yang telah menarik perhatian ramai dalam bidang NLP (Natural Language Processing) sejak beberapa tahun kebelakangan ini. Ia membolehkan model menyesuaikan diri dengan lebih baik pada domain atau tugas tertentu dengan melakukan latihan tambahan pada model yang sudah terlatih. Kaedah ini membolehkan model mempelajari lebih banyak pengetahuan yang berkaitan dengan domain tertentu, dengan itu mencapai prestasi yang lebih baik dalam domain atau tugasan ini. Kelebihan penalaan halus LLM ialah ia mengambil kesempatan daripada pengetahuan am yang telah dipelajari oleh model pra-latihan, dan kemudian memperhalusinya lagi pada domain tertentu untuk mencapai ketepatan dan prestasi yang lebih tinggi pada tugasan tertentu. Kaedah ini telah digunakan secara meluas dalam pelbagai tugasan NLP dan telah mencapai hasil yang ketara Konsep utama penalaan halus LLM adalah menggunakan parameter model pra-latihan sebagai asas untuk tugasan baharu, dan menjadikan model diperhalusi. sejumlah kecil domain atau data tugasan tertentu Keupayaan untuk menyesuaikan diri dengan cepat kepada tugasan atau set data baharu. Kaedah ini boleh menjimatkan banyak masa dan sumber latihan sambil meningkatkan prestasi model pada tugasan baharu. Fleksibiliti dan kecekapan penalaan halus LLM menjadikannya salah satu kaedah pilihan dalam banyak tugas pemprosesan bahasa semula jadi. Dengan memperhalusi di atas model yang telah dilatih, model itu boleh mempelajari ciri dan corak untuk tugasan baharu dengan lebih pantas, sekali gus meningkatkan prestasi keseluruhan. Ini

Dalam senario perniagaan sebenar, tujuan utama penalaan halus biasanya termasuk perkara berikut:

Dalam senario perniagaan sebenar, tujuan utama penalaan halus biasanya termasuk perkara berikut:

(1) Penyesuaian domain

LLM biasanya dilatih pada data umum merentas domain, tetapi apabila digunakan pada bidang Dalam tertentu seperti kewangan, perubatan, undang-undang dan senario lain, prestasi mungkin terjejas dengan teruk. Melalui penalaan halus, model pra-latihan boleh dilaraskan dan disesuaikan dengan domain sasaran supaya ia dapat menangkap dengan lebih baik ciri-ciri bahasa dan hubungan semantik domain tertentu, seterusnya meningkatkan prestasi dalam domain ini.

(2) Penyesuaian tugas

Walaupun dalam bidang yang sama, tugasan khusus yang berbeza mungkin mempunyai keperluan yang berbeza. Tugas NLP seperti klasifikasi teks, menjawab soalan, pengecaman entiti bernama, dsb. semuanya akan mengemukakan keperluan yang berbeza untuk pemahaman bahasa dan keupayaan penjanaan. Melalui penalaan halus, penunjuk prestasi model pada tugas tertentu, seperti ketepatan, Ingat, nilai F1, dsb., boleh dioptimumkan mengikut keperluan khusus tugas hiliran.

(3) Peningkatan prestasi

Walaupun pada tugas tertentu, model pra-latihan mungkin mempunyai kesesakan dalam ketepatan, kelajuan, dsb. Melalui penalaan halus, kami boleh meningkatkan lagi prestasi model pada tugasan ini. Contohnya, untuk senario aplikasi masa nyata yang memerlukan kelajuan inferens yang tinggi, model boleh dimampatkan dan dioptimumkan untuk tugas utama yang memerlukan ketepatan yang lebih tinggi, keupayaan pertimbangan model juga boleh dipertingkatkan lagi melalui penalaan halus.

Apakah faedah dan kesukaran yang dihadapi oleh Penalaan Halus (penalaan halus)?

Secara amnya, faedah utama Penalaan Halus (penalaan halus) ialah ia dapat meningkatkan prestasi model pra-latihan sedia ada dengan berkesan dalam senario aplikasi tertentu. Melalui latihan berterusan dan pelarasan parameter model asas dalam bidang sasaran atau tugas, ia boleh menangkap ciri dan corak semantik dengan lebih baik dalam senario tertentu, dengan itu meningkatkan dengan ketara penunjuk utama model dalam bidang atau tugasan ini. Contohnya, dengan memperhalusi model Llama 2, prestasi pada beberapa ciri boleh menjadi lebih baik daripada pelaksanaan model bahasa asal Meta.

Walaupun Penalaan Halus membawa faedah yang ketara kepada LLM, terdapat juga beberapa kelemahan yang perlu dipertimbangkan. Jadi, apakah dilema yang dihadapi oleh Penalaan Halus (fine-tuning)? semasa pra-latihan. Ini boleh berlaku jika data nudge terlalu khusus atau tertumpu terutamanya pada kawasan yang sempit.

Keperluan Data: Walaupun penalaan halus memerlukan kurang data berbanding latihan dari awal, data berkualiti tinggi dan berkaitan masih diperlukan untuk tugasan tertentu. Data yang tidak mencukupi atau tidak dilabelkan dengan betul boleh menyebabkan prestasi yang lemah.

- Sumber pengiraan: Proses penalaan halus kekal mahal dari segi pengiraan, terutamanya untuk model kompleks dan set data yang besar. Bagi organisasi yang lebih kecil atau mereka yang mempunyai sumber terhad, ini boleh menjadi penghalang.

- Kepakaran diperlukan: Penalaan halus selalunya memerlukan kepakaran dalam bidang seperti pembelajaran mesin, NLP dan tugas khusus yang ada. Memilih model pralatihan yang betul, mengkonfigurasi hiperparameter dan menilai keputusan boleh menjadi rumit bagi mereka yang tidak mempunyai pengetahuan yang diperlukan.

- Isu berpotensi:

- Penguatan bias: Model pra-latihan boleh mewarisi berat sebelah daripada data latihan mereka. Jika data yang didorong mencerminkan bias yang serupa, dorongan tersebut mungkin secara tidak sengaja menguatkan bias ini. Ini boleh membawa kepada hasil yang tidak adil atau diskriminasi.

Cabaran Kebolehtafsiran: Model yang diperhalusi adalah lebih sukar untuk ditafsirkan daripada model yang telah dilatih. Memahami cara model mencapai keputusannya boleh menjadi sukar, yang boleh menghalang nyahpepijat dan mempercayai output model.

- Risiko Keselamatan: Model yang diperhalusi mungkin terdedah kepada serangan musuh, di mana pelaku berniat jahat memanipulasi data input, menyebabkan model menghasilkan output yang salah.

- Bagaimana Penalaan Halus berbanding kaedah penyesuaian lain?

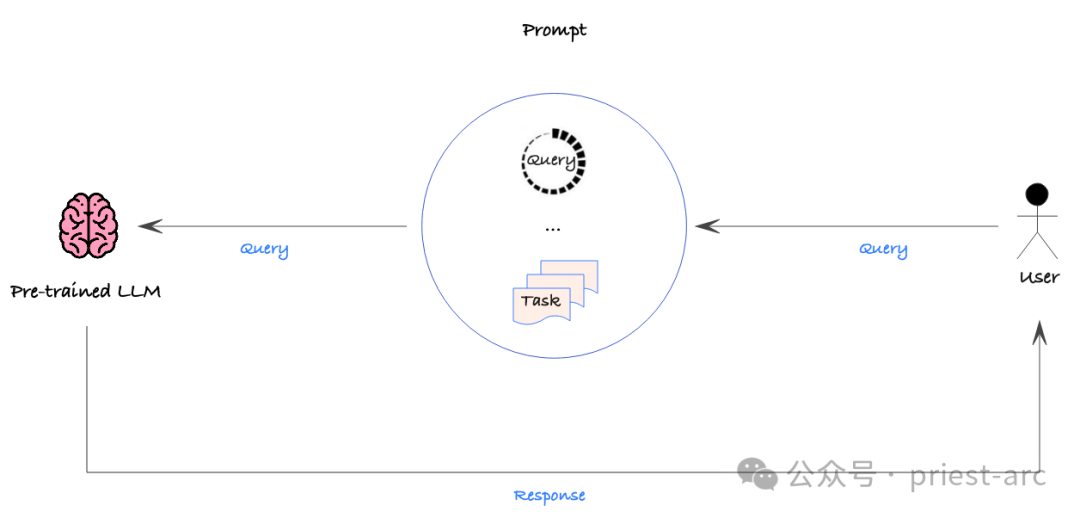

- Secara umumnya, Penalaan Halus bukanlah satu-satunya cara untuk menyesuaikan output model atau menyepadukan data tersuai. Malah, ia mungkin tidak sesuai untuk keperluan khusus dan kes penggunaan kami, terdapat beberapa alternatif lain yang patut diterokai dan dipertimbangkan, seperti berikut:

Strategi ini agak mudah, tetapi pendekatan dipacu data masih harus digunakan untuk menilai secara kuantitatif ketepatan pelbagai petua untuk memastikan prestasi yang diingini. Dengan cara ini, kita boleh memperhalusi isyarat secara sistematik untuk mencari cara paling berkesan untuk membimbing model menghasilkan output yang diingini.

Namun, Prompt Engineering bukan tanpa kekurangannya. Pertama, ia tidak boleh secara langsung menyepadukan set data yang besar kerana gesaan biasanya diubah suai dan digunakan secara manual. Ini bermakna Prompt Engineering mungkin kelihatan kurang cekap apabila memproses data berskala besar.

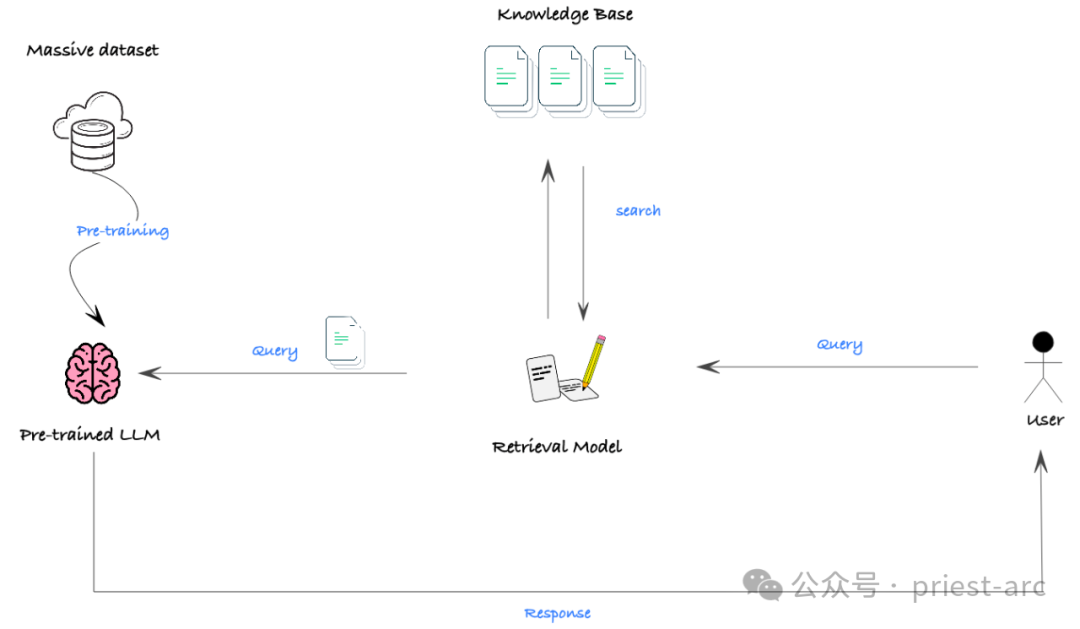

Dalam senario sebenar, halangan terbesar kepada keberkesanan RAG ialah banyak model mempunyai tetingkap konteks terhad, iaitu panjang maksimum teks yang boleh diproses oleh model pada satu masa adalah terhad. Dalam sesetengah situasi di mana pengetahuan latar belakang yang luas diperlukan, ia mungkin menghalang model daripada mendapatkan maklumat yang mencukupi untuk mencapai prestasi yang baik.

Namun, dengan perkembangan pesat teknologi, tetingkap konteks model berkembang pesat. Malah beberapa model sumber terbuka telah dapat mengendalikan input teks panjang sehingga 32,000 token. Ini bermakna RAG akan mempunyai prospek aplikasi yang lebih luas pada masa hadapan dan boleh memberikan sokongan yang kuat untuk tugas yang lebih kompleks.

Seterusnya, mari kita fahami dan bandingkan prestasi khusus ketiga-tiga teknologi ini dari segi privasi data, sila rujuk perkara berikut:

(1) Penalaan Halus (penalaan halus)

Penalaan Halus (. penalaan halus) ) ialah maklumat yang digunakan semasa melatih model dikodkan ke dalam parameter model. Ini bermakna walaupun output model adalah peribadi kepada pengguna, data latihan asas mungkin masih bocor. Penyelidikan menunjukkan bahawa penyerang berniat jahat juga boleh mengekstrak data latihan mentah daripada model melalui serangan suntikan. Oleh itu, kita mesti menganggap bahawa sebarang data yang digunakan untuk melatih model mungkin boleh diakses oleh pengguna masa hadapan.

(2) Prompt Engineering

Sebagai perbandingan, jejak keselamatan data Prompt Engineering jauh lebih kecil. Oleh kerana gesaan boleh diasingkan dan disesuaikan untuk setiap pengguna, data yang terkandung dalam gesaan yang dilihat oleh pengguna yang berbeza mungkin berbeza. Tetapi kami masih perlu memastikan bahawa sebarang data yang terkandung dalam gesaan itu tidak sensitif atau dibenarkan kepada mana-mana pengguna yang mempunyai akses kepada gesaan itu.

(3) RAG (Retrieval Enhancement Generation)

Keselamatan RAG bergantung pada kawalan capaian data dalam sistem perolehan asasnya. Kami perlu memastikan bahawa pangkalan data vektor asas dan templat segera dikonfigurasikan dengan privasi dan kawalan data yang sesuai untuk menghalang capaian yang tidak dibenarkan. Hanya dengan cara ini RAG boleh benar-benar memastikan privasi data.

Secara keseluruhannya, Prompt Engineering dan RAG mempunyai kelebihan yang jelas berbanding penalaan halus dalam hal privasi data. Tetapi tidak kira kaedah yang digunakan, kami mesti mengurus akses data dan perlindungan privasi dengan berhati-hati untuk memastikan maklumat sensitif pengguna dilindungi sepenuhnya.

Jadi, dalam erti kata lain, sama ada kita akhirnya memilih Fine-Tuning, Prompt Engineering atau RAG, pendekatan yang diguna pakai harus konsisten dengan matlamat strategik organisasi, sumber yang ada, kemahiran profesional dan jangkaan pulangan pelaburan Sangat konsisten. Ini bukan sahaja tentang keupayaan teknikal tulen, tetapi juga tentang cara pendekatan ini sesuai dengan strategi perniagaan, garis masa, aliran kerja semasa dan keperluan pasaran kami.

Memahami selok-belok pilihan Penalaan Halus adalah kunci untuk membuat keputusan termaklum. Butiran teknikal dan penyediaan data yang terlibat dalam Penalaan Halus adalah agak kompleks dan memerlukan pemahaman yang mendalam tentang model dan data. Oleh itu, adalah penting untuk bekerjasama rapat dengan rakan kongsi yang mempunyai pengalaman penalaan halus yang meluas. Rakan kongsi ini bukan sahaja mesti mempunyai keupayaan teknikal yang boleh dipercayai, tetapi juga dapat memahami sepenuhnya proses dan matlamat perniagaan kami serta memilih penyelesaian teknologi tersuai yang paling sesuai untuk kami.

Begitu juga, jika kami memilih untuk menggunakan Prompt Engineering atau RAG, kami juga perlu menilai dengan teliti sama ada kaedah ini boleh sepadan dengan keperluan perniagaan kami, keadaan sumber dan kesan yang dijangkakan. Akhirnya kejayaan hanya boleh dicapai dengan memastikan bahawa teknologi tersuai yang dipilih benar-benar boleh mencipta nilai untuk organisasi kita.

Rujukan:

- [1] https://medium.com/@younesh.kc/rag-vs-fine-tuning-in-large-language-models-a-comparison-c765b9e21328

- [2] https ://kili-technology.com/large-language-models-llms/the-ultimate-guide-to-fine-tuning-llms-2023

Atas ialah kandungan terperinci Satu artikel untuk memahami cabaran teknikal dan strategi pengoptimuman untuk memperhalusi model bahasa besar. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!