Peranti teknologi

Peranti teknologi AI

AI Penyelidikan baharu Google tentang kecerdasan yang terkandung: RT-H, yang lebih baik daripada RT-2, ada di sini

Penyelidikan baharu Google tentang kecerdasan yang terkandung: RT-H, yang lebih baik daripada RT-2, ada di siniPenyelidikan baharu Google tentang kecerdasan yang terkandung: RT-H, yang lebih baik daripada RT-2, ada di sini

Memandangkan model bahasa besar seperti GPT-4 semakin disepadukan dengan robotik, kecerdasan buatan secara beransur-ansur bergerak ke dunia nyata. Oleh itu, penyelidikan yang berkaitan dengan kecerdasan yang terkandung juga telah menarik perhatian lebih banyak. Di antara banyak projek penyelidikan, siri robot "RT" Google sentiasa berada di barisan hadapan dan trend ini telah mula berkembang pesat baru-baru ini (lihat "Model Besar Sedang Membina Semula Robot, Bagaimana Google Deepmind Mentakrifkan Kecerdasan Terwujud di Masa Depan" untuk butiran).

Pada Julai tahun lalu, Google DeepMind melancarkan RT-2, model pertama di dunia yang mampu mengawal robot untuk interaksi visual-language-action (VLA). Hanya dengan memberi arahan dalam cara perbualan, RT-2 boleh mengenal pasti Swift dalam sejumlah besar gambar dan menghantar setin Coke kepadanya.

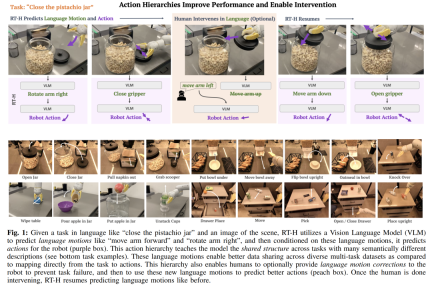

Kini, robot ini telah berkembang semula. Versi terkini robot RT dipanggil "RT-H". Ia boleh meningkatkan ketepatan pelaksanaan tugas dan kecekapan pembelajaran dengan menguraikan tugasan yang kompleks kepada arahan bahasa mudah dan kemudian menukar arahan ini kepada tindakan robot. Sebagai contoh, diberi tugasan, seperti "meletakkan penutup pada balang pistachio" dan imej pemandangan, RT-H akan menggunakan model bahasa visual (VLM) untuk meramalkan tindakan bahasa (gerakan), seperti "gerakkan lengan ke hadapan. " dan "Putar lengan ke kanan", dan kemudian ramalkan tindakan robot berdasarkan tindakan lisan ini.

Tahap tindakan adalah penting untuk mengoptimumkan ketepatan dan kecekapan pembelajaran pelaksanaan tugas robot. Struktur hierarki ini menjadikan RT-H berprestasi lebih baik daripada RT-2 dalam pelbagai tugas robot, menyediakan laluan pelaksanaan yang lebih cekap untuk robot.

Berikut ialah butiran kertas tersebut. Pautan org/pdf/ 2403.01823 .pdf

Pautan projek: https://rt-hierarchy.github.io/

Bahasa ialah enjin penaakulan manusia, yang membolehkan kita memecahkan konsep yang kompleks kepada komponen yang lebih mudah , salah faham kita, dan generalisasi konsep dalam konteks baharu. Dalam beberapa tahun kebelakangan ini, robot juga telah mula menggunakan struktur bahasa yang cekap dan gabungan untuk memecahkan konsep peringkat tinggi, menyediakan pembetulan bahasa, atau mencapai generalisasi dalam persekitaran baharu.

Bahasa ialah enjin penaakulan manusia, yang membolehkan kita memecahkan konsep yang kompleks kepada komponen yang lebih mudah , salah faham kita, dan generalisasi konsep dalam konteks baharu. Dalam beberapa tahun kebelakangan ini, robot juga telah mula menggunakan struktur bahasa yang cekap dan gabungan untuk memecahkan konsep peringkat tinggi, menyediakan pembetulan bahasa, atau mencapai generalisasi dalam persekitaran baharu.

- Kajian ini biasanya mengikut paradigma biasa: berdepan dengan tugas peringkat tinggi yang diterangkan dalam bahasa (seperti "ambil tin Coke"), mereka mempelajari strategi untuk memetakan pemerhatian dan penerangan tugas dalam bahasa kepada robot peringkat rendah actions , yang perlu dicapai melalui set data berbilang tugas berskala besar. Kelebihan bahasa dalam senario ini ialah ia mengekodkan struktur yang dikongsi antara tugasan yang serupa (cth., "ambil tin Coke" lwn. "angkat epal"), sekali gus mengurangkan data yang diperlukan untuk mempelajari pemetaan daripada tugasan kepada tindakan. Walau bagaimanapun, apabila tugasan menjadi lebih pelbagai, bahasa yang digunakan untuk menerangkan setiap tugasan juga menjadi lebih pelbagai (cth., "Ambil tin Coke" berbanding "isi segelas air"), menjadikan pembelajaran antara tugasan yang berbeza semata-mata melalui bahasa peringkat tinggi Ia menjadi lebih sukar untuk berkongsi struktur antara Untuk mempelajari tugasan yang pelbagai, penyelidik menyasarkan untuk menangkap persamaan antara tugasan ini dengan lebih tepat.

- Mereka mendapati bahawa bahasa bukan sahaja boleh menerangkan tugasan peringkat tinggi, tetapi juga menerangkan secara terperinci cara menyelesaikan tugasan - perwakilan jenis ini lebih halus dan lebih dekat dengan tindakan tertentu. Sebagai contoh, tugas "mengambil tin Coke" boleh dipecahkan kepada beberapa langkah yang lebih terperinci, iaitu "gerakan bahasa": pertama "mencapai lengan ke hadapan", kemudian "menggenggam tin", dan akhirnya "mengangkat lengan ke atas" ”. Wawasan teras penyelidik ialah dengan menggunakan tindakan lisan sebagai lapisan perantaraan yang menghubungkan perihalan tugas peringkat tinggi dan tindakan peringkat rendah, tindakan tersebut boleh digunakan untuk membina hierarki tindakan yang dibentuk melalui tindakan lisan.

- Terdapat beberapa faedah untuk mewujudkan tahap tindakan ini:

- Ia membolehkan perkongsian data yang lebih baik pada tahap tindakan bahasa antara tugasan yang berbeza, membolehkan gabungan tindakan bahasa dan generalisasi dalam set data berbilang tugas dipertingkatkan. Sebagai contoh, walaupun "tuang segelas air" dan "angkat tin Coke" berbeza secara semantik, tindakan lisan mereka adalah sama sehingga mereka dilaksanakan untuk mengambil objek.

- Tindakan bahasa bukanlah primitif tetap yang mudah, tetapi dipelajari melalui arahan dan pemerhatian visual berdasarkan spesifik tugas dan adegan semasa. Contohnya, "jangkau tangan ke hadapan" tidak menyatakan kelajuan atau arah pergerakan, yang bergantung pada tugas dan pemerhatian tertentu. Pergantungan konteks dan fleksibiliti tindakan lisan yang dipelajari memberi kita keupayaan baharu: membenarkan orang ramai membuat pengubahsuaian kepada tindakan lisan apabila strategi tidak berjaya 100% (lihat kawasan jingga dalam Rajah 1). Selanjutnya, robot juga boleh belajar daripada pembetulan manusia ini. Sebagai contoh, semasa menjalankan tugas "mengambil tin Coke", jika robot menutup pencengkam terlebih dahulu, kita boleh mengarahkannya untuk "memastikan lengan dipanjangkan ke hadapan lebih lama". hanya mudah untuk bimbingan manusia, dan lebih mudah untuk robot belajar.

Memandangkan kelebihan tindakan bahasa di atas, penyelidik dari Google DeepMind mereka bentuk rangka kerja hujung ke hujung - RT-H (Pengubah Robot dengan Hierarki Tindakan, iaitu Transformer robot menggunakan tahap tindakan) , memfokuskan untuk mempelajari tahap tindakan ini. RT-H memahami cara melaksanakan tugas pada tahap terperinci dengan menganalisis pemerhatian dan huraian tugas peringkat tinggi untuk meramalkan arahan tindakan lisan semasa. Kemudian, menggunakan pemerhatian, tugasan dan tindakan lisan yang disimpulkan ini, RT-H meramalkan tindakan yang sepadan untuk setiap langkah Tindakan lisan menyediakan konteks tambahan dalam proses untuk membantu meramalkan tindakan tertentu dengan lebih tepat (kawasan ungu dalam Rajah 1).

Selain itu, mereka membangunkan kaedah automatik untuk mengekstrak set tindakan bahasa yang dipermudahkan daripada proprioception robot, membina pangkalan data yang kaya dengan lebih daripada 2500 tindakan bahasa tanpa memerlukan anotasi manual. Seni bina model

RT-H menggunakan RT-2, yang merupakan model bahasa visual berskala besar (VLM) yang dilatih bersama mengenai data visual dan bahasa berskala Internet untuk meningkatkan kesan pembelajaran dasar. RT-H menggunakan model tunggal untuk mengendalikan kedua-dua tindakan bahasa dan pertanyaan tindakan, memanfaatkan pengetahuan berskala internet yang meluas untuk menggerakkan setiap peringkat hierarki tindakan.

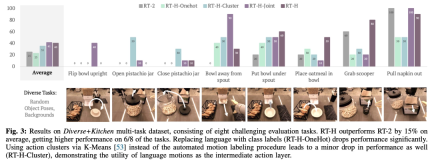

Dalam eksperimen, penyelidik mendapati bahawa menggunakan hierarki tindakan bahasa boleh membawa peningkatan yang ketara apabila memproses set data berbilang tugas yang pelbagai, meningkatkan prestasi sebanyak 15% pada julat tugas berbanding RT-2. Mereka juga mendapati bahawa mengubah suai pergerakan pertuturan menghasilkan kadar kejayaan yang hampir sempurna pada tugas yang sama, menunjukkan fleksibiliti dan kebolehsuaian situasi pergerakan pertuturan yang dipelajari. Tambahan pula, dengan memperhalusi model untuk intervensi tindakan bahasa, prestasinya melebihi kaedah pembelajaran tiruan interaktif SOTA (seperti IWR) sebanyak 50%. Akhirnya, mereka membuktikan bahawa tindakan bahasa dalam RT-H boleh menyesuaikan diri dengan perubahan adegan dan objek dengan lebih baik, menunjukkan prestasi generalisasi yang lebih baik daripada RT-2.

RT-H Architecture Terperinci

Untuk menangkap struktur dikongsi dengan berkesan merentas set data berbilang tugas (tidak diwakili oleh huraian tugas peringkat tinggi), RT-H bertujuan untuk belajar mengeksploitasi dasar peringkat tindakan secara eksplisit.

Secara khusus, pasukan penyelidik memperkenalkan lapisan ramalan tindakan bahasa perantaraan ke dalam pembelajaran dasar. Tindakan linguistik yang menerangkan tingkah laku terperinci robot boleh menangkap maklumat berguna daripada set data berbilang tugas dan boleh menjana dasar berprestasi tinggi. Tindakan lisan boleh dimainkan semula apabila dasar yang dipelajari sukar dilaksanakan: ia menyediakan antara muka intuitif untuk pembetulan manusia dalam talian yang berkaitan dengan senario tertentu. Dasar yang dilatih tentang tindakan pertuturan secara semula jadi boleh mengikut pembetulan manusia peringkat rendah dan berjaya menyelesaikan tugasan yang diberikan data pembetulan. Tambahan pula, strategi ini juga boleh dilatih mengenai data yang diperbetulkan bahasa dan seterusnya meningkatkan prestasinya.

Seperti yang ditunjukkan dalam Rajah 2, RT-H mempunyai dua peringkat utama: pertama meramalkan tindakan lisan berdasarkan penerangan tugasan dan pemerhatian visual, dan kemudian membuat kesimpulan tindakan tepat berdasarkan tindakan lisan yang diramalkan, tugasan khusus dan hasil pemerhatian.

RT-H menggunakan rangkaian tulang belakang VLM dan mengikuti proses latihan RT-2 untuk instantiasi. Sama seperti RT-2, RT-H memanfaatkan pengetahuan terdahulu yang luas dalam bahasa semula jadi dan pemprosesan imej daripada data berskala Internet melalui latihan kolaboratif. Untuk memasukkan pengetahuan terdahulu ini ke dalam semua peringkat hierarki tindakan, model tunggal mempelajari tindakan lisan dan pertanyaan tindakan secara serentak.

Hasil eksperimen

Untuk menilai secara menyeluruh prestasi RT-H, pasukan penyelidik menetapkan empat soalan eksperimen utama:

- S1 (Prestasi): Berapa tahap tindakan dengan bahasa dipertingkatkan? Prestasi dasar pada set data tugas?

- S2 (Situasi): Adakah tindakan bahasa yang dipelajari oleh RT-H berkaitan dengan konteks tugas dan adegan?

- Q3 (Pembetulan): Adakah latihan mengenai pembetulan pergerakan pertuturan lebih baik daripada pembetulan teleoperasi?

- S4 (Ringkasan): Bolehkah hierarki tindakan meningkatkan keteguhan dalam tetapan luar pengedaran?

Dari segi set data, kajian ini menggunakan set data pelbagai tugas yang besar mengandungi 100,000 sampel demonstrasi dengan pose dan latar belakang objek rawak. Set data ini menggabungkan set data berikut:

- Kitchen: set data yang digunakan oleh RT-1 dan RT-2, yang terdiri daripada 6 kategori tugasan semantik daripada 70K sampel.

- Pelbagai: Set data baharu yang terdiri daripada tugasan yang lebih kompleks, dengan lebih daripada 24 kategori tugasan semantik, tetapi hanya 30K sampel.

Kajian ini memanggil set data gabungan ini set data Diverse+Kitchen (D+K) dan menggunakan atur cara automatik untuk melabelkannya untuk tindakan lisan. Untuk menilai prestasi RT-H yang dilatih pada set data Diverse+Kitchen penuh, kajian itu menilai lapan tugas khusus, termasuk:

1) Meletakkan mangkuk tegak di atas kaunter

2) Buka balang pistachio 3) Tutup balang pistachio

7) Dapatkan sudu dari bakul

8) Tarik napkin dari dispenser

Lapan tugasan ini dipilih kerana ia memerlukan urutan pergerakan yang kompleks dan ketepatan yang tinggi.

Jadual di bawah memberikan MSE minimum untuk pusat pemeriksaan latihan RT-H, RT-H-Joint dan RT-2 apabila berlatih pada set data Diverse+Kitchen atau set data Dapur. MSE RT-H adalah lebih kurang 20% lebih rendah daripada RT-2, dan MSE RTH-Joint adalah 5-10% lebih rendah daripada RT-2, menunjukkan bahawa hierarki tindakan boleh membantu meningkatkan ramalan tindakan luar talian dalam berbilang besar. - set data tugas. RT-H (GT) menggunakan metrik MSE kebenaran asas dan mencapai jurang 40% daripada MSE hujung ke hujung, menunjukkan bahawa tindakan bahasa yang dilabel dengan betul mempunyai nilai maklumat yang tinggi untuk meramalkan tindakan.

Rajah 4 menunjukkan beberapa contoh tindakan kontekstual yang diambil daripada penilaian dalam talian RT-H. Seperti yang dapat dilihat, tindakan lisan yang sama sering mengakibatkan perubahan halus dalam tindakan untuk menyelesaikan tugas, sambil tetap menghormati tindakan lisan peringkat lebih tinggi.

Seperti yang ditunjukkan dalam Rajah 5, pasukan penyelidik menunjukkan fleksibiliti RT-H dengan campur tangan dalam talian dengan pergerakan bahasa dalam RT-H. . Sendi mempunyai kesan berbeza pada adegan Perubahan nyata lebih mantap:

Seperti yang ditunjukkan dalam Rajah 5, pasukan penyelidik menunjukkan fleksibiliti RT-H dengan campur tangan dalam talian dengan pergerakan bahasa dalam RT-H. . Sendi mempunyai kesan berbeza pada adegan Perubahan nyata lebih mantap: Malah, terdapat beberapa struktur dikongsi antara tugas yang kelihatan berbeza, contohnya setiap tugasan ini memerlukan beberapa gelagat memilih untuk memulakan tugas, dan dengan mempelajari struktur perkongsian tindakan bahasa merentas tugasan yang berbeza, RT-H boleh mencapai Pick up peringkat tanpa sebarang pembetulan.

Walaupun RT-H tidak lagi dapat menyamaratakan ramalan tindakan lisannya, pembetulan tindakan lisan selalunya boleh digeneralisasikan, jadi hanya beberapa pembetulan diperlukan untuk berjaya menyelesaikan tugasan itu. Ini menunjukkan potensi tindakan lisan untuk mengembangkan pengumpulan data pada tugasan baharu.

Pembaca yang berminat boleh membaca teks asal kertas untuk mengetahui lebih lanjut tentang kandungan penyelidikan.

Atas ialah kandungan terperinci Penyelidikan baharu Google tentang kecerdasan yang terkandung: RT-H, yang lebih baik daripada RT-2, ada di sini. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

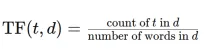

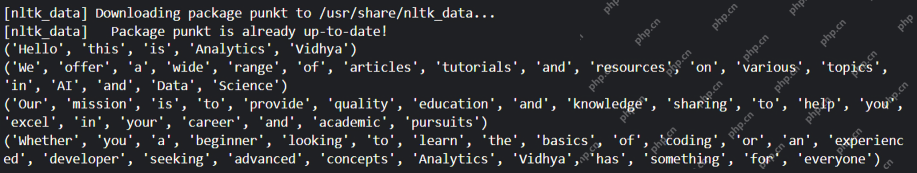

Tukar dokumen teks ke matriks TF-IDF dengan TFIDFVectorizerApr 18, 2025 am 10:26 AM

Tukar dokumen teks ke matriks TF-IDF dengan TFIDFVectorizerApr 18, 2025 am 10:26 AMArtikel ini menerangkan teknik frekuensi frekuensi frekuensi (TF-IDF) istilah, alat penting dalam pemprosesan bahasa semulajadi (NLP) untuk menganalisis data teks. TF-IDF melampaui batasan pendekatan asas beg-perkataan dengan berat TE

Membina Ejen AI Pintar dengan Langchain: Panduan PraktikalApr 18, 2025 am 10:18 AM

Membina Ejen AI Pintar dengan Langchain: Panduan PraktikalApr 18, 2025 am 10:18 AMMelepaskan kuasa ejen AI dengan Langkhain: Panduan Pemula Bayangkan menunjukkan nenek anda keajaiban kecerdasan buatan dengan membiarkannya berbual dengan Chatgpt - kegembiraan di wajahnya sebagai AI dengan mudah terlibat dalam perbualan! Th

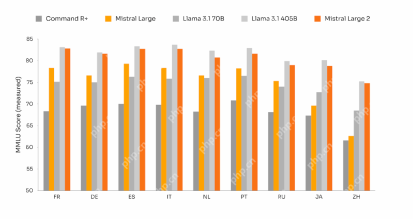

Mistral Besar 2: Cukup kuat untuk mencabar llama 3.1 405b?Apr 18, 2025 am 10:16 AM

Mistral Besar 2: Cukup kuat untuk mencabar llama 3.1 405b?Apr 18, 2025 am 10:16 AMMistral Besar 2: menyelam mendalam ke dalam sumber terbuka AI yang kuat LLM Pelancaran model keluarga Llama 3.1 baru-baru ini dengan cepat diikuti oleh Mistral AI yang membentangkan model terbesarnya sehingga kini: Mistral Large 2. Paramet 123 bilion ini

Apakah jadual bunyi dalam penyebaran stabil? - Analytics VidhyaApr 18, 2025 am 10:15 AM

Apakah jadual bunyi dalam penyebaran stabil? - Analytics VidhyaApr 18, 2025 am 10:15 AMMemahami Jadual Bunyi dalam Model Penyebaran: Panduan Komprehensif Pernahkah anda terpesona oleh visual seni digital yang menakjubkan yang dihasilkan oleh AI dan tertanya -tanya tentang mekanik yang mendasari? Elemen utama ialah "Jadual Kebisingan, & Quo

Bagaimana membina chatbot perbualan dengan GPT-4O? - Analytics VidhyaApr 18, 2025 am 10:06 AM

Bagaimana membina chatbot perbualan dengan GPT-4O? - Analytics VidhyaApr 18, 2025 am 10:06 AMMembina chatbot kontekstual dengan GPT-4O: Panduan Komprehensif Dalam landskap AI dan NLP yang pesat berkembang, chatbots telah menjadi alat yang sangat diperlukan untuk pemaju dan organisasi. Aspek utama untuk mewujudkan sembang yang benar -benar menarik dan cerdas

Rangka Kerja 7 Teratas untuk Membina Ejen AI pada tahun 2025Apr 18, 2025 am 10:00 AM

Rangka Kerja 7 Teratas untuk Membina Ejen AI pada tahun 2025Apr 18, 2025 am 10:00 AMArtikel ini meneroka tujuh kerangka utama untuk membina ejen AI - entiti perisian autonomi yang melihat, memutuskan, dan bertindak untuk mencapai matlamat. Ejen -ejen ini, melepasi pembelajaran pengukuhan tradisional, memanfaatkan perancangan lanjutan dan alasan

Apakah perbezaan antara jenis I dan Jenis II? - Analytics VidhyaApr 18, 2025 am 09:48 AM

Apakah perbezaan antara jenis I dan Jenis II? - Analytics VidhyaApr 18, 2025 am 09:48 AMMemahami Kesalahan Jenis I dan Jenis II dalam Ujian Hipotesis Statistik Bayangkan ujian percubaan klinikal menguji ubat tekanan darah baru. Percubaan itu menyimpulkan bahawa dadah dengan ketara menurunkan tekanan darah, tetapi pada hakikatnya, ia tidak. Ini adalah jenis

Ringkasan Teks Automatik dengan Perpustakaan SumyApr 18, 2025 am 09:37 AM

Ringkasan Teks Automatik dengan Perpustakaan SumyApr 18, 2025 am 09:37 AMSumy: Pembantu Ringkasan AI anda Bosan menyaring dokumen yang tidak berkesudahan? Sumy, perpustakaan Python yang kuat, menawarkan penyelesaian yang diselaraskan untuk ringkasan teks automatik. Artikel ini meneroka keupayaan Sumy, membimbing anda

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

MinGW - GNU Minimalis untuk Windows

Projek ini dalam proses untuk dipindahkan ke osdn.net/projects/mingw, anda boleh terus mengikuti kami di sana. MinGW: Port Windows asli bagi GNU Compiler Collection (GCC), perpustakaan import yang boleh diedarkan secara bebas dan fail pengepala untuk membina aplikasi Windows asli termasuk sambungan kepada masa jalan MSVC untuk menyokong fungsi C99. Semua perisian MinGW boleh dijalankan pada platform Windows 64-bit.

SublimeText3 versi Inggeris

Disyorkan: Versi Win, menyokong gesaan kod!

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Penyesuai Pelayan SAP NetWeaver untuk Eclipse

Integrasikan Eclipse dengan pelayan aplikasi SAP NetWeaver.

PhpStorm versi Mac

Alat pembangunan bersepadu PHP profesional terkini (2018.2.1).

Seperti yang ditunjukkan dalam Rajah 5, pasukan penyelidik menunjukkan fleksibiliti RT-H dengan campur tangan dalam talian dengan pergerakan bahasa dalam RT-H. . Sendi mempunyai kesan berbeza pada adegan Perubahan nyata lebih mantap:

Seperti yang ditunjukkan dalam Rajah 5, pasukan penyelidik menunjukkan fleksibiliti RT-H dengan campur tangan dalam talian dengan pergerakan bahasa dalam RT-H. . Sendi mempunyai kesan berbeza pada adegan Perubahan nyata lebih mantap: