Rumah >Peranti teknologi >AI >OccFusion: Rangka kerja gabungan berbilang sensor yang mudah dan berkesan untuk Occ (Prestasi SOTA)

OccFusion: Rangka kerja gabungan berbilang sensor yang mudah dan berkesan untuk Occ (Prestasi SOTA)

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBke hadapan

- 2024-03-08 11:50:03857semak imbas

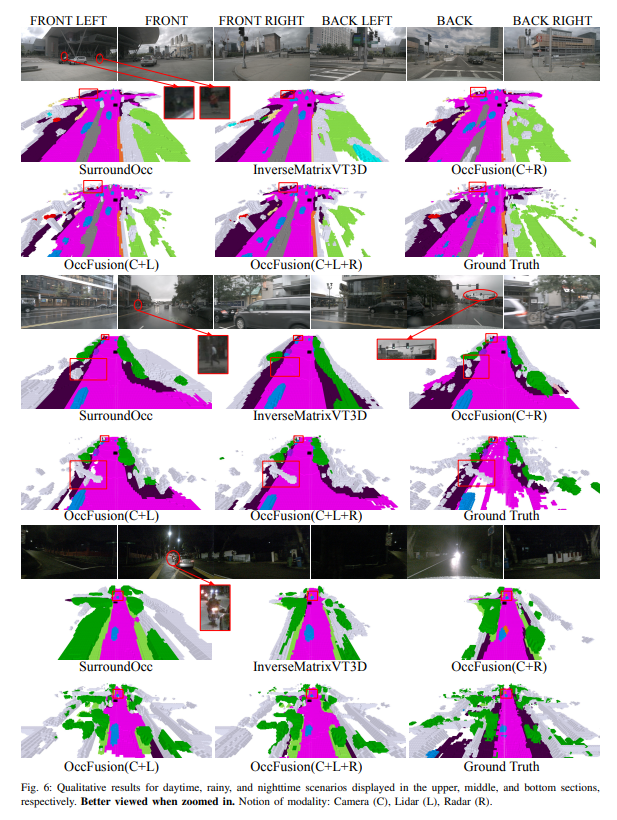

Pemahaman menyeluruh tentang adegan 3D adalah penting dalam pemanduan autonomi, dan model ramalan penghunian semantik 3D terkini telah berjaya menangani cabaran untuk menerangkan objek dunia sebenar dengan bentuk dan kategori yang berbeza. Walau bagaimanapun, kaedah ramalan penghunian 3D sedia ada banyak bergantung pada imej kamera panoramik, yang menjadikannya mudah terdedah kepada perubahan dalam keadaan pencahayaan dan cuaca. Dengan menyepadukan keupayaan penderia tambahan seperti lidar dan radar pandangan sekeliling, rangka kerja kami meningkatkan ketepatan dan keteguhan ramalan penghunian, menghasilkan prestasi terbaik pada penanda aras nuScenes. Tambahan pula, eksperimen yang meluas pada set data nuScene, termasuk adegan waktu malam dan hujan yang mencabar, mengesahkan prestasi unggul strategi gabungan sensor kami merentas pelbagai julat penderiaan.

Pautan kertas: https://arxiv.org/pdf/2403.01644.pdf

Nama kertas: OccFusion: A Straightforward and Effective Multi-Sensor Fusion Framework for 3D Occupancy Prediction

Sumbangan utama artikel ini diringkaskan seperti berikut :

- Rangka kerja gabungan berbilang sensor dicadangkan untuk menyepadukan maklumat kamera, lidar dan radar untuk melaksanakan tugas ramalan penghunian semantik 3D.

- Dalam tugas ramalan penghunian semantik 3D, kaedah kami dibandingkan dengan algoritma tercanggih (SOTA) lain untuk menunjukkan kelebihan gabungan berbilang sensor.

- Kajian ablasi menyeluruh telah dijalankan untuk menilai peningkatan prestasi yang dicapai oleh kombinasi sensor yang berbeza di bawah pencahayaan yang mencabar dan keadaan cuaca seperti malam dan hujan.

- Kajian komprehensif telah dijalankan untuk menganalisis kesan faktor julat persepsi terhadap prestasi rangka kerja kami dalam tugas ramalan penghunian semantik 3D, dengan mengambil kira pelbagai kombinasi penderia dan senario yang mencabar!

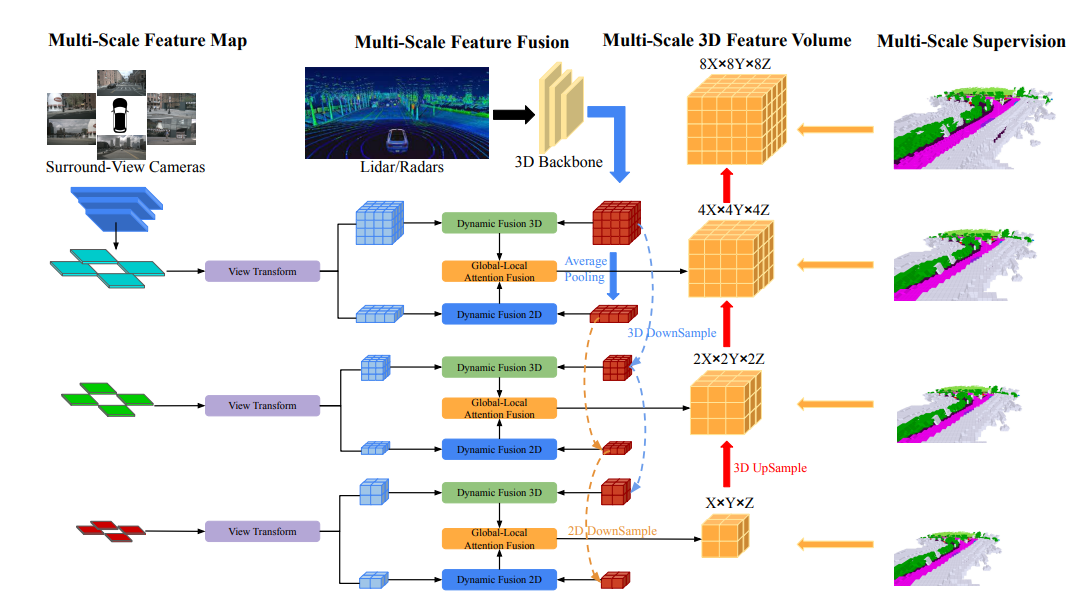

Gambaran keseluruhan struktur rangkaian

Seni bina keseluruhan OccFusion adalah seperti berikut. Pertama, imej paparan sekeliling dimasukkan ke dalam tulang belakang 2D untuk mengekstrak ciri berbilang skala. Selepas itu, transformasi paparan dilakukan pada setiap skala untuk mendapatkan ciri BEV global dan volum ciri 3D tempatan pada setiap peringkat. Awan titik 3D yang dijana oleh lidar dan radar sekeliling juga dimasukkan ke dalam tulang belakang 3D untuk menjana kuantiti ciri 3D tempatan berbilang skala dan ciri BEV global. Modul gabungan dinamik 3D/2D pada setiap peringkat menggabungkan keupayaan kamera dan lidar/radar. Selepas ini, gabungan ciri BEV global dan volum ciri 3D tempatan pada setiap peringkat dimasukkan ke dalam gabungan perhatian global-tempatan untuk menjana volum 3D akhir pada setiap skala. Akhir sekali, volum 3D pada setiap peringkat ditingkatkan dan disambungkan langkau dengan mekanisme penyeliaan berbilang skala.

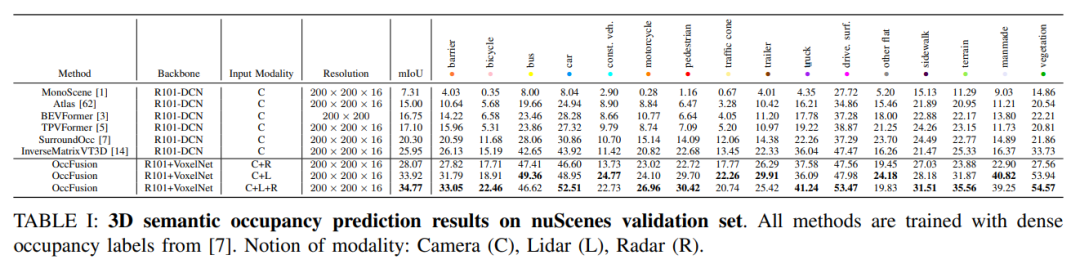

Analisis perbandingan eksperimen

Pada set pengesahan nuScenes, hasil pelbagai kaedah berdasarkan latihan label penghunian padat dalam ramalan penghunian semantik 3D ditunjukkan. Kaedah ini melibatkan konsep modal yang berbeza termasuk kamera (C), lidar (L) dan radar (R).

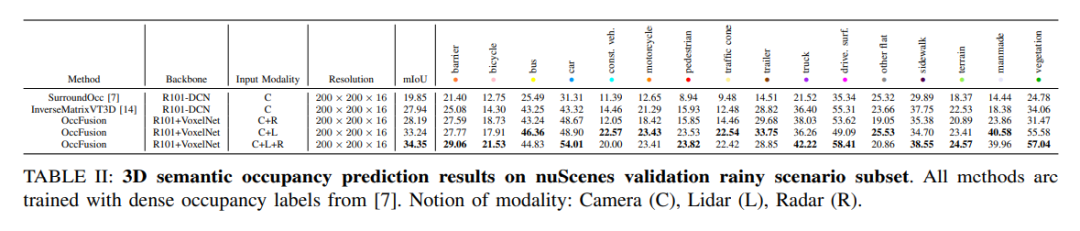

Pada subset kejadian hujan bagi set data nuScenes, kami meramalkan penghunian semantik 3D dan menggunakan label penghunian padat untuk latihan. Dalam eksperimen ini, kami mempertimbangkan data daripada modaliti yang berbeza seperti kamera (C), lidar (L), radar (R), dsb. Gabungan mod ini boleh membantu kami lebih memahami dan meramalkan adegan hujan, memberikan rujukan penting untuk pembangunan sistem pemanduan autonomi.

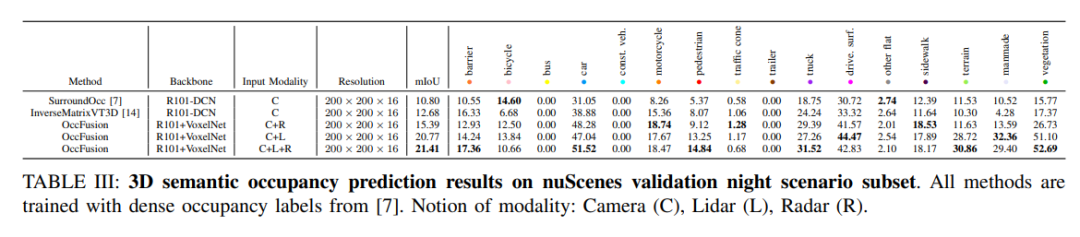

nuScenes mengesahkan keputusan ramalan penghunian semantik 3D untuk subset adegan waktu malam. Semua kaedah dilatih menggunakan label penghunian padat. Konsep modal: kamera (C), lidar (L), radar (R).

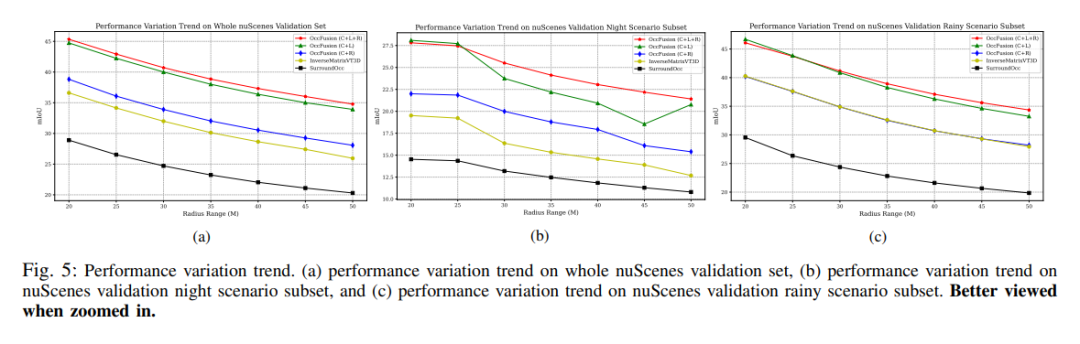

Trend perubahan prestasi. (a) Trend perubahan prestasi bagi keseluruhan set pengesahan nuScenes, (b) subset adegan malam pengesahan nuScenes, dan (c) trend perubahan prestasi pengesahan nuScene bagi subset pemandangan hujan.

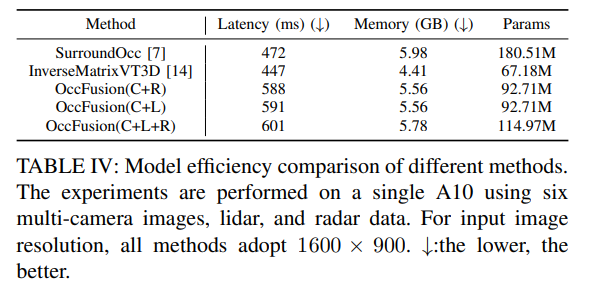

Jadual 4: Perbandingan kecekapan model kaedah yang berbeza. Eksperimen telah dijalankan pada A10 menggunakan enam imej berbilang kamera, data lidar dan radar. Untuk resolusi imej input, 1600×900 digunakan untuk semua kaedah. ↓:Lebih rendah lebih baik.

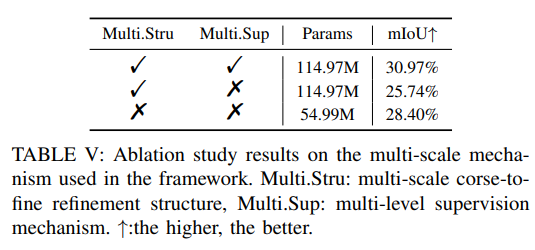

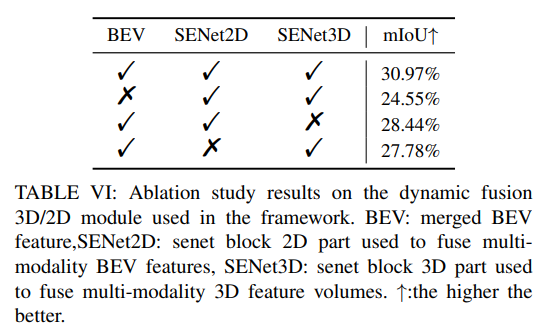

Lebih banyak eksperimen ablasi:

Atas ialah kandungan terperinci OccFusion: Rangka kerja gabungan berbilang sensor yang mudah dan berkesan untuk Occ (Prestasi SOTA). Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!