Rumah >Peranti teknologi >AI >Untuk mengimbangi kelemahan perancangan Transformer, Searchformer pasukan Tian Yuandong menjadi popular

Untuk mengimbangi kelemahan perancangan Transformer, Searchformer pasukan Tian Yuandong menjadi popular

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBke hadapan

- 2024-02-26 08:01:22724semak imbas

Keupayaan generalisasi yang berkuasa Transformer telah terbukti sekali lagi!

Dalam beberapa tahun kebelakangan ini, struktur berasaskan Transformer telah menarik perhatian global kerana prestasi cemerlangnya dalam pelbagai tugas. Menggunakan struktur ini dan menggabungkannya dengan jumlah data yang besar, model yang terhasil seperti model bahasa besar (LLM) boleh disesuaikan dengan baik kepada senario aplikasi praktikal.

Walaupun kejayaan mereka dalam beberapa bidang, seni bina berasaskan Transformer dan LLM masih menghadapi cabaran, terutamanya dalam mengendalikan tugas perancangan dan inferens. Penyelidikan terdahulu telah menunjukkan bahawa LLM menghadapi kesukaran dalam menangani tugas perancangan berbilang langkah atau tugas penaakulan peringkat tinggi.

Untuk meningkatkan penaakulan dan prestasi perancangan Transformer, komuniti penyelidik juga telah mencadangkan beberapa kaedah dalam beberapa tahun kebelakangan ini. Salah satu kaedah yang paling biasa dan berkesan ialah mensimulasikan proses pemikiran manusia: mula-mula menjana "pemikiran" perantaraan dan kemudian mengeluarkan respons. Sebagai contoh, kaedah penggerak Rantaian Pemikiran (CoT) menggalakkan model untuk meramalkan langkah perantaraan dan melakukan "berfikir" langkah demi langkah. Pohon pemikiran (ToT) menggunakan strategi percabangan dan kaedah penilaian untuk membolehkan model menjana berbilang laluan pemikiran yang berbeza, dan kemudian memilih laluan terbaik daripadanya. Walaupun teknik ini selalunya berkesan, penyelidikan telah menunjukkan bahawa dalam banyak kes kaedah ini merendahkan prestasi model disebabkan oleh sebab termasuk penguatkuasaan kendiri.

Sesuatu teknik yang berprestasi baik pada satu set data mungkin tidak berfungsi dengan baik pada set data lain. Ini mungkin disebabkan oleh perubahan dalam jenis penaakulan yang diperlukan, seperti peralihan daripada penaakulan spatial kepada matematik atau akal sehat.

Sebaliknya, perancangan simbolik tradisional dan teknik carian menunjukkan keupayaan penaakulan yang sangat baik. Tambahan pula, penyelesaian yang dikira oleh kaedah tradisional ini selalunya mempunyai jaminan formal, kerana algoritma perancangan simbolik biasanya mengikut proses carian berasaskan peraturan yang jelas.

Untuk melengkapkan Transformer dengan keupayaan penaakulan yang kompleks, pasukan Meta FAIR Tian Yuandong baru-baru ini mencadangkan Searchformer.

paper Tajuk: Beyond A*: Perancangan yang lebih baik dengan Transformers melalui Dynamics Bootstrapping Adress: https://arxiv.org/pdf/2402.14083.pdf

searchformer adalah pengubah model, tetapi untuk tugas perancangan berbilang langkah seperti navigasi maze dan menolak kotak, ia boleh mengira pelan optimum dan bilangan langkah carian yang digunakan boleh jauh lebih rendah daripada algoritma perancangan simbolik seperti carian A*.

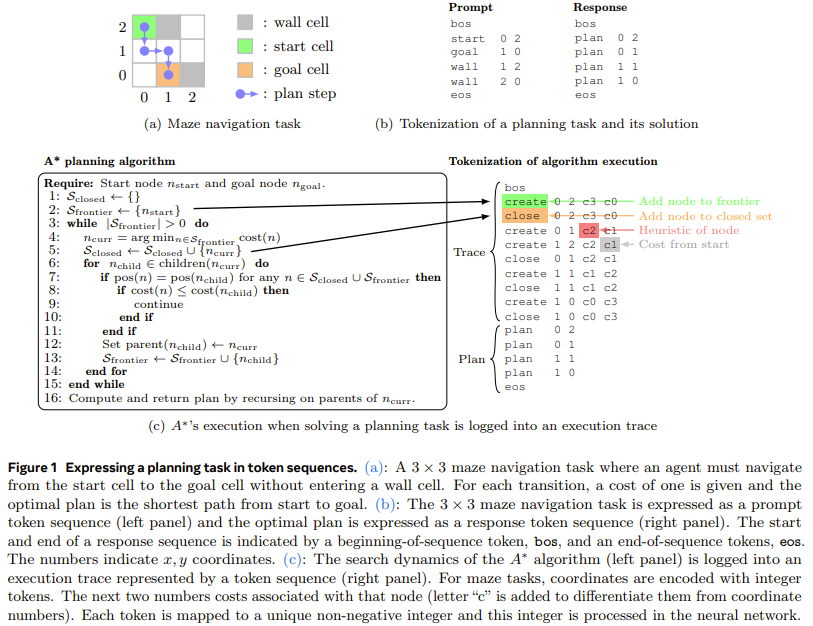

Untuk melakukan ini, pasukan mencadangkan kaedah baharu: dinamik carian bootstrapping. Kaedah ini mula-mula melatih model Transformer untuk meniru proses carian A* (seperti yang ditunjukkan dalam Rajah 1), dan kemudian memperhalusinya supaya ia dapat mencari pelan optimum dengan langkah carian yang lebih sedikit

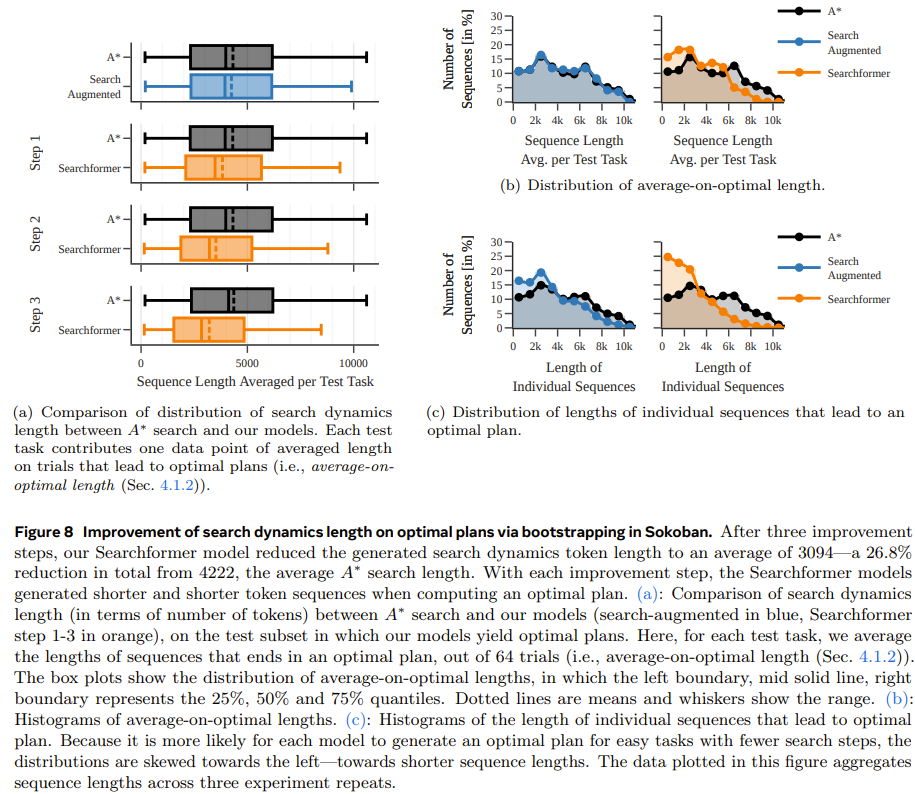

Langkah kedua ialah menggunakan kaedah lelaran pakar untuk menambah baik lagi latihan menggunakan urutan dipertingkatkan carian di atas (termasuk trajektori pelaksanaan A*). . Kaedah lelaran pakar membolehkan Transformer menjana penyelesaian optimum dengan langkah carian yang lebih sedikit Proses ini menghasilkan algoritma pengaturcaraan saraf yang dikodkan secara tersirat dalam pemberat rangkaian Transformer dan mempunyai Kebarangkalian yang tinggi untuk mencari pelan optimum dengan langkah carian yang lebih sedikit Carian A* Sebagai contoh, apabila melakukan tugas menolak kotak, model baharu boleh menyelesaikan 93.7% daripada tugasan ujian, manakala bilangan langkah carian adalah 26.8% kurang daripada carian A* secara purata cara untuk Transformer mengatasi algoritma perancangan simbolik tradisional

Langkah kedua ialah menggunakan kaedah lelaran pakar untuk menambah baik lagi latihan menggunakan urutan dipertingkatkan carian di atas (termasuk trajektori pelaksanaan A*). . Kaedah lelaran pakar membolehkan Transformer menjana penyelesaian optimum dengan langkah carian yang lebih sedikit Proses ini menghasilkan algoritma pengaturcaraan saraf yang dikodkan secara tersirat dalam pemberat rangkaian Transformer dan mempunyai Kebarangkalian yang tinggi untuk mencari pelan optimum dengan langkah carian yang lebih sedikit Carian A* Sebagai contoh, apabila melakukan tugas menolak kotak, model baharu boleh menyelesaikan 93.7% daripada tugasan ujian, manakala bilangan langkah carian adalah 26.8% kurang daripada carian A* secara purata cara untuk Transformer mengatasi algoritma perancangan simbolik tradisional

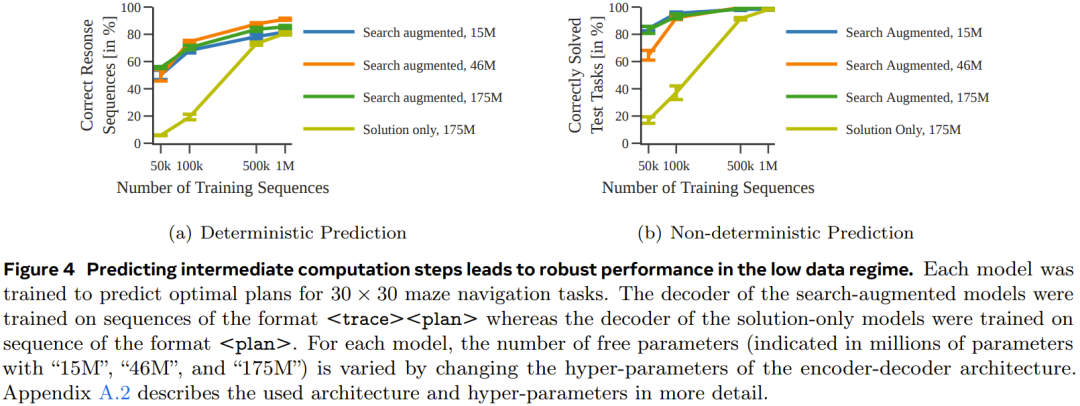

Untuk lebih memahami kesan data latihan dan volum parameter model terhadap prestasi model yang dihasilkan, mereka menjalankan beberapa kajian ablasi

Mereka menggunakan dua jenis set data untuk melatih model: satu mempunyai urutan token yang hanya mengandungi penyelesaian (penyelesaian sahaja, yang hanya mempunyai penerangan tugasan dan pelan akhir); perancangan akhir). Dalam percubaan, pasukan menggunakan varian carian A* yang deterministik dan bukan untuk menjana setiap set data urutan

Navigasi labirinDalam percubaan pertama, pasukan melatih satu set pengekod-penyahkod model Transformer untuk meramalkan laluan optimum dalam labirin 30×30

Rajah 4 menunjukkan bahawa dengan meramalkan langkah pengiraan pertengahan, prestasi yang lebih mantap boleh dicapai apabila jumlah data adalah kecil.

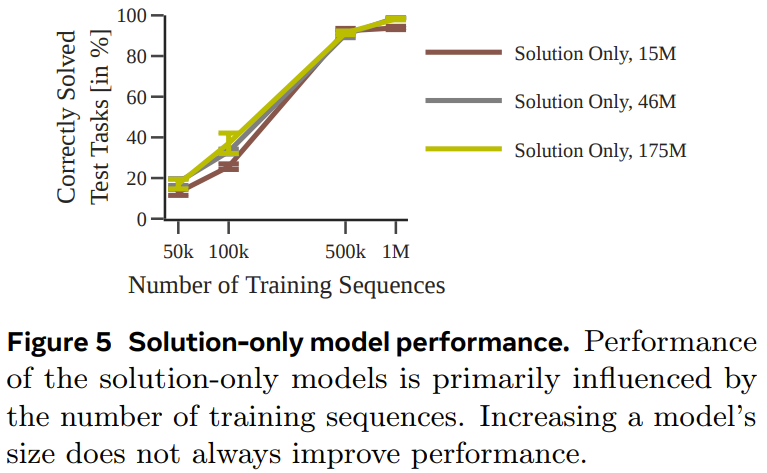

Rajah 5 memberikan prestasi model yang dilatih hanya menggunakan penyelesaian.

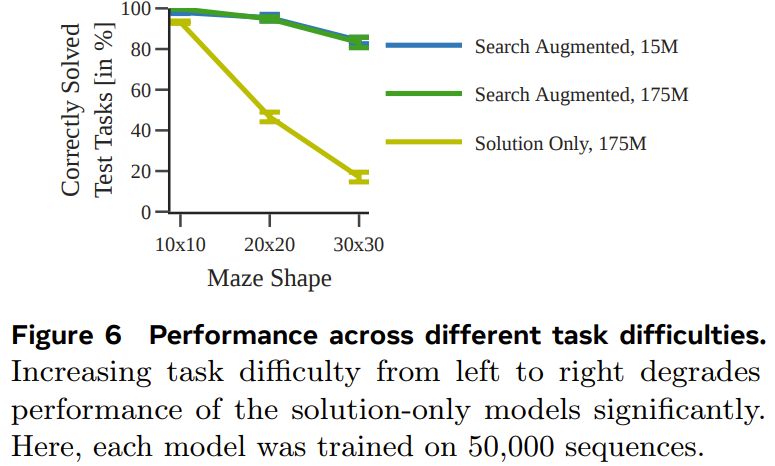

Rajah 6 menunjukkan kesan kesukaran tugasan terhadap prestasi setiap model.

Secara keseluruhan, walaupun model yang dilatih menggunakan hanya penyelesaian boleh meramalkan pelan optimum apabila set data latihan yang digunakan cukup besar dan cukup pelbagai, apabila jumlah data adalah kecil, model yang dipertingkatkan carian mempunyai Prestasi adalah ketara. lebih baik dan skala yang lebih baik untuk tugas yang lebih sukar juga.

Menolak kotak

Untuk menguji sama ada hasil yang serupa boleh diperolehi pada tugas yang berbeza dan lebih kompleks (dengan mod tokenisasi yang berbeza), pasukan itu juga menjana set data perancangan kotak menolak untuk ujian .

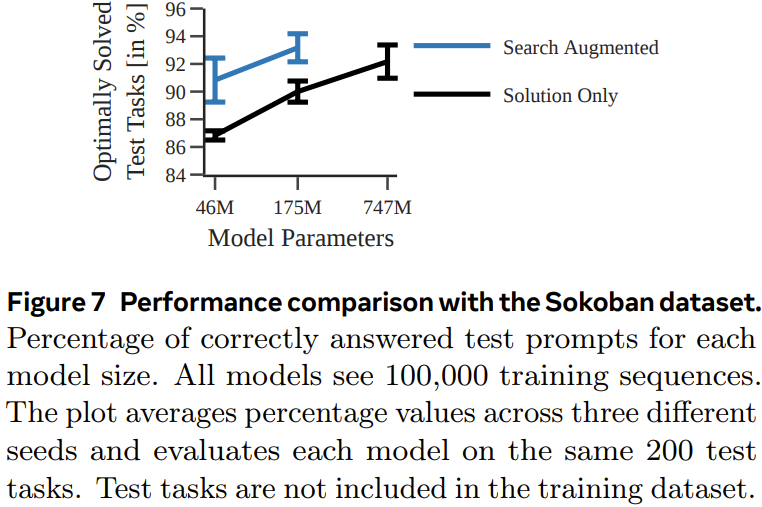

Rajah 7 menunjukkan kebarangkalian setiap model menjana pelan yang betul untuk setiap tugasan ujian.

Adalah dapat dilihat bahawa, seperti percubaan sebelumnya, dengan melatih menggunakan jejak pelaksanaan, model yang dipertingkatkan carian mengatasi prestasi model yang dilatih hanya menggunakan penyelesaian.

Searchformer: Meningkatkan dinamik carian melalui bootstrapping

Sebagai percubaan terakhir, pasukan menyiasat cara model yang dipertingkatkan carian boleh dipertingkatkan secara berulang untuk mengira pelan optimum dengan langkah carian yang lebih sedikit. Matlamat di sini adalah untuk memendekkan panjang trajektori carian sementara masih memperoleh penyelesaian yang optimum.

Rajah 8 menunjukkan bahawa kaedah panduan dinamik carian yang baru dicadangkan boleh memendekkan panjang jujukan yang dijana oleh model Searchformer secara berulang.

Atas ialah kandungan terperinci Untuk mengimbangi kelemahan perancangan Transformer, Searchformer pasukan Tian Yuandong menjadi popular. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Memperkasakan industri fesyen dengan teknologi untuk membantu Daerah Futian membina 'Pusat Ibu Pejabat Fesyen Bay Area'

- Mengambil 'Exhibition Express', Qingdao Artificial Intelligence Industrial Park meneroka cara baharu untuk menarik pelaburan

- Ronglian Cloud telah dipilih ke dalam Peta Industri AI Generatif Global 2023

- Memfokuskan pada ekosistem perniagaan digital dan industri metaverse, Lujiazui Digital Intelligence World berusaha untuk mencipta kluster industri elemen data

- Robot ETF (159770): Menarik aliran masuk modal bersih selama 4 hari berturut-turut, 'Pendapat Panduan tentang Inovasi dan Pembangunan Robot Humanoid' mungkin menggalakkan proses pembangunan industri