Peranti teknologi

Peranti teknologi AI

AI Mistral-Medium secara tidak sengaja bocor? Model misteri yang berjaya dalam senarai ini telah menyebabkan banyak perbincangan dalam komuniti AI.

Mistral-Medium secara tidak sengaja bocor? Model misteri yang berjaya dalam senarai ini telah menyebabkan banyak perbincangan dalam komuniti AI.Mistral-Medium secara tidak sengaja bocor? Model misteri yang berjaya dalam senarai ini telah menyebabkan banyak perbincangan dalam komuniti AI.

"Saya kini 100% yakin bahawa Miqu dan Mistral-Medium di Perplexity Labs adalah model yang sama

Baru-baru ini, sekeping berita tentang "kebocoran model Mistral-Medium" telah menarik perhatian semua orang.

Menurut khabar angin, berita bocor tentang model baharu yang dipanggil "Miqu" berkaitan dengan EQ-Bench, penanda aras untuk menilai kecerdasan emosi model bahasa. Menurut data yang berkaitan, korelasi antara EQ-Bench dan MMLU adalah kira-kira 0.97, dan korelasi dengan Arena Elo ialah kira-kira 0.94. Menariknya, Miqu secara langsung mengatasi semua model besar kecuali GPT-4 dalam penilaian penanda aras ini, dan skornya sangat hampir dengan Mistral-Medium. Berita ini menarik perhatian dan perbincangan yang meluas.

Sumber gambar: https://x.com/N8Programs/status/1752441060133892503?s=20

Alamat sumber terbuka: https://miqugging1face.co

Untuk model yang begitu berkuasa, penerbit projek itu adalah seorang yang misteri:

Seseorang bertanya "siapa yang menjadikan awak", Miqu terus melaporkan dirinya: "Saya dicipta oleh pasukan Mistral Al."

Seseorang menghantar soalan ujian yang sama kepada kedua-dua model, dan jawapan yang diterima semuanya dalam bahasa Rusia. Penguji itu menambah syak wasangkanya: "Ia seolah-olah tahu teka-teki standard, tetapi jika ia adalah seorang pelawak, adalah mustahil untuk menyesuaikannya untuk menjawab dalam bahasa Rusia

Dalam proses terjemahan, ungkapannya hampir sama." .

Dari mana asalnya Miqu? Adakah ia benar-benar Mistral-Medium?

Dalam perbincangan hangat yang berlangsung selama dua hari, ramai pembangun membandingkan kedua-dua model tersebut menunjukkan kemungkinan berikut:

1 Miqu adalah Mistral-Medium

2. tetapi beberapa versi eksperimen awal atau versi lain

3 Miqu ialah versi Llama2 yang diperhalusi.

Terdahulu, kami memperkenalkan alasan yang diberikan oleh pembangun yang menyokong kemungkinan pertama. Apabila insiden itu berlaku, lebih ramai pembangun terlibat dalam operasi penyahsulitan dan menjalankan ujian yang lebih mendalam pada kedua-dua model. Ujian yang dijalankan oleh pengguna reddit yang berjaga lewat menunjukkan bahawa Miqu lebih seperti versi awal model MistralAI.

Pemaju menggunakan model tersebut pada empat latihan/peperiksaan perlindungan data dalam talian profesional dalam bahasa Jerman. Data ujian, soalan dan semua arahan adalah dalam bahasa Jerman, manakala kad aksara dalam bahasa Inggeris. Ini menguji kemahiran terjemahan dan pemahaman merentas bahasa.

Kaedah ujian khusus adalah seperti berikut:

Arahkan model dalam bahasa Jerman sebelum memberikan maklumat: "Saya akan memberi anda beberapa maklumat, sila beri perhatian kepada maklumat ini, tetapi apabila menjawab, hanya gunakan "OK" untuk mengesahkan bahawa anda faham, jangan Berkata lebih "Ini adalah untuk menguji keupayaan model untuk memahami dan melaksanakan arahan.

Selepas memberikan semua maklumat mengenai topik, tanyakan soalan model. Ini ialah soalan aneka pilihan (A/B/C) di mana soalan pertama dan terakhir adalah sama tetapi susunan pilihan dan huruf (X/Y/Z) ditukar. Setiap ujian mengandungi 4-6 soalan, dengan jumlah 18 soalan aneka pilihan.

Diperingkat berdasarkan bilangan jawapan betul yang diberikan oleh model, mula-mula mempertimbangkan jawapan selepas maklumat kursus diberikan, dan kedua jawapan dijawab secara membuta tuli tanpa memberikan maklumat terlebih dahulu, sekiranya berlaku seri. Semua ujian adalah unit bebas, konteks dikosongkan antara setiap ujian dan tiada memori atau keadaan dikekalkan antara sesi.

Laporan ujian terperinci adalah seperti berikut:

miqudev/miqu-1-70b GGUF Q5_K_M, konteks 32K, format Mistral: hanya jawapan yang betul diberikan untuk 4+4+4+5=17/18 berbilang- soalan pilihan. Tanpa maklumat terdahulu, jawab sahaja soalan dan berikan jawapan yang betul: 4+3+1+5=13/18. Kemasukan data tidak disahkan dengan "OK" seperti yang diarahkan.

Semasa ujian, pembangun mendapati bahawa Miqu mempunyai banyak persamaan dengan Mixtral: ejaan dan tatabahasa Jerman dwibahasa yang sangat baik menambahkan terjemahan pada balasan;

Walau bagaimanapun, dalam ujian pembangun ini, Miqu berprestasi lebih teruk daripada Mixtral-8x7B-Instruct-v0.1 (4-bit), dan masih lebih baik daripada Mistral Small and Medium. Tetapi ia tidak jauh lebih baik daripada Mixtral 8x7B Instruct. Pembangun membuat spekulasi bahawa Miqu mungkin model MistralAI yang bocor, model yang lebih lama, mungkin bukti konsep.

Ini adalah ujian paling terperinci yang kami lihat setakat ini menyokong tuntutan kedua.

Walau bagaimanapun, sesetengah pembangun percaya bahawa Miqu tidak ada kaitan dengan MistralAI, tetapi lebih seperti Llama 70B, kerana seni binanya "betul-betul sama" dengan Llama 70B dan "bukan model hibrid pakar."

Begitu juga, beberapa orang mendapati selepas menguji bahawa Miqu memang lebih seperti Llama:

Tetapi jika dilihat dari perbezaan skor, Miqu dan Llama 70B jelas bukan model yang sama.

Jadi, seseorang membuat kesimpulan bahawa sama ada Miqu ialah versi Llama yang diperhalusi atau versi awal Mistral-Medium:

Jika yang pertama benar, Miqu mungkin Llama 70B yang ditala dengan baik pada Set data Mistral-Medium :

Jika yang terakhir itu benar, Miqu hanyalah penyulingan Mistral API, ini mungkin sandiwara pada tahap "pendaratan bulan palsu Amerika":

Soalan terakhir, siapa pembocor?

Menurut petunjuk yang diberikan oleh ramai pengguna platform X, model yang disyaki bocor itu pada asalnya disiarkan di laman web bernama 4chan. Laman web ini ialah forum pemesejan masa nyata tanpa nama sepenuhnya di mana pengguna boleh menyiarkan komen grafik dan teks tanpa mendaftar.

Sudah tentu kesimpulan ini subjektif. Bagi semua penyelidik AI, gelombang drama ini memerlukan "kebenaran" untuk ditamatkan.

Pautan rujukan: https://www.reddit.com/r/LocalLLaMA/comments/1af4fbg/llm_comparisontest_miqu170b/

Atas ialah kandungan terperinci Mistral-Medium secara tidak sengaja bocor? Model misteri yang berjaya dalam senarai ini telah menyebabkan banyak perbincangan dalam komuniti AI.. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Apakah model Power Bi Semantik?Apr 15, 2025 am 10:46 AM

Apakah model Power Bi Semantik?Apr 15, 2025 am 10:46 AMPengenalan Bayangkan senario: Pasukan anda dibanjiri oleh dataset besar -besaran dari pelbagai sumber. Mengintegrasikan, menyusun, dan menganalisis maklumat ini untuk persembahan yang bermakna adalah satu cabaran. Di sinilah Model Power Bi Semantik (PBISM) EX

Cara Membina Ejen AI Menggunakan Indeks Llama dan MonsterapiApr 15, 2025 am 10:44 AM

Cara Membina Ejen AI Menggunakan Indeks Llama dan MonsterapiApr 15, 2025 am 10:44 AMEjen AI: Masa Depan AI, Dikuasakan oleh Llamaindex dan Monsterapi Ejen AI bersedia untuk merevolusikan bagaimana kita berinteraksi dengan teknologi. Sistem autonomi ini meniru tingkah laku manusia, melaksanakan tugas yang memerlukan pemikiran, membuat keputusan, dan rea

7 cara untuk melatih LLM tanpa campur tangan manusiaApr 15, 2025 am 10:38 AM

7 cara untuk melatih LLM tanpa campur tangan manusiaApr 15, 2025 am 10:38 AMMembuka kunci AI AI: 7 Kaedah untuk LLMS Latihan Sendiri Bayangkan masa depan di mana sistem AI belajar dan berkembang tanpa campur tangan manusia, seperti kanak -kanak yang menguasai konsep kompleks secara bebas. Ini bukan fiksyen sains; itu janji diri

Mengubah Pelaporan Kewangan dengan AI dan NLG - Analytics VidhyaApr 15, 2025 am 10:35 AM

Mengubah Pelaporan Kewangan dengan AI dan NLG - Analytics VidhyaApr 15, 2025 am 10:35 AMPelaporan Kewangan berkuasa AI: merevolusikan pandangan melalui generasi bahasa semula jadi Dalam persekitaran perniagaan dinamik hari ini, analisis kewangan yang tepat dan tepat pada masanya adalah penting untuk membuat keputusan strategik. Pelaporan kewangan tradisional

Adakah robot Google Deepmind ini akan bermain di Sukan Olimpik 2028?Apr 15, 2025 am 10:16 AM

Adakah robot Google Deepmind ini akan bermain di Sukan Olimpik 2028?Apr 15, 2025 am 10:16 AMRobot Tenis Jadual Google Deepmind: Era Baru dalam Sukan dan Robotik Sukan Olimpik Paris 2024 mungkin berakhir, tetapi era baru dalam sukan dan robotik adalah berkemungkinan, terima kasih kepada Google Deepmind. Penyelidikan terobosan mereka ("Mencapai Kompet Tahap Manusia

Membina WebApp Wawasan Makanan dengan Model Gemini Flash 1.5Apr 15, 2025 am 10:15 AM

Membina WebApp Wawasan Makanan dengan Model Gemini Flash 1.5Apr 15, 2025 am 10:15 AMMembuka Kecekapan dan Skala dengan Gemini Flash 1.5: WebApp Wawasan Makanan Flask Dalam landskap AI yang pesat berkembang, kecekapan dan skalabiliti adalah yang paling utama. Pemaju semakin mencari model berprestasi tinggi yang meminimumkan kos dan latenc

Melaksanakan ejen AI menggunakan llamaindexApr 15, 2025 am 10:11 AM

Melaksanakan ejen AI menggunakan llamaindexApr 15, 2025 am 10:11 AMMemanfaatkan kuasa agen AI dengan llamaindex: panduan langkah demi langkah Bayangkan pembantu peribadi yang memahami permintaan anda dan melaksanakannya dengan sempurna, sama ada pengiraan cepat atau mengambil berita pasaran terkini. Artikel ini meneroka

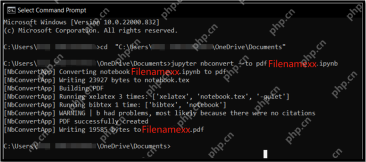

5 kaedah untuk menukar fail .ipynb ke pdf- analitik vidhyaApr 15, 2025 am 10:06 AM

5 kaedah untuk menukar fail .ipynb ke pdf- analitik vidhyaApr 15, 2025 am 10:06 AMFail Notebook Jupyter (.iPynb) digunakan secara meluas dalam analisis data, pengkomputeran saintifik, dan pengekodan interaktif. Walaupun buku nota ini bagus untuk membangun dan berkongsi kod dengan saintis data lain, kadang -kadang anda perlu mengubahnya menjadi format yang lebih umum, seperti PDF. Panduan ini akan membimbing anda melalui pelbagai cara untuk menukar fail .ipynb ke PDF, serta petua, amalan terbaik, dan cadangan penyelesaian masalah. Jadual Kandungan Mengapa menukar .ipynb ke pdf? Cara menukar fail .ipynb ke pdf Menggunakan UI Notebook Jupyter Menggunakan NBConve

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

VSCode Windows 64-bit Muat Turun

Editor IDE percuma dan berkuasa yang dilancarkan oleh Microsoft

EditPlus versi Cina retak

Saiz kecil, penyerlahan sintaks, tidak menyokong fungsi gesaan kod

SublimeText3 Linux versi baharu

SublimeText3 Linux versi terkini

Dreamweaver CS6

Alat pembangunan web visual

DVWA

Damn Vulnerable Web App (DVWA) ialah aplikasi web PHP/MySQL yang sangat terdedah. Matlamat utamanya adalah untuk menjadi bantuan bagi profesional keselamatan untuk menguji kemahiran dan alatan mereka dalam persekitaran undang-undang, untuk membantu pembangun web lebih memahami proses mengamankan aplikasi web, dan untuk membantu guru/pelajar mengajar/belajar dalam persekitaran bilik darjah Aplikasi web keselamatan. Matlamat DVWA adalah untuk mempraktikkan beberapa kelemahan web yang paling biasa melalui antara muka yang mudah dan mudah, dengan pelbagai tahap kesukaran. Sila ambil perhatian bahawa perisian ini