Rumah >Peranti teknologi >AI >Stability AI mengeluarkan model 3B kod stabil yang menyokong larian tempatan dan tiada GPU diperlukan

Stability AI mengeluarkan model 3B kod stabil yang menyokong larian tempatan dan tiada GPU diperlukan

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBke hadapan

- 2024-01-17 16:03:061073semak imbas

Stability AI baru-baru ini mengeluarkan model AI pertamanya pada tahun 2024, yang dipanggil Stable Code 3B. Model ini mempunyai 3 bilion parameter dan memfokuskan pada tugas kod tambahan.

Jalankan secara asli pada komputer riba tanpa memerlukan GPU khusus, sambil tetap memberikan prestasi kompetitif dengan model besar seperti CodeLLaMA 7B Meta.

Pada penghujung tahun 2023, Stability AI mula mempromosikan pembangunan model yang lebih kecil, lebih padat dan lebih berkuasa, seperti model StableLM Zephyr 3B untuk penjanaan teks.

Pada awal tahun 2024, Stability AI mengeluarkan model bahasa penting yang dipanggil Stable Code 3B. Malah, versi pratontonnya, Stable Code Alpha 3B, telah dikeluarkan seawal Ogos tahun lalu. Sejak itu, Stability AI terus meningkatkan teknologi. Versi baharu Kod Stable 3B ini direka untuk pelengkapan kod dan juga mempunyai pelbagai ciri tambahan.

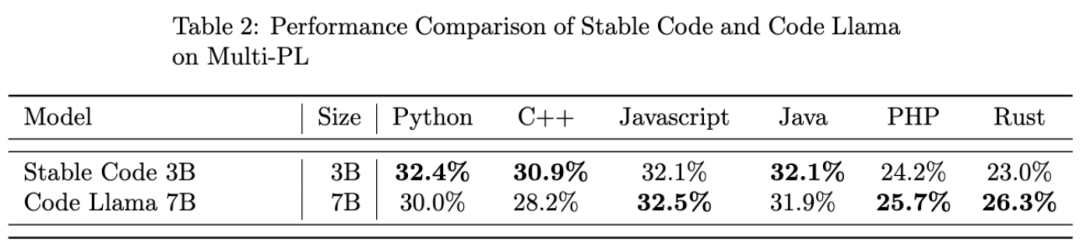

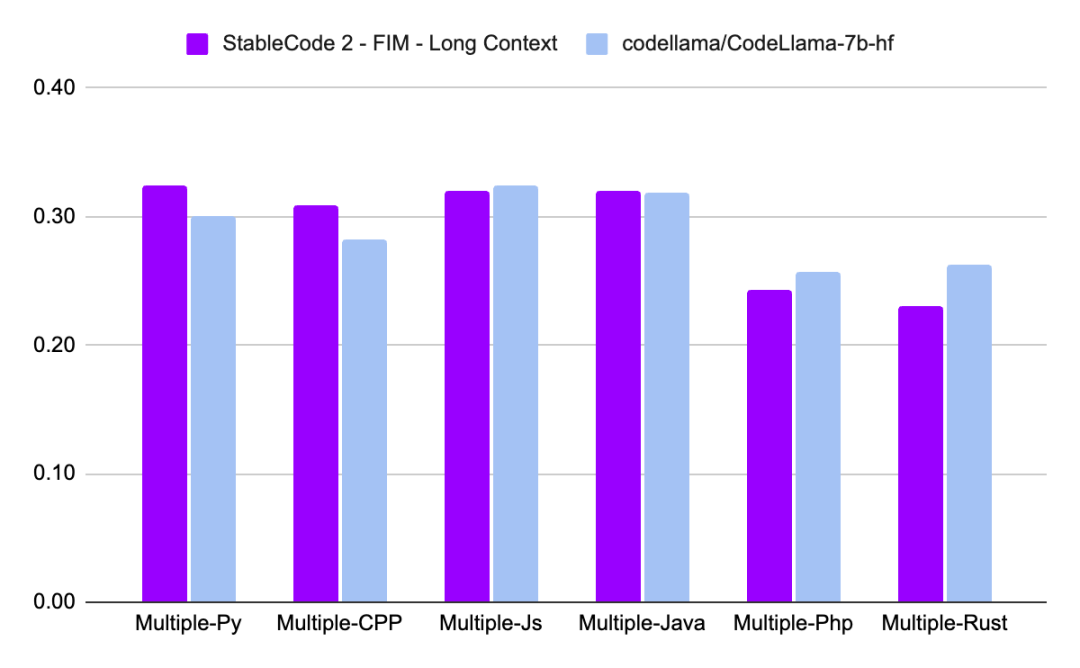

Berbanding dengan CodeLLaMA 7b, Kod Stable 3B adalah 60% lebih kecil dalam saiz, tetapi mencapai prestasi yang setanding dengan yang pertama pada tugas pengaturcaraan.

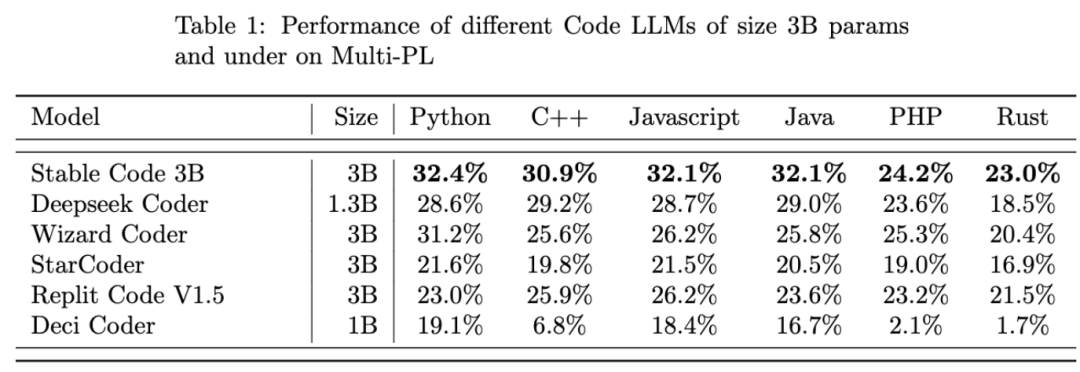

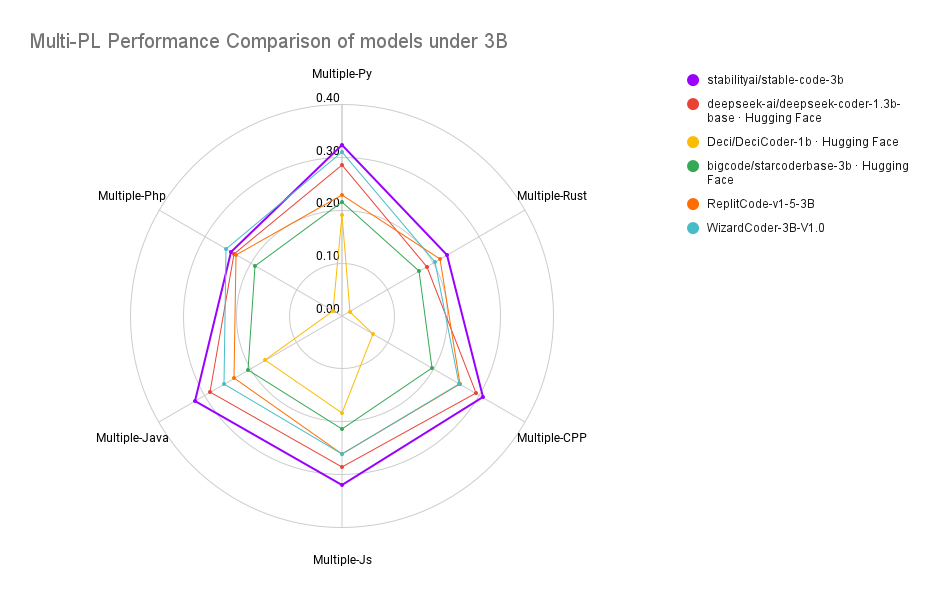

Stable Code 3B mencapai prestasi SOTA (berbanding dengan model bersaiz serupa) pada penanda aras MultiPL-E, seperti Stable Code 3B pada bahasa pengaturcaraan Python, C++, JavaScript, Java, PHP dan Rust Prestasi lebih baik daripada StarCoder.

Pengenalan Penyelidikan

Stable Code 3B dilatih berdasarkan Stable LM 3B, yang mempunyai nombor token latihan sehingga 4 trilion. Selain itu, Kod Stable juga menggunakan data khusus untuk kejuruteraan perisian untuk latihan.

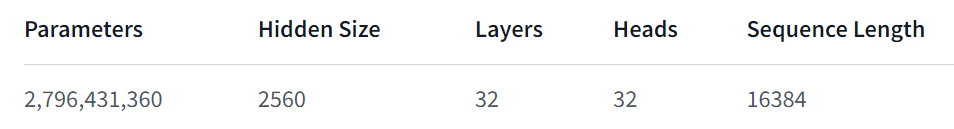

Kod Stabil 3B menyediakan lebih banyak ciri, berprestasi baik walaupun dalam pelbagai bahasa, dan juga mempunyai kelebihan lain, seperti menyokong fungsi FIM (Isi Tengah, teknik latihan baharu) dan boleh diperluaskan saiz Konteks. Kod Stabil asas dilatih pada sehingga 16,384 jujukan token dan mengikut pendekatan yang serupa dengan CodeLlama, iaitu, menggunakan Rotary Embeddings, yang secara pilihan membenarkan pengubahsuaian sehingga 1,000,000 pangkalan putaran Panjang konteks model dilanjutkan lagi kepada 100k token .

Dari segi seni bina model, model Kod Stabil 3B ialah pengubah penyahkod tulen, serupa dengan seni bina LLaMA, dengan pengubahsuaian berikut:

- Kedudukan dibenamkan: Diputarkan pada kedudukan: benam kepala 25% pertama dimensi untuk meningkatkan daya pemprosesan;

- Tokenizer: Gunakan versi GPTNeoX Tokenizer.NeoX yang diubah suai untuk menambah token khas untuk melatih fungsi FIM, seperti

,

Latihan

Training Dataset

Stable Code 3B's training data set terdiri daripada set data berskala besar Facon yang ditapis pada Hubung kami b, CommitPackFT , Isu Github, StarCoder dan latihan tambahan dengan data dari bidang matematik.

Infrastruktur latihan

- Perkakasan: Kod Stabil 3B dilatih pada gugusan AI Kestabilan menggunakan 256 GPU NVIDIA A100 40GB.

- Perisian: Kod Stabil 3B mengguna pakai cabang gpt-neox, menggunakan ZeRO-1 untuk melatih di bawah keselarian 2D (keselarian data dan tensor), dan bergantung pada inti pembenaman putaran perhatian kilat, SwiGLU dan FlashAttention- 2 .

Akhir sekali, mari kita lihat prestasi Kod Stabil 3B:

Laporan teknikal yang lebih terperinci mengenai Kod Stable 3B akan dikeluarkan kemudian, anda boleh menantikannya kemudian, anda boleh menantikannya nanti.

Atas ialah kandungan terperinci Stability AI mengeluarkan model 3B kod stabil yang menyokong larian tempatan dan tiada GPU diperlukan. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!