Peranti teknologi

Peranti teknologi AI

AI Peningkatan mPLUG-Owl baru Alibaba mempunyai yang terbaik dari kedua-dua dunia, dan kerjasama modal membolehkan SOTA baharu MLLM

Peningkatan mPLUG-Owl baru Alibaba mempunyai yang terbaik dari kedua-dua dunia, dan kerjasama modal membolehkan SOTA baharu MLLMPeningkatan mPLUG-Owl baru Alibaba mempunyai yang terbaik dari kedua-dua dunia, dan kerjasama modal membolehkan SOTA baharu MLLM

Kedua-dua

OpenAI GPT-4V dan Google Gemini telah menunjukkan keupayaan pemahaman pelbagai mod yang sangat kukuh dan menggalakkan pembangunan pesat model besar berbilang modal (MLLM) telah menjadi hala tuju penyelidikan yang paling hangat dalam industri.

MLLM telah mencapai arahan cemerlang mengikut kebolehan dalam pelbagai tugasan terbuka visual-linguistik. Walaupun penyelidikan terdahulu mengenai pembelajaran multimodal telah menunjukkan bahawa modaliti yang berbeza boleh bekerjasama dan mempromosikan satu sama lain, penyelidikan MLLM sedia ada tertumpu terutamanya pada peningkatan keupayaan tugas multimodal dan cara mengimbangi faedah kerjasama modal dan kesan gangguan modal kekal sebagai isu penting yang perlu ditangani.

Sila klik pautan berikut untuk melihat kertas: https://arxiv.org/pdf/2311.04257.pdf

Sila lihat alamat kod berikut: https://github.com/X -PLUG/mPLUG -Owl/tree/main/mPLUG-Owl2

Alamat pengalaman ModelScope: https://modelscope.cn/studios/damo/mPLUG-Owl2/summary

HuggingFace address experience link: https://modelscope.cn/studios/damo/mPLUG-Owl2/summary

//huggingface. co/spaces/MAGAer13/mPLUG-Owl2

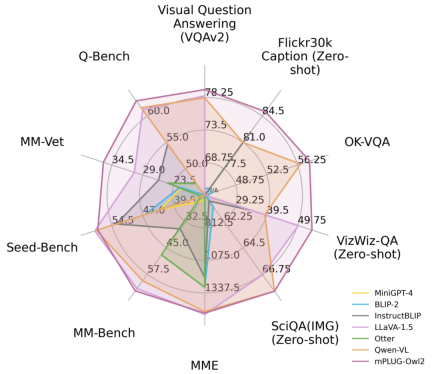

Rajah 1 Perbandingan prestasi dengan model MLLM sedia ada

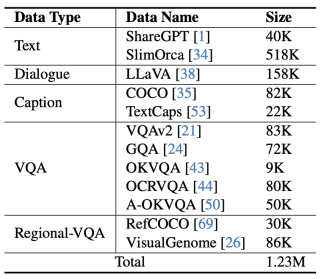

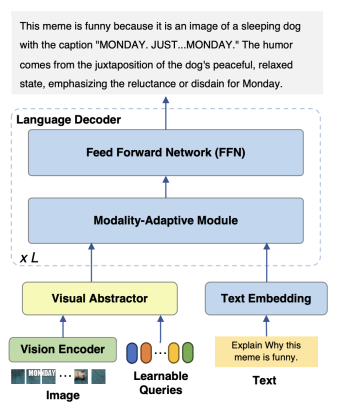

Pengenalan kaedah Untuk mencapai tujuan untuk tidak mengubah maksud asal, kandungan perlu ditulis semula ke dalam bahasa CinamPLUG-Owl2 model terutamanya terdiri daripada tiga bahagian:

Pengekod Visual: Menggunakan ViT-L/14 sebagai visual pengekod, resolusi input Imej dengan kadar H x W ditukar kepada jujukan token visual H/14 x W/14 dan dimasukkan ke dalam Abstraktor Visual.

Visual Extractor: Mengekstrak ciri semantik peringkat tinggi dengan mempelajari set pertanyaan yang tersedia sambil mengurangkan panjang jujukan visual model bahasa input

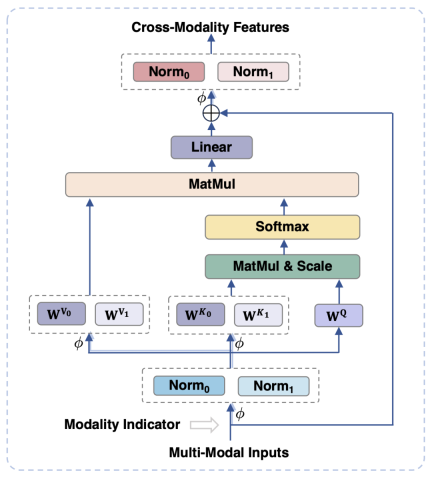

Figure 2 MPLUG-OWL2 MODEL STRUKTUR maklumat visual dan teks boleh menjejaskan prestasi model disebabkan oleh ketidakpadanan kebutiran semantik. Untuk menyelesaikan masalah ini, kertas kerja ini mencadangkan modul penyesuaian modaliti (MAM) untuk memetakan ciri visual dan teks ke dalam ruang semantik yang dikongsi, sambil menyahgandingkan perwakilan visual-linguistik untuk mengekalkan sifat unik setiap modaliti. . Dalam fasa input dan output modul, operasi LayerNorm dilakukan pada modaliti visual dan bahasa masing-masing untuk menyesuaikan diri dengan pengedaran ciri masing-masing bagi kedua-dua modaliti.

Dengan berkongsi FFN yang sama, kedua-dua modaliti boleh menggalakkan kerjasama antara satu sama lain

- Mengoptimumkan strategi latihan Rajah 4 mPLUG-Owl2

-

Seperti yang ditunjukkan dalam Rajah 4, latihan mPLUG-Owl2 merangkumi dua peringkat: pra-latihan dan penalaan halus arahan. Peringkat pra-latihan adalah terutamanya untuk mencapai penjajaran pengekod visual dan model bahasa Pada peringkat ini, Pengekod Visual dan Abstraktor Visual boleh dilatih, dan dalam model bahasa, hanya berat model berkaitan visual yang ditambah oleh Modaliti. Modul Adaptif diproses. Dalam peringkat penalaan halus arahan, semua parameter model diperhalusi berdasarkan teks dan data arahan berbilang modal (seperti yang ditunjukkan dalam Rajah 5) untuk meningkatkan keupayaan mengikuti arahan model. .

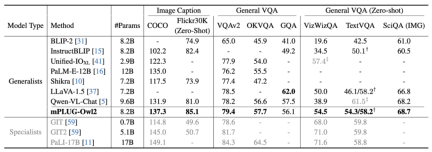

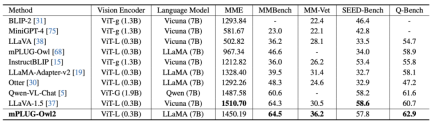

Gambar 7 Prestasi penanda aras MLLM

ditunjukkan dalam Rajah 6 dan Rajah 7, sama ada perihalan imej tradisional, VQA dan tugasan bahasa visual lain, atau MMBench, Q-Bench dan set data penanda aras lain untuk berbilang modal besar model, mPLUG-Owl2 semuanya mencapai prestasi yang lebih baik daripada kerja sedia ada.

Figure 8 Prestasi Benchmark Teks Tulen Figure 9 Kesan Modul Adaptasi Modal pada Prestasi Tugas Teks Pure Tambahan, untuk menilai kesan kerjasama modal mengenai tugas teks tulen Berkenaan kesan tugasan teks, pengarang juga menguji prestasi mPLUG-Owl2 dalam pemahaman dan penjanaan bahasa semula jadi. Seperti yang ditunjukkan dalam Rajah 8, mPLUG-Owl2 mencapai prestasi yang lebih baik berbanding LLM yang disesuaikan dengan arahan yang lain. Rajah 9 menunjukkan prestasi pada tugasan teks biasa Ia dapat dilihat bahawa sejak modul penyesuaian modal menggalakkan kerjasama modal, pemeriksaan model dan keupayaan pengetahuan telah dipertingkatkan dengan ketara. Penulis menganalisis bahawa ini adalah kerana kerjasama multi-modal membolehkan model menggunakan maklumat visual untuk memahami konsep yang sukar untuk diterangkan dalam bahasa, dan meningkatkan keupayaan penaakulan model melalui maklumat yang kaya dalam imej, dan secara tidak langsung mengukuhkan keupayaan penaakulan teks tersebut.

mPLUG-Owl2 menunjukkan keupayaan pemahaman pelbagai mod yang sangat baik dan berjaya mengurangkan halusinasi pelbagai mod. Teknologi pelbagai mod ini telah digunakan pada produk teras Tongyi seperti Tongyi Stardust dan Tongyi Zhiwen, dan telah disahkan dalam demo terbuka ModelScope dan HuggingFace

Atas ialah kandungan terperinci Peningkatan mPLUG-Owl baru Alibaba mempunyai yang terbaik dari kedua-dua dunia, dan kerjasama modal membolehkan SOTA baharu MLLM. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Skop Gemma: Mikroskop Google ' s untuk mengintip ke proses pemikiran AI 'Apr 17, 2025 am 11:55 AM

Skop Gemma: Mikroskop Google ' s untuk mengintip ke proses pemikiran AI 'Apr 17, 2025 am 11:55 AMMeneroka kerja -kerja dalam model bahasa dengan skop Gemma Memahami kerumitan model bahasa AI adalah satu cabaran penting. Pelepasan Google Gemma Skop, Toolkit Komprehensif, menawarkan penyelidik cara yang kuat untuk menyelidiki

Siapa penganalisis perisikan perniagaan dan bagaimana menjadi satu?Apr 17, 2025 am 11:44 AM

Siapa penganalisis perisikan perniagaan dan bagaimana menjadi satu?Apr 17, 2025 am 11:44 AMMembuka Kejayaan Perniagaan: Panduan untuk Menjadi Penganalisis Perisikan Perniagaan Bayangkan mengubah data mentah ke dalam pandangan yang boleh dilakukan yang mendorong pertumbuhan organisasi. Ini adalah kuasa penganalisis Perniagaan Perniagaan (BI) - peranan penting dalam GU

Bagaimana untuk menambah lajur dalam SQL? - Analytics VidhyaApr 17, 2025 am 11:43 AM

Bagaimana untuk menambah lajur dalam SQL? - Analytics VidhyaApr 17, 2025 am 11:43 AMPernyataan Jadual Alter SQL: Menambah lajur secara dinamik ke pangkalan data anda Dalam pengurusan data, kebolehsuaian SQL adalah penting. Perlu menyesuaikan struktur pangkalan data anda dengan cepat? Pernyataan Jadual ALTER adalah penyelesaian anda. Butiran panduan ini menambah colu

Penganalisis Perniagaan vs Penganalisis DataApr 17, 2025 am 11:38 AM

Penganalisis Perniagaan vs Penganalisis DataApr 17, 2025 am 11:38 AMPengenalan Bayangkan pejabat yang sibuk di mana dua profesional bekerjasama dalam projek kritikal. Penganalisis perniagaan memberi tumpuan kepada objektif syarikat, mengenal pasti bidang penambahbaikan, dan memastikan penjajaran strategik dengan trend pasaran. Simu

Apakah Count dan Counta dalam Excel? - Analytics VidhyaApr 17, 2025 am 11:34 AM

Apakah Count dan Counta dalam Excel? - Analytics VidhyaApr 17, 2025 am 11:34 AMPengiraan dan Analisis Data Excel: Penjelasan terperinci mengenai fungsi Count dan Counta Pengiraan dan analisis data yang tepat adalah kritikal dalam Excel, terutamanya apabila bekerja dengan set data yang besar. Excel menyediakan pelbagai fungsi untuk mencapai matlamat ini, dengan fungsi Count dan CountA menjadi alat utama untuk mengira bilangan sel di bawah keadaan yang berbeza. Walaupun kedua -dua fungsi digunakan untuk mengira sel, sasaran reka bentuk mereka disasarkan pada jenis data yang berbeza. Mari menggali butiran khusus fungsi Count dan Counta, menyerlahkan ciri dan perbezaan unik mereka, dan belajar cara menerapkannya dalam analisis data. Gambaran keseluruhan perkara utama Memahami kiraan dan cou

Chrome ada di sini dengan AI: mengalami sesuatu yang baru setiap hari !!Apr 17, 2025 am 11:29 AM

Chrome ada di sini dengan AI: mengalami sesuatu yang baru setiap hari !!Apr 17, 2025 am 11:29 AMRevolusi AI Google Chrome: Pengalaman melayari yang diperibadikan dan cekap Kecerdasan Buatan (AI) dengan cepat mengubah kehidupan seharian kita, dan Google Chrome mengetuai pertuduhan di arena pelayaran web. Artikel ini meneroka exciti

Sisi Manusia Ai ' s: Kesejahteraan dan garis bawah empat kali gandaApr 17, 2025 am 11:28 AM

Sisi Manusia Ai ' s: Kesejahteraan dan garis bawah empat kali gandaApr 17, 2025 am 11:28 AMImpak Reimagining: garis bawah empat kali ganda Selama terlalu lama, perbualan telah dikuasai oleh pandangan sempit kesan AI, terutama memberi tumpuan kepada keuntungan bawah. Walau bagaimanapun, pendekatan yang lebih holistik mengiktiraf kesalinghubungan BU

5 Kes Pengkomputeran Kuantum Mengubah Permainan Yang Harus Anda KetahuiApr 17, 2025 am 11:24 AM

5 Kes Pengkomputeran Kuantum Mengubah Permainan Yang Harus Anda KetahuiApr 17, 2025 am 11:24 AMPerkara bergerak terus ke arah itu. Pelaburan yang dicurahkan ke dalam penyedia perkhidmatan kuantum dan permulaan menunjukkan bahawa industri memahami kepentingannya. Dan semakin banyak kes penggunaan dunia nyata muncul untuk menunjukkan nilainya

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Versi Mac WebStorm

Alat pembangunan JavaScript yang berguna

SublimeText3 Linux versi baharu

SublimeText3 Linux versi terkini

Muat turun versi mac editor Atom

Editor sumber terbuka yang paling popular

SublimeText3 versi Inggeris

Disyorkan: Versi Win, menyokong gesaan kod!

Penyesuai Pelayan SAP NetWeaver untuk Eclipse

Integrasikan Eclipse dengan pelayan aplikasi SAP NetWeaver.