Rumah >Peranti teknologi >AI >Pengurangan dimensi model pengubah berkurangan dan prestasi LLM kekal tidak berubah apabila lebih daripada 90% komponen lapisan tertentu dialih keluar.

Pengurangan dimensi model pengubah berkurangan dan prestasi LLM kekal tidak berubah apabila lebih daripada 90% komponen lapisan tertentu dialih keluar.

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBke hadapan

- 2023-12-28 15:44:20931semak imbas

Dalam era model berskala besar, Transformer sahaja menyokong keseluruhan bidang penyelidikan saintifik. Sejak dikeluarkan, model bahasa berasaskan Transformer telah menunjukkan prestasi cemerlang dalam pelbagai tugas Seni bina Transformer yang mendasari telah menjadi terkini dalam pemodelan dan inferens bahasa semula jadi, dan juga telah menunjukkan janji dalam bidang seperti penglihatan komputer. dan pembelajaran pengukuhan. Ia menunjukkan prospek yang kukuh

Senibina Transformer semasa sangat besar dan biasanya memerlukan banyak sumber pengkomputeran untuk latihan dan inferens

Ini adalah disengajakan, kerana Transformer yang dilatih dengan lebih banyak parameter atau data adalah jelas. lebih besar daripada Model lain lebih berkebolehan. Walau bagaimanapun, badan kerja yang semakin meningkat menunjukkan bahawa model berasaskan Transformer serta rangkaian saraf tidak memerlukan semua parameter yang dipasang untuk mengekalkan hipotesis yang dipelajari.

Secara amnya, pengiraan berlebihan secara besar-besaran nampaknya membantu semasa melatih model, tetapi model ini boleh dipangkas sebelum inferens menunjukkan bahawa rangkaian saraf selalunya boleh mengeluarkan lebih daripada 90% berat tanpa menunjukkan prestasi yang baik merosot. Fenomena ini telah mendorong penyelidik untuk beralih kepada strategi pemangkasan yang membantu inferens model

Penyelidik dari MIT dan Microsoft melaporkan dalam makalah bertajuk "The Truth Is Out There: Improving Improvement through Layer Selective Ranking Reduction Satu penemuan yang mengejutkan telah dibuat dalam kertas kerja "Keupayaan Penaakulan Model Bahasa". Mereka mendapati pemangkasan halus pada lapisan tertentu model Transformer boleh meningkatkan prestasi model dengan ketara pada tugasan tertentu

- Alamat kertas: https://arxiv.org/pdf/2312.13558.pdf

laman utama: https://pratyushasharma.github.io/laser/

Intervensi mudah ini dipanggil LASER (Pengurangan Kedudukan PILIHAN LAPISAN) dalam kajian. Ia meningkatkan prestasi LLM dengan ketara dengan mengurangkan secara terpilih komponen tertib tinggi matriks berat pembelajaran lapisan tertentu dalam model Transformer melalui penguraian nilai tunggal. Operasi ini boleh dilakukan selepas latihan model selesai dan tidak memerlukan parameter atau data tambahan

Semasa operasi, pengurangan pemberat dilakukan dengan menggunakan matriks dan lapisan berat khusus model. Kajian itu juga mendapati bahawa banyak matriks yang serupa dapat mengurangkan berat dengan ketara, dan secara amnya tiada kemerosotan prestasi diperhatikan sehingga lebih daripada 90% komponen dikeluarkan

Kajian itu juga mendapati bahawa mengurangkan faktor ini boleh meningkatkan ketepatan dengan ketara. Menariknya, penemuan ini bukan sahaja terpakai kepada bahasa semula jadi, tetapi juga meningkatkan prestasi untuk pembelajaran pengukuhan

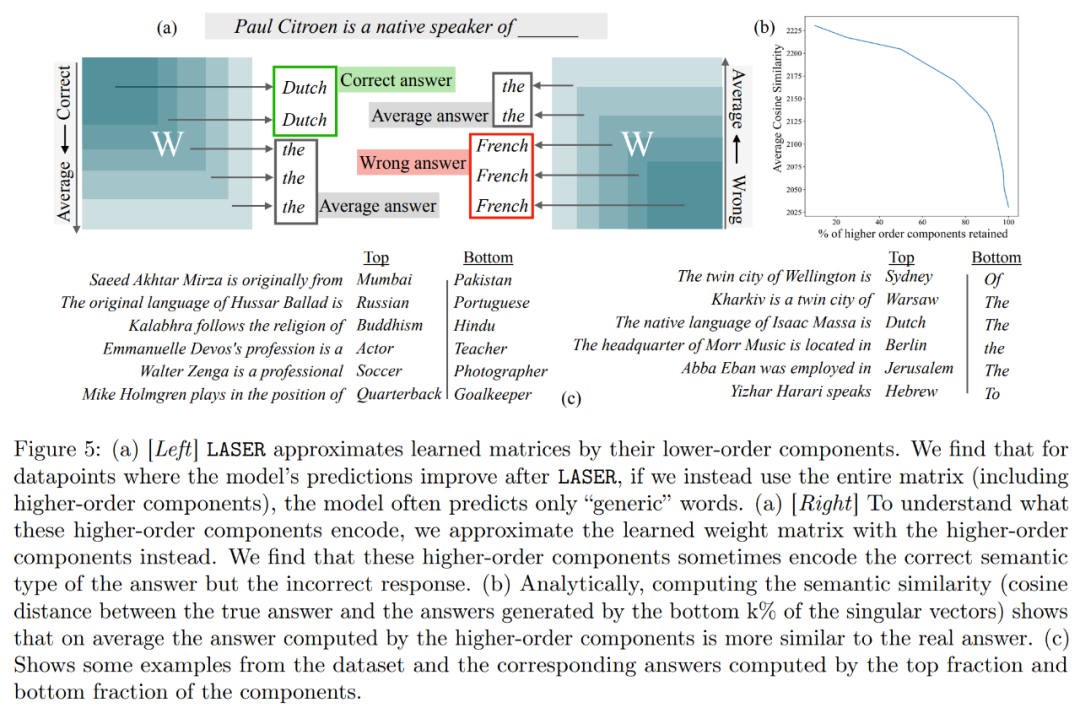

Selain itu, kajian ini cuba menyimpulkan apa yang disimpan dalam komponen peringkat lebih tinggi untuk meningkatkan prestasi melalui pemadaman. Kajian mendapati bahawa selepas menggunakan LASER untuk menjawab soalan, model asal terutamanya bertindak balas menggunakan perkataan frekuensi tinggi (seperti "the", "of", dll.). Kata-kata ini tidak sepadan dengan jenis semantik jawapan yang betul, yang bermaksud bahawa tanpa campur tangan, komponen ini akan menyebabkan model menghasilkan beberapa perkataan frekuensi tinggi yang tidak relevan

Namun, selepas melakukan tahap penurunan pangkat tertentu, The jawapan model boleh diubah menjadi yang betul.

Untuk memahami perkara ini, kajian itu turut meneroka perkara yang dikodkan oleh komponen selebihnya secara individu, dan mereka menganggarkan matriks berat menggunakan hanya vektor tunggal peringkat tinggi mereka. Didapati bahawa komponen ini menerangkan respons yang berbeza atau perkataan frekuensi tinggi biasa dalam kategori semantik yang sama dengan jawapan yang betul.

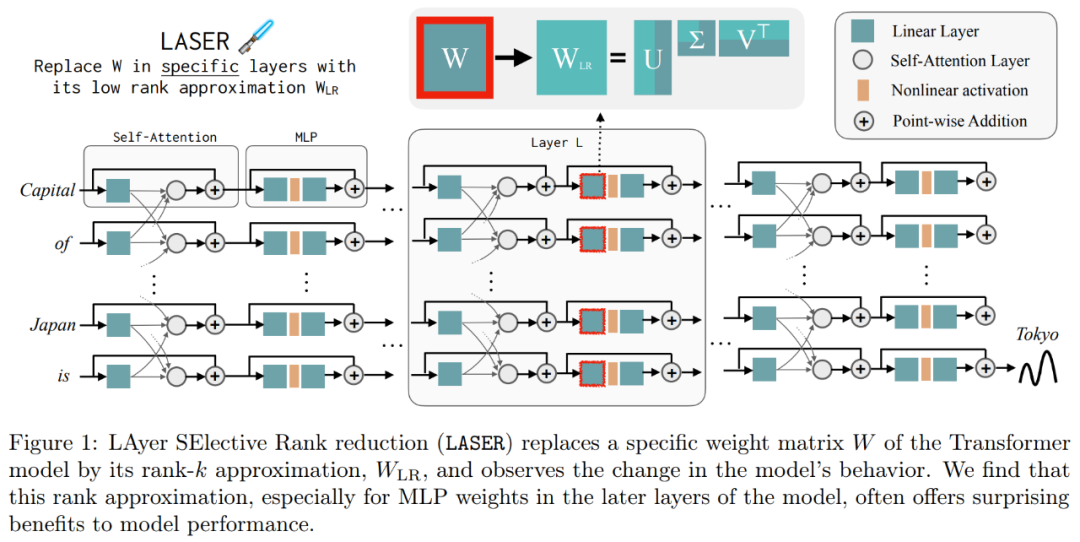

Hasil ini mencadangkan bahawa apabila komponen tertib tinggi yang bising digabungkan dengan komponen tertib rendah, respons bercanggah mereka menghasilkan jawapan purata, yang mungkin salah. Rajah 1 memberikan gambaran visual seni bina Transformer dan prosedur yang diikuti oleh LASER. Di sini, matriks berat lapisan tertentu perceptron berbilang lapisan (MLP) digantikan dengan anggaran peringkat rendahnya.

Laser Gambaran Keseluruhan 🎜🎜🎜🎜Pengkaji memperkenalkan campur tangan LASER secara terperinci. Campur tangan LASER satu langkah ditakrifkan oleh tiga parameter (τ, ℓ dan ρ). Parameter ini bersama-sama menerangkan matriks yang akan digantikan dengan penghampiran peringkat rendah dan darjah penghampiran. Pengkaji mengelaskan matriks yang akan diintervensi mengikut jenis parameter🎜🎜🎜🎜Pengkaji memfokuskan pada matriks W = {W_q, W_k, W_v, W_o, U_in, U_out}, yang terdiri daripada multilayer perceptron (MLP) dan attention Matrix komposisi dalam lapisan daya. Bilangan lapisan mewakili tahap campur tangan penyelidik, di mana indeks lapisan pertama ialah 0. Sebagai contoh, Llama-2 mempunyai 32 tahap, jadi ia dinyatakan sebagai ℓ ∈ {0, 1, 2,・・・31}🎜🎜

Akhirnya, ρ ∈ [0, 1) menerangkan bahagian kedudukan maksimum yang harus dikekalkan apabila membuat anggaran peringkat rendah. Sebagai contoh, andaikan  , pangkat maksimum matriks ialah d. Para penyelidik menggantikannya dengan anggaran ⌊ρ・d⌋-.

, pangkat maksimum matriks ialah d. Para penyelidik menggantikannya dengan anggaran ⌊ρ・d⌋-.

Perkara berikut diperlukan Dalam Rajah 1 di bawah, contoh LASER ditunjukkan. Simbol τ = U_in dan ℓ = L dalam rajah menunjukkan bahawa matriks berat lapisan pertama MLP dikemas kini dalam blok Transformer lapisan Lth. Terdapat juga parameter untuk mengawal nilai k dalam anggaran pangkat-k

LASER boleh mengehadkan aliran maklumat tertentu dalam rangkaian dan secara tidak dijangka menghasilkan faedah prestasi yang ketara. Intervensi ini juga boleh digabungkan dengan mudah, seperti menggunakan set intervensi dalam sebarang susunan  .

.

Kaedah LASER hanyalah carian mudah untuk jenis intervensi ini, diubah suai untuk membawa manfaat maksimum. Walau bagaimanapun, terdapat banyak cara lain untuk menggabungkan campur tangan ini, yang merupakan hala tuju untuk kerja masa hadapan.

Hasil eksperimen

Dalam bahagian eksperimen, penyelidik menggunakan model GPT-J yang telah dilatih pada set data PILE, yang mempunyai 27 lapisan dan 6 bilion parameter. Tingkah laku model kemudian dinilai pada set data CounterFact, yang mengandungi sampel tiga kali ganda (topik, hubungan dan jawapan), dengan tiga gesaan parafrasa disediakan untuk setiap soalan.

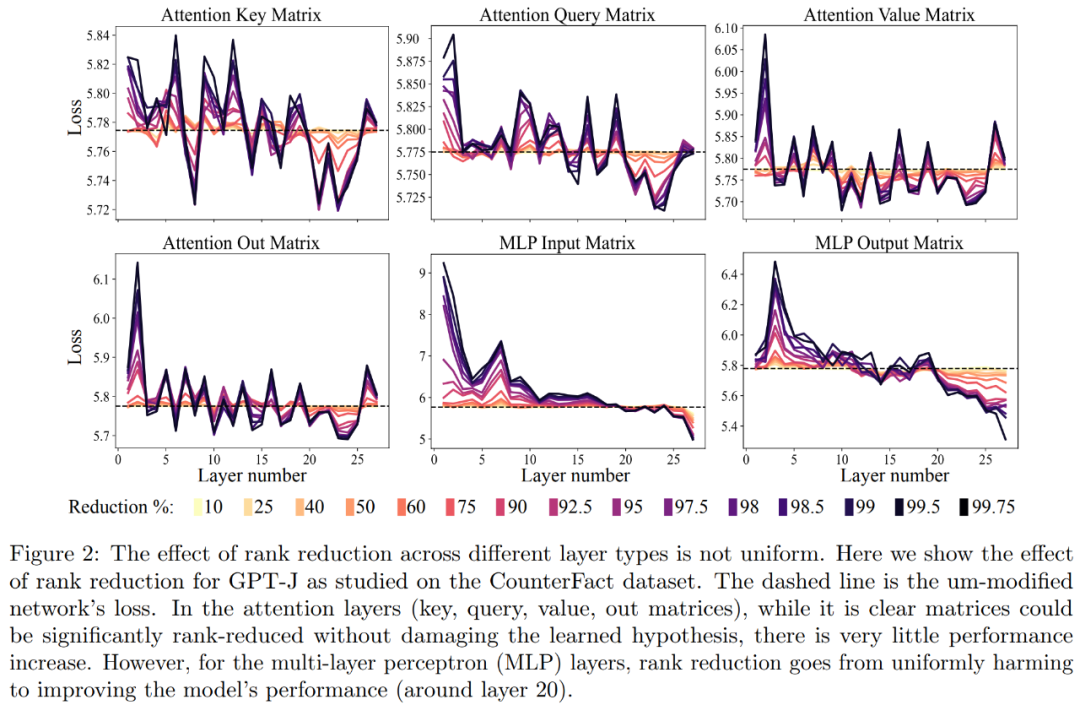

Mula-mula, kami menganalisis model GPT-J pada set data CounterFact. Rajah 2 menunjukkan kesan ke atas kehilangan klasifikasi set data selepas menggunakan jumlah pengurangan pangkat yang berbeza untuk setiap matriks dalam seni bina Transformer. Setiap lapisan Transformer terdiri daripada MLP kecil dua lapisan, dengan matriks input dan output ditunjukkan secara berasingan. Warna yang berbeza mewakili peratusan berbeza bagi komponen yang dialih keluar

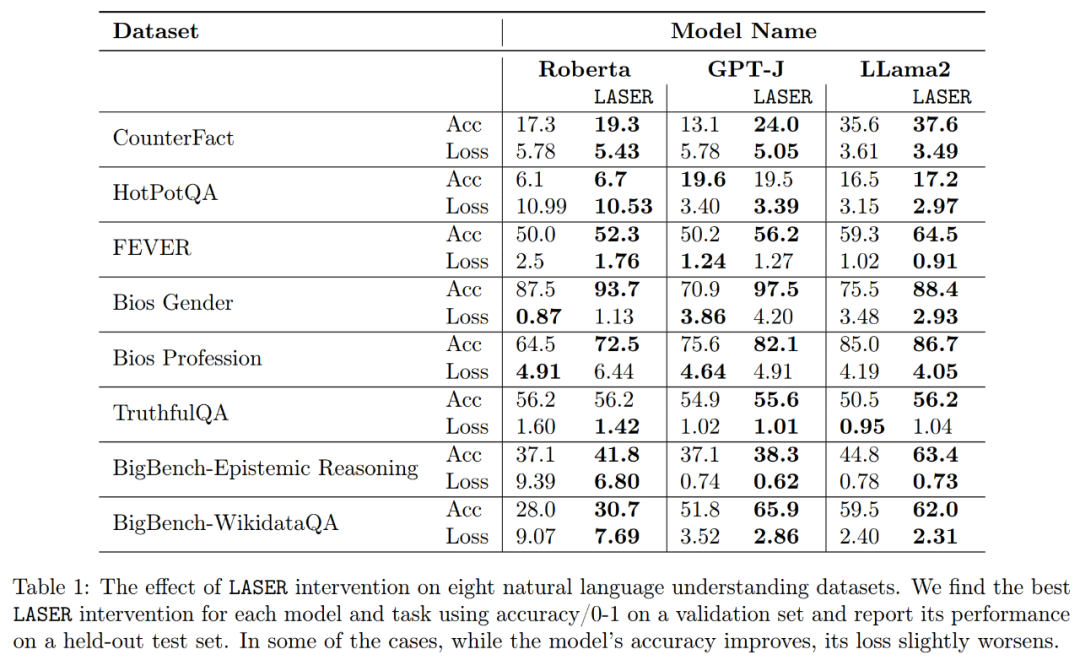

Mengenai ketepatan dan keteguhan tafsiran yang lebih baik, seperti yang ditunjukkan dalam Rajah 2 di atas dan Jadual 1 di bawah, penyelidik mendapati bahawa apabila melakukan pengurangan pangkat pada satu lapisan, Fakta fakta ketepatan model GPT-J pada dataset CounterFact meningkat daripada 13.1% kepada 24.0%. Adalah penting untuk ambil perhatian bahawa penambahbaikan ini hanya hasil daripada penurunan pangkat dan tidak melibatkan sebarang latihan lanjut atau penalaan halus model.

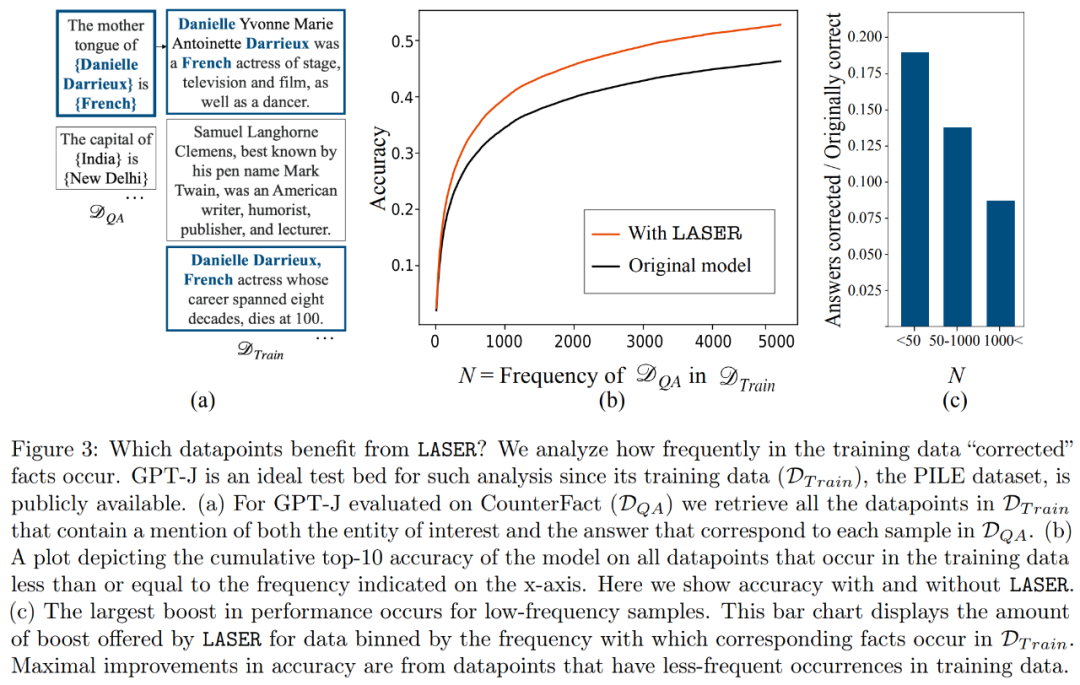

Apakah fakta yang akan dipulihkan apabila melakukan pemulihan peringkat bawah? Para penyelidik mendapati bahawa fakta yang diperoleh melalui pemulihan pengurangan pangkat mungkin kelihatan sangat jarang dalam set data, seperti yang ditunjukkan dalam Rajah 3

Apakah yang disimpan oleh komponen peringkat tinggi? Para penyelidik menggunakan komponen tertib tinggi untuk menganggarkan matriks berat akhir (bukannya menggunakan komponen tertib rendah seperti LASER), seperti yang ditunjukkan dalam Rajah 5 (a) di bawah. Mereka mengukur persamaan kosinus purata bagi jawapan benar berbanding dengan jawapan yang diramalkan apabila menghampiri matriks menggunakan nombor yang berbeza bagi komponen tertib tinggi, seperti yang ditunjukkan dalam Rajah 5(b) di bawah.

Penyelidik akhirnya menilai kebolehgeneralisasian tiga LLM berbeza yang mereka temui pada tugas pemahaman berbilang bahasa. Bagi setiap tugasan, mereka menilai prestasi model menggunakan tiga metrik: ketepatan penjanaan, ketepatan klasifikasi dan kehilangan. Mengikut keputusan dalam Jadual 1, walaupun pangkat matriks sangat berkurangan, ia tidak akan menyebabkan ketepatan model menurun, sebaliknya boleh meningkatkan prestasi model

Atas ialah kandungan terperinci Pengurangan dimensi model pengubah berkurangan dan prestasi LLM kekal tidak berubah apabila lebih daripada 90% komponen lapisan tertentu dialih keluar.. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!